7 Papers & Radios | 无人机3D打印登Nature封面;哈工大用微波驱控机器人

机器之心 & ArXiv Weekly Radiostation

参与:杜伟、楚航、罗若天

本周主要论文包括英国帝国理工学院用无人机 3D 打印房子;哈佛大学新型固态锂电池 3 分钟充满电,可循环超 10000 次。

-

Aerial additive manufacturing with multiple autonomous robots -

A dynamic stability design strategy for lithium metal solid state batteries -

Multi-Degree-of-Freedom Robots Powered and Controlled by Microwaves -

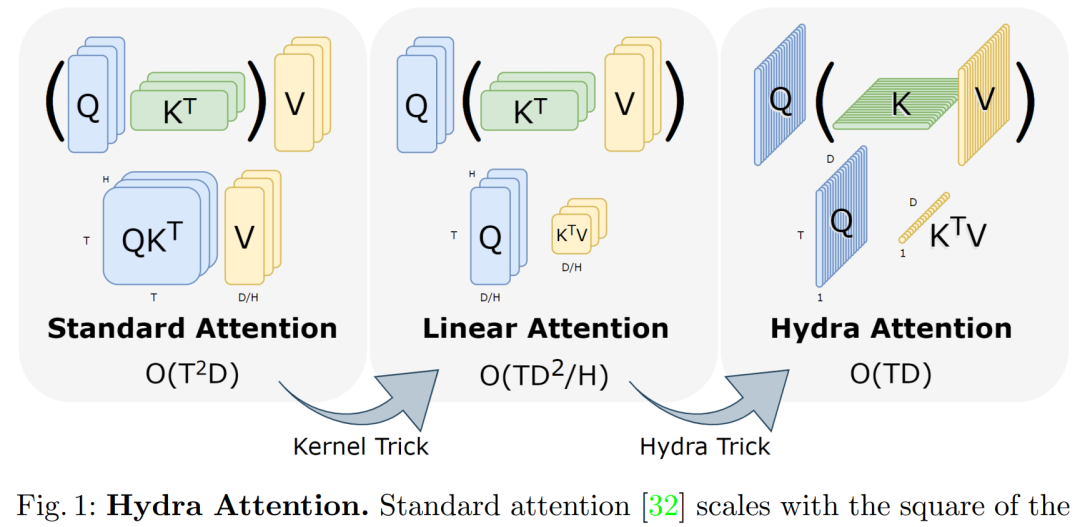

Hydra Attention: Efficient Attention with Many Heads -

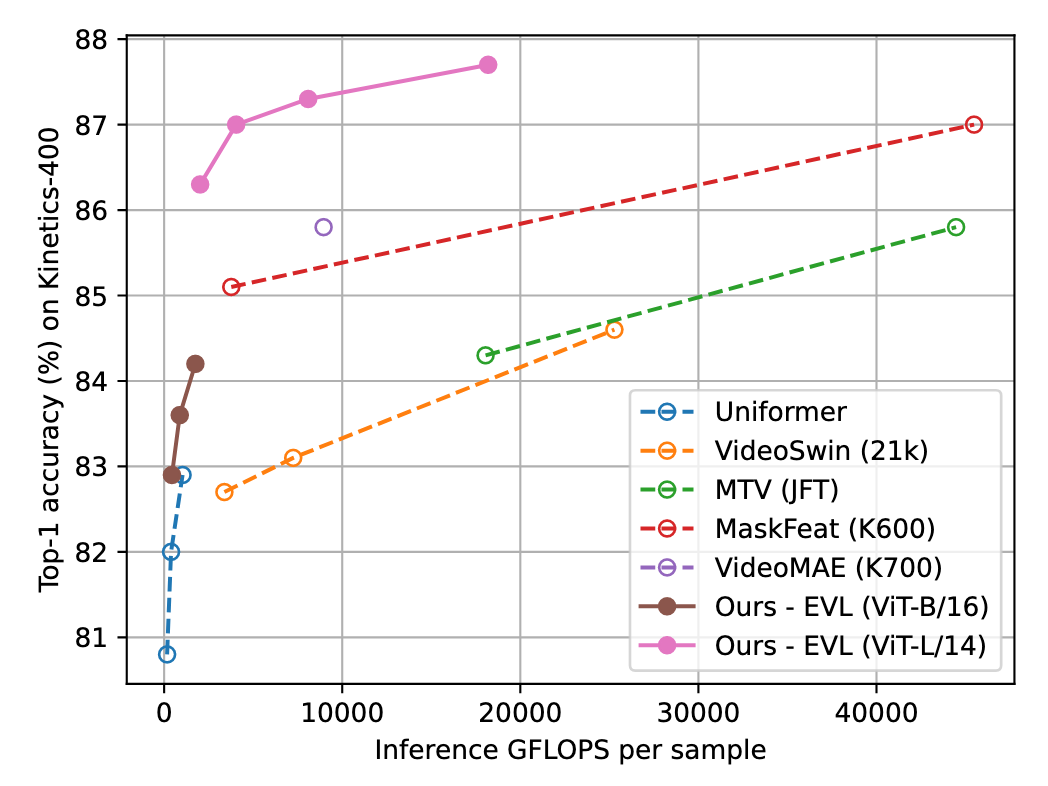

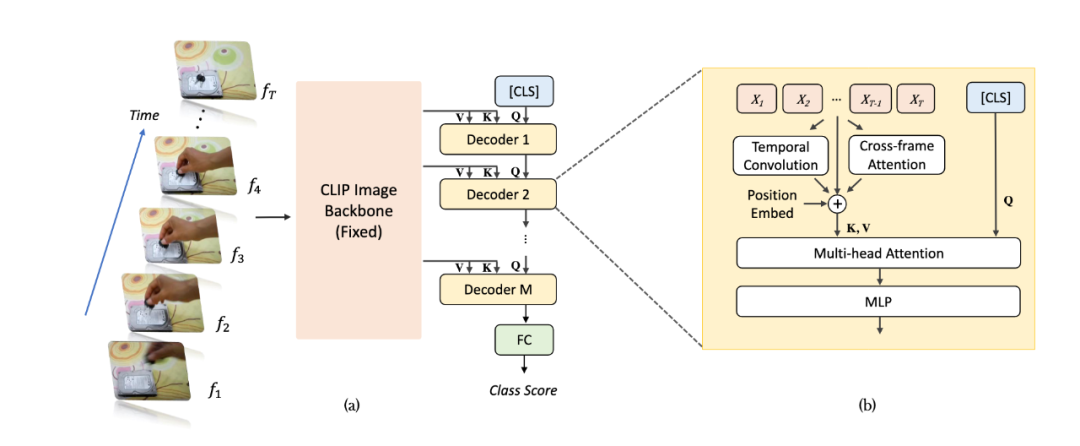

Frozen CLIP Models are Efficient Video Learners -

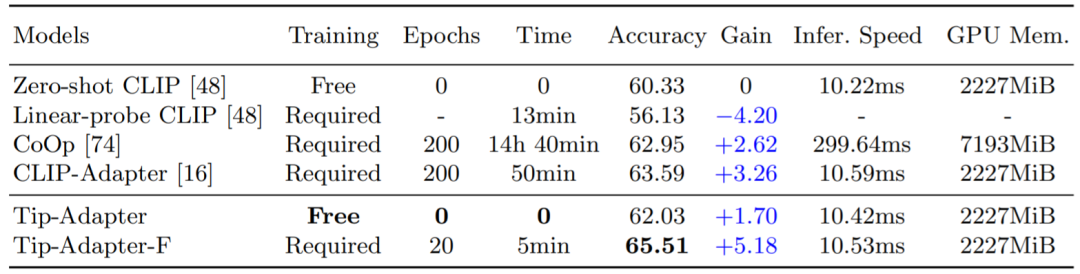

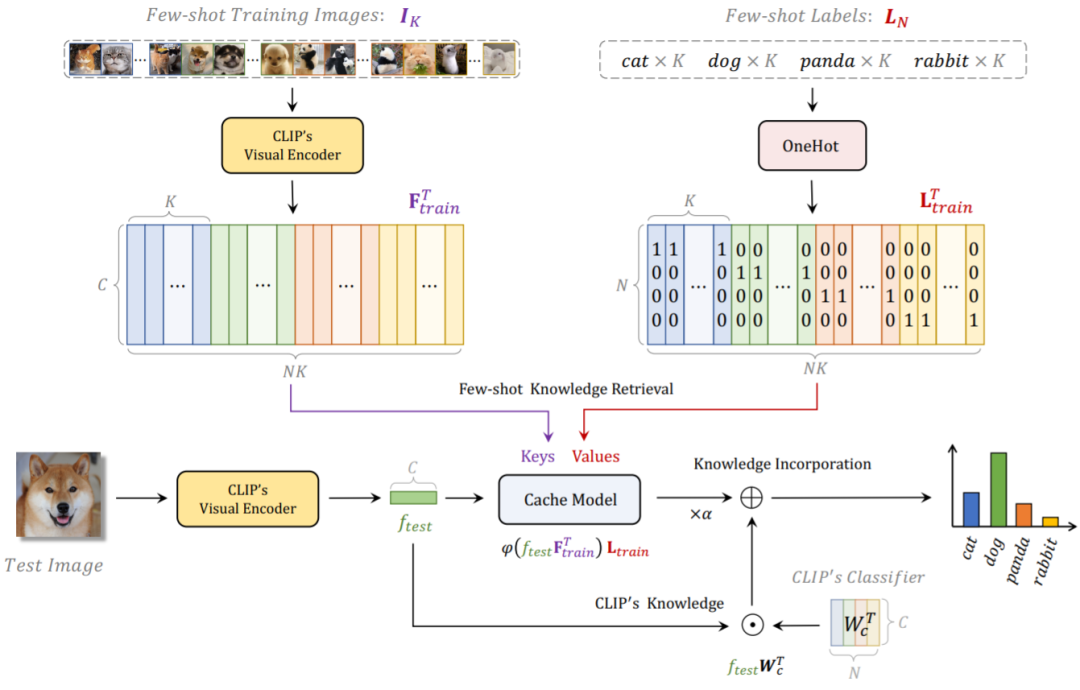

Tip-Adapter: Training-free Adaption of CLIP for Few-shot Classification -

SOFT DIFFUSION SCORE MATCHING FOR GENERAL CORRUPTIONS -

ArXiv Weekly Radiostation:NLP、CV、ML 更多精选论文(附音频)

-

作者:Ketao Zhang、Pisak Chermprayong 等 -

论文地址:https://www.nature.com/articles/s41586-022-04988-4

-

作者:Luhan Ye、Xin Li -

论文地址:https://www.nature.com/articles/s41586-021-03486-3

-

作者:李永泽、邢志广、赵建文 -

论文地址:https://onlinelibrary.wiley.com/doi/full/10.1002/advs.202203305

-

作者:Daniel Bolya 、 Cheng-Yang Fu 等 -

论文地址:https://arxiv.org/pdf/2209.07484.pdf

-

作者:Ziyi Lin、Shijie Geng 等 -

论文地址:https://arxiv.org/abs/2208.03550

-

作者:Renrui Zhang 、 Wei Zhang 等 -

论文地址:https://arxiv.org/pdf/2207.09519.pdf

-

作者:Giannis Daras 、 Mauricio Delbracio 等 -

论文地址:https://arxiv.org/pdf/2209.05442.pdf

本周 10 篇 CV 精选论文是:

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年11月23日

Arxiv

0+阅读 · 2022年11月23日

Arxiv

0+阅读 · 2022年11月22日

Arxiv

0+阅读 · 2022年11月22日