点击上方“CVer”,选择加"星标"置顶

重磅干货,第一时间送达![]()

本文转载自:CSIG文档图像分析与识别专委会

![]()

本文简要介绍2020年被CVPR录用的论文“ContourNet: Taking a Further Step toward Accurate Arbitrary-shaped Scene Text Detection”的主要工作。近年来场景文本检测的研究发展迅速,但其中有两个困难的挑战未被很好解决,算法容易产生伪召回

(False Positives)以及对尺度变化剧烈的文本检测不准确。为此,本文提出ContourNet算法,设计了Adaptive-RPN模块生

成更高精度质量的候选框,以及Local Orthogonal Texture-aware Module (LOTM)模块来解耦候选框中的水平和竖直方向的文本轮廓检测,从而向更精确的任意形状的场景文本检测又迈进一步。

![]()

场景文字图片中,文本尺度变化大,背景纹理复杂等困难导致了现有的场景文本检测算法普遍存在两个问题,

伪召回(False Positives)多,以

及对尺度变化剧烈的文本检测不准确。针对伪召回问题,现有的方法大多基于文本的上下文信息,全局与局部关系,以及纹理信息建模。本文作者观察发现,伪召回中的纹理特征具有强烈的无方向性,即类似物理上的各向同性,于是将其解耦为水平方向和竖直方向的轮廓检测,通过其联合响应来抑制伪召回。针对尺度变换剧烈问题,现有的方法多着眼于融合多尺度特征来预测边界框,作者则另辟蹊径关注文本自身形状信息的建模以及利用尺度不敏感的指标来优化网络的检测。

![]()

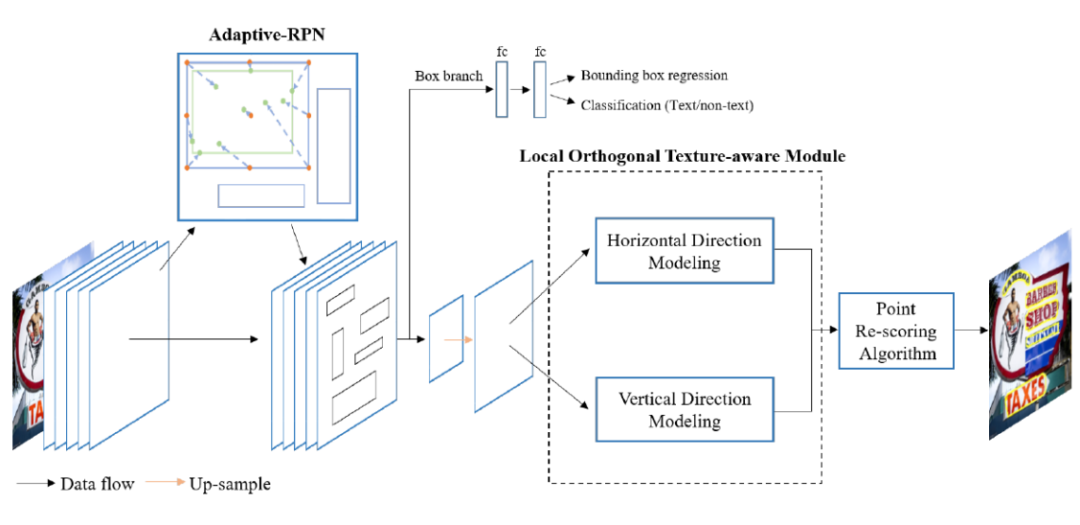

图

2是网络的整体框架图。ContourNet 由三个模块组成,第一个是Adaptive-RPN模块,用于生成高质量精度的矩形候选框;第二个是Local Orthogonal Texture-aware Module (LOTM)模块,用于解耦候选框中水平和竖直两个方向的轮廓检测;第三个是Point Re-scoring Algorithm模块,用于耦合水平和竖直方向的轮廓响应分数。下面分别介绍每个模块的结构。

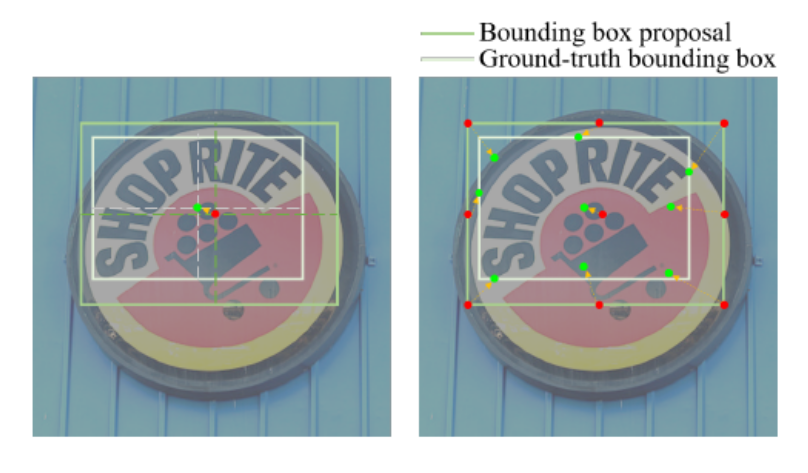

主干网络采用类似FPN结构 [1],输出卷积特征到Adaptive-RPN,然后使用类似Faster RCNN [2]的方法,计算候选区域分类和回归损失。在其经典的RPN [2] 中,直接回归检测框中心点和长宽四个偏移量,而Adaptive-RPN则回归预定义好的9个点的坐标偏移量,(四角点,四条边中心点,候选框中心点),如图3所示。回归后取外围8点的最小包围框,而中心点则用于矫正(e.g. 包围框左边界超过中心点,直接取中心点为左界)。不同于使用经典的Smooth L1 loss[2],作者利用IoU loss [3] 的尺度不敏感特性来回归更准确的边界框。

![]()

图3 左图是经典RPN,右图是Adaptive-RPN。红点是预定义好的回归前的锚点,绿点是回归后的点,黄色箭头是回归偏移量方向示意。

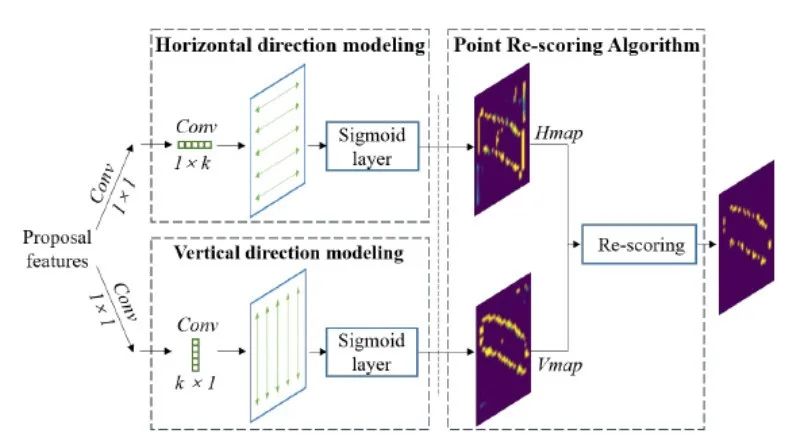

图4为LOTM结构。LOTM模块的输入Proposal Features是在Adaptive-RPN后的共享特征图上使用Deformable RoI pooling [4] 和双线性插值得到。经过1*1卷积后,展开两个平行分支,解耦为水平和和竖直两个正交方向的轮廓检测。水平方向分支使用1*k的卷积核水平方向卷积,竖直方向分支则使用k*1的卷积核竖直方向卷积,k是超参数,实验验证使用k=3比较好。卷积后的特征图经过Sigmoid归一化得到相应方向的热图。LOTM使用交叉熵损失分类轮廓边界点。

![]()

图4 LOTM与Point Re-scoring Algorithm的结构。其中Point Re-scoring Algorithm只用于测试阶段。

Point Re-scoring Algorithm模块中,先对两个方向热图进行简单的NMS预处理滤波得到更高置信度的准确表征,然后综合考虑LOTM输出的水平和垂直方向上响应,即文本轮廓需同时具有两个方向的响应,滤除单方向噪声,从而抑制伪召回。

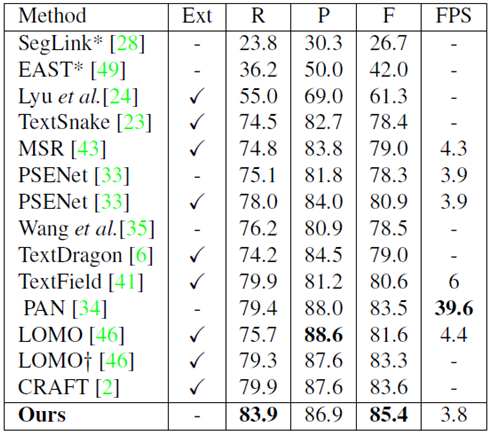

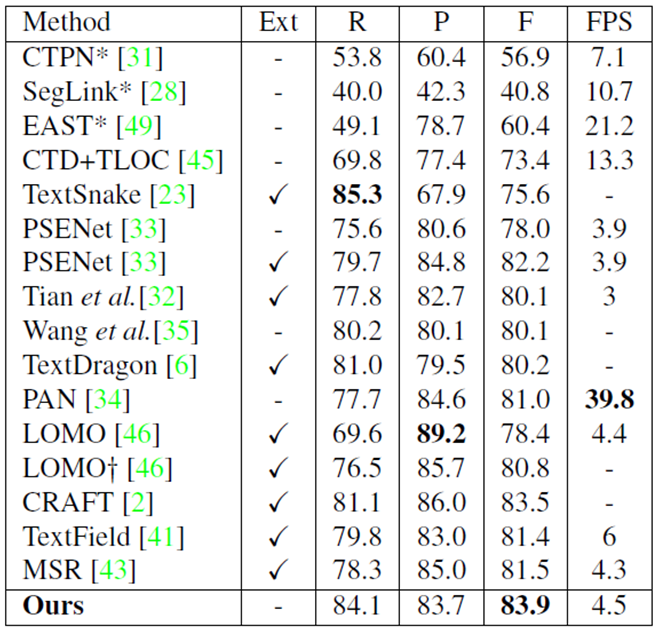

Table 1. The single-scale results on Total-Text. * indicates the results from [5]. Ext is the short for external data used in training stage. y means testing at multi-scale setting. The evaluation protocol is DetEval.

![]()

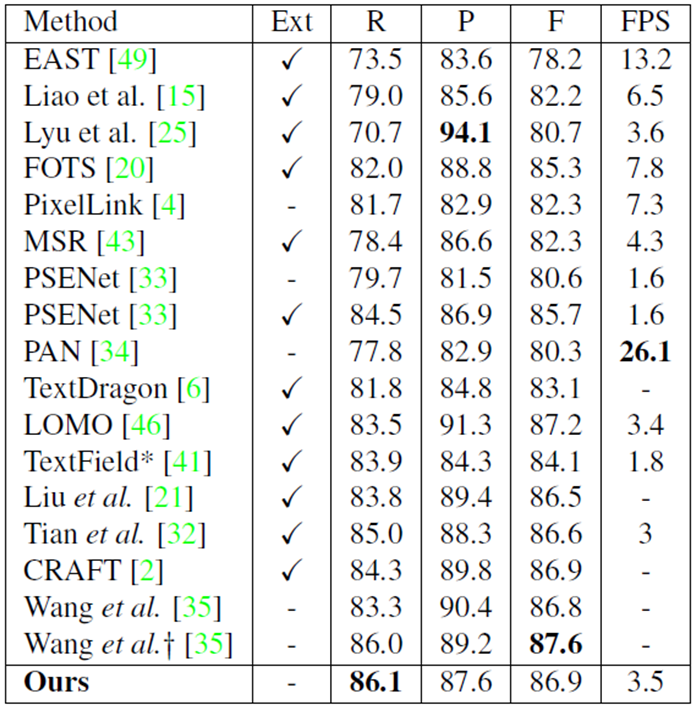

Table 2. The single-scale results on CTW1500. * indicates the results from [6]. Ext is the short for external data used in training stage. + means testing at multi-scale setting.

![]()

Table 3. The single-scale results on ICDAR2015. * means testing at multi-scale setting. + means SE blocks [7] implemented in their backbone.

![]()

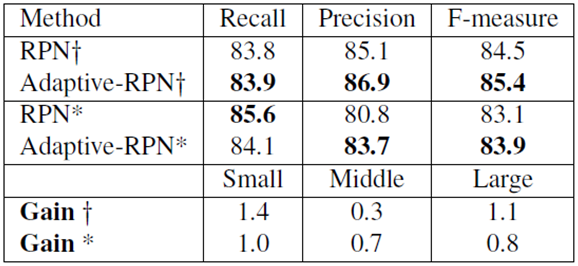

Table 4. The performance gain of Adaptive-RPN. * and + are results from CTW1500 and Total-Text respectively. Small, Middle and Large is short for small-size texts, middle-size texts and large size texts.

![]()

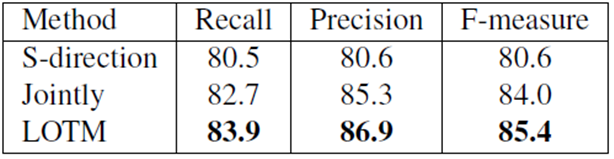

Table 5. The performance gain of LOTM on Total-Text. S direction means the texture information is only modeled along a single direction (horizontal direction is implemented here). Jointly means the method jointly models the texture information in a 3*3 convolutional kernel.

![]()

![]()

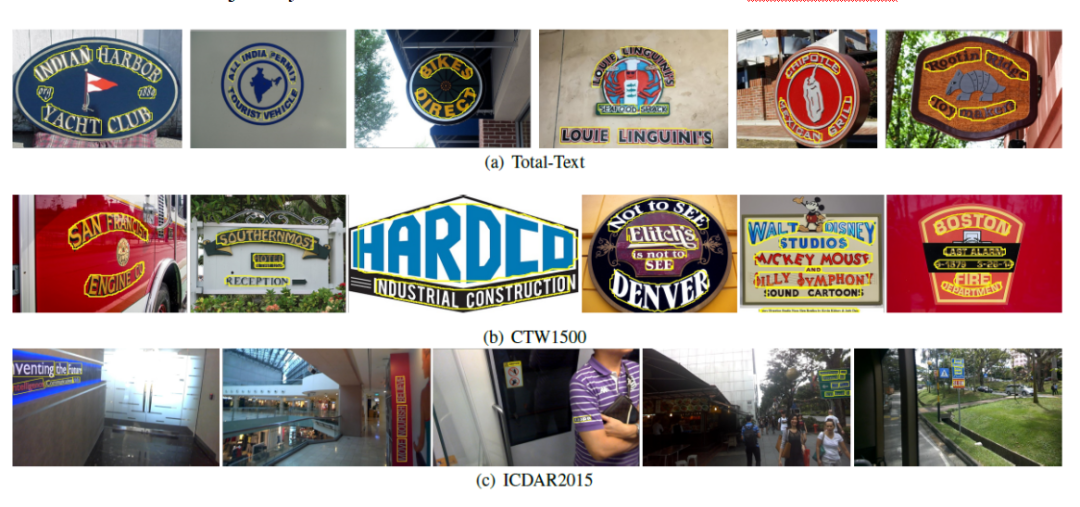

作者在Total-Text,CTW-1500,ICDAR2015,三个数据集上进行了测试,Table 1,Table 2,Table 3分别是模型在上述三个数据集的性能,可以看出ContourNet在有高精度的同时具有不错的速度。Table 4是使用RPN与本文提出的Adaptive-RPN对比结果,可以看出对不同尺度的文本都有一定的提升。Table 5是LOTM模块对比实验,可以看出使用单一方向或者3*3直接滑动卷积得到结果都比解耦成水平与竖直方向的LOTM差。

本文提出了更精确的任意方向文本检测算法ContourNet,针对伪召回问题设计了文本水平与竖直方向的轮廓检测方法,针对尺度变换大的文本回归不准问题,使用改进的9点Adaptive-RPN回归与尺度不敏感的IoU Loss计算损失。论文通过实验对比也证明了该方法的高效性以及模型的优越性能。

² ContourNet论文地址:https://arxiv.org/pdf/2004.04940.pdf

² ContourNet开源代码:https://github.com/wangyuxin87/ContourNet

[1] Tsung-Yi Lin, Piotr Doll´ar, Ross B. Girshick, Kaiming He, Bharath Hariharan, and Serge J. Belongie. Feature pyramid networks for object detection. In CVPR, pages 936–944, 2017.

[2] Shaoqing Ren, Kaiming He, Ross Girshick, and Jian Sun. Faster r-cnn: Towards real-time object detection with region proposal networks. In Advances in neural information processing systems, pages 91–99, 2015.

[3] Hamid Rezatofighi, Nathan Tsoi, JunYoung Gwak, Amir Sadeghian, Ian Reid, and Silvio Savarese. Generalized intersection over union: A metric and a loss for bounding box regression. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 658–666, 2019.

[4] Xizhou Zhu, Han Hu, Stephen Lin, and Jifeng Dai. Deformable convnets v2: More deformable, better results. In CVPR, 2019.

[5] Shangbang Long, Jiaqiang Ruan, Wenjie Zhang, Xin He, Wenhao Wu, and Cong Yao. Textsnake: A flexible representation for detecting text of arbitrary shapes. In ECCV, pages 19–35. Springer, 2018.

[6] Yuliang Liu, Lianwen Jin, Shuaitao Zhang, Canjie Luo, Sheng Zhang.Curved scene text detection via transverse and longitudinal sequence connection. Pattern Recognition 90:337–345.

[7] Jie Hu, Li Shen, and Gang Sun. Squeeze-and-excitation networks. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 7132–7141, 2018.

原文作者:Yuxin Wang, Hongtao Xie, Zhengjun Zha, Mengting Xing, Zilong Fu and Yongdong Zhang

审校:殷 飞 | 发布:金连文

免责声明:

(

1

)本文仅代表撰稿者观点,撰稿者不一定是原文作者,其个人理解及总结不一定准确及全面,论文完整思想及论点应以原论文为准。(

2

)本文观点不代表本公众号立场。

下载

在CVer公众号后台回复:CVPR2020,即可下载CVPR 2020所有论文和300+篇代码开源的论文项目,开源地址如下:

https://github.com/amusi/CVPR2020-Code

重磅!CVer-论文写作与投稿交流群成立

扫码添加CVer助手,可申请加入CVer-论文写作与投稿 微信交流群,目前已满2000+人,旨在交流顶会(CVPR/ICCV/ECCV/ICML/ICLR/AAAI等)、顶刊(IJCV/TPAMI等)、SCI、EI等写作与投稿事宜。

同时也可申请加入CVer大群和细分方向技术群,细分方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch和TensorFlow等群。

一定要备注:研究方向+地点+学校/公司+昵称(如论文写作+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

![]()

▲长按加微信群

![]()

▲长按关注CVer公众号

整理不易,请给CVer一个在看!![]()