图神经网络还能这样学,看新加坡小哥圈圈画画搞掂GNN(免费赠书)

作者:Rishabh Anand

机器之心编译

参与:Panda

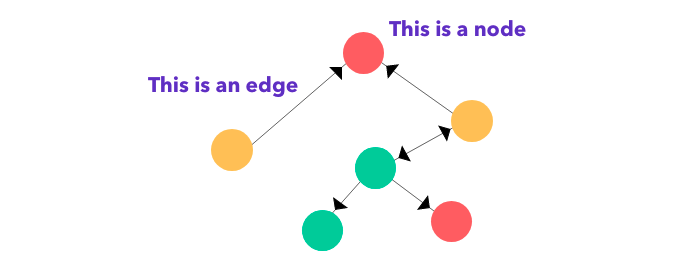

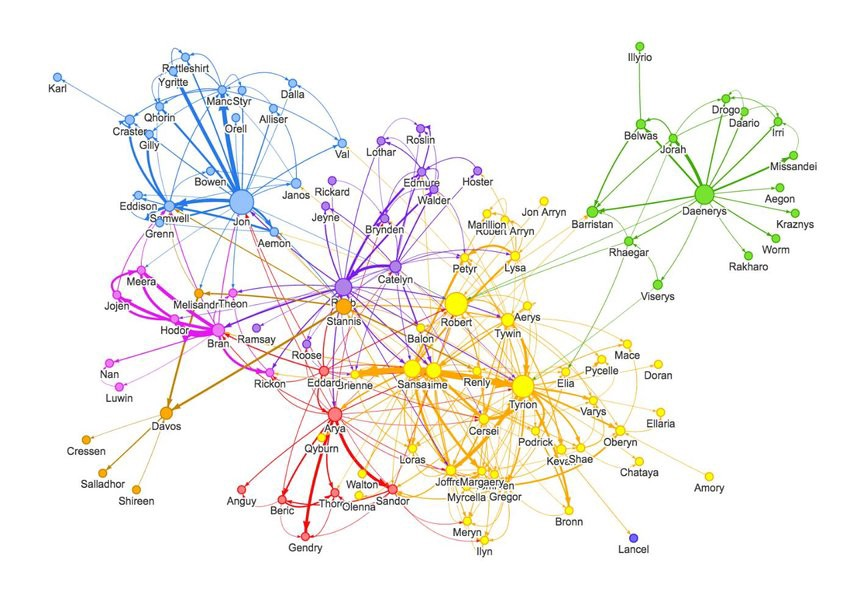

在社交网络分析等一些应用中,图神经网络已经得到了广泛的应用。新加坡科技研究局(A*STAR)的研究者 Rishabh Anand 近日通过图解的方式介绍了图与图神经网络的基本概念,或许能帮助初学者更直观地理解图神经网络的内涵和价值。此外,为了满足读者们对图神经网络的学习需求,机器之心联合极验团队向读者们赠送 20 本《深入浅出图神经网络:GNN 原理解析》,欢迎大家积极留言获得赠书。

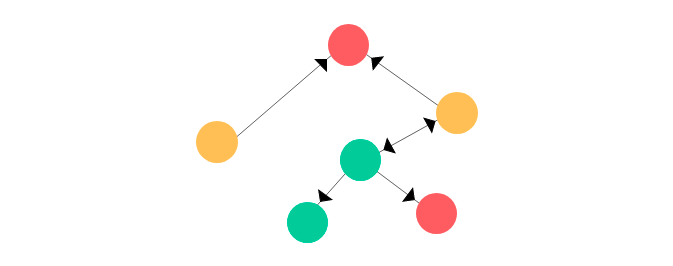

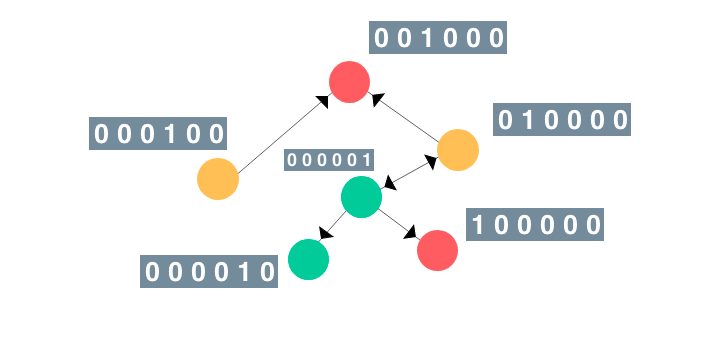

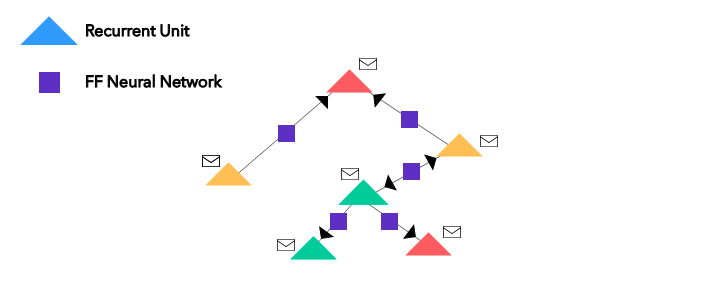

给定一个图,首先将节点转换为循环单元,将边转换为前馈神经网络;

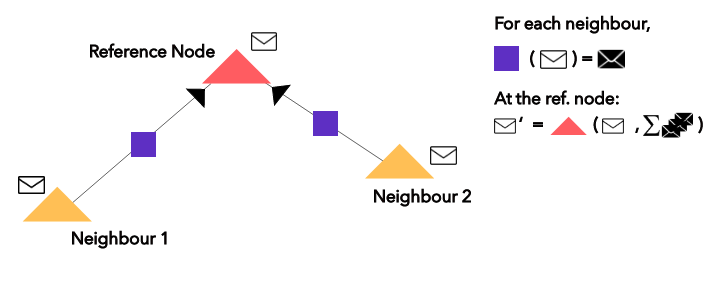

接着为所有节点执行 n 次近邻聚合(也就是消息传递);

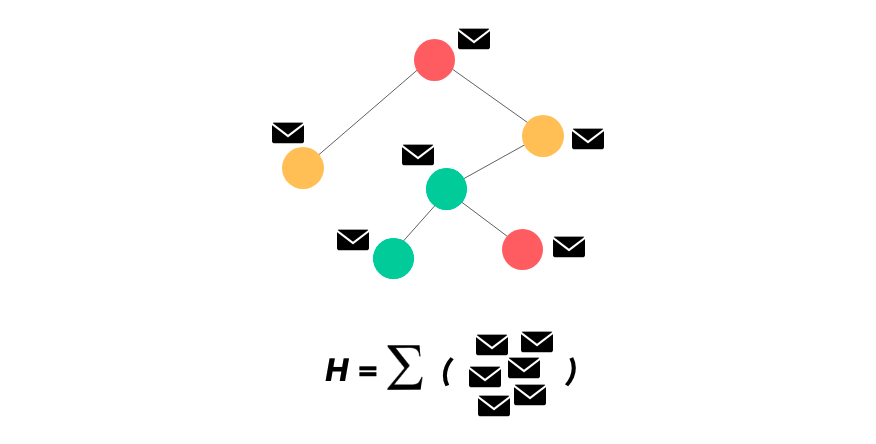

然后再在所有节点的嵌入向量上求和以得到图表征 H;

最后可以完全跳过 H 直接向更高层级进发或者也可使用 H 来表征该图的独有性质。

登录查看更多