开课|3月27晚8点ISU博士详解:k均值算法

《深度学习专业班》系列课:3月27晚8点ISU博士详解:k均值算法!

《全球人工智能学院》专注于AI技术人才教育。为AI学习者提供“技术理论+技术实战相结合的AI技术培训;学习群+辅导员双轨制的AI学习辅导;非商业项目+商业项目并行的AI项目开发”。致力于培养出既懂理论,又能实战的AI技术人才。

《深度学习专业班》邀请名校AI博士带你从零学习深度学习:从基础的名词概念,数学符号、数学公式推导、算法模型、神经网络模型到全球最新深度学习算法技术Paper解读。每周2次直播,全年80次理论+实战课。(讲师直播答疑,学员社群7*24小时交流,助教每天辅导学习,从理论到实践,只有一个目标:让你学会!)

直播:每周二、周四 20:00开始,随时回放

讲师:全球名校AI博士+全球名企AI工程师

服务:名师授课+社群交流+助教辅导+线下交流

资料1:算法相关数学符号表

资料2:AI相关词汇中英文对照表

资料3:算法相关词汇的概念和含义表

1月25日:邹博(中科院)

1.1 机器学习介绍

1.1.1 机器学习的概念

1.1.2 机器学习的流程

1.1.3 机器学习的分类

1.2 监督学习/非监督/半监督

1.2.1 监督学习的概念和含义

1.2.2 监督学习的模型和原理

1.2.3 监督学习的主要算法

1.2.4 监督学习的主要应用

1.2.5 非监督学习与和半监督学习

1.3 强化学习

1.3.1 强化学习的概念和含义

1.3.2 强化学习的模型和原理

1.3.3 强化学习的主要算法

1.3.4 强化学习的主要应用

1.4 迁移学习

1.4.1 迁移学习的概念和含义

1.4.2 迁移学习的分类

1.4.3 迁移学习的主要算法

1.4.4 迁移学习的主要应用

1.5 模型评估与选择方法

1.5.1 经验误差和过拟合

1.5.2 评估的主要方法

1.5.3 性能度量和比较检验

1.5.4 偏差和方差

2月1日:欧阳若飞(NUS博士)

2.1 线性回归

2.1.1 一元线性回归

2.1.2 多元线性回归

2.1.3 带正则项的线性回归

2.1.4 带核函数的线性回归

2.1.5 线性回归的实例分析

2月6日:陈兴委(国科大博士)

2.2 逻辑回归/softmax回归

2.2.1 逻辑回归的概念和分布介绍

2.2.2 逻辑回归的模型和参数估计

2.2.3 逻辑回归的损失函数和优化方法

2.2.3 逻辑回归的正则化

2.2.4 softmax回归的介绍

2.2.5 逻辑回归的实例分析

2月8日:邓博文(Stanford 博士)

2.3 决策树

2.3.1 决策树思想

2.3.2 决策树算法

2.3.3 决策树实例

2.3.4 决策树延伸

3月6日:王老师(TAMU博士)

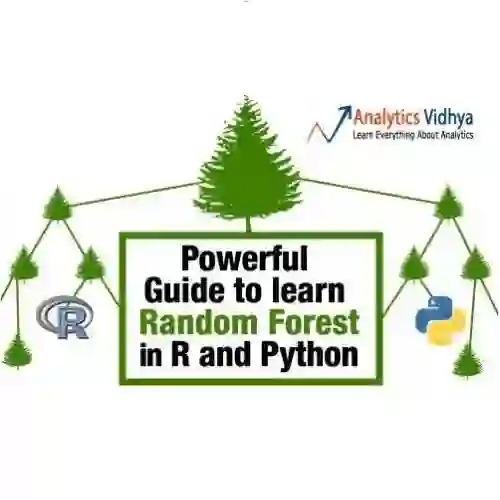

2.4 随机森林

2.4.1 随机森林与决策树的关系

2.4.2 随机森林的特点

2.4.3 随机森林的构建生成

2.4.4 随机森林的工作原理

2.4.5 随机森林的评估

2.4.6 随机森林的应用

3月8日:高老师(ISU 博士)

2.5 支持向量机

2.5.1 支持向量机的概念和类型

2.5.2 线性可分支持向量机与硬间隔最大化

2.5.3 线性支持向量机与软间隔最大化

2.5.4 非线性支持向量机与核函数

2.5.5 序列最小最优化算法

2.5.6 支持向量机的应用

3月13日:欧阳若飞(NUS博士)

2.6 集成算法

2.6.1 个体与集成

2.6.2 Boosting介绍

2.6.2.1 Adaboost

2.6.2.2 GBDT

2.6.2.3 XGBoost

2.6.3 Bagging介绍

2.6.4 结合的策略

2.6.5 多样性

2.6.6 集成算法的应用

3月15日:欧阳若飞(NUS博士)

2.7 Gradient Boost

2.7.1 Gradient Boost的概念与特点

2.7.2 Gradient Boost的算法流程

2.7.3 Gradient tree boosting

2.7.4 Gradient Boost正则化

2.7.5 Gradient Boost 的应用

3月20日:陈兴委(国科大博士)

2.8 朴素贝叶斯

2.8.1 朴素贝叶斯相的关数学知识

2.8.2 朴素贝叶斯的模型

2.8.3 朴素贝叶斯的推断过程

2.8.4 朴素贝叶斯的参数估计

2.8.5 朴素贝叶斯的算法流程

2.8.6 朴素贝叶斯的优缺点分析

2.8.7 朴素贝叶斯的应用

3月22日:陈兴委(国科大博士)

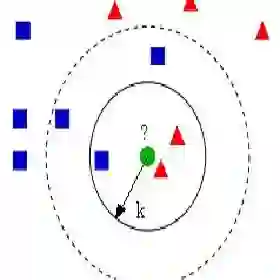

2.9 k最近邻算法

2.9.1 k最近邻算法概念和特点介绍

2.9.2 k最近邻算法流程

2.9.3 k最近邻算法模型

2.9.4 k最近邻算法距离度量

2.9.5 k最近邻算法k值的选择

2.9.6 k最近邻算法分类决策规则

2.9.7 k最近邻算法实现:kd树

2.9.8 k最近邻算法应用

3月27日:高老师(ISU 博士)

2.10 k均值算法

2.10.1 k均值算法概念、流程和特点介绍

2.10.2 k值的选择方法

2.10.3 k均值算法质心的选择

2.10.4 k均值算法距离的度量

2.10.5 k均值算法质心的计算

2.10.6 k均值算法评价标准和停止条件

2.10.7 空聚类的处理

2.10.8 k均值算法的应用和实现

2.10.9 二分K均值算法

3月29日:高老师(ISU 博士)

2.11 降维算法

2.11.1 降维算法的概念与介绍

2.11.2 降维的出发角度

2.11.3 典型的降维方法与流程

2.11.3.1主成分分析PCA

2.11.3.2多维缩放(MDS)

2.11.3.3线性判别分析(LDA)

2.11.3.4等度量映射(Isomap)

2.11.3.5局部线性嵌入(LLE)

2.11.3.6t-SNE

2.11.3.7Deep Autoencoder Networks

2.11.4 降维算法的应用

2.12 遗传算法

2.12.1 遗传算法的概念和特点介绍

2.12.2 遗传算法的基本原理与流程

2.12.3 基本遗传算法和算法的改进

2.12.4 遗传算法中的各种函数

2.12.5 遗传算法的实例应用

2.13 隐性马尔科夫模型

2.13.1 隐性马尔科夫模型的概念与基本问题

2.13.2 隐形马尔科夫模型的概率计算

2.13.3 隐性马尔科夫的学习算法

2.13.4 隐性马尔科夫的预测算法

2.14 高斯判别算法

2.14.1 高斯判别算法的概念与特点

2.14.2 高斯判别算法的推导过程

2.14.3 算法分析

2.14.4 高斯判别分析模型

2.14.5 高斯判别算法的应用实现

2.15 优化算法

2.15.1 梯度下降

2.15.2 牛顿动量

2.15.3 Adagrad

2.15.4 RMSProp

2.15.5 Adadelta

2.15.6 Adam

2.16 DBSCAN

2.16.1 DBSCAN的概念与原理

2.16.2 DBSCAN的流程

2.16.3 DBSCAN参数设置

2.16.4 DBSCAN算法描述

2.16.5 DBSCAN算法的聚类过程

2.16.6 算法伪代码

2.16.7 DBSCAN的应用

2.17 DensityPeak

2.17.1 Density Peak的概念与特点

2.17.2 Density Peak算法思想

2.17.3 Density Peak聚类过程

2.17.4 聚类中心的选择

2.17.5 可靠性度量

2.17.6 Density Peak的实验效果

2.17.7 Density Peak的应用

2.18 Hierarchical Clustering

2.18.1 层次聚类的概念与原理

2.18.2 层次聚类的步骤流程

2.18.3 创建聚类树的两种方法

2.18.3.1 自下而上合并

2.18.3.2 自上而下分裂

2.18.4 层次聚类的算法描述

2.18.5 相似性度量

2.18.6 层次聚类树状图

2.18.7 层次聚类的应用

2.19 Spectral Clustering

2.19.1 谱聚类的概念和原理分析

2.19.2 谱聚类的算法流程

2.19.2.1 相似度矩阵S的构建

2.19.2.2 相似度图G的构建

2.19.2.3 拉普拉斯矩阵

2.19.2.4 无向图的切割

2.19.2.5 生成最小的特征值和特征向量

2.19.2.6 用特征向量进行聚类

2.19.3 谱聚类与K均值算法的关系

2.19.4 谱聚类代码分析

2.19.5 谱聚类的应用

3.1 神经网络和深度学习介绍

3.1.1 神经网络的概念、含义

3.1.2 深度学习的概念,流程、评估指标和分类

3.13 神经网络与深度学习的关系

3.2 每种神经网络的网络结构、特点和用途等介绍

3.2.1 感知机(P)

3.2.2 前馈网络(FF)

3.2.3 径向基网络(RBF)

3.2.4 深度前馈(DFF)

3.2.5 自动编码网络(AE)

3.2.6 变分自编码器 (VAE)

3.2.7 去噪自动编码(DAE)

3.2.8 稀疏的自动编码(SAE)

3.2.9 马尔可夫链(MC)

3.2.10 霍普菲尔网络(HN)

3.2.11 玻尔兹曼机(BM)

3.2.12 受限玻尔兹曼机(RBM)

3.2.13 深度置信(信念)网络(DBN)

3.2.14 神经图灵机(NTM)

3.2.15 深度残差网络(DRN)

3.2.16 回声状态网络(ESN)

3.2.17 极限学习机(ELM)

3.2.18 液态状态机 (LSM)

3.2.19 反向传播 (BP)

3.2.20 Kohonen网络(KN)

3.3 深度神经网络(DNN)

3.3.1 深度神经网络结构和前向传播

3.3.2 深度神经网络的反向传播算法

3.3.3 深度神经网络的损失函数和激活函数选择

3.3.4 深度神经网络的正则化

3.4 卷积神经网络(CNN)

3.4.1 卷积神经网络的模型和原理

3.4.2 卷积神经网络的正向传播

3.4.3 卷积神经网络的反向传播

3.4.4 RCNN/Fast-RCNN/Faster-RCNN/MaskRCNN

3.4.5 卷积神经网络的其他变体:DCNN/DN/DCIGN

3.4.6 CNN的实际应用

3.5 循环神经网络 (RNN)

3.5.1 循环神经网络的模型和原理

3.5.2 循环神经网络的前向反向传播

3.5.3 LSTM模型和前向反向传播

3.5.4 门控循环单元(GRU)

3.5.5 循环神经网络其他变种

3.5.6 RNN的实际应用

3.6 生成式对抗网络(GAN)

3.6.1 生成式对抗网络的模型和原理

3.6.2 Conditional GAN

3.6.3 DCGAN

3.6.4 WGAN

3.6.5 BEGAN

3.6.5 EBGAN

3.6.6 LS-GAN

3.6.7 cycle-GAN

3.6.8 Stack-GAN

3.6.9 InfoGAN

3.6.10 GAN的实际应用

3.7 记忆网络(MemNN)

3.7.1 记忆网络的概念和原理分析

3.7.2 记忆网络的流程与框架

3.7.3 实现文本的记忆网络

3.7.3.1 基本模型

3.7.3.2 一串的词作为输入

3.7.3.3 高效率的哈希内存

3.7.3.4 写入时间的模型化

3.7.3.5 未见过的词的模型化

3.7.3.6 准确匹配与未见过的词

3.7.4 记忆网络的实验方法

3.7.4.1 数据集

3.7.4.2 与其他方法的对比

3.7.4.3 运行时间

3.7.4.4 计算单元层数的作用

3.7.4.5 错误分析

3.7.5 记忆网络的应用案例

3.8 胶囊网络(CapsuleNet)

3.8.1 胶囊网络的概念与原理

3.8.2 胶囊网络的结构分析与流程

3.8.3 胶囊网络的算法

3.8.3.1 输入向量的矩阵乘法

3.8.3.2 输入向量的标量加权

3.8.3.3 加权输入向量之和

3.8.3.4 压缩3.8.4 Reconstruction模块

3.8.5 囊间动态路由算法

3.8.5.1 囊间动态路由

3.8.5.2 权重更新的直观例子

3.8.5.3 路由的迭代

3.8.6 胶囊网络的应用

......更多课程点击“阅读原文”,查看详情