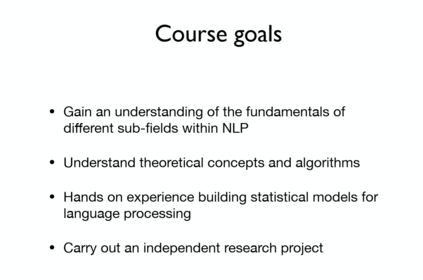

课程简介: 本课程将向学生介绍NLP的基础知识,涵盖处理自然语言的标准框架以及解决各种NLP问题的算法和技术,包括最新的深度学习方法。 涵盖的主题包括语言建模,表示学习,文本分类,序列标记,语法解析,机器翻译,问题解答等。

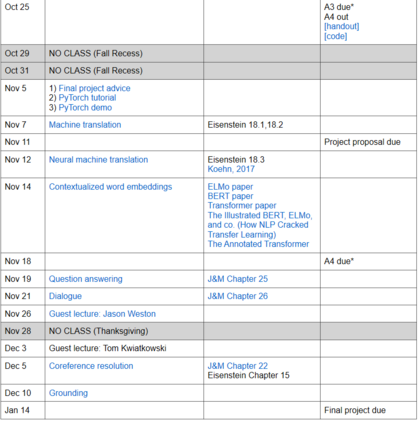

课程安排:

- 概述与简介

- 语言模型

- 文本分类

- 线性模型

- 词嵌入

- 神经网络基础

- 序列模型

- EM模型

- RNN神经语言模型

- 解析介绍

- 机器翻译

- 神经机器翻译

- 文本词嵌入

- 问答系统

- 对话系统

- 嘉宾讲座

嘉宾介绍:

陈丹琦,普林斯顿大学计算机科学的助理教授,在此之前,是西雅图Facebook AI Research(FAIR)的访问科学家。 斯坦福大学计算机科学系获得博士学位,并在斯坦福NLP集团工作。研究方向:自然语言处理,文本理解、知识解释。

Karthik Narasimhan,普林斯顿大学计算机科学系助理教授,研究跨越自然语言处理和强化学习。

成为VIP会员查看完整内容