WWW2022|去芜存菁:基于互信息压缩的紧致图结构学习

1 介绍

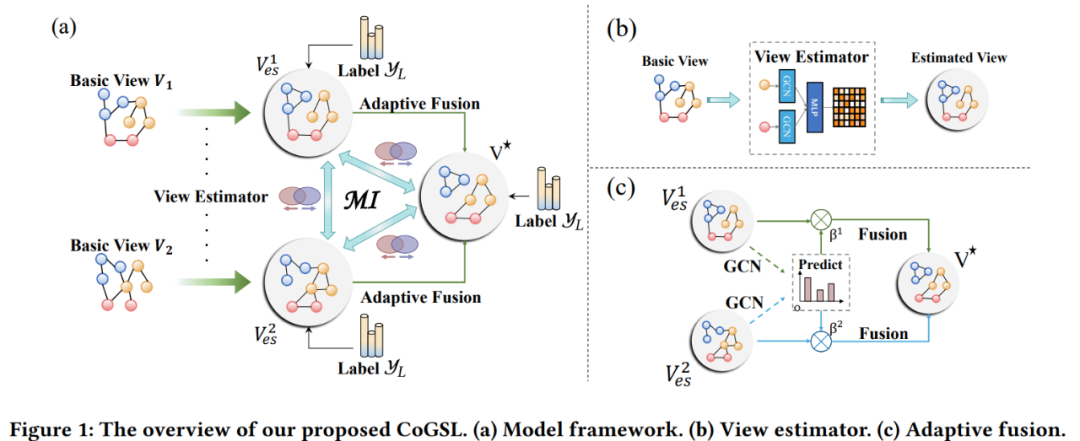

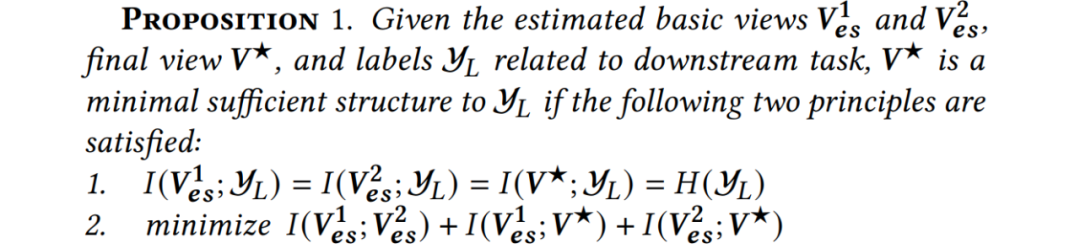

(1)如何确保最终视图的最小以及充分 首先是如何将这一准则形式化。为了达到充分,最终视图应充分由标签指导,从而尽可能包含和标签有关的信息;为了达到最小,需要限制信息从基础视图向最终视图的流动。 (2)如何确保基础视图的有效性 作为最终视图的信息源,基础视图需要保证较高质量。一方面,基础视图需要包含标签的信息;另一方面,不同视图间应相互独立,消除彼此间的冗余。

2 模型介绍

2.1 基础视图选取

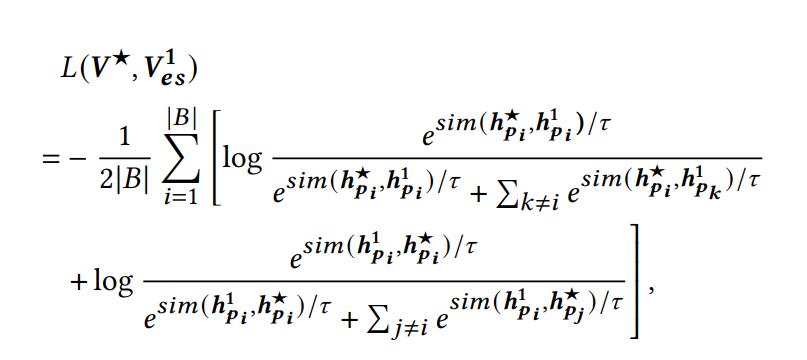

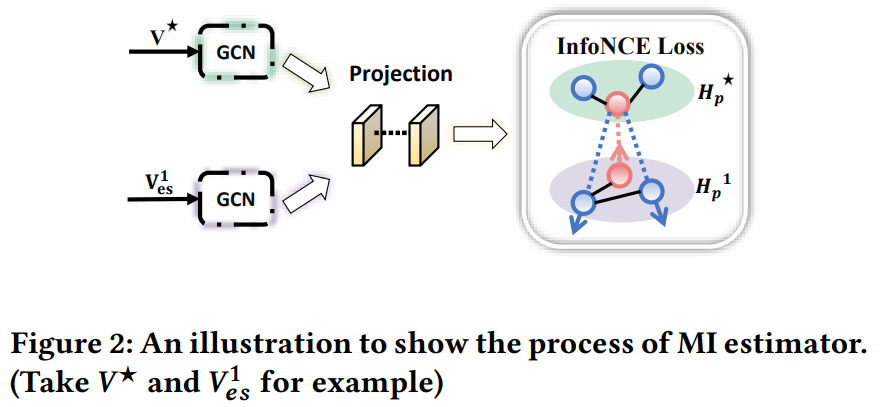

2.2 视图评估器

2.3 视图融合

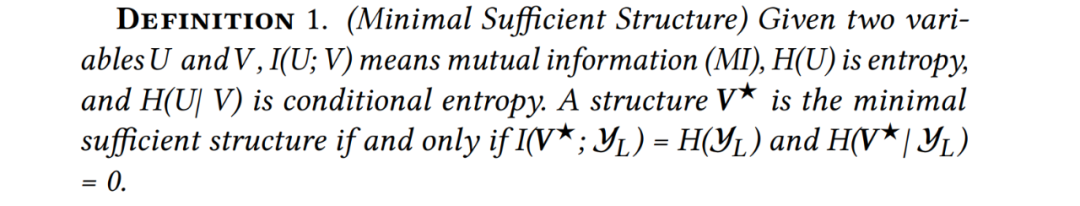

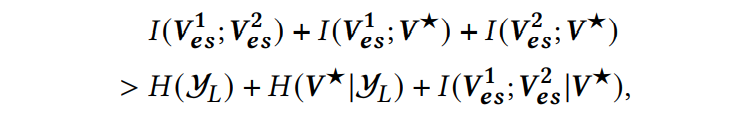

2.4 最小充分结构V*

优化分类器 优化互信息评估器 优化视图估计器

3 实验

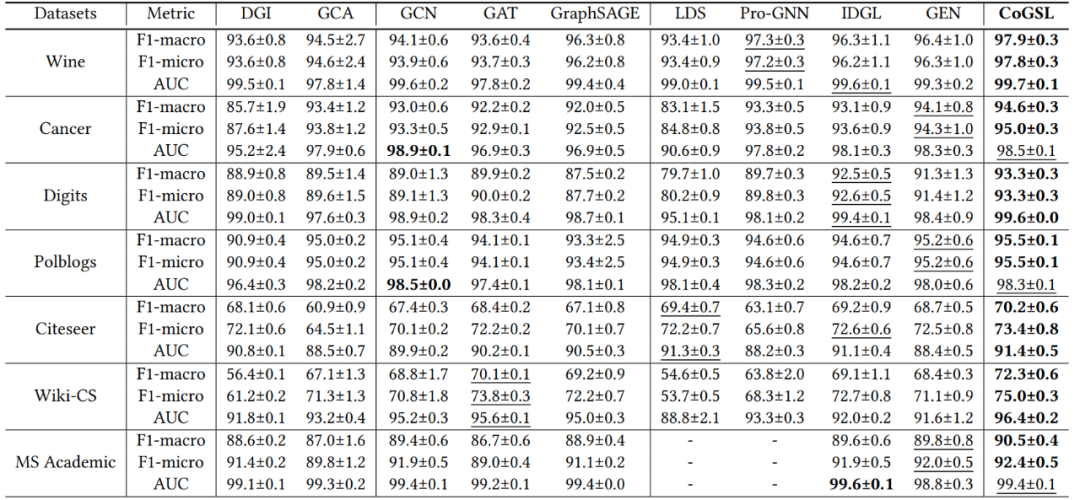

3.1 节点分类

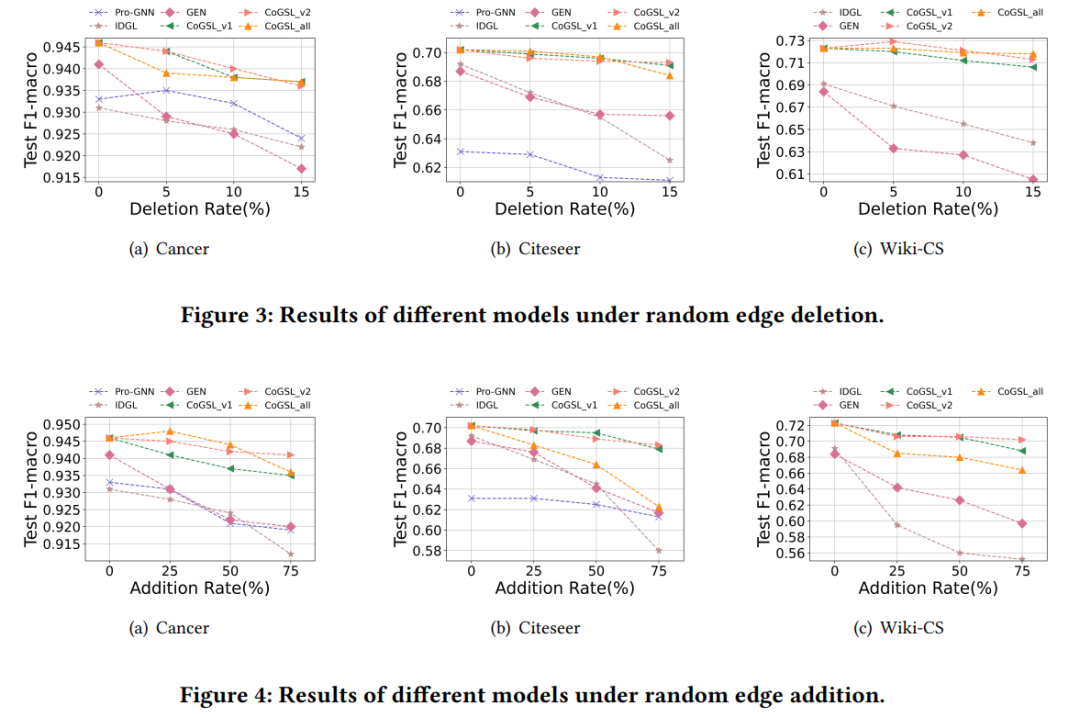

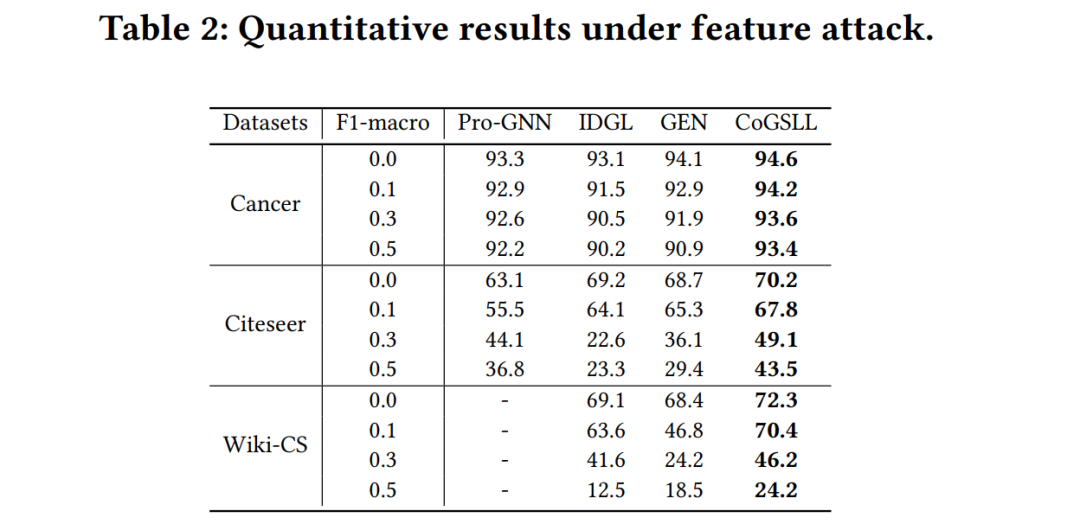

3.2 鲁棒性实验

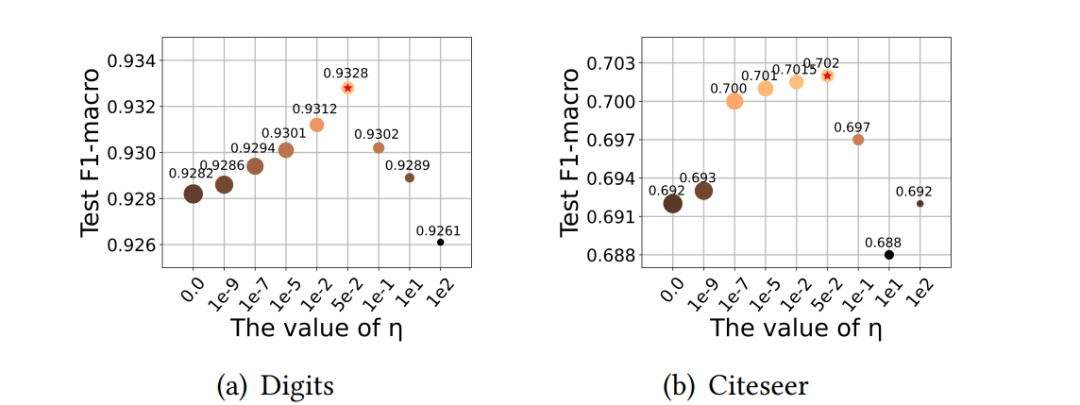

3.3 互信息分析

4 参考文献

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“CGSI” 就可以获取《【WWW2022】互信息压缩的紧凑图结构学习》专知下载链接

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年4月19日

Arxiv

0+阅读 · 2022年4月15日

Arxiv

15+阅读 · 2021年5月19日