GPNet: 一种端到端全自由度抓取姿态估计网络简介

摘要 机器人抓取物体是机器人模仿人类行为的一项基本功能。机器人从视觉观测中学习如何合理地抓取场景中的物体,是一项具有实际应用但又具有挑战性的任务。例如物品的分拣、家庭智能机器人与人的交互等场景中,都会涉及到机器人抓取任务。这个任务的挑战在于:1)视觉感知具有一定的不精确性和噪声,2)机器人在规划抓取路径和执行抓取时可能有一定的系统误差,3)单从视觉观测中,机器人无法获取被抓取物体的物理属性,例如物体的重心、材质、摩擦系数等等。

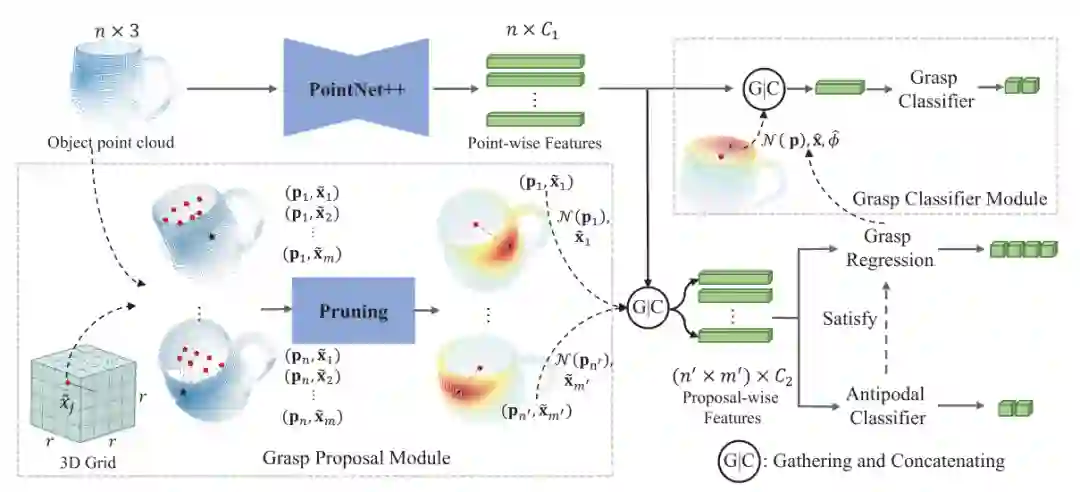

近期的一些工作[1], [2]表明了利用大规模的合成数据来训练深度学习模型,可以在真实场景中达到很好的鲁棒性和泛化能力,即使合成数据与真实数据有一定的域间差异。但现在的这些工作主要集中于解决基于四自由度(4-DOF)的平面抓取,即机器人的爪子是垂直于桌面从上往下抓取物体的,这大大限制了机器人抓取的灵活性。因此,本文提出了一个合成的六自由度(6-DOF)的数据集,同时提出了生成六自由度抓取的神经网络结构Grasp Proposal Network(GPNet)。我们的方法相对于现有的6-DOF抓取方案[3], [4],在抓取成功率和抓取多样性两个标准上都有很大的提升。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2020年11月30日