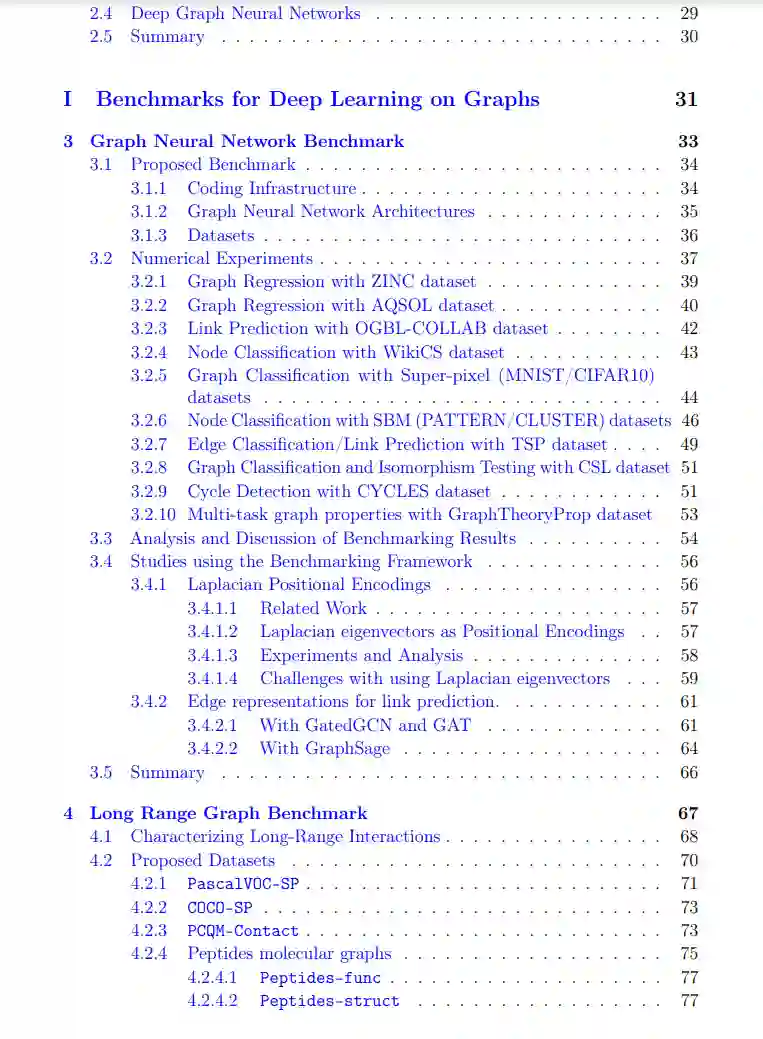

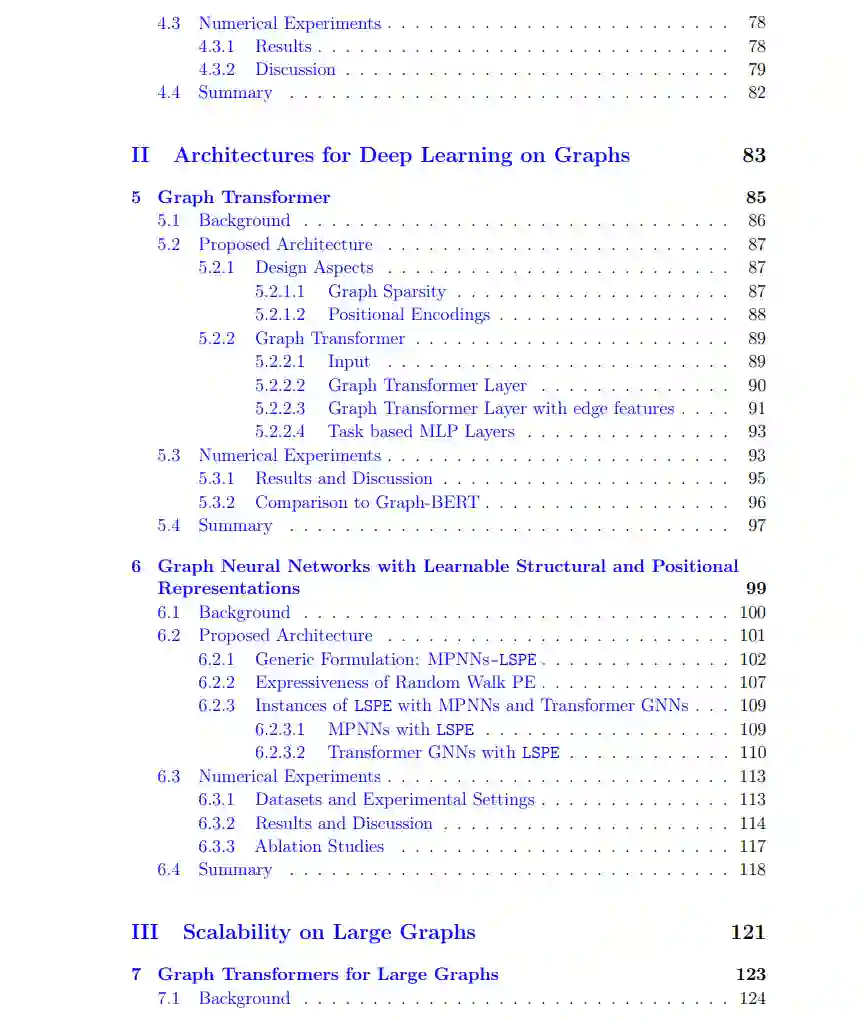

图结构数据在各个领域中广泛存在,表示实体之间有价值的关系信息。然而,大多数深度学习技术,如卷积神经网络(CNN)和循环神经网络(RNN),都是针对网格结构数据设计的,难以处理图数据。这引发了对使用图神经网络(GNNs)进行图表示学习的日益兴趣。GNNs通常通过消息传递将图结构融入神经网络层中。然而,图神经网络仍面临诸多挑战,如缺乏严格的基准、模型表达能力的局限性和较差的可扩展性。 本论文旨在通过解决这些关键问题,推动图表示学习的发展。首先,它开发了全面的基准,用于标准化评估GNNs。这包括中等规模的任务,涵盖社交网络、计算机视觉和组合优化等领域中节点、边和图分类的监督和半监督学习。论文还引入了一个专门设计的全新基准,用于测试大规模图中长距离交互建模的能力。

其次,论文致力于开发新的GNN架构,以提高图上的学习表现和泛化能力。它通过引入图形领域的归纳偏差(如利用稀疏性和设计Laplacian位置编码)将Transformer网络扩展到图结构数据领域。另一种技术通过使用具有信息量的图扩散特征,在GNN中分别学习结构和位置表示。这显著增强了模型的能力。

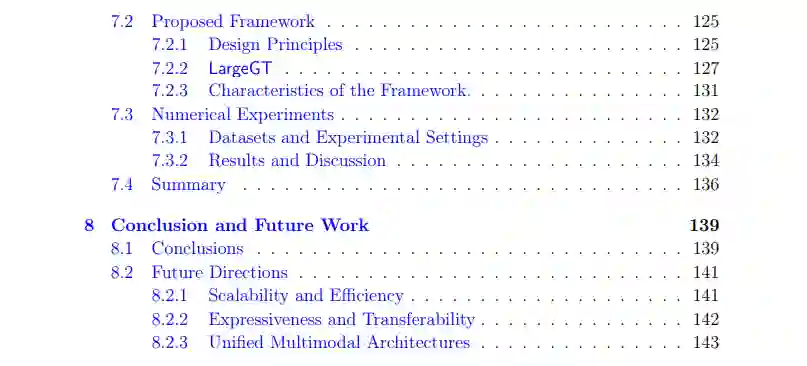

最后,论文解决了图模型(尤其是图Transformer)在大规模图上扩展的问题。它研究了设计原则,如整合高效的局部和全局图表示。基于此,提出了一个可扩展的图Transformer框架。该框架通过引入新颖的邻域采样和全局注意机制,捕捉大规模图中的局部结构和全局依赖关系。

总体而言,通过严格的基准测试、富有表现力的架构和可扩展的模型,本论文在多个方面对推动图结构数据上的深度学习做出了重要贡献。这些技术为GNN在处理复杂关系数据的实际应用中铺平了道路。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2024年10月4日