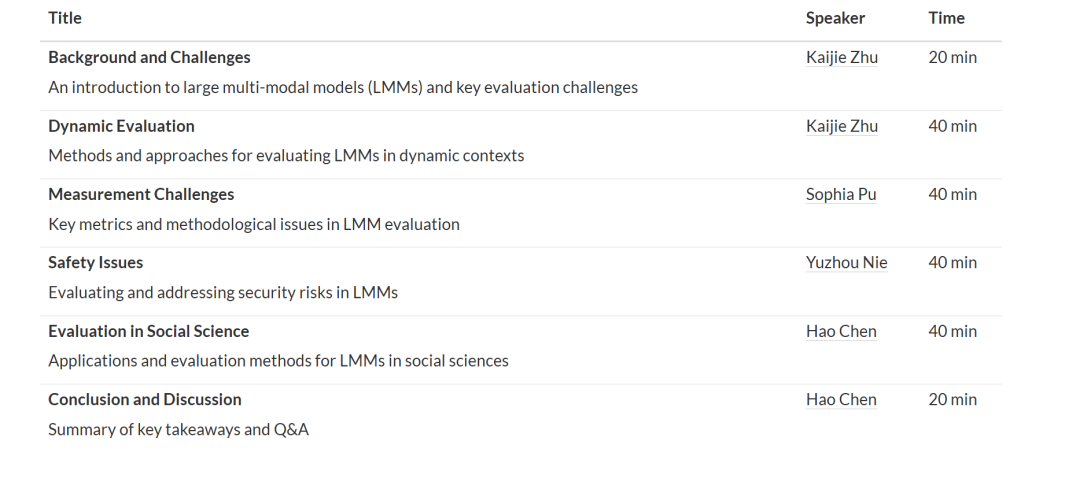

随着大规模多模态模型(LMMs)的迅速发展,人们对其安全性与潜在风险的关注也日益增加。这些担忧主要源于我们对其能力与局限性的认知尚不充分。在本次教程中,我们旨在填补这一空白,提供对 LMM 评估的全面概览。 首先,我们从“评估什么”、“在哪里评估”以及“如何评估”这三个维度出发,梳理 LMM 评估的最新进展。接着,我们提出当前 LMM 评估中面临的若干关键挑战,例如数据污染和固定复杂度问题,并介绍应对这些挑战的方法。 此外,我们还将探讨包括可信度、鲁棒性与公平性在内的关键评估指标,并评估 LMM 在自然科学与社会科学等多种下游任务中的表现。最后,我们总结了一些广泛使用的评估代码库与基准测试工具,以支持相关研究工作。 我们希望本教程能推动学术界与工业界持续关注 LMM 的安全性、责任性与准确性,共同促进多模态人工智能的健康发展。

成为VIP会员查看完整内容

相关内容

Arxiv

40+阅读 · 2023年4月19日

Arxiv

79+阅读 · 2023年4月4日

Arxiv

144+阅读 · 2023年3月29日

Arxiv

83+阅读 · 2023年3月21日