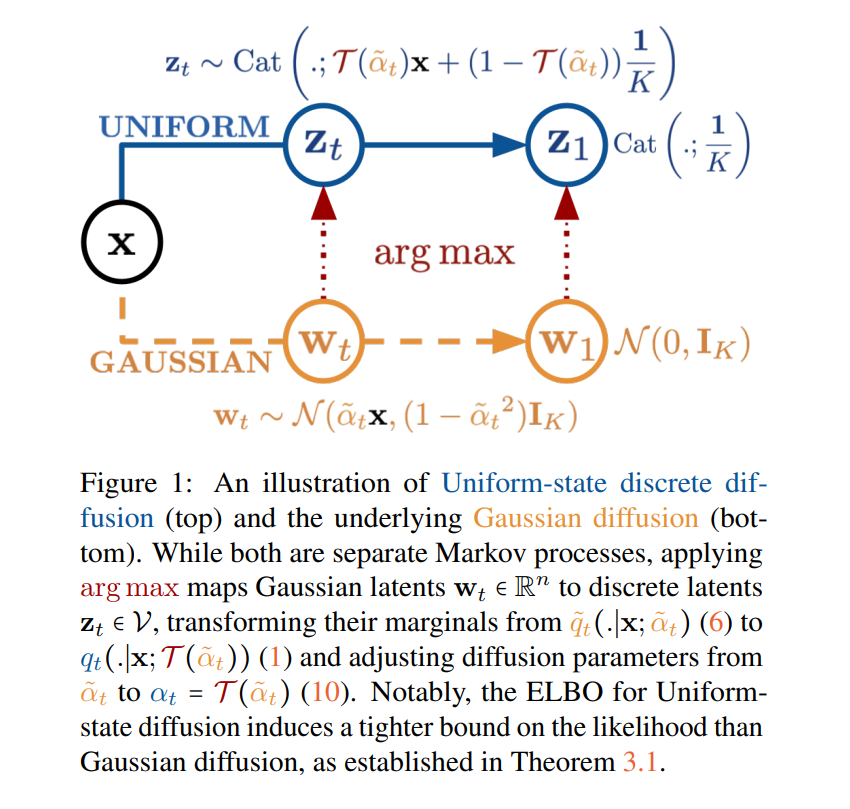

统一状态的离散扩散模型因其内在的自我纠错能力,被认为具有快速文本生成的潜力。然而,实际中它们的性能通常不如自回归模型(autoregressive models)和掩码扩散模型(masked diffusion models)。本研究旨在通过一个关键洞察来缩小这一性能差距:统一状态扩散过程本质上可由底层的高斯扩散自然导出。 我们提出了一种新方法 Duo,通过将高斯扩散中的先进技术迁移到离散扩散模型中,以提升训练与采样效果。 * 首先,我们引入了一种由高斯过程指导的课程学习策略(curriculum learning),通过降低方差,将训练速度提高了一倍。采用课程学习训练的模型在 7 个基准测试中的 3 个上,其零样本困惑度(zero-shot perplexity)超过了自回归模型。 * 其次,我们提出了离散一致性蒸馏(Discrete Consistency Distillation),该方法将“连续一致性蒸馏(consistency distillation)”扩展至离散领域。这一算法实现了扩散语言模型的少步采样(few-step generation),使采样速度提高了两个数量级。

相关代码与模型检查点可在项目主页获取: 👉 https://s-sahoo.com/duo

成为VIP会员查看完整内容

相关内容

Arxiv

40+阅读 · 2023年4月19日

Arxiv

211+阅读 · 2023年4月7日

Arxiv

79+阅读 · 2023年4月4日