![]() 蛋白质工程领域旨在通过合成全新蛋白质或修改现有分子来开发和改进分子属性和功能,如化学活性和热稳定性。定向进化模仿自然进化,但在快速尺度上进行。蛋白质被修改并筛选出感兴趣的功能,最优秀的候选者被用作进一步迭代的起点,直到识别出最佳候选分子。近年来,AI技术在蛋白质工程和定向进化流程的开发上取得了迅速进展,然而,收集对于监督学习方法所必需的大型、高质量训练数据集既耗时又耗资源。为了帮助解决这些问题,以下论文开发了数据高效的机器学习引导的蛋白质工程方法,目标是改进开发并减少实验负担。 第一章描述了现代机器学习引导的蛋白质工程的相关领域和方法,以及工作的动机。本论文专注于不需要结构信息的蛋白质序列数据的机器学习,并简要概述了文献。论文认为,尽管监督学习方法已经相当成功,但大多数方法需要为手头任务精心设计的大型数据集,因此该领域可以从稳健的、数据高效的机器学习方法中受益。最后,详细介绍了本工作开发的方法,包括数据增强、元学习和语言模型。 第二章提出了一种用于蛋白质序列数据学习的数据增强方法。包括计算机视觉和自然语言处理(NLP)在内的传统机器学习领域定期利用数据增强来提高机器学习模型的鲁棒性和性能。然而,蛋白质序列数据缺乏在其他领域发现的易用和有效的数据增强技术,这可能是由于蛋白质的离散氨基酸序列与其结构和功能之间的关系。为此,开发了核苷酸增强,利用自然的核苷酸密码子简并性作为数据增强策略来合成增加训练集大小。为了详细探索这一概念,提出了几种算法和实现,并使用多个为机器学习引导的蛋白质工程建立的基准数据集(包括回归和分类任务)进行评估。提出了关于密码子简并性作为数据增强技术的额外问题,例如,是否有意义尊重在自然界中发现的密码子到氨基酸的关系,或者任意指定的标记扩展是否仍能提高模型性能。最终,发现核苷酸增强特别改善了在数据量少或类别不平衡严重时的困难学习任务的性能。 生物测定是嘈杂和耗时的。此外,将先前收集的数据集适应新任务可能昂贵或不可行。为了解决这个问题,第三章详细介绍了从嘈杂和标签不足的数据中学习的元学习框架的开发。为了证明该框架对蛋白质工程中各种场景的有用性和适用性,设计、生成并筛选了大型、多样化的酵母展示抗体库以绑定到目标抗原。然后将生成的数据集策划为蛋白质工程工作流程中相关的三个任务:从嘈杂数据中学习以减少实验要求、在没有真正阴性的情况下学习、以及预测分布外属性。选择了一个双层优化的元学习框架,其中内循环在大型、嘈杂或标签不足的数据上训练,外循环可以访问一个小型、干净、标签完善的数据集。外循环指导内循环的学习,忽略噪声、放大信号,并适应感兴趣的领域。通过广泛的实验和基准测试,研究了所开发框架的有效性和局限性。最后,由于工作的成功,讨论了框架的未来潜在应用。 第四章探索了如何通过蛋白质语言模型的转移学习和高效的多标签学习策略,帮助预测病毒从治疗性抗体中逃逸。通过蛋白质突变、表面展示和深度测序建立了SARS-CoV-2抗体逃逸的实验合成共进化系统。筛选了SARS-CoV-2受体结合域的变体库,以绑定和逃逸三十八种临床抗体和人类ACE2受体。尽管这一实验过程生成了大型和多样化的多标签数据集,但它在标签之间和标签内部都高度不平衡,使学习复杂化。为了解决这个问题,同时实施了两种策略:使用蛋白质语言模型的转移学习和使用变压器和掩蔽标签建模学习标签间关系。通过广泛的实验和基准测试,展示了该方法的有效性。此外,使用可解释AI技术来探测学习到的模式,并与生物学上有意义的趋势画上等号。 第五章对整个工作进行了讨论。详细讨论了本论文中提出的工作的贡献和意义,以及工作的不足。然后将这些贡献放在机器学习引导的蛋白质工程和一般机器学习的更广泛背景下。最后,讨论了未来的方向和应用。

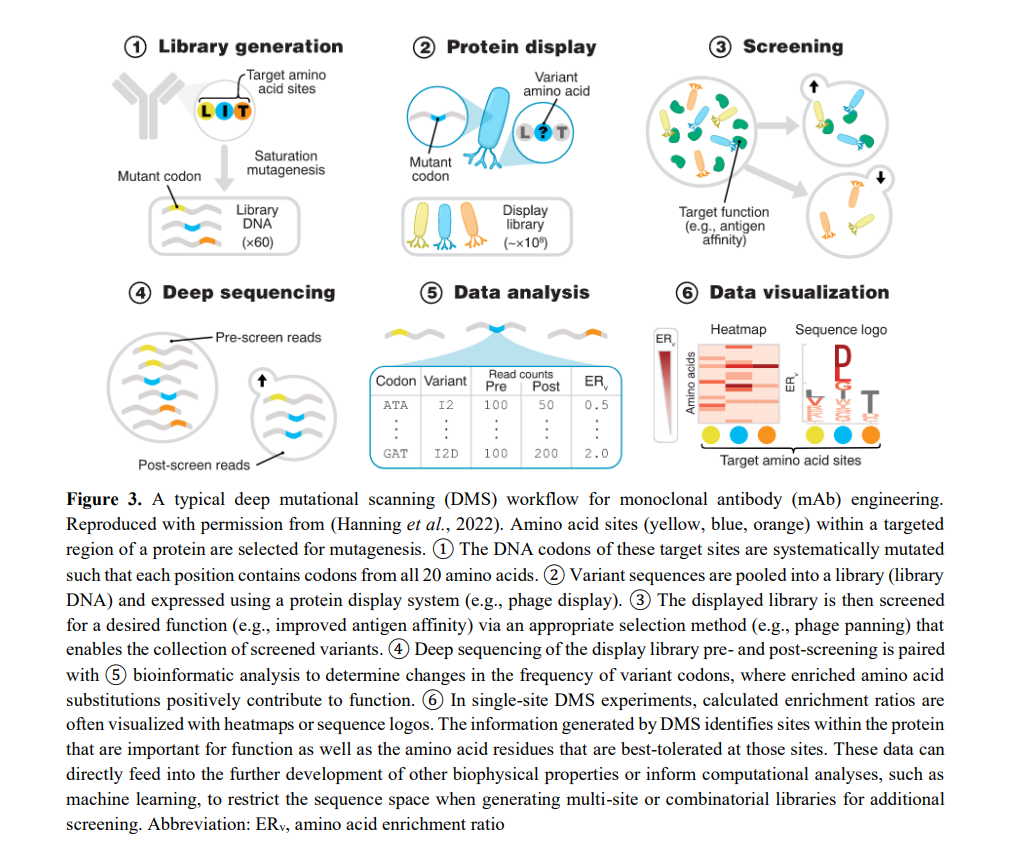

蛋白质工程领域旨在通过合成全新蛋白质或修改现有分子来开发和改进分子属性和功能,如化学活性和热稳定性。定向进化模仿自然进化,但在快速尺度上进行。蛋白质被修改并筛选出感兴趣的功能,最优秀的候选者被用作进一步迭代的起点,直到识别出最佳候选分子。近年来,AI技术在蛋白质工程和定向进化流程的开发上取得了迅速进展,然而,收集对于监督学习方法所必需的大型、高质量训练数据集既耗时又耗资源。为了帮助解决这些问题,以下论文开发了数据高效的机器学习引导的蛋白质工程方法,目标是改进开发并减少实验负担。 第一章描述了现代机器学习引导的蛋白质工程的相关领域和方法,以及工作的动机。本论文专注于不需要结构信息的蛋白质序列数据的机器学习,并简要概述了文献。论文认为,尽管监督学习方法已经相当成功,但大多数方法需要为手头任务精心设计的大型数据集,因此该领域可以从稳健的、数据高效的机器学习方法中受益。最后,详细介绍了本工作开发的方法,包括数据增强、元学习和语言模型。 第二章提出了一种用于蛋白质序列数据学习的数据增强方法。包括计算机视觉和自然语言处理(NLP)在内的传统机器学习领域定期利用数据增强来提高机器学习模型的鲁棒性和性能。然而,蛋白质序列数据缺乏在其他领域发现的易用和有效的数据增强技术,这可能是由于蛋白质的离散氨基酸序列与其结构和功能之间的关系。为此,开发了核苷酸增强,利用自然的核苷酸密码子简并性作为数据增强策略来合成增加训练集大小。为了详细探索这一概念,提出了几种算法和实现,并使用多个为机器学习引导的蛋白质工程建立的基准数据集(包括回归和分类任务)进行评估。提出了关于密码子简并性作为数据增强技术的额外问题,例如,是否有意义尊重在自然界中发现的密码子到氨基酸的关系,或者任意指定的标记扩展是否仍能提高模型性能。最终,发现核苷酸增强特别改善了在数据量少或类别不平衡严重时的困难学习任务的性能。 生物测定是嘈杂和耗时的。此外,将先前收集的数据集适应新任务可能昂贵或不可行。为了解决这个问题,第三章详细介绍了从嘈杂和标签不足的数据中学习的元学习框架的开发。为了证明该框架对蛋白质工程中各种场景的有用性和适用性,设计、生成并筛选了大型、多样化的酵母展示抗体库以绑定到目标抗原。然后将生成的数据集策划为蛋白质工程工作流程中相关的三个任务:从嘈杂数据中学习以减少实验要求、在没有真正阴性的情况下学习、以及预测分布外属性。选择了一个双层优化的元学习框架,其中内循环在大型、嘈杂或标签不足的数据上训练,外循环可以访问一个小型、干净、标签完善的数据集。外循环指导内循环的学习,忽略噪声、放大信号,并适应感兴趣的领域。通过广泛的实验和基准测试,研究了所开发框架的有效性和局限性。最后,由于工作的成功,讨论了框架的未来潜在应用。 第四章探索了如何通过蛋白质语言模型的转移学习和高效的多标签学习策略,帮助预测病毒从治疗性抗体中逃逸。通过蛋白质突变、表面展示和深度测序建立了SARS-CoV-2抗体逃逸的实验合成共进化系统。筛选了SARS-CoV-2受体结合域的变体库,以绑定和逃逸三十八种临床抗体和人类ACE2受体。尽管这一实验过程生成了大型和多样化的多标签数据集,但它在标签之间和标签内部都高度不平衡,使学习复杂化。为了解决这个问题,同时实施了两种策略:使用蛋白质语言模型的转移学习和使用变压器和掩蔽标签建模学习标签间关系。通过广泛的实验和基准测试,展示了该方法的有效性。此外,使用可解释AI技术来探测学习到的模式,并与生物学上有意义的趋势画上等号。 第五章对整个工作进行了讨论。详细讨论了本论文中提出的工作的贡献和意义,以及工作的不足。然后将这些贡献放在机器学习引导的蛋白质工程和一般机器学习的更广泛背景下。最后,讨论了未来的方向和应用。

![]()

![]()

![]()