多样本聚合策略(multi-sample aggregation strategies),如多数投票(majority voting)和 Best-of-N 采样,已被广泛应用于当代大型语言模型(Large Language Models,LLMs)中,以提升在各类任务中的预测准确性。在此过程中,一个关键挑战是温度参数的选择,该参数对模型性能有显著影响。现有方法通常依赖固定的默认温度,或需使用带标签的验证数据进行调参,而这类数据在实际中往往稀缺且难以获取。

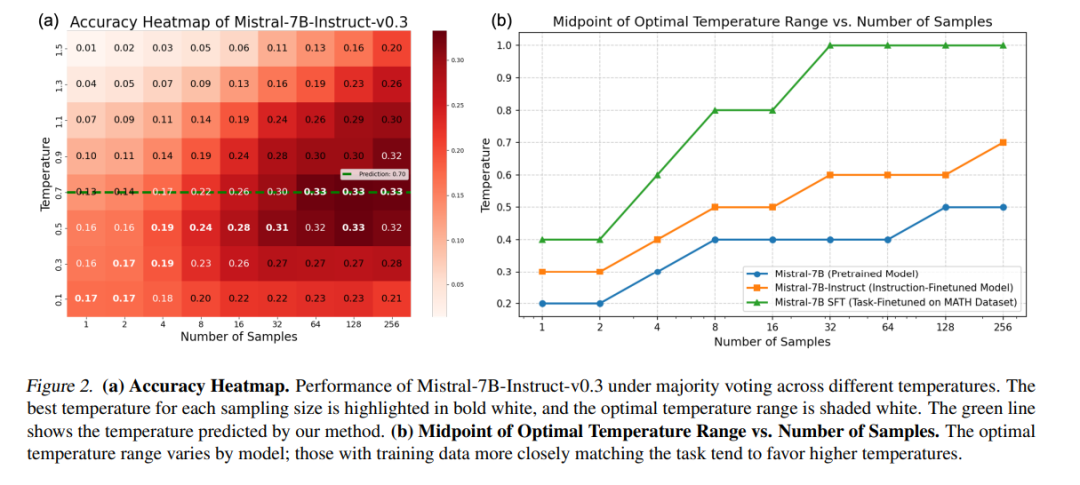

本文旨在解决在无需任务特定验证数据的前提下,使用多样本聚合策略为不同LLMs自动寻找(近)最优温度的问题。我们对温度在性能优化中的作用进行了系统分析,涵盖模型架构、数据集、任务类型、模型规模与预测准确性等多种变量。 此外,我们提出了一种基于熵的全新度量方法,用于自动优化温度参数,在多个实验中其表现持续优于固定温度的基线方法。我们还引入了一种随机过程建模方法,提升了温度调节过程的可解释性,帮助深入理解温度与模型性能之间的关系。

成为VIP会员查看完整内容

相关内容

Arxiv

205+阅读 · 2023年4月7日

Arxiv

17+阅读 · 2017年12月12日