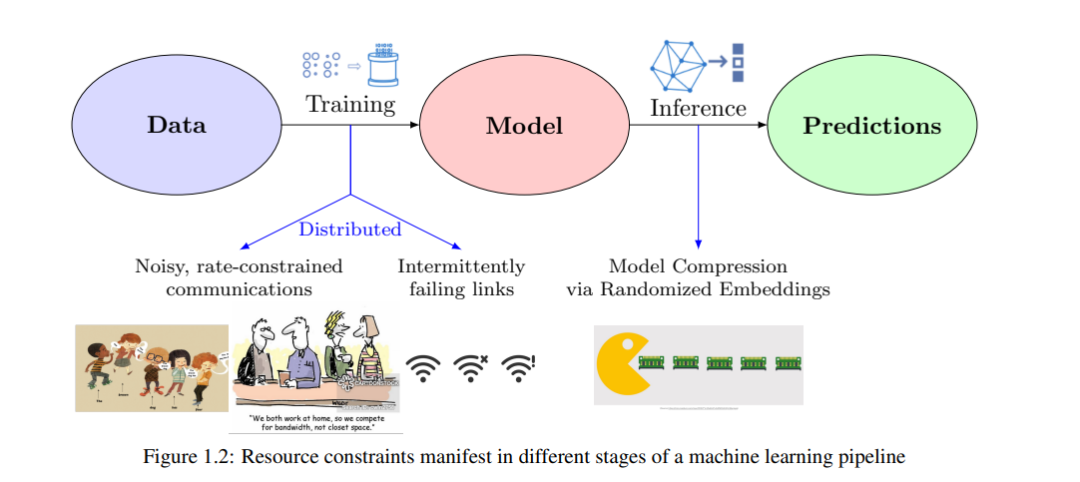

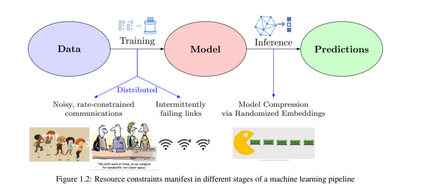

机器学习(ML)算法需要大量的计算、通信和内存资源,这在许多环境中很难提供。这样的资源受限环境包括智能手机和物联网(IoT)设备等边缘计算设备、无人机和卫星上的遥感设备以及健康监测可穿戴设备。这些系统所呈现的独特挑战需要能够在电力、内存和连接受限的情况下高效处理数据的解决方案。本论文通过集中研究两个关键领域来应对这些重大挑战:(i) 在边缘设备上,ML面临显著的计算限制;(ii) 由于通信能力受限,对ML模型进行分布式训练的障碍。

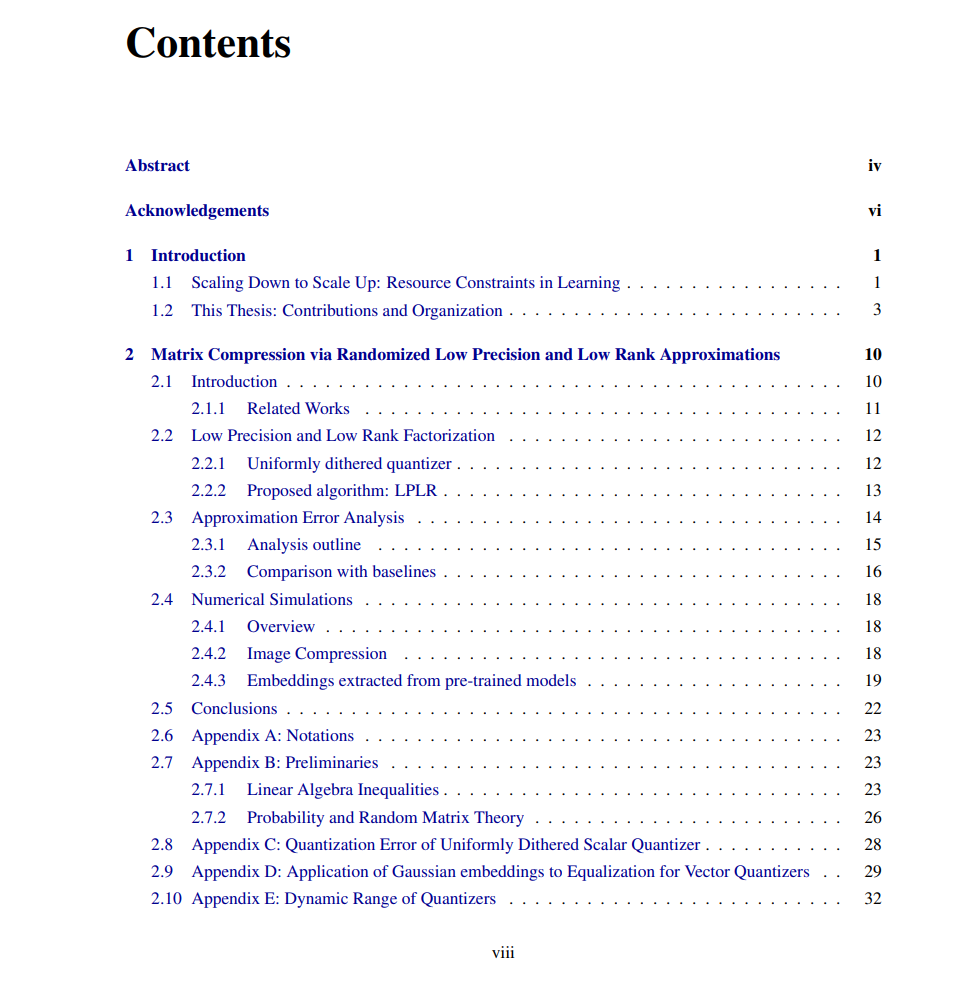

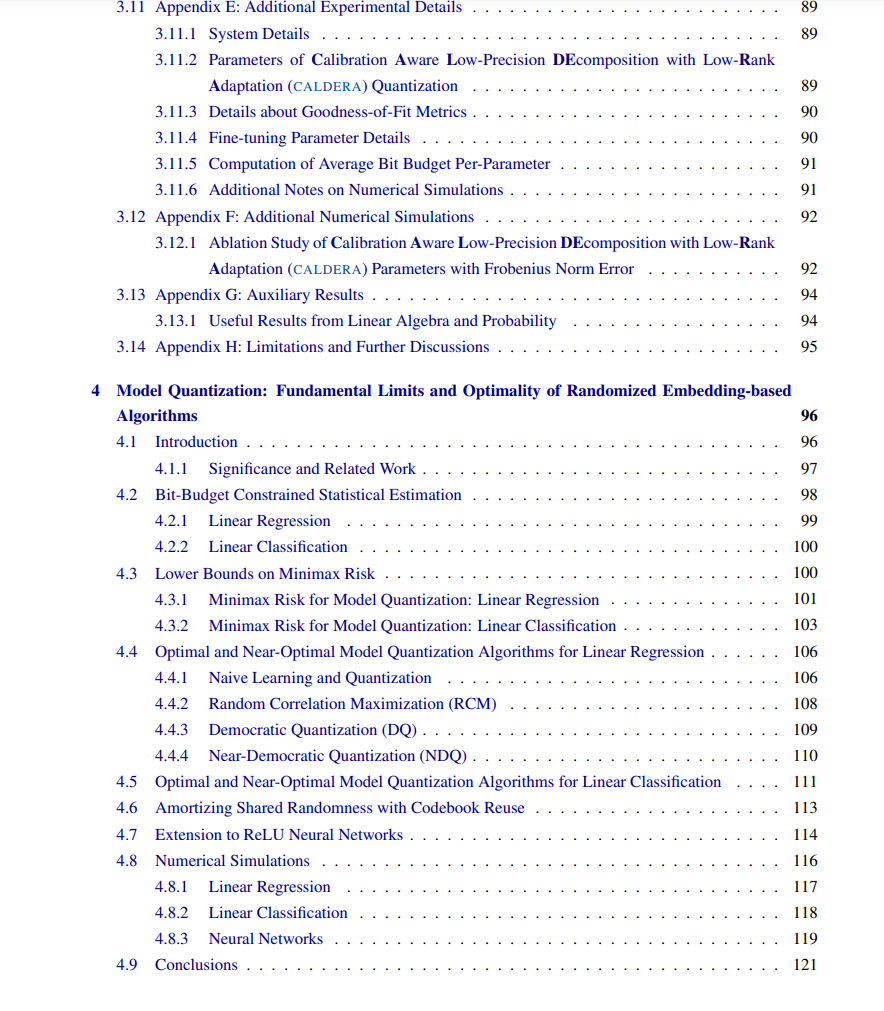

首先,本论文研究了低精度建模技术在边缘推理中的潜力,采用随机嵌入技术实现高效的模型压缩。利用随机嵌入技术大大降低了在处理能力和内存有限的边缘设备上部署高维模型的计算需求。所提出的算法旨在保持可接受的准确度水平,确保模型性能在计算复杂度降低的情况下不会下降。这对于在性能和效率之间实现谨慎平衡以实现实际部署至关重要。此外,确定了所提出算法的信息论最优性,并且证明了基于随机嵌入的算法在位预算约束下对统计估计任务是常数因子内的最小最大最优。通过详细的实验和理论分析,本论文展示了随机低精度技术如何为在资源受限环境中增强机器学习应用的可扩展性和可用性提供可行的解决方案。

其次,本论文探讨了在标志着间歇性连接的不可靠通信网络上进行分布式训练所面临的挑战。提出了协作中继作为解决方案,以提高数据传输的可靠性并确保数据隐私,尽管通信链路的性质不可预测。此外,为了应对额外的网络不可靠性来源,如代理之间的噪声和带宽有限的通信,本论文调整了流行的分布式训练算法,包括随机梯度下降和懒惰镜像下降。这些调整结合了功率控制和基于随机嵌入的梯度量化策略,以减轻不利影响。总体而言,这些策略有效地解决了在不可靠分布式环境中确保模型训练的稳健性和弹性的重要挑战,同时将开销降至最低。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日