机器学习模型最终用于在现实世界中做出决策,其中的错误可能代价极高。我们对神经网络及其训练过程的理解仍然出奇地少,结果是,我们的模型脆弱,经常依赖于虚假特征,在微小的分布变化下泛化能力差。此外,这些模型往往无法忠实地表示其预测中的不确定性,进一步限制了它们的适用性。在这篇论文中,我展示了关于神经网络损失表面、概率深度学习、不确定性估计以及对分布变化的鲁棒性的研究成果。在这些工作中,我们旨在构建对模型、训练程序及其局限性的基础理解,并利用这种理解来开发实际有影响力、可解释性强、鲁棒性好且广泛适用的方法和模型。

在过去几年中,我们见证了深度学习多个领域的显著进步。我们现在拥有可以超越人类水平下国际象棋的深度学习模型 [Silver et al. 2016],推进蛋白质折叠领域的神经网络 [Jumper et al. 2021],能根据文本描述创建逼真图像和视频的生成模型 [Ramesh et al. 2021; Saharia et al. 2022],以及展现出通用智能迹象的语言模型 [OpenAI 2023; Bubeck et al. 2023]。不可避免地,我们也看到越来越多的深度学习模型应用于现实世界,如自动驾驶汽车、用于自动诊断的医学成像模型,以及围绕语言模型构建的个人助理和其他系统。

然而,这些系统仍存在重大局限性,使得它们的广泛采用面临挑战。特别是,量化深度学习模型预测中的不确定性仍然具有挑战性 [Guo et al. 2017; Kadavath et al. 2022; Minderer et al. 2021]。结果是,我们往往很难知道何时可以信任这些模型,何时应该依赖人类专家。另一个主要问题是,神经网络经常依赖于捷径特征,并在测试数据分布与训练分布不同时泛化能力差 [Geirhos et al. 2018; Hendrycks and Dietterich 2019],这在大多数实际应用中都是如此。

到目前为止,我的大部分研究都是从高层次上理解深度学习。我相信,通过解构我们的模型和方法并理解各个部分,我们可以建立更好的直觉和机械性理解,了解它们是如何工作的。最终,这种理解通常会转化为更好的模型、方法和训练程序。在整篇论文中,我展示了几个这种类型的工作示例。

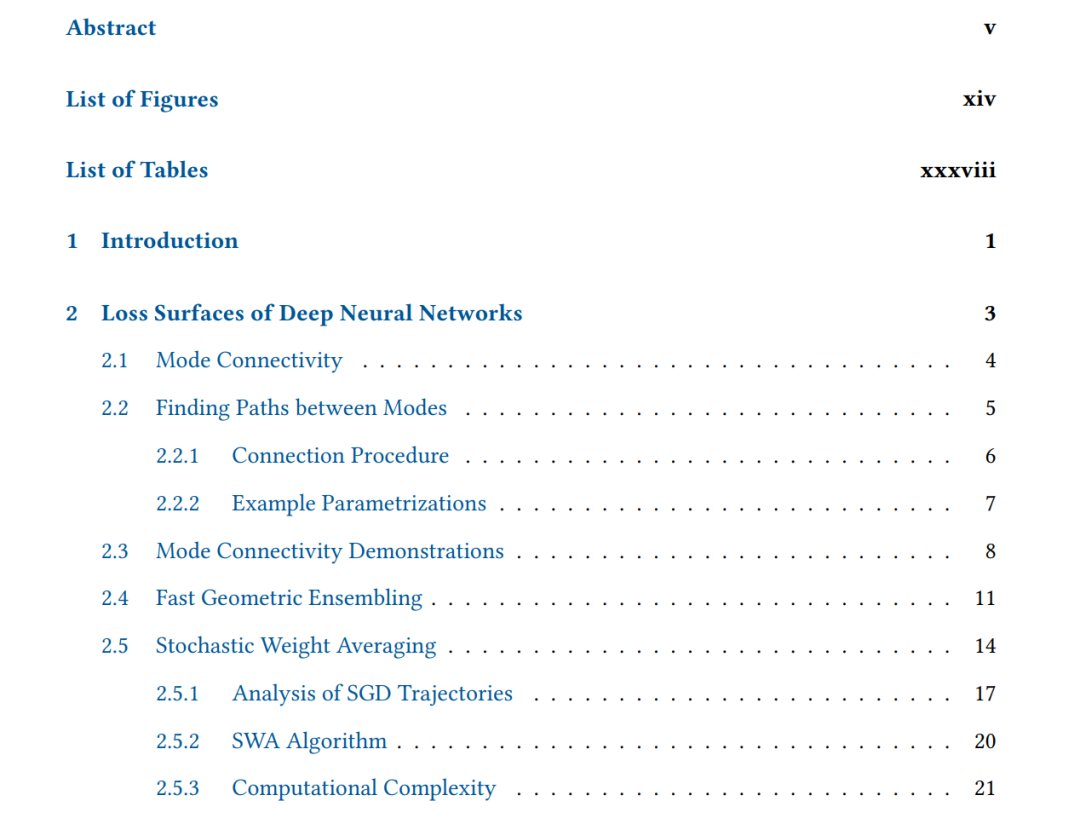

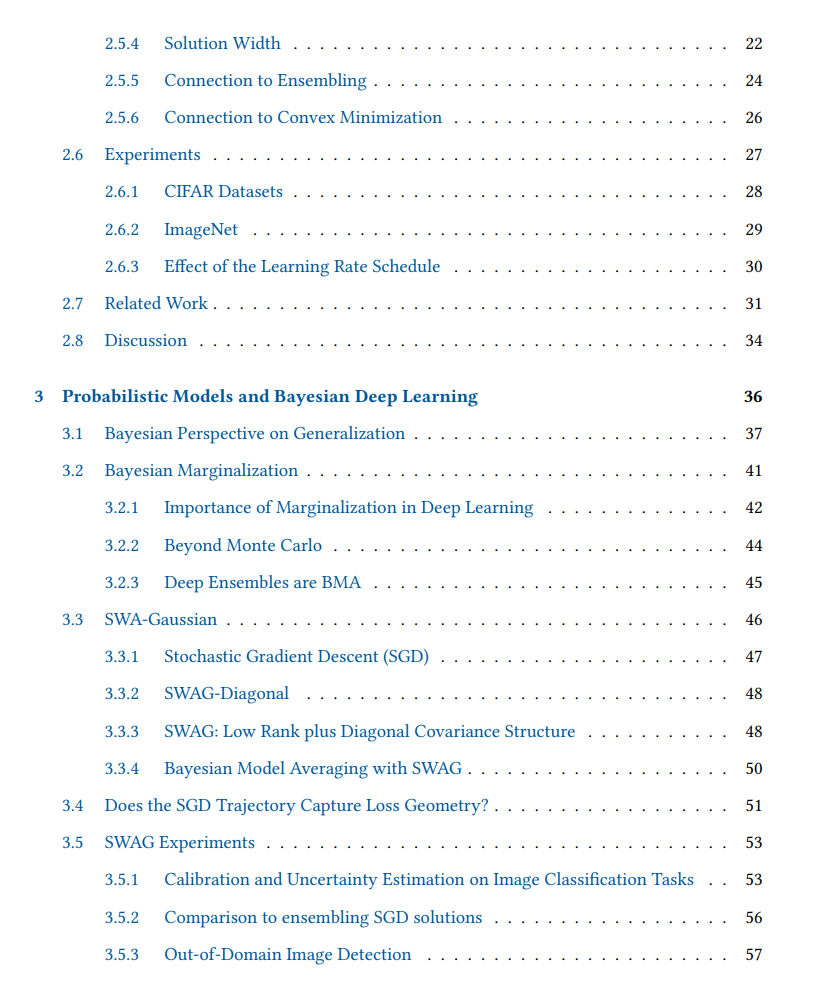

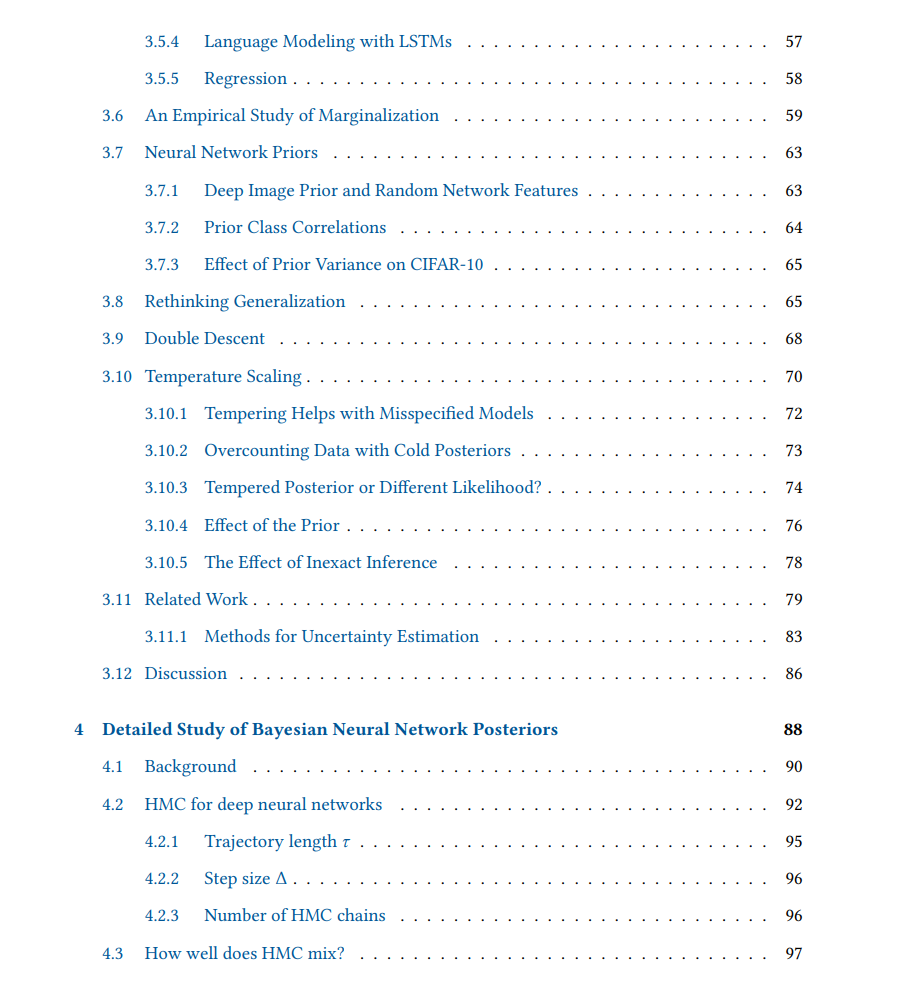

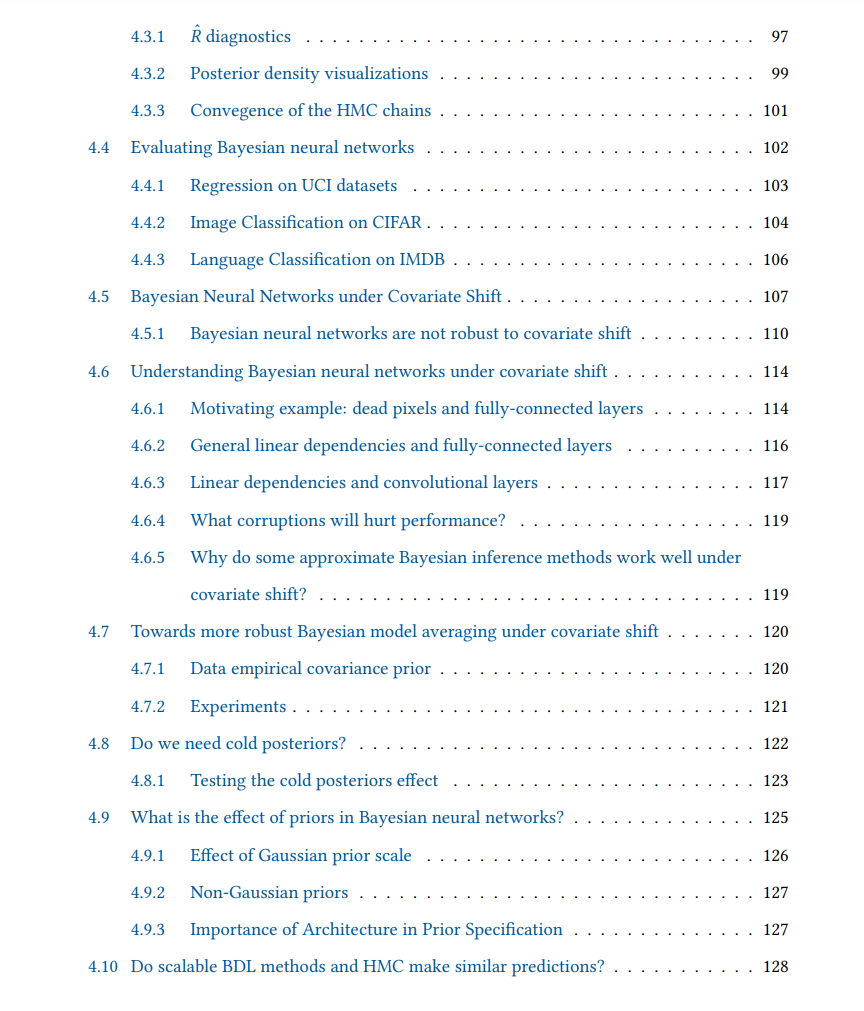

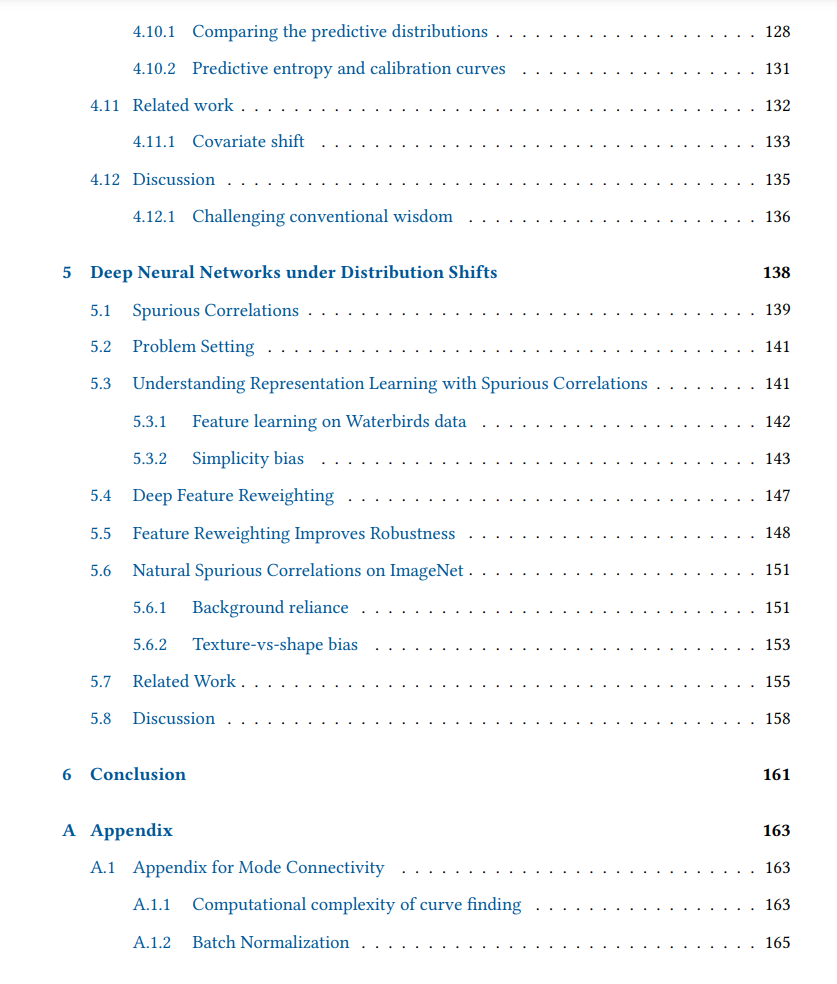

本论文的其余部分安排如下。在第2章中,我介绍了神经网络损失表面中最优解集合的结构。我还提出了基于对损失表面的观察而激发的深度神经网络改进训练和快速集成的实用方法。在第3章中,我展示了贝叶斯神经网络的广泛阐述以及对泛化的概率视角。我还提出了改进深度神经网络不确定性估计的实用方法。在第4章中,我报告了对贝叶斯神经网络后验分布的详细科学研究结果,提出了许多挑战传统智慧的惊人观察。特别是,我描述了导致贝叶斯神经网络在分布偏移下表现不佳的确切机制,并提出了部分解决方案。在第5章中,我描述了我们在存在捷径特征的情况下神经网络的特征学习工作,以及减少对这些特征依赖的方法。最后,在第6章中我总结了这篇论文。