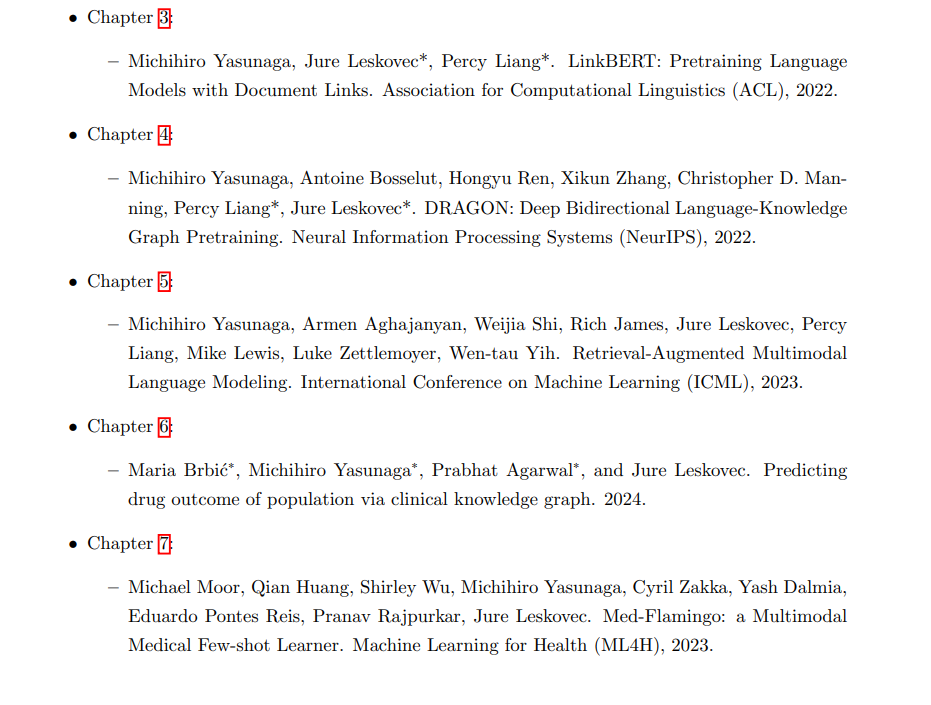

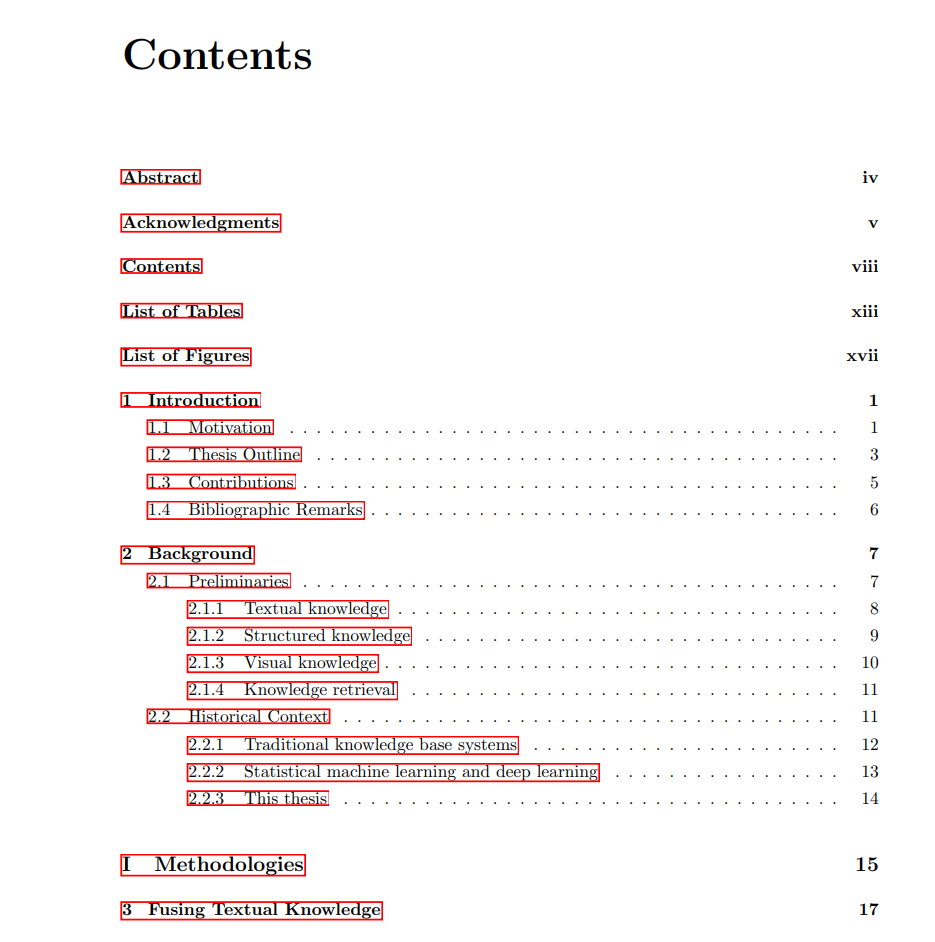

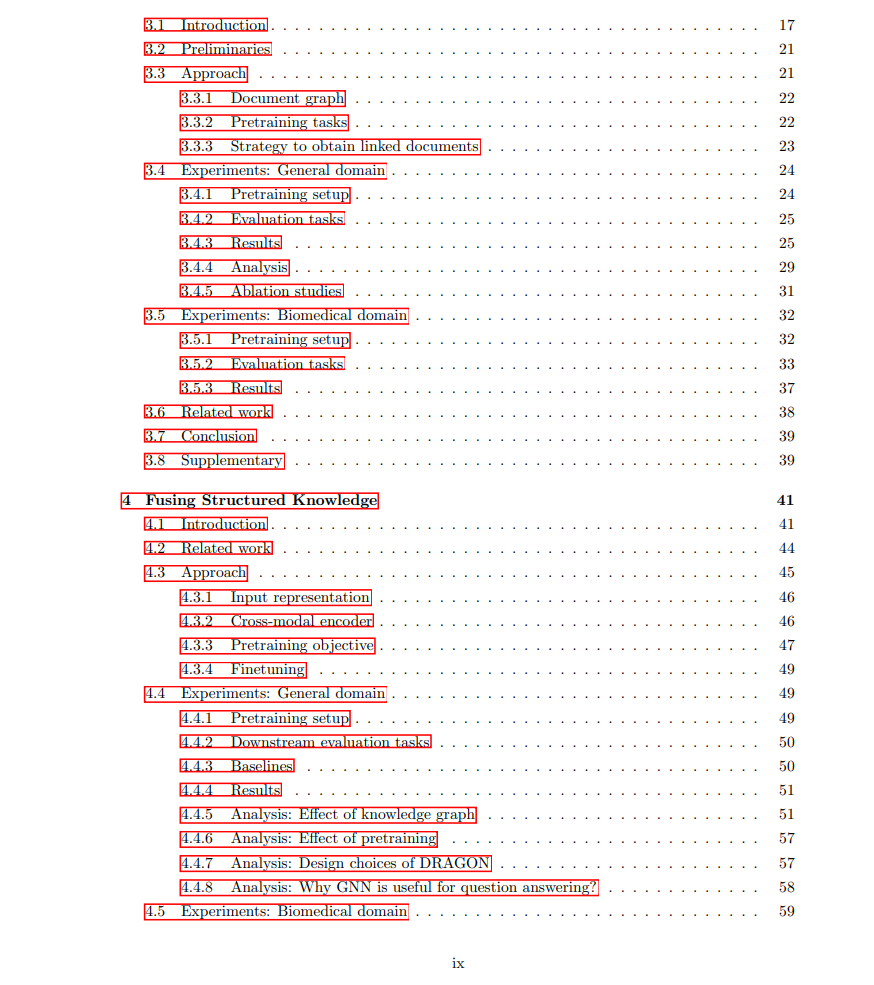

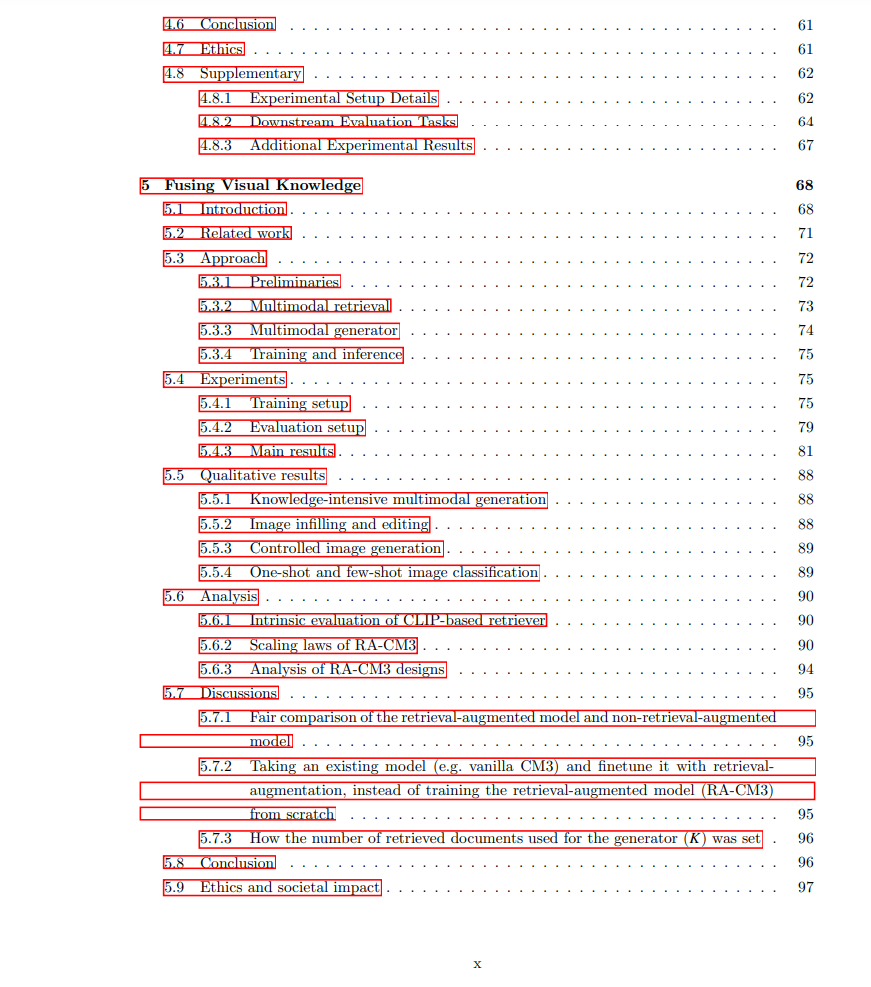

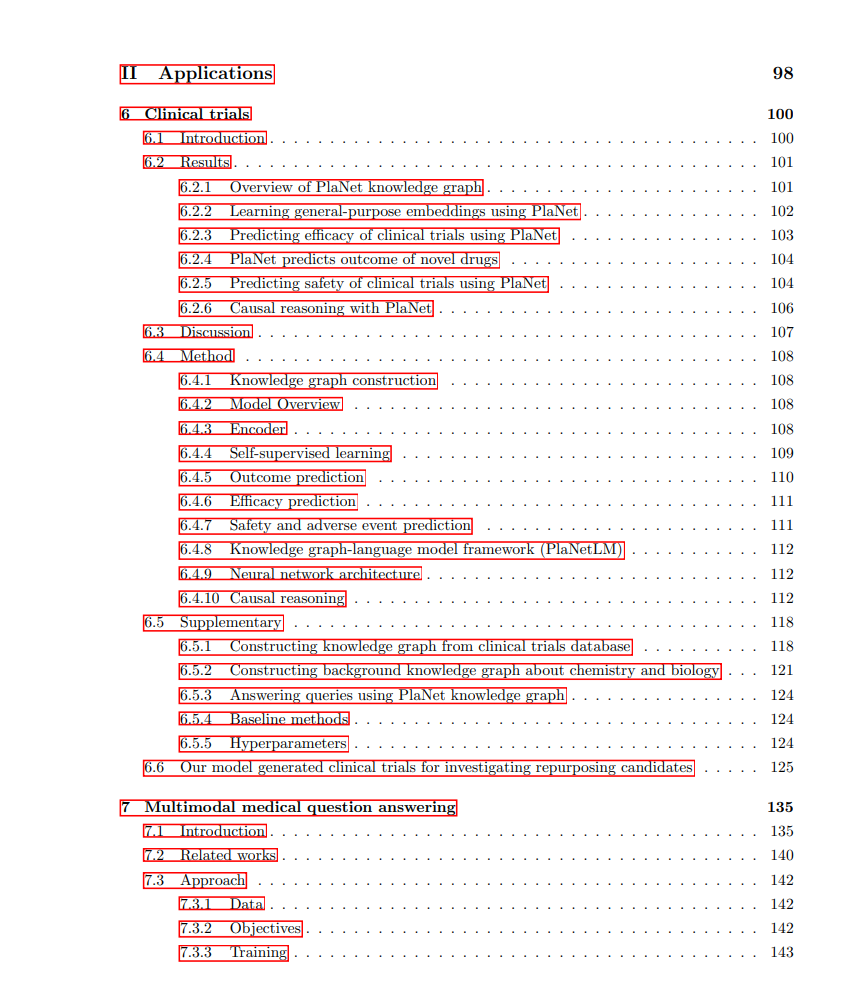

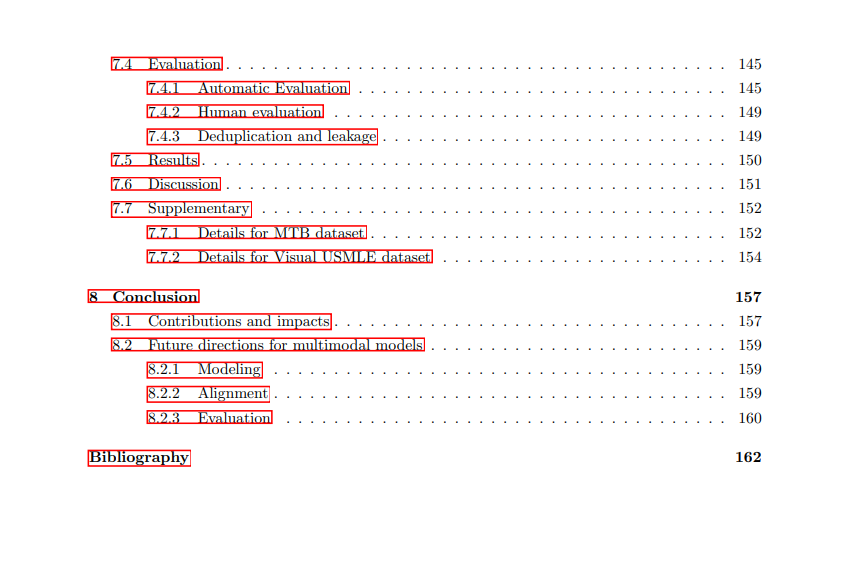

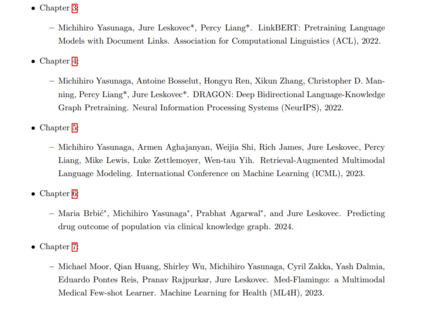

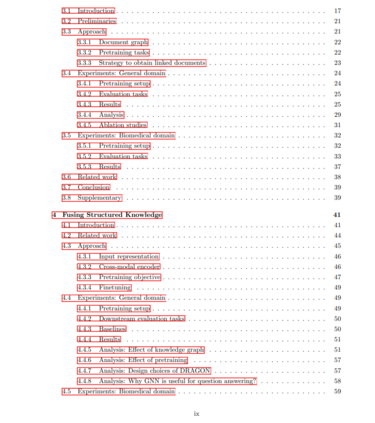

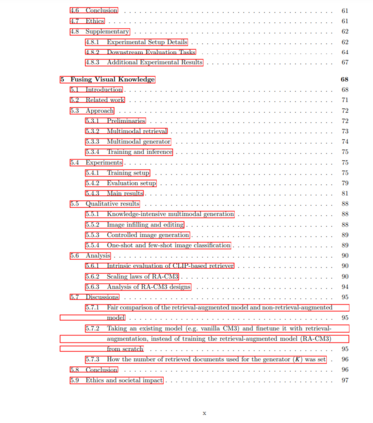

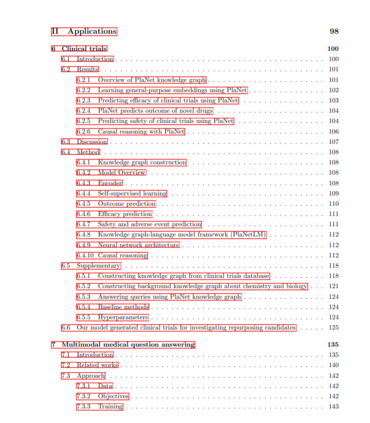

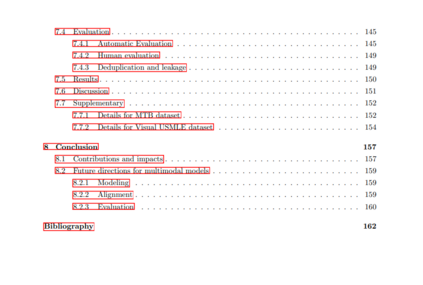

语言模型,如GPT-4,具有生成对用户查询的文本响应的能力。它们被用于各种任务,包括问答、翻译、摘要和个人助理等。然而,为了创建更多功能的人工智能助手,这些模型需要处理更多样化和复杂的任务,涉及领域或视觉知识,如回答医疗问题以及解释或生成图像。这种需求促使了开发能够访问并利用文本之外的多样化知识源的模型,如数据库和图像。在本论文中,我们旨在开发能够利用多模态知识的语言模型,包括文本、知识图谱和图像,以解决各种用户查询。文本提供广泛且富有语境的知识,知识图谱通常提供结构化的领域知识,而图像则促进各种视觉应用。本论文共有五章。第一章介绍语言模型如何有效地从文本数据中学习知识的方法。具体来说,我们在一系列相关文档上训练语言模型,鼓励它们学习和推理具有长期依赖性的知识。这种方法在复杂的长上下文和多步推理任务上表现出强大的性能。在第二章中,我们介绍了使语言模型能够利用知识图谱信息的方法。具体来说,我们开发了一种新的模型架构,结合了语言模型和图神经网络,以及一个融合文本和知识图谱表征的训练目标。这种方法在涉及领域知识的任务上表现出强大的性能,如医疗问题回答。在第三章中,为了使语言模型能够在文本信息旁使用和生成视觉内容,我们设计了能够编码、检索和解码文本和图像交织序列的统一多模态模型。该模型采用检索器来获取文本或视觉知识,并将其整合到一个多模态变换器中,该变换器使用标记表示同时编码和解码文本和图像。最后,在第四和第五章中,我们展示了将文本、结构化和视觉知识融合技术应用于解决实际医疗任务的情况,包括临床试验结果预测和多模态医疗问题回答。总之,本论文构建了能够理解和生成多模态内容的模型,涵盖了文本、知识图谱和图像。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日