本论文研究了训练深度神经网络中的基本挑战,重点探讨了信号在网络深度中的传播。论文考察了各种架构选择,如全连接层、权重初始化、归一化层和非线性激活函数,如何影响深度架构中的前向传播和反向传播。研究解决了诸如秩崩塌、梯度稳定性等关键问题,并探讨了它们对训练动态和网络性能的影响。

利用平均场理论、随机矩阵理论和马尔可夫链理论的工具,我们开发了一个用于分析深度网络中信号传播的数学框架。我们描述了导致秩崩塌和梯度不稳定的条件,并提供了归一化技术和初始化方案有效性的理论见解,提出了改善非常深层网络中信号传播和训练动态的途径。从根本上说,本论文的发现是朝着理解现代神经网络架构成功背后的数学原理迈出的重要一步。

深度神经网络已经彻底改变了人工智能领域,在广泛的任务中取得了前所未有的表现,从图像识别 [KSH12] 到自然语言处理 [Dev+18]。尽管这些模型取得了显著的成功,它们通常仍然是神秘的,作为“黑箱”通过一系列复杂的非线性操作将输入转换为输出 [AB16]。这种缺乏理论理解给研究人员和实践者带来了重大挑战,因为它妨碍了我们更好地理解和优化这些系统。

深度学习范式的核心是信号传播——信息在神经网络的层次中流动的过程,涵盖前向和反向传播 [GB10a]。理解这一过程至关重要,原因有几个。它提供了神经网络如何处理和转化信息的见解,可能揭示其过程背后的基本原理。对信号传播的更深入理解可以指导更好的网络初始化设计 [GB10a]、更有效的网络架构设计 [He+16a] 以及更高效的优化算法 [KB14]。总的来说,理论理解有助于在更有原则的方式下设计神经网络架构。

当考虑到训练深度神经网络的挑战时,信号传播的重要性变得尤为突出。随着网络深度的增加,它们具备了更强的表达能力和学习更复杂表示的潜力 [BSF94]。然而,这种增加的深度也带来了稳定训练的重大障碍,许多障碍直接与信号在网络中的传播方式有关 [GB10a;He+15]。本论文旨在弥补我们理解中的一些空白。

1.1 研究目标与范围

本论文的主要目标是通过对各种神经网络组件对信号传播深度的影响进行深入研究,揭示神经网络的某些行为。具体来说,我们旨在解决以下核心研究问题:

信号如何在深度神经网络的层次中传播,前向和反向传播是如何演变的?

为了全面探讨这个问题,我们重点关注神经网络设计的几个关键方面:全连接层、权重初始化、归一化技术和非线性激活函数。全连接层作为神经网络的基本构建块,为我们的分析提供了起点 [SMG13a]。初始权重的选择可以显著影响网络的训练动态,我们研究了各种初始化策略及其对信号传播的影响 [SMG13a;GB10a;He+15]。其次,Batch Normalization (BN) [IS15] 和 Layer Normalization (LN) [BKH16] 等归一化层在使得非常深的网络能够训练方面发挥了关键作用,我们分析了这些技术如何影响信号流动和稳定性。第三,非线性激活函数的选择显著影响网络的表示能力和训练动态,因此我们考察了ReLU [NH10] 和双曲正切等流行选择,探索它们对信号传播的影响 [GBB11;MHN13;CUH15;He+15;RZL17]。

从数学角度来看,我们的分析重点关注神经网络中的两个关键操作:矩阵乘积和逐元素激活。矩阵乘积发生在线性层中,转换层之间的表示,并影响信号如何在网络中传播 [SMG13a]。非线性激活函数将关键的非线性引入网络,我们研究了不同激活函数如何塑造激活和梯度的分布 [Kla+17;PSG17;PSG18]。虽然像BN和LN这样的归一化层是非线性操作,但它们并不按元素操作。有些出乎意料的是,我们发现我们可以将它们作为一种特殊的矩阵乘积进行研究,其中一个矩阵是对角矩阵,与特征或批处理空间中激活的标准差成比例 [Dan+20;DJB21]。

我们的分析主要集中在网络初始化状态,因为这个初始状态在确定随后的优化轨迹和网络最终表现中起着至关重要的作用 [SMG13a;Xia+18;FC18;PSG17]。这使我们能够利用随机矩阵理论和马尔可夫链理论的工具,分析层表示如何以随机方式演变。

1.2 训练深度神经网络中的挑战

随着神经网络变得越来越深,在各种任务中取得了最先进的表现 [He+16a;Dev+18],训练这些架构时出现了两个主要挑战 [PMB13]。在反向传播中,梯度消失和梯度爆炸问题变得尤为重要 [BSF94;PMB13;Han18]。在前向传播中,表现崩溃的问题出现了,即随着深度的增加,不同输入样本映射到越来越相似的表示 [Dan+20;Noc+22b]。表现崩溃和梯度不稳定都显著影响了训练动态和网络性能 [Han18]。

**1.2.1 梯度爆炸与梯度消失

梯度爆炸与梯度消失问题长期以来是训练深度神经网络的挑战 [Hoc91;BSF94]。这些问题在反向传播算法的过程中出现,可能会严重妨碍学习过程。

梯度爆炸发生在梯度在通过网络层反向传播时增长过快,可能导致数值不稳定,使得训练过程发散 [PMB13]。相反,梯度消失发生在梯度变得指数级变小,实际上阻止网络学习长距离依赖 [Hoc98]。

梯度消失问题尤其对网络的第一层或最后一层影响严重。第一层的梯度消失会导致网络无法从输入数据中捕捉到重要的特征,从而丧失网络开始阶段的关键信息 [GB10a]。当最后一层出现梯度消失时,网络会难以将误差信号反向传播到早期层,导致整个网络的微调效果不佳 [He+15]。此外,梯度消失还可能导致深度网络表现得像一个较浅的网络,从而消除深度架构在学习层次化表示方面的潜在优势 [SGS15]。

梯度消失与爆炸问题与深度、权重初始化和激活函数密切相关 [GB10a;He+15]。从数学角度来看,梯度可以表示为一个扩展的矩阵乘积链,这是微积分链式法则的结果。主要挑战在于,随着乘积链的增长,如何保持稳定的梯度流 [SMG13a;PMB13]。

**1.2.2 秩崩塌

秩崩塌指的是随着深度的增加,深度神经网络的输出变得越来越相关,导致表达能力的丧失 [Dan+20]。这个问题在具有标准初始化方案的网络中尤其突出,可能会严重阻碍网络学习复杂表示的能力 [Dan+20]。

最近的研究表明,秩崩塌不仅限于全连接网络,还影响其他架构,如卷积神经网络 [Xia+18] 和变换器 [DCL21;Noc+22b]。解决秩崩塌问题对于使得非常深的网络能够训练并充分发挥其表示能力至关重要。

秩崩塌与梯度消失密切相关,都是由于信号传播问题引起的 [Dan+20;Han18]。从非正式角度看,这两个问题都可以看作是网络在传播过程中“丧失”信息。

**1.2.3 对训练动态的影响

秩崩塌和梯度不稳定现象对训练动态和深度神经网络的整体表现有重大影响。这些挑战通过多种相互关联的方式表现出来,显著影响了学习过程的效率和效果。

网络在遭遇秩崩塌或梯度问题时,通常需要更多的训练迭代才能达到类似的性能 [IS15;San+18;Dan+20;DJB21]。这个增加的训练时间可能成为大型模型和数据集的瓶颈。

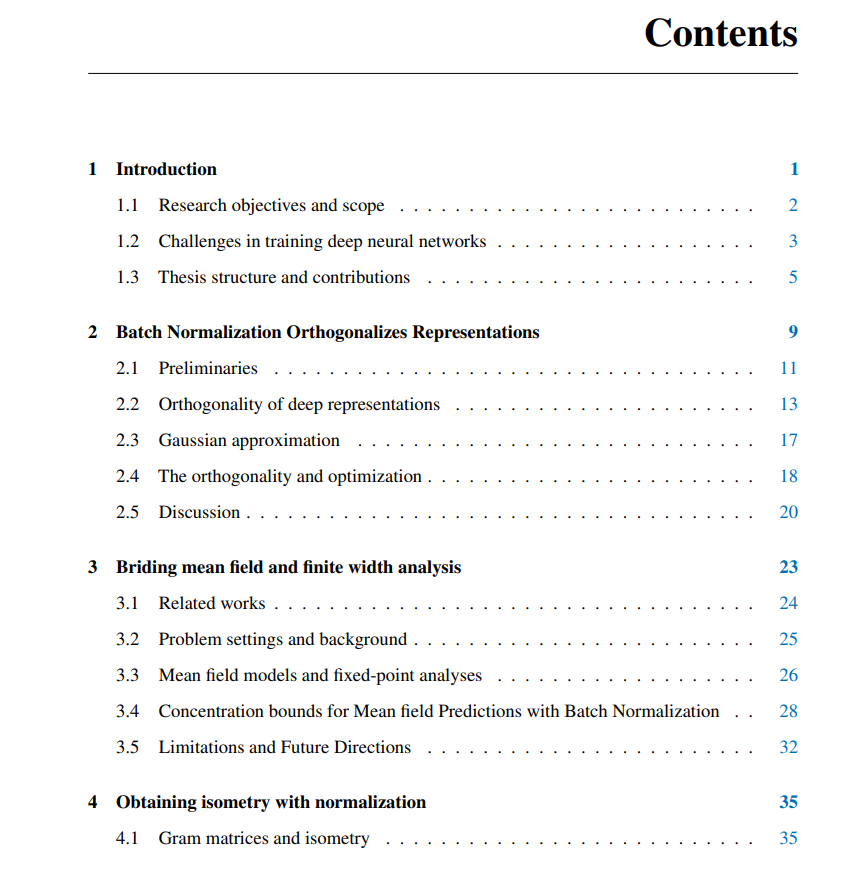

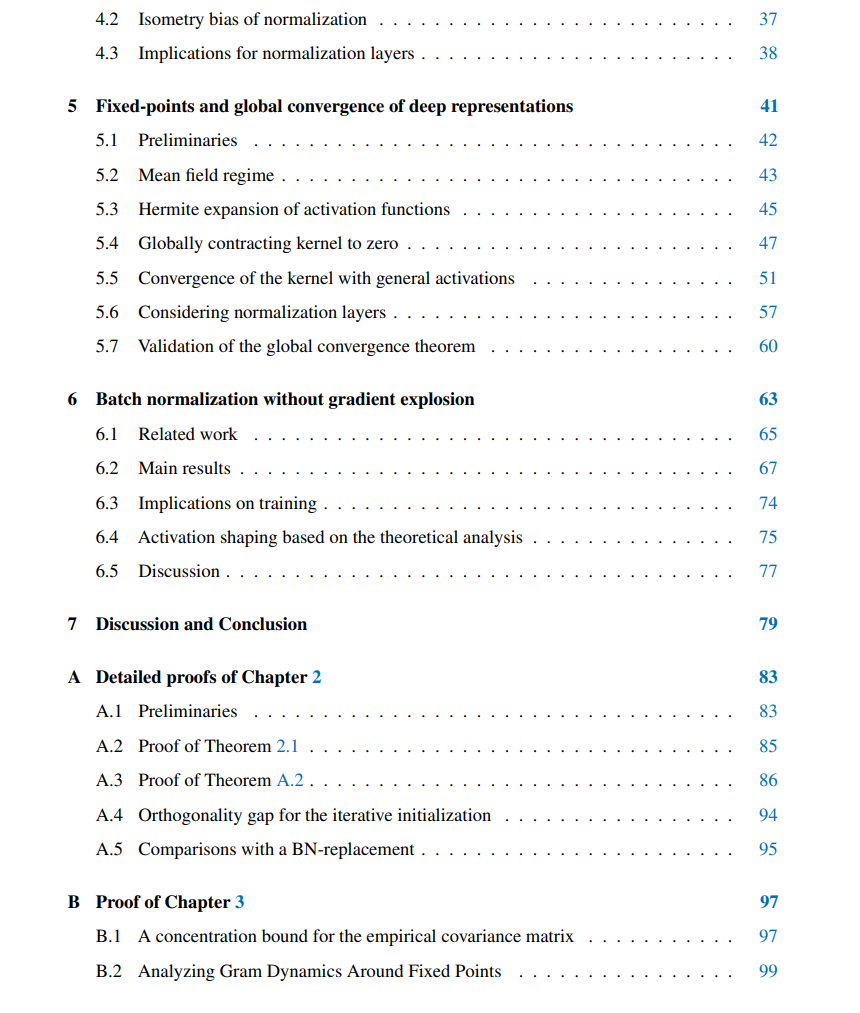

1.3 论文结构与贡献

本论文探讨了训练深度神经网络中的挑战,并提出了应对这些问题的新方法。各章节按写作和发布的时间顺序排列,具体章节如下:

第2章:批量归一化正交化表示。

第3章:弥合平均场与有限宽度差距。

第4章与第5章:讨论归一化与激活函数如何导致深度神经网络中表示的等距性。

第6章:没有梯度爆炸的批量归一化。

第7章:总结与未来方向。

每章都有助于加深我们对深度神经网络训练动态的理解,并为解决这些模型的深度挑战提供了新的技术。

**

**