摘要

全球各地的军队都在开发越来越多的自主机器人武器,打造完全自主武器的未来前景,它可以自行搜索、选择和攻击目标。迄今为止,自主武器只有很少的应用,如在人类监督下保卫舰船和车辆。通过研究全球各地正在使用或正在开发的50多个自主军事和网络系统的案例,本论文得出结论,完全自主武器的广泛使用将是战争中的一个新发展。自主武器为危机稳定、升级控制和战争终止提出了重要的考虑因素,而这些考虑因素迄今为止基本上没有得到充分的探讨。

完全自主武器可以以多种方式影响稳定。自主武器可以通过以自动化取代人类决策,将策略领导人与战术行动更直接地联系起来,从而提高稳定性。然而,自主武器的事故可能导致相反的结果,造成意外的致命交战,使危机升级或使终止冲突更加困难。我们探讨了完全自主的武器可能影响稳定的九种机制,其中四种会加强稳定,五种会破坏稳定。对这些机制的重要性进行了评估,其中最突出的因素是自主武器增加或减少人类控制的程度。如果自主武器有可能在现实的军事行动环境中与人类的意图一致,那么广泛的自主武器将通过增加政治领导人对其军队的控制和减少事故或未经授权的升级行动的风险来改善危机稳定性、升级控制和战争终止。然而,如果在现实环境中,自主武器可能采取意料之外的行动,那么它们的使用将破坏危机稳定性、升级控制和战争终止,因为有可能出现意外的致命交战,使冲突升级或使战争更难结束。

正常事故理论和高可靠性组织的竞争框架对复杂系统发生事故的可能性做出了不同的预测。

超过25个真实环境中的军事和非军事复杂系统的案例研究被用来测试这些相互竞争的理论。其中包括美国在海军 "宙斯盾 "和陆军 "爱国者 "空中和导弹防御系统方面的广泛经验以及它们的相关安全记录。

军事和民用自主系统的经验表明,存在三个关键条件,它们将破坏战时完全自主武器的可靠性:(1)缺乏现实条件下的日常经验,因为测试和和平时期的环境不会完全复制战时条件;(2)存在敌对行为者;以及(3)缺乏人类判断来灵活地应对新情况。论文的结论是,正常事故理论最好地描述了完全自主武器的情况,军队极不可能用完全自主武器实现高可靠性的行动。意料之外的致命行动可能是使用完全自主武器的正常后果,军队可以减少但不能完全消除这些风险。

人工智能和机器学习方面最近和未来的潜在进展可能会加剧这些风险,即使它们使更多的系统具备能力。这源于准确预测机器学习系统在复杂环境中的行为所面临的挑战,它们在应对新情况时表现不佳,以及它们对各种形式的欺骗和操纵的脆弱性。

因此,完全自主武器的广泛部署可能会破坏稳定,因为有可能出现意外的致命交战。探讨了四种政策和监管方案来减轻这种风险。根据对40多个试图控制武器的历史案例和自主武器的具体特征的分析,评估了它们成功的可能性。论文最后提出了三种可能可行的监管方法,以减轻完全自主武器的风险。

概述和主要研究问题

简介

决策

技术已经把我们带到了人类与战争关系的一个关键门槛的边缘。在未来的战争中,机器可以自行做出生死攸关的交战决定。全球的军队正在竞相在空中、地面和海上部署机器人。它们的自主性越来越强,很多都有武器。超过90个国家有无人机在天空中巡逻。目前,无人机在人类的控制下运行,但当捕食者无人机拥有像自动驾驶汽车一样的自主权时,会发生什么?当事关最终决定--生命和死亡--时,军队应该愿意把什么权力下放给机器?

超过30个国家已经拥有防御性自主武器,用于应对交战速度过快、人类无法应对的情况。它们被用来保护船只和基地免受火箭和导弹的饱和攻击。这些系统由人类监督,在必要时可以进行干预,但更多的自主权正在悄悄进入各种武器。其中一种武器,以色列的哈比无人机,已经跨越了完全自主武器的界限。与由人类控制的 "捕食者 "无人机不同,"哈比"无人机可以在大范围内搜索敌方雷达,一旦发现敌方雷达,就可以不经允许对其进行神风特攻。它已经被卖给了少数几个国家--土耳其、中国、印度和韩国--而且中国已经反向设计了他们自己的变体。更广泛的扩散是一种肯定的可能性,而哈比可能只是一个开始。

全球各地的军队正在部署具有越来越多自主权的武装机器人。韩国已经在与朝鲜接壤的非军事区部署了机器人哨兵枪。以色列已经使用武装地面机器人在其加沙边界巡逻。俄罗斯正在为欧洲平原上的战争建造一套武装地面机器人。超过20个国家已经或正在获取武装无人机。

这些发展是席卷人类社会的更深层次的技术趋势的一个方面:人工智能(AI)的崛起。一些人称人工智能是 "下一次工业革命"。 技术大师凯文-凯利将人工智能比作电力。正如电力注入我们周围的物体,给它们带来生命力一样,人工智能也将注入日常物品,给它们带来智能。在物理系统中,人工智能使更复杂和自主的机器人,从仓库机器人到下一代无人机。在非物理系统中,人工智能可以帮助处理大量的数据,并为各种任务做出决定,进行医疗诊断,编制地铁维修时间表,并为Twitter机器人提供动力。在战争中,人工智能系统可以用来处理信息,以帮助人类做出决定--或者可以将权力下放,让它们自己做出决定。

人工智能的崛起将改变战争。二十世纪初,军队利用工业革命将坦克、飞机和机枪带入战争,以前所未有的规模释放出破坏力。工业革命使人们能够创造出身体上比人类更强壮、更快速的机器,至少对于量身定做的任务而言。同样地,人工智能革命使人们能够创造出比人类更聪明、认知能力更强的机器来完成狭窄的任务。人工智能的许多军事应用是没有争议的--改善后勤、网络防御、协助人类的决策辅助工具,或用于医疗疏散、补给或监视的机器人。然而,将人工智能注入到武器中会引发一些棘手的问题。虽然今天自动化已经被用于武器的各种功能,但在大多数情况下,仍然是人类在选择目标和扣动扳机。这种情况是否会继续下去还不清楚。大多数国家对他们的计划保持沉默,但有几个国家已经表明他们打算在自主性方面不作保留。俄罗斯高级军事指挥官表示,他们设想在不久的将来,"将创建一个完全机器人化的单位,能够独立开展军事行动。"美国国防部官员表示,完全自主的武器应该是 "摆在桌面上的"。

比人类更好?

武装的机器人自己决定杀谁,这听起来像是一个乌托邦式的科幻噩梦,但有些人认为,自主武器可能使战争更加人性化。可以让自动驾驶汽车避开行人的那种自动化,也可以用来避免战争中的平民伤亡。与人类士兵不同,机器永远不会生气或寻求报复。他们永远不会疲劳或疲倦。飞机上的自动驾驶仪已经极大地提高了商业客机的安全性,拯救了无数人的生命。自主性能否为战争带来同样的效果?无数曾经被认为对机器来说不可能完成的任务现在都被机器超越人类技能的看似无止境的步伐所取代:国际象棋、危险游戏、围棋、飞行、驾驶和股票交易。下一个是战争吗?

新的人工智能技术,如深度学习神经网络,在视觉物体识别、面部识别和感知人类情感方面显示出惊人的进步。不难想象,未来的传感器可以在区分手持步枪的人和手持耙子的人方面胜过人类。然而,在理解上下文和解释意义方面,计算机仍然远远落后于人类。今天的人工智能程序可以识别图像中的物体,但它们无法将这些物体放入更广泛的背景中,以了解正在发生的事情。

战争中的一些决定是简单明了的。有时,敌人很容易被识别出来,枪声也很干净。然而,有些决定,如斯坦尼斯拉夫-彼得罗夫面临的决定,需要了解更广泛的背景。有时做正确的事情需要打破规则。

辩论

完全自主的武器可以自行做出生死决定,这一前景引发了一场激烈的辩论,一些人呼吁先发制人地禁止自主武器。3000多名机器人和人工智能专家呼吁禁止进攻性自主武器。他们与60多个非政府组织一起参加了 "阻止杀手机器人运动"。霍金、埃隆-马斯克和苹果公司联合创始人史蒂夫-沃兹尼亚克等科技界名人都公开反对自主武器,警告它们可能引发 "全球人工智能军备竞赛"。 "红十字国际委员会也同样表达了对自主武器的担忧,尽管他们还没有呼吁禁止,而联合国法外处决问题特别报告员则呼吁暂停自主武器的开发。各国正在讨论如何处理自主武器的问题。自2014年以来,作为联合国(UN)《特定常规武器公约》(CCW)的一部分,各国每年都在瑞士日内瓦聚会,讨论致命的自主武器。

迄今为止,关于自主武器的大部分讨论都集中在法律、道德和伦理问题上,但自主武器也引起了对稳定的重要关注。自主武器将人类从对特定目标使用武力的决定中 "抽离 "出来,从而消除了对战场上的意外或意外行动的潜在的有价值的故障保护。自主武器是否会导致一种 "脆弱的稳定 "状况,即危机可能迅速升级而失去控制?自动化的股票交易已经导致了华尔街的 "闪电崩盘"。自主武器在战场上的互动会不会导致 "闪电战",即具有灾难性后果的意外事故?

今天的 "狭义 "人工智能系统是很脆弱的。它们在狭窄的任务中往往可以超过人类的表现,如驾驶,但当被推到超出其编程的界限时,它们会失败,而且是严重的失败。目前狭窄的人工智能系统缺乏人类通用智能的灵活性,无法适应新的环境。未来更先进的人工智能系统能否像斯坦尼斯拉夫-彼得罗夫那样聪明地理解更广泛的环境,克服这些限制?如果是这样,具有类似人类智能的更先进的人工智能系统会带来哪些新的挑战?

最后,如果自主武器确实引起了对稳定的担忧,各国可以采取什么措施来解决这些问题,单边的和集体的?人类在控制危险技术方面的记录好坏参半。禁止被认为是非法的武器的尝试可以追溯到古代。其中许多尝试都失败了,包括20世纪初禁止潜水艇和飞机的尝试。即使那些成功的尝试,如禁止化学武器,也很少能阻止巴沙尔-阿萨德的叙利亚或萨达姆-侯赛因的伊拉克等流氓政权。然而,在冷战期间,美国和苏联合作避免了被视为破坏稳定的武器或部署态势,如反弹道导弹武器、具有中程核能力的导弹,或在太空或海床放置核武器。

可以自行做出生死决定的自主武器会引起困难的法律或伦理问题,但也会引起对可控性和风险的实际安全关切。超越人类控制的自主武器可能对危机稳定、升级管理和战争终止产生严重后果。一场 "闪电战 "对任何人都没有好处。稳定性是一个重要的考虑因素,应该成为关于自主武器后果的对话的一部分。

主题概述

全球各国都在部署自主性越来越强的军用机器人。许多非机器人系统的自动化和自主性也在增加,包括弹药、空中和导弹防御以及网络系统。这些发展引发了越来越多关于自主武器和人类控制在使用武力中的适当作用的文献。然而,目前的文献存在两个重大缺陷。首先,尽管有越来越多的关于自主武器的学术文献,但大部分文献都是由倡导禁止 "杀手机器人 "的活动家提出的。第二,许多关于自主武器的文献都是从法律、伦理或道德的角度来探讨这个话题。虽然这些是重要的考虑因素,但自主武器也引起了对稳定的重要关注。将武力的使用授权给一个自主系统可能会给稳定带来新的挑战,包括危机中的升级管理和战争终止。

这篇论文研究了自主武器对稳定的影响。核心的研究问题是:

- “自主武器是否对稳定构成挑战,如果是的话,各国可以采取哪些可行的风险缓解措施?”

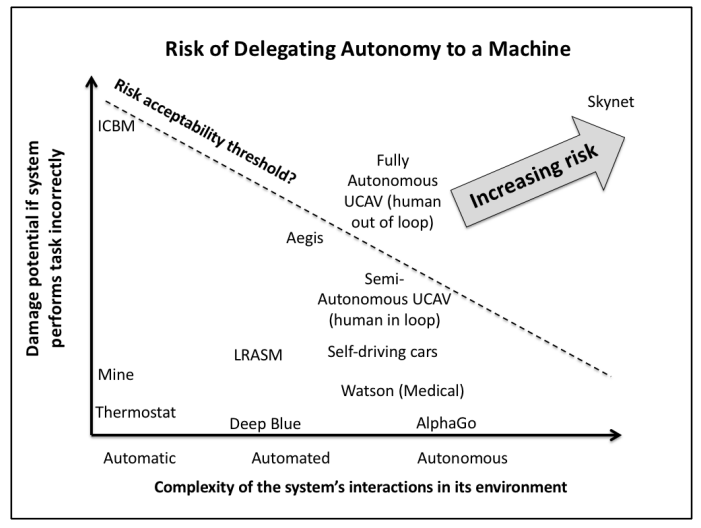

这个问题的第一部分将通过探索自主武器的性质及其与稳定概念的交集来研究,包括危机稳定、升级动态和战争终止。自主武器的核心问题之一是将致命的决策权交给机器所带来的风险。简单地说,风险--包括概率和后果--就是武器系统攻击那些让它运作的人不希望它攻击的东西。国防部将这些情况称为 "意外交战",这一概念也包括对其他适当目标的过度附带损害。这可能由于各种原因而发生:简单的机械故障、软件故障、不同组件的相互作用导致的系统故障、测试不足、设计错误、培训不足、人机界面不佳、人为错误、与环境的意外互动,以及对手的黑客攻击、欺骗或行为操纵。

虽然其中一些担忧因系统的复杂性和/或自主性而加剧,但总的来说,这些风险并非自主武器所独有。自相残杀、平民伤亡和事故是战争中不幸的现实。然而,自主武器构成了一个独特的挑战。自主武器的故障可能会导致 "失控的枪",在人类能够重新控制之前的一段时间内自行攻击不适当的目标。在最坏的情况下,武器可能会继续攻击不适当的目标,直到耗尽其弹夹。根据具体的武器、目标类型、弹夹容量和使用环境,这样的事故可能导致重大伤害。

除了对友军或平民的攻击,意外的交战也可能包括对敌军的攻击,这些敌军本来是合法的目标,但在时间、地点或方式上与人类操作员的意图不同。在边缘政策、危机或有限战争期间,这些交战可能导致意外的升级,破坏稳定。由于自动化的速度,这些交战可能发生得相当快,导致危机迅速失控。

另一方面,某些形式的自主性可以增加稳定性。自动防御系统可以帮助人类争取时间在危机中做出决定,而自动信息系统可以帮助人类快速处理大量混乱或冲突的信息。自动反应系统可以通过有效地束缚一个国家的手脚和减少不确定性来增加威慑力,如果这种自动性能够令人信服地传达给对手的话。另一方面,如果自主武器被认为是不可预测的,那么对其风险的不确定性可能会促使人们在走向战争的滑坡中保持谨慎--"疯子 "理论适用于自主机器的稳定性。

因此,自主武器对稳定性的影响的一个至关重要的方面是其操作的可控性和可预测性的程度。这既包括系统本身的行为,也包括其在竞争环境中与对手系统的互动。由于完全自主的武器通常还不存在,除了一些罕见的例外,本论文研究了总共80多个相关系统的案例研究。这些案例包括具有不同程度自主性的现有武器系统,以及在竞争和/或无约束环境下运行的非军事自主系统。研究这些案例是为了了解人类用户在多大程度上可以准确地预测和控制复杂的、高度自主的系统在无约束或敌对环境中的行为。这些案例包括:

-

在非军事环境中涉及复杂的自动化或自主系统的事故,包括F-22国际日期线事件和法航447坠机事件。

-

在股票交易的竞争、高速对抗环境中涉及自动化的事故,包括2010年5月6日的闪电崩盘的原因和随后的风险缓解措施。

-

2003年爱国者自相残杀事件,在伊拉克战争的最初阶段,高度自动化的美国爱国者防空系统击落了两架友好飞机。

-

宙斯盾作战系统的性能,这是一个由美国海军操作的舰载防御性人类监督的自主武器系统。

-

当今最先进的机器学习系统的行为。

这些案例研究是通过两个关于复杂系统风险的理论来研究的:正常事故理论和高可靠性组织,它们对复杂系统的事故风险有相互竞争的预测。正常事故理论预测,可以采取谨慎的措施来减少风险,但在复杂的、紧密耦合的系统中,事故是不可避免的。另一种理论是,通过某些程序,高可靠性的组织可以在高风险的环境中实现非常低的事故率。本论文评估了这些理论对自主武器的适用性,以及案例研究表明自主武器在多大程度上对用户是可控和可预测的。此外,核武器的安全记录也被作为衡量军队安全管理危险武器系统能力的一个标准。

这个可控性问题的基础是机器智能的脆性。与人类智能不同,人类智能是广泛的,并允许人类灵活地适应一系列情况,而机器智能--至少从今天的技术来看--是相当狭窄的。人工智能系统通常可以在狭窄的任务中胜过人类,如驾驶汽车或下围棋,但不能适应新的环境。如果被推到其任务范围之外,它们就会失败,而且往往失败得很惨。一些研究人员推测,未来可以制造出表现出类似人类的人工通用智能(AGI)的机器。原则上,一个表现出通用智能的机器将解决许多关于意外约定的担忧。一个真正的AGI可以像人类一样,推理出指挥官的意图,而不仅仅是他们的命令,并相应地调整他们的行动。开发AGI的前景是未知的,对它可能发展的时间的估计是疯狂的推测。尽管如此,本研究将简要审查关于AGI的新生(而且公认是极度推测的)文献,并考虑AGI对自主武器和稳定的影响。

最后,如果自主武器对稳定构成风险,本论文将考虑各国可能采取的潜在风险缓解措施,包括单边和合作。国际军备控制和单边自律有丰富的历史,可以追溯到几千年前。本论文研究了限制武器的努力成功和不成功的例子,并对管理自主武器风险的前景做出了结论。

这篇论文使几个受众受益。首先,它通过将现有理论应用于一种新兴技术,为战略稳定的学术文献做出了贡献。其次,它有助于为现实世界中关于自主武器的国际讨论提供信息。今天,军队正在努力解决在未来武器系统中设计多少自主权和人类控制的问题。此外,国家、国际组织和非政府组织正在讨论哪些国际规范、条约、制度或法规对自主武器是有用的,如果有的话。虽然没有政策规定性,但本论文还是产生了与政策相关的发现,以帮助那些辩论增加武器自主性的人了解情况。

背景和现有文献

稳定性是新兴武器技术的一个重要考虑因素,并有丰富的知识历史。稳定性包括一些不同的概念,包括第一次打击的稳定性、升级控制和军备竞赛的稳定性,这些都与自主武器有不同程度的关联。此外,自主武器可能会对战争的终止带来新的挑战,这是一个重要的考虑因素,有时也包括在稳定的大伞下。

稳定性的概念出现在20世纪50年代的美国核理论家中,他们试图解决这种新的和强大的武器的影响。美国官员早在1947年就开始担心,核武器的巨大破坏力使哪个国家先下手为强,就有可能导致苏联发动突然的核攻击。因此,美国的核力量在面对苏联的突然袭击时的这种脆弱性,使美国有动力在战争迫在眉睫时自己先动手。当然,知道这一点只会进一步刺激苏联在可能的敌对行动中先发制人。这种危险的态势抓住了先发制人的本质,在这种情况下,对手就像狂野的西部枪手一样对峙着,只要有一丝迹象表明对方可能会拿起枪来,双方都准备先发制人。正如托马斯-谢林对这种困境的解释,"我们必须担心他打击我们,以防止我们打击他,以防止他打击我们。"危险的是,不稳定本身可以创造一个自我实现的预言,一方首先攻击,担心另一方的攻击。

虽然美国的战略家们考虑立即采取措施,减少美国核力量对突袭的脆弱性,但随着时间的推移,这一概念演变为对 "稳定 "更广泛的渴望。稳定性的概念比仅仅保护自己的部队不受突然袭击更广泛;它考虑到了冲突双方的观点。稳定还包括避免在部署自己的军事力量时,让对手认为自己有遭受突袭的风险,从而激励他首先发动攻击。托马斯-谢林(Thomas Schelling)描述说,一个稳定的局势是 "在先发制人的情况下,双方都不能破坏对方的反击能力",从而避免了不稳定的枪手动态,即激励每一方先发制人,如果他认为对方可能会攻击。

战略稳定的概念是来自物理世界的直接类比。一个稳定的平衡是指,如果受到外部力量的干扰,会恢复到原来的平衡状态。一个坐在碗底的球处于一个稳定的平衡状态。如果球被稍微移动,它将回到碗底。相反,一个不稳定的平衡状态是一个轻微的干扰将导致系统迅速过渡到另一个状态。一支铅笔在其顶端平衡,处于不稳定的平衡状态。任何轻微的干扰都会导致铅笔向一侧倾倒。当核战争一触即发时,类似于铅笔尖上平衡的状态是一种不稳定的情况。

随着时间的推移,出现了几种不同的稳定性变种。减少突袭动机的最初概念被称为 "第一打击稳定性"。第一轮攻击的稳定性是指竞争者没有动机首先攻击的条件。一个相关的概念是 "危机稳定性"。危机稳定性与先发制人的稳定性有关,但它的视野更广,关注的是避免任何可能使危机升级的不必要的条件。这些条件可能包括对故意升级的不正当刺激,如可能导致第一击不稳定的脆弱性。危机的稳定性也可能受到以下因素的破坏:意外升级,例如下级指挥官自作主张;自动升级,例如预先授权作出反应,而实际上决策者可能不想执行;或对对手的行动或意图的误判,导致危机升级。最后,稳定的概念在时间上可以延伸到军备竞赛稳定的概念,这是一个理想的条件,各国可以避免昂贵和浪费的军备竞赛,因为这不会使他们获得对对手的任何优势,从而创造一个稳定的条件。

事实证明,稳定是减轻核武器潜在风险的一个极其重要的智力工具。在整个冷战期间,美国和苏联采取了许多单边和合作措施,旨在加强稳定,避免潜在的不稳定局势,因为这些局势可能会在危机中推动国家的战争。虽然不可能肯定地证明这些措施产生了预期的效果--毕竟,一个反事实的实验将包括故意试图煽动核战争--但整个冷战期间和之后的核事件的记录表明,如果有的话,这些促进稳定的措施可能更加有力。

随着新的军事技术的出现,稳定是一个重要的视角,应该通过它来评估这些技术。许多技术不会以这种或那种方式对稳定产生重大影响,但有些军事技术确实具有战略影响。例如,空间和网络空间的竞争加剧是两个具有战略影响的领域。应不断评估这种竞争对稳定的影响。同样,对于可以自行选择和攻击目标的自主武器,也应评估其对稳定的影响。

什么是自主武器?

长期以来,自动化已经以各种形式被用于武器系统。70多年来,军队已经使用了 "发射和遗忘 "的归航弹药,这些弹药拥有机载寻的器来归航于敌人的目标。然而,越来越多的自主性正在使未来的系统能够在广泛的区域内搜索目标并自行摧毁它们。这些自主武器系统一旦启动,就会在人类没有决定要攻击的特定目标上选择并攻击目标。

至少有30个国家已经拥有人类监督的自主武器系统,用于保护车辆和基地免受短时饱和攻击。这些系统包括空中和导弹防御系统;反火箭、火炮和迫击炮系统;以及保护地面车辆免受射入的主动保护系统。人类操作者监督他们的操作,并在必要时可以干预以停止其运作,尽管不一定在事件发生之前。(事实上,人类操作者可能不知道系统在不适当地运行,直到事故发生)。人类操作者通常也有物理访问的能力,至少在原则上,在系统不能响应软件命令的情况下,可以手动关闭系统。

这些系统对于军队在一个日益复杂的精确制导武器时代有效保卫基地和车辆是至关重要的。如果没有自主的操作模式,人类操作者可能会被短时的饱和攻击所淹没,而这种攻击可能超过他们对每一个来袭威胁的反应能力。这些系统是防御性的,可能有助于稳定,在某些情况下被用来保护平民。然而,即使有人类的监督,这些系统也不是完美无缺的。2003年,美国爱国者防空系统发生了两起自相残杀事件,它击落了友军飞机,导致飞行员死亡。这些事故是由训练不足、系统设计不良、人机界面不透明、战场上的意外情况以及过度信任自动化的操作者文化等复杂因素造成的。这些事件表明,高度自动化的武器在现实世界的操作条件下使用时,会有一些更多的风险。

越来越多的自主权继续被纳入未来的军事武器系统,不仅是无人机和无人车,还有下一代的弹药。以色列的反雷达哈比就是一个例子。此外,一些支持禁令的人对一些具有先进瞄准功能的下一代导弹提出质疑,包括英国的 "硫磺石"、挪威的联合打击导弹(JSM)和美国的远程反舰导弹(LRASM)。

越来越多的自主权继续被纳入未来的军事武器系统,不仅仅是无人机和无人车,还有下一代弹药。以色列的反雷达哈比就是一个例子。此外,一些支持禁令的人对一些具有先进瞄准功能的下一代导弹提出了疑问,包括英国的 "硫磺石"、挪威的联合打击导弹(JSM)和美国的远程反舰导弹(LRASM)。公开发布的关于其功能的数据往往对其在选择和攻击目标方面的自主程度含糊不清。这突出了自主武器军备控制的困难之一。由于自主武器和半自主武器之间的区别可能在于软件,透明度和核查可能是困难的。

这些下一代导弹也显示了随着时间推移逐步推进自主性的挑战之一。即使是制造自主武器的军队也可能看不到今天的武器和未来的自主武器之间有一条明确的界限。军队可能会逐步增加更多的自主功能,而不一定经过深思熟虑的辩论,甚至是有意识地决定追求自主武器,认识到战略风险和利益。

为什么军队会想要自主武器?

虽然没有国家声明他们正在追求自主武器,但也很少有人排除它们。军队有许多动机来追求军事系统中越来越多的自主功能,包括更高的精度、可靠性、减少人员成本,以及在通信退化或被剥夺的环境中与无人和机器人系统进行操作的能力。

在许多情况下,在获得提高自主性的优势的同时,仍然保留一个人 "在回路中",以授权特定目标进行交战。可以向人类操作员提示潜在目标的机载瞄准算法可以将带宽要求大幅降低到每秒仅数百千比特,从而允许在通信退化的环境中操作。然而,保留人类对特定目标的授权仍然需要一些带宽,以及一些时间让人类操作员做出明智的决定--至少几秒钟--取决于目标和环境的复杂性。

如果获得人类的授权不可行,军队可能希望将交战决策权下放给自主系统。如果与无人居住的战斗车辆的通信被降低或被拒绝,就可能出现这种情况。这也可能发生在交战时间表被压缩到使人类保持在循环中不再可行的情况下。这就是今天各国拥有由人类监督的防御性自主武器的理由,类似的逻辑也可以适用于进攻性角色。

军方也可能仅仅是因为担心其他国家可能正在开发自主武器,以及它们可能产生重要的战场优势,即使它们的具体应用尚不清楚。

最后,在许多领域,如汽车,自主发展的渐进性表明,军队有可能悄悄进入自主武器领域,也许甚至没有做出追求自主武器的战略决定。

自主武器的法律和伦理问题已被广泛探讨

自主武器引起了一些关注,包括关于人类使用武力的责任和义务的法律、道德和伦理问题。这些问题已被纳入越来越多的自主武器文献中。虽然大部分关于自主武器的文献都来自于倡导的立场,但围绕自主武器的法律和伦理问题还是存在着广泛的辩论。Matthew Waxman、Ken Andersen、Daniel Reisner和Rebecca Crootof就围绕自主武器的许多法律问题撰写了文章。Peter Asaro、Robert Sparrow和B.J. Strawser等一些学者研究了自主武器的道德和伦理层面。联合国法外处决、即决处决或任意处决问题特别报告员Christof Heyns对围绕人类尊严和自主武器的一些伦理问题进行了最优雅的论证。

安全和可控性

自主武器也引起了对安全和可控性的重要考虑。自主性的本质是将任务的控制权交给机器。然而,自主系统仍然是由人类为某种目的而设计和使用的。人类操作者如何对自主性越来越强的武器保持有意义和有效的控制,特别是如果自主武器在没有通信或行动速度超过人类反应时间的情况下可能最有用?军方如何确保在复杂的现实世界环境中,在受到对手黑客攻击、欺骗、物理攻击和欺骗的情况下,能够实现安全运行?失去控制会极大地挑战决策者在危机中管理升级的能力,甚至可能导致意外或不经意的升级。围绕自主武器的安全和可控性问题很少被讨论,即使被讨论,也通常是在两个相当有限的背景下进行的。

研究可控性的第一个领域是在 "有意义的人类控制 "的框架内,这是一个模糊的术语,被禁令倡导者提出来作为未来武器中自主性作用的积极愿景。尽管对有意义的人类控制的含义缺乏明确的定义,但这个词在许多关注自主武器的人中已经流行开来。在联合国《特定常规武器公约》关于自主武器的会议上,有意义的人类控制一直是一个重要的讨论话题。有意义的人类控制也是非倡导性的联合国研究小组--联合国裁军研究所(UNIDIR)的报告的主题。关于有意义的人类控制的讨论通常集中在什么使人类控制在道德或法律意义上 "有意义 "的概念上,侧重于人类的责任和问责制。关于有意义的人类控制的对话重点通常是从人类操作者的心理角度出发,以及操作者是否在认知上参与决策,或只是将决策权交给自动化。虽然有关于自动化偏见和人类与自动化互动的现有文献,但大多数关于有意义的人类控制的讨论都围绕着定义问题和预期目标。

有意义的人类控制的第二个关键维度--安全和可控性--与设计自主武器的技术方面有关,这些武器将在真实世界的操作条件下按照预期的方式运作。尽管美国国防部的一些官方出版物对这些问题进行了讨论,但在这方面的文章较少。

美国国防部关于武器自主性的官方政策,即国防部指令3000.09,武器系统的自主性,广泛涉及测试和安全问题,以确保纳入自主性的武器系统在现实世界的操作条件下发挥应有的作用。 该政策很少涉及法律或道德问题,只是说自主武器,像所有的武器一样,必须通过法律审查,使用自主武器的人必须 "适当小心,并遵守战争法、适用的条约、武器系统安全规则和适用的交战规则(ROE)。"相反,国防部文件的目的是"[建立]准则,旨在尽量减少自主和半自主武器系统故障的概率和后果,这可能导致意外的交战。 因此,这份15页的文件的大部分内容涵盖了测试和评估、软件验证、人类操作员培训、系统设计和其他安全相关问题的标准。

国防部指令3000.09建立在2007年国防部无人系统安全指南的基础上,该指南涉及无人(无人)系统的类似主题。 美国空军首席科学家办公室发布了一份报告《自主地平线。美国空军首席科学家办公室在2015年6月发布了一份报告《自主地平线:空军的系统自主性--通往未来的道路》,其中一个主要的主题是需要新的技术来验证和确认自主软件,以确保在现实世界的操作中的可预测行为。同样,2016年国防科学委员会关于自主性的报告涉及测试、验证和网络弹性。

然而,这些文件对自主性的安全性和可控性方面进行了狭义的研究,只考虑了人们可能采取的技术步骤来提高安全性。他们认为安全和可控性类似于人们对其他武器或危险工具(如手榴弹或电锯)的直接安全关注。他们甚至没有承认,自主武器的可控性问题可能会引起更广泛的战略关注--事实上,大规模部署自主武器可能是相当危险的,对升级管理、战争限制或战争终止有害。

自主武器与稳定

虽然自主武器的稳定性问题目前还没有反映在政府关于自主性的官方文件中,但一些学者已经提出了这些问题。迈克尔-卡尔-哈斯(Michael Carl Haas)就自主武器对稳定的影响发表了文章,提出了关于自主武器对军备竞赛稳定、危机稳定和升级控制的影响问题:

- [使用自主武器的]国家将在危机方程中引入一个他们无法直接控制的因素,但它仍然与人类对手的战略心理相互作用。实际上,在自主系统作战期间管理其行为的人工智能(AI)将成为参与危机的另一个行为者,尽管它受到一套算法和任务目标的严格限制。

这就在方程式中引入了一系列复杂的变量:人工智能本身,它准确地遵循人类指挥官的指导的能力,对手对人工智能的期望,以及对手可能利用人工智能的任何漏洞。利用漏洞的形式可以是通过恶意软件直接入侵,或通过利用可预测的人工智能行为进行行为入侵。此外,通信干扰为这个方程式引入了另一个变量。通信干扰可能会限制或完全消除与人类操作员的通信,迫使机器人车辆完全自主地运行。然后,这就产生了另一套围绕委托给人工智能的交战规则的反应、看法和反反应。

哈斯指出,自主武器的一个问题是,如果它们不能被召回,其使用可能会使升级管理复杂化。

- 显然,可召回性和失去控制是主要关切。虽然像X-47B UCAS[无人驾驶作战系统]这样的攻击系统最初可以在人类的密切监督下使用,但很难看出它们如何能在那些迄今为止提供最大附加值的情况下实现其全部潜力:情报、监视和侦察(ISR)以及深入防卫森严的领土内的攻击任务,在那里通信可能会被削弱,而让人类不断保持联系所产生的电子辐射可能是一个致命陷阱。

先进的军队有在有争议的环境中进行通信的方法,尽管这些方法的带宽和范围有限,而且可能需要附近有人居住的(有人)飞机。然而,哈斯的观点仍然有效。如果不可能与人类控制者进行通信,无人驾驶飞行器将不得不限制其任务,或者,如果它完全自主运行,那么使用它的人类将不得不接受失去控制和可召回的风险。哈斯正确地指出,在冲突的早期阶段,军队可能会在深入敌方领土的 "反进入/区域封锁 "区使用自主武器,在那里它们可能不得不在长时间内与人类控制者没有联系的情况下运行。

- 在防卫区内的这些时间里,[自主武器]可能无法完全召回或重新编程,即使政治局势发生变化,这带来了不受欢迎的升级风险,并可能破坏政治举措。

即使政治局势没有变化,对手也可能利用自主武器的交战目标定位规则的漏洞。

- 这可能包括,除其他外,将重要的资产转移到繁忙的城市环境或不允许的目标旁边,如水电大坝或核电站;改变武器和设施的外观以模拟非法目标,甚至可能改变非法目标以模拟合法目标;大规模使用假人和遮蔽物,以及全套电子欺骗措施。

所有这些都可能导致无意中的升级,因为缺乏可召回性,失去对自主武器的有效控制,或者仅仅是因为对手利用了自主武器瞄准算法的弱点。哈斯总结说,自主武器对危机稳定提出了一些挑战性问题。"在一些情况下,自主打击系统的引入可能会导致暂时失去对行动的高层控制,以及不必要的升级(常规或核)。" 因此,政策制定者 "在权衡自主武器对军事稳定的影响和将这些系统引入一个目前非常复杂的方程式的潜在好处时,应该谨慎小心。" 哈斯认为,应将 "相互克制 "作为一个严肃的选项进行探讨。哈斯的担忧特别值得注意,因为它们反映了对与自主武器相关的战略风险的认识,而这些风险并没有反映在任何政府--美国或其他国家的政策文件或公开声明中。

肯尼斯-佩恩对人工智能更广泛地提出了类似的担忧,即它们被引入战争将以深刻的方式改变战略。人工智能系统如果与人类的意图不一致,或者不能灵活地适应不断变化的环境,就可能产生风险。他解释说:

- 如果人工智能误判了其人类委托人的意图,就有可能发生灾难性的和无端的暴力。......一个为满足预先指定的声誉和信誉标准而升级的人工智能可能无法及时反思其行动的后果,从而允许改变方向。

这可能会导致 "意外的升级"。佩恩还认为,人工智能系统将缺乏与人类对手产生共鸣的能力,而这在缓和冲突方面是有价值的。他以古巴导弹危机为例说,"在紧张的对峙中,社会智能和心智理论是决定性的。"49 虽然佩恩的论点是关于一般军事人工智能系统的限制,但它们肯定也适用于自主武器。

Alexander Velez-Green认为,自主武器可以增加或减少稳定性,这取决于武器的类型和部署情况。作为一个例子,Velez-Green引用了部署在韩国非军事区(DMZ)的三星SGR-A1机器人机枪,在一些报道中,该机枪据称具有完全自主能力。Velez-Green认为,一个完全自主的SGR-A1,即使与人类控制者的通信被切断,也能与前进中的朝鲜军队交战,将增强威慑力,从而改善危机中的稳定。这是因为SGR-A1完全是一种防御性武器,是一种固定在边境的静态炮。Velez-Green承认在区分进攻性和防御性武器方面存在挑战,并得出结论。

- [各国应参与国际对话,明确界定自主武器的正确用途,商定核查各国是否正确使用这些武器的方法,并指定违规者的后果。

在其他地方,Velez-Green对自主武器对稳定的影响采取了更细致的立场。在Paul Scharre提出的自主武器可能在战场上以不可预测的方式进行互动的担忧基础上,Velez-Green列举了一些武器以外的自主系统以令人惊讶的方式行事的例子。这些例子包括亚马逊上两个自动卖家机器人之间的竞价战,导致一本教科书被定价为2360万美元;1983年由苏联奥科导弹预警系统的错误警报引发的核事件;以及2010年华尔街的股市 "闪崩"。维莱斯-格林警告说,自主武器以不可预测的方式进行互动,可能会引发一场 "闪电战",并概述了一个涉及自动化网络武器的可怕场景,说明它可能发生。

约翰-博里对自主武器持更加悲观的看法。博里与 "正常事故理论 "相提并论,他认为:

- [Borrie认为:[自主武器]有一个安全层面,与我们对自主目标或攻击的伦理或合法性的看法无关。我的看法是,可能无法有效地控制或预测自主武器系统即使在最初的简单故障中会发生什么。这并不是因为故意滥用,也不是因为 "机器人正在接管",而只是因为很难像防止复杂、紧密耦合的系统出现灾难性故障那样,迅速诊断并有效地应对故障。

在得出这一结论时,Borrie借鉴了其他高风险行业中复杂、紧密耦合的系统的历史,包括核反应堆、核武器、商业航空和石油钻探。他列举了法航447航班、三里岛和深水地平线事故等例子。

2016年4月,在瑞士日内瓦举行的联合国自主武器会议的间隙,Borrie在关于自主武器和风险的演讲中阐述了这些担忧。Borrie关注的是自主武器的 "无意风险",如果 "系统的行为不符合其设计者和操作者的意图",就可能出现这种风险。根据理解复杂系统风险的两个相互竞争的理论,即正常事故理论和高可靠性组织理论,博里得出结论,自主武器 "在许多情况下非常符合复杂、紧密耦合系统的特征"。与其他分析家类似,鲍里将其与其他领域的复杂紧耦合系统的事故相提并论,如太空旅行、股市闪崩和核事故。Borrie认为,自主武器事故的后果可能包括 "大规模杀伤性事故和对战略稳定的影响"。

Paul Scharre和Michael Horowitz对自主武器的可预测性或可控性提出了与Haas、VelezGreen和Borrie类似的担忧。Scharre和Horowitz认为,自主武器是 "脆弱的"--在可预测的环境中能够表现良好,但有时在未预料到的情况下会严重失败。他们以2003年 "爱国者 "自相残杀事件为例,说明如果自主系统发生故障,可能产生的后果。他们指出,在2003年 "爱国者 "自相残杀事件中,人类实际上是 "在圈内"。虽然人类操作员未能阻止自相残杀事件的发生,但他们能够在事后进行干预并停止系统的运行,防止了更多的自相残杀事件。完全自主的武器可能就不是这样了。完全自主的武器发生故障的后果可能要严重得多。

- 在这种情况下,系统故障--由故障、与环境的意外互动或网络攻击引起--会引发战场上大规模自相残杀的可怕前景。与2010年的闪电事故类似,从理论上讲,一大批自主系统发生故障可能会迅速失去控制。在最坏的情况下,其结果可能是自相残杀、平民伤亡或危机的意外升级--甚至可能是一场 "闪电战"。

在对自主武器的风险和可预测性的相关评估中,探讨了与鲍里关于正常事故的工作类似的案例研究,沙尔进一步增加了速度的维度,作为潜在破坏稳定的一个复杂因素。

- 竞争环境中的自然趋势是走向更高的速度,需要更多的自动化,进一步加快战斗的步伐。其结果可能是一个不稳定的局面。自主系统之间的意外互动或黑客攻击可能导致 "闪电战",在这种情况下,冲突会迅速脱离人类控制。

其他学者加深了对正常事故理论适用于自主武器的理解。在2017年的一篇论文中,Stephanie Carvin对正常事故理论、其批评者以及与之相对应的高可靠性理论进行了深入分析,她得出结论:"有充分的理由相信,[致命的自主武器系统]将容易发生正常事故,尽管对其使用有严格的控制。"

Matthijs Maas将这些同样的担忧更广泛地推广到人工智能系统,并得出结论,人工智能系统的正常事故是 "不可避免的。"此外,Maas指出,这些问题在竞争环境中会加剧。他最后提出了一些值得进一步探讨的潜在的监管策略,包括

- 改变系统被用户使用的方式--尽可能找到减少人工智能的耦合性或不透明性的方法;限制系统在预定环境之外部署时的自主性(或速度)。......部署的人工智能架构和网络系统的异质性(以隔离系统的闪电式崩溃)......[以及]对 "可解释的 "人工智能和更广泛的人工智能安全的研究。Maas还建议进一步研究如何在不妨碍性能的情况下减轻风险因素,以及 "可能更好地促进优雅故障的组织和技术创新"。

马斯还建议进一步研究如何在不妨碍性能的情况下减轻风险因素,以及 "可能更好地促进优雅失败的组织和技术革新"。马斯承认,在确定人工智能系统正常事故的技术或组织解决方案方面还有很多工作要做,但还是清楚地概述了这个问题,并提出了一些探索潜在解决方案的途径。

Jürgen Altmann和Frank Sauer也有类似的观点,他们对自主武器如何破坏危机稳定进行了最深入的论证。他们关注的核心问题是,速度和复杂性的结合可能会导致自主系统之间出现意想不到的相互作用。在《生存》杂志2017年的一篇文章中,他们描绘了这种情况是如何由于蜂群之间的互动而发生的,尽管合作自主(又称蜂群)并不是发生这种互动的必要条件。他们的分析适用于任何涉及敌对自主系统在非常复杂的环境中高速互动的情况。

-

一个这样的蜂群战斗情况可能是严重的政治危机,对手认为战争可能爆发。由于蜂群部署在彼此之间的距离很近,控制软件必须在瞬间的时间框架内对攻击的迹象做出反应--通过回避或可能在不使用它们就失去它们的情况下进行反击。即使是错误的攻击迹象--被解释为火箭火焰的太阳光、对手的突然和意外的举动,或一个简单的故障--也可能引发升级。

-

军事冲突的性质决定了这些类型的互动是无法事先测试或训练的。此外,从技术上讲,不可能事先考虑到所有可能的结果。显然,蜂群的互动,如果完全自主,将是不可预测的,并有可能导致从危机到战争的升级,或者在武装冲突中,升级到更高的暴力水平。

Altmann和Sauer指出,在冷战期间,"人类推理 "在缓和危机和避免对事故或错误警报作出反应方面发挥了重要作用。他们担心,在危机中把致命的决策权交给机器的自主武器会抛弃 "经过考验的反复检查和重新考虑的机制,这些机制使人类能够作为故障保险或断路器发挥作用。

- 这与不可预见的算法互动产生不可预见的军事结果相结合,增加了危机的不稳定性,令人不快地想起冷战时期的意外战争情景。

因此,自主武器有可能带来多种复杂因素,这些因素结合在一起,可能导致小事件迅速升级为重大事故。这些因素包括:高度的复杂性造成对意外行为的敏感性;无法灵活应对新事件的脆性自动化;可能缺乏与人类操作员的沟通;以及高速互动。一些学者--Haas、Payne、Velez-Green、Borrie、Scharre、Horowitz、Altmann和Sauer--以各种形式将这种潜在的非预期事故联系起来,不仅有战术影响,而且有潜在的行动和战略影响,破坏稳定。

其他学者在更广泛的稳定概念中考虑自主武器,包括攻防平衡和军备竞赛稳定。Jean-Marc Rickli权衡了自主武器影响攻防平衡和使用武力门槛的潜力。Rickli认为,自主武器可能会降低攻击方的生命损失风险,从而降低使用武力的门槛66。他认为,自主武器还可能破坏第一次打击的稳定性,通过蜂群战术来饱和防御,这可能使攻防平衡有利于进攻方。Payne同样认为,人工智能将有利于进攻,原因有很多:机器的速度和精度提高,以及蜂群分散然后重新集中攻击的能力。

Rickli认为,赋予进攻方的优势会破坏稳定。

- 在一个有利于进攻的国际环境中,反击使用武力进攻的最佳策略是依靠先发制人。因此,如果[致命的自主武器系统]被开发出来,先发制人的战略很可能成为常态。在被攻击之前先下手为强,将提供战略优势。

佩恩同意,他说军事人工智能 "为在任何危机中首先行动创造了强大的动力"。

里克利说,自主武器提供优势的事实也将激励各国试图首先获得这些武器,从而激起自主武器的军备竞赛。因此,根据Rickli的估计,自主武器有可能以多种方式破坏稳定。它们 "在攻防平衡中有利于进攻方,因此有可能促进军备竞赛"。

里克利还考虑了远超人类的 "人工超级智能 "的前景,得出结论说,将这种技术与自主武器联姻是一个 "令人担忧的前景"。Rickli总结说,基于所有这些与稳定相关的担忧,"国际社会在考虑发展[致命的自主武器系统]时应该非常谨慎"。

Jürgen Altmann和Frank Sauer提出了与Rickli类似的关于攻防平衡和军备竞赛稳定性的担忧。他们同样得出结论,无人驾驶的车辆将通过节省士兵的生命来降低侵略的成本,而蜂群将有利于进攻方。Altmann和Sauer特别强调 "难以防御的自主蜂群 "是一种破坏稳定的技术。Altmann和Sauer还指出,自主武器处于军备竞赛的高风险中,因为该技术在很大程度上借鉴了自主技术的双重用途商业进展。这使他们得出结论,如果一个国家发展自主武器,"其他国家就会比较容易--因此也很可能--效仿"。由于一个国家开发自主武器的扩散风险很高,他们认为,"[自主武器系统]的开发很可能引发一场破坏稳定的军备竞赛。"由于这些担忧,阿尔特曼和绍尔与里克利和哈斯一起建议各国应考虑采取合作措施,以避免自主武器的危险,他们还研究了几种军控方案。

军备控制的前景

哈斯、里克里、阿尔特曼和绍尔呼吁进行国际合作以减轻这些风险,这有很多先例。虽然从纯粹的法律角度来看,以自主武器是非法的为由呼吁禁止可能在同义词上是无用的(如果一种武器是非法的,那么它就已经被禁止了),但出于战略稳定的原因禁止或管制武器有很多先例。

长期以来,军备控制一直是政策制定者减少不稳定的工具之一。到20世纪50年代末,美国的战略家已经开始考虑将军备控制作为战略稳定问题的一个可能的解决方案,除了单方面减少美国对突袭的脆弱性之外。到1958年,美国和苏联已经开始讨论可能的合作方式,以减少突袭的威胁。在冷战期间,许多武器被管制或禁止,不是因为道德或伦理原因,而是因为它们可能破坏战略稳定。其中包括禁止在海床(《海床条约》)、太空(《外空条约》)或月球上放置任何种类的武器(《外空条约》);禁止中程导弹(《中导条约》)和反弹道导弹武器(《反导条约》);以及禁止动能反卫星武器和中子弹的软规范。

事实上,根据美国法律,对自主武器的战略稳定影响的关注有一个具体的先例。在20世纪80年代发展战略防御倡议(又称 "星球大战")期间,国会在1988-89年国防授权法案中通过了一项决议,禁止战略弹道导弹防御系统 "除非由适当级别的权威机构作出肯定的人类决定,否则将启动致命的火力。"

尽管有这些先例,一些人批评了禁止自主武器的呼吁,理由是这是不可行的。在回应人工智能科学家斯图尔特-拉塞尔(Stuart Russell)关于禁止的呼吁时,埃文-阿克曼(Evan Ackerman)认为,禁止不可能成功,因为实现自主武器的基础技术是如此普遍。"阿克曼认为:"阻止人们开发这种系统的障碍实在是太低了。阿克曼认为,"创造四旋翼飞机(和其他机器人)的商业价值实在太大,它们具有更长的续航时间、更多的自主权、更大的有效载荷,以及你在军事系统中想要的其他一切。"似乎有理由认为,一项技术的可及性会影响实施禁令的可行性;更广泛的技术将需要更多的潜在用户合作,以有效实施禁令。因此,禁令的可行性是另一个需要研究的重要方面。

一些学者研究了对自主武器进行军备控制的可行性。Rebecca Crootof和Sean Watts都研究了历史上禁止武器的尝试,并确定了成功禁止武器的共同特征。Crootof确定了通常与成功的武器禁令相关的八个特征,并得出结论,这些特征中只有一个适用于自主武器的情况。其他特征要么是 "不确定的,要么是目前对成功禁止的可能性有影响的"。 "Watts的结论是:"虽然自主武器系统目前同时表现出容忍监管和抵制监管的特点,但总的来说,对[监管]抵制的考虑......占了上风,并表明各国在近期内同意有意义的特定监管或先发制人的禁令的可能性很低。"

Jürgen Altmann和Frank Sauer得出的结论略有不同。他们认为,鉴于人工智能和自主性的巨大社会效益,试图限制获得能够实现自主武器的基础技术的不扩散制度不仅是 "徒劳的",而且事实上是 "严重误导"。 Altmann和Sauer承认核查军备控制条约的挑战,"因为软件可以在检查后几分钟内被改回来,"但他们建议,在事件发生后利用法证记录核查遵守情况的事后解决方案可能是一个解决方案,也许可以利用新技术,如 "区块链等抗操纵数据库解决方案。 "最终,他们得出结论,禁止自主武器 "不容易实现",但他们指出,"军备控制几乎从来不是。"他们认为,围绕自主武器的 "一长串关切"--法律、道德和战略--有利于民族国家努力 "共同阻止武器系统的完全自主化竞赛"。

Crootof、Watts、Altmann和Sauer的这些分析具有启发性和洞察力,并共同表明对自主武器的监管将极具挑战性。然而,令人惊讶的是,除了他们的工作之外,普遍缺乏关于一些武器禁令为何成功和不成功的理论。不过,有超过40个成功和不成功的武器禁令的历史例子,可以从中得出结论。在Crootof和Watts的工作基础上,这些历史实例可以帮助解释为什么一些禁令成功,而另一些则失败,并为禁止或监管自主武器的前景提供见解。

文献摘要

自主武器是人工智能在军事领域的一种应用,而人工智能的其他用途也可能对稳定产生重大影响。这些包括,但不限于,由人工智能驱动的机器人系统改善情报收集,自动情报分析,由人工智能驱动的战略决策,指挥和控制的自动化,以及可能加强或破坏核威慑能力的机器人系统。作为一种通用的使能技术,很像电力或内燃机,人工智能将有广泛的军事应用。已经有大量的文献在探索人工智能在稳定方面的更广泛的应用,特别是核稳定方面的应用88。

总的来说,关于自主武器和稳定的少数文章与其说是一个既定的文献领域,不如说是一组初步的论点和假设。通过文章和演讲,一些学者已经开始提出自主武器对稳定的几个方面的影响问题:危机稳定、攻防平衡和军备竞赛稳定。Altmann和Sauer最清楚地阐述了对危机稳定性的担忧,他们认为,自主武器的非预期行动倾向加上缺乏人类控制,可能导致意外的升级。

这些学者的担忧在目前关于自主武器的国际讨论中显得尤为突出,包括越来越多的声音呼吁禁止开发和使用自主武器。所有这些文章的一个主导主题是,关于自主武器的讨论应该扩大到法律和伦理问题之外,还应该包括考虑它们对稳定等方面的影响。这篇论文为这一新生的文献做出了贡献。

研究问题

本论文研究了自主武器的稳定性问题和降低风险的前景。核心问题是

自主武器是否对稳定构成挑战,如果是的话,各国可以采取哪些可行的风险缓解措施?

具体的子问题包括:

I. 自主性和自主武器

-

自主性的本质是什么?什么是自主武器?

-

自主性在历史上是如何被纳入武器的?

-

自主武器与现有的保留人类对目标选择和交战的更直接控制的武器有何不同?

II. 武器中的自主性趋势

-

今天正在制造的下一代武器中包含了哪些类型的自主性?

-

趋势表明,自主性可能会被用于未来的武器中?

-

武器中的自主性如何与网络空间和网络武器交织在一起?

III. 稳定性和自主武器

-

稳定性的概念是什么?什么是不同种类的稳定?哪些条件有助于或有损于稳定?

-

自主武器可能在哪些方面影响稳定?自主武器如何影响危机稳定、升级控制或战争终止?

-

自主武器,无论是单独还是与对手的自主武器相结合,是否会导致一种 "脆弱的稳定 "状况,即危机迅速升级,脱离人类指挥官的控制?

-

自主武器能否通过增加危机中的可预测性来提高稳定性?

IV. 控制自主武器:风险、可预测性和危险

-

随着系统变得更加自主,风险、可预测性和危险如何变化?

-

与现有的半自主武器相比,自主武器发生故障或事故的可能性和后果是什么?

-

现有的半自主或受监督的自主武器,如爱国者防空系统和宙斯盾作战系统,其经验对自主武器的风险和控制有何启示?

-

非军事自主系统在竞争或不受约束的环境中的经验对自主武器的控制有什么启示?

-

军方如何确保在现实的操作条件下,包括在通信降级或被拒绝、敌方黑客攻击和欺骗的条件下,实现可预测和故障安全的操作?

-

现有的复杂系统的安全理论--正常事故理论和高可靠性组织--如何适用于自主武器?

-

危险技术的历史先例,如核武器,对军队有效管理这些风险的能力有何启示?

V. 机器学习系统

-

机器学习方面的最新进展如何改变这些风险?

-

人工通用智能的发展将如何改变这些风险?

VI. 围绕自主武器的操作因素

-

相对于保留人类 "参与 "的半自主武器,完全自主的武器可能有多大价值?

-

在物理空间或网络空间,完全自主的武器发生事故可能会有什么后果?

VII. 减轻风险:政策选择和历史先例

-

各国可以使用哪些军备控制、透明度或建立信任的措施来减轻自主武器的潜在风险,单边或集体的?如果成功的话,这些措施在减少风险方面的效果如何?

-

从过去被视为潜在破坏稳定的武器的历史经验中可以学到什么教训?今天的自主武器有哪些相似之处?

-

历史上的例子对各种政策选择的可行性有何启示?

方法论

研究自主武器对稳定的影响特别具有挑战性,因为它们是潜在的未来武器,而不是今天存在的武器(除了一些罕见的例外)。这使得即使理解自主武器的性质也很困难,更不用说其扩散和冲突动态的二阶和三阶影响。然而,这些问题是考察新兴技术的本质所固有的。担心一项新技术可能会破坏国际安全的稳定,这是一个先发制人的研究理由。例如,我们不需要等到(也不应该等到)核战争爆发时再考虑核武器的稳定性动态。幸运的是,在相关领域有大量的研究和可用的案例研究来帮助解决这些问题。

为了更好地理解自主系统在复杂的现实环境中的表现,本书使用了来自军事和非军事环境的80多个具体技术实例。

-

在其他武器,特别是核武器的背景下,稳定性和升级动态已经得到了彻底的探讨。这些文献非常广泛,可以追溯到几十年前的冷战时期。这一研究领域提供了一个强大的智力框架,可以在考虑自主武器时加以利用。

-

自动化在武器中的历史用途。在现有的武器中,自动化被广泛用于各种功能,包括跟踪和识别目标,确定目标的优先次序,决定何时开火,以及在发射后对目标进行定位。我们研究了27种不同的武器系统,以说明自动化的不同应用:

- 宙斯盾武器系统(美国)

- AIM-120 AMRAAM导弹(美国)

- 竞技场主动防护系统(俄罗斯)

- 蝙蝠反舰滑翔炸弹(美国)

- BLU-108/B子弹药(美国)

- 辉煌反坦克弹药(BAT)(美国)

- 反火箭、火炮和迫击炮(C-RAM)系统(美国)

- G7es/T5 Zaunkönig (Wren)鱼雷(德国)

- G7e/T4 Falke(猎鹰)鱼雷(德国)

- 手置大黄蜂(美国)

- Harop游荡弹药(以色列)

- 哈比游荡弹药(以色列)

- 高速反辐射导弹(HARM)(美国)

- 低成本自主攻击系统(LOCAAS)(美国)

- M898感知和摧毁装甲弹药(SADARM)(美国)

- M93 "大黄蜂 "广域弹药(WAM)(美国)

- MANTIS防空系统(德国)

- Mk 60 CAPTOR封装鱼雷(美国)

- 爱国者防空系统(美国)

- PMK-2封装式鱼雷(俄罗斯)

- 传感器引信武器(SFW)(美国)

- SMArt 155弹药(德国)

- Tacit Rainbow(美国)

- 战斧反舰导弹(TASM) (美国)

- 战斧对地攻击导弹,Block IV (TLAM-E,或战术战斧)(美国)

- "战利品 "主动防护系统(以色列)

- XM1100 "蝎子"(美国)

-

下一代军事系统的自主性。在全球范围内,军队正在推动发展中系统的自主性的界限。本报告对22个系统进行了研究,这些系统被选择来说明一系列的应用:

- 自主航空货运/公用事业系统(AACUS)(美国)

- 机器人船群(美国)。

- 反潜战连续跟踪无人船(ACTUV)(美国)

- 武装地面机器人车辆(非国家团体)

- Aura无人机(印度)

- Brimstone导弹(英国)

- 拒绝环境下的协作行动(CODE)计划(美国)

- B.A. E. ESGRUM无人水面舰艇(USV)(厄瓜多尔)

- Guardium无人地面车(以色列)

- Modified armed drones(非国家团体)

- nEUROn无人机(法国)

- Platform-M无人地面车(俄罗斯)

- Protector USV(以色列)

- RQ-170无人机(美国)

- SGR-A1哨兵炮(韩国)

- 利剑无人机(中国)

- Skat无人机(俄罗斯)

- T-14 Armata坦克(俄罗斯)

- Taranis隐形作战无人机(英国)

- 有争议环境下的目标识别和适应(TRACE)计划(美国)

- Uran-9无人地面车辆(俄罗斯)

- X-47B原型无人机(美国)

-

网络系统。自动化长期以来一直被用于进攻性和防御性网络系统中。我们研究了四个典型的系统及其自动化程度:

- Conficker

- 1988年的互联网蠕虫

- Mayhem

- Stuxnet

-

非军事自主权和人工智能(AI)。这包括自主权在自动驾驶汽车、商业航空自动驾驶仪以及国际象棋或围棋等游戏中的应用。例如,深度学习神经网络等人工智能计算的新方法的最新进展带来了新的机遇和挑战。具体例子包括:

- 汽车

- 飞机自动驾驶仪

- 商业级四旋翼飞机(如DJI Spark)

- 开源神经网络库(如Keras)

- IBM Watson Jeopardy挑战赛

- 人工智能在战略游戏(如国际象棋、围棋)中的表现

- 深度神经网络,包括用于物体识别的

-

复杂的高度自动化系统中的正常事故、可预测性和安全性。正常事故理论和高可靠性组织的竞争理论为分析复杂系统的安全性提供了基础。研究了13个事故或高可靠性的例子,以了解在一系列行业中引起事故或高可靠性的条件:

- 阿波罗13号事件

- 挑战者号灾难

- 哥伦比亚灾难

- SpaceX事故

- 三里岛事件

- 福岛第一核电站事故

- F-22国际基准线事件

- 法航447航班坠毁

- 美国联邦航空局空中交通管制系统

- 海军航空母舰甲板操作

- 海军SUBSAFE计划

- 2016年特斯拉自动驾驶飞机坠毁事件

- 737 MAX坠机事件

-

自动化是军事环境中安全和风险的一个因素。在军事领域 场景中,自动化一直是事故和改善安全的一个因素,与其他行业类似。与其他行业类似。为了更好地理解正常事故理论和高可靠性的应用,我们研究了六个例子。为了更好地理解正常事故理论和高可靠性组织在军事环境中使用 自动化在军事环境中的应用:

- 自动地面防撞系统(Auto-GCAS)

- 基于软件的F-35飞行控制的限制

- 2007年南非的一门高射炮发生了故障

- 2010年美国海军火力侦察兵无人机失去控制

- 2011年美国空军一架RQ-170无人机失去控制并坠毁

- 2017年美国陆军一架 "阴影 "无人机失去控制并坠毁

-

在竞争环境中使用的自主系统带来了额外的挑战,有一些重要的非军事案例研究可供借鉴,特别是在金融领域。本文研究了五个案例:

- 亚马逊自动图书定价算法价格战

- 2012年华尔街骑士事件

- 2010年股市闪崩

- 闪崩后的风险缓解措施(如断路器)

- 随后的小型闪崩

-

受监督自主武器的操作经验。几十年来,全球各地的军队都在使用受监督的自主武器进行防空和导弹防御,提供了关于一种自主武器的深度操作经验。美国陆军在爱国者系统方面的经验和美国海军在宙斯盾系统方面的经验提供了一个理想的比较研究,因为这两个系统执行相同的任务(空中和导弹防御),由同一个国防承包商建造,但两个军种的使用方式不同。对它们的文化、操作经验和安全记录进行了研究,包括:

- 1988年美国海军文森号事件(伊朗航空655航班被击落)

- 2003年爱国者龙卷风被击落

- 2003年爱国者F-18被击落

- 2003年伊拉克入侵期间爱国者在弹道导弹防御方面的作战经验

- 1988年后的宙斯盾安全记录

-

核武器安全和风险是思考自主武器风险和安全的一个特别有用的试金石。尽管核武器有明显的危险性,但在整个核时代,出现了大量令人恐惧的险情事件。其中一些事件可能导致核武器失去控制或爆炸。可以想象,其他事件可能会导致超级大国之间的核交换。核武器安全一直是许多分析的主题,特别是斯科特-萨根的《安全的极限》。96 查塔姆大厦最近的一份报告详细介绍了过去60年中13起险些发生的核使用事件。

-

军备控制的尝试--有些成功,有些不成功--可以追溯到几千年前。一些古印度文献--《达摩经》、《摩诃婆罗多》和《摩奴律》--禁止带刺或有毒的箭和其他武器。随着技术的发展,它们因各种原因而被禁止、限制或允许。弩箭最初是在12世纪被教皇的两项法令禁止的(用于对付基督徒)。从17世纪到19世纪中叶,日本有效地禁止了大约250年的枪支,而英国在16世纪的类似尝试也失败了。二十世纪初,人们试图对潜艇进行监管,并禁止对城市进行空袭。化学武器被禁止,爆炸性、膨胀性或燃烧性弹丸也被禁止。今天,大量的法律、政策和规范性原则管理着广泛的武器及其使用。已有条约禁止化学和生物武器、集束弹药、地雷、致盲激光、太空或海底的大规模杀伤性武器、月球上的任何种类的武器,以及利用环境作为武器。各国已经探索了空间和网络空间的规范性框架或行为准则,特别是美国已经试图建立和巩固一个规范,反对产生空间碎片的动能反卫星攻击。总之,过去在规范武器方面成功和不成功的40多个例子提供了丰富的案例研究,以了解规范自主武器的可行性。

-

除了这些其他来源外,还使用了对各领域专家的采访。这些专家包括人机因素工程、机器学习、人类和机器认知、安全关键系统的自动化以及自动化系统的军事运作等方面的专家。这些访谈特别带来了关于复杂的军事自主武器系统运作的新信息:美国海军宙斯盾作战系统和美国陆军爱国者空中和导弹防御系统。对熟悉这些系统的海军和陆军的技术和操作专家的采访,提供了有关这些系统的操作、围绕其使用的文化、安全程序和先前事故的新信息。

对自主武器稳定性方面的任何审查都是前瞻性的,但这个问题就其本质而言,需要前瞻性的思考和分析。对于有可能破坏国际安全稳定的武器,在其部署前应考虑其风险。Haas、Borrie、Rickli、Sauer、Altmann、Payne、Velez-Green等人提出了应该考虑的重要问题,而这些问题到目前为止还没有得到足够详细的研究。尽管缺乏关于完全自主武器的影响的直接实验证据,但这种审查不需要在黑暗中进行。如上所述,在相关领域有大量的现有文献和充足的案例研究,可以利用这些文献对自主武器在真实世界环境中的性能进行有意义的预测。其中包括关于稳定和危机升级的现有文献;自主性在武器中的历史用途;军事机器人系统的未来趋势;网络系统中的自主性;非军事应用中的自主性和人工智能;非军事环境中的正常事故和复杂系统;将自动化作为风险和安全因素的军事经验;竞争环境中的自主性非军事系统;先前有监督的自主武器的军事行动经验;核武器安全;以及军控。除了评估这些领域的文献外,该项目还包括对这些领域的专家进行有针对性的采访。利用这些多样而深入的信息和案例研究,本论文预测了自主武器将如何影响稳定,以及哪些措施是可行的和适当的。

原始贡献

本论文以围绕自主武器的新生文献和学者们提出的关于自主武器对稳定的影响的问题为基础,并以新的贡献推动这一讨论。这篇论文:

1)提出了一种新颖的自主性类型学,作为系统的三维特征,而不是单一的自主性光谱(第一部分)。这种介绍有助于阐明自主性的各个方面,包括自主武器和其他应用。

2)介绍了全球正在使用或正在开发的50多个自主军事和网络系统的案例研究(第一和第二部分)。这是迄今为止汇编的最详细的武器系统自主性案例研究系列。

3)将现有的稳定性理论应用于自主武器,以便比以往更全面地了解它们在增加或减少稳定性方面的可能影响。许多学者对自主武器对稳定的影响提出了担忧,但本论文对这些担忧以及新的担忧进行了全面分类(第三部分)。总共确定了自主武器可能影响稳定的九种机制,其中四种增加稳定,五种破坏稳定。

4)利用正常事故理论和高可靠性组织的理论框架,分析了超过25个军事和非军事用途的复杂或自主系统的案例研究,以更好地理解真实世界环境中的风险、可预测性和控制(第四部分)。此外,该分析将高可靠性和正常事故理论应用于对抗性环境中的复杂系统,并提出了一套高可靠性理论何时可能占上风和正常事故理论何时可能占上风的标准,这是这些理论的一个新的应用。这些标准对复杂自主系统在对抗性环境中可能的安全记录进行了预测,并可通过未来的观察进行检验。

5)介绍了两个军事武器系统的原始深入案例研究,即美国陆军爱国者空中和导弹防御系统和美国海军宙斯盾作战系统,包括对熟悉这两个系统的专家的采访(第四部分)。这包括关于这两个武器系统的操作、围绕其使用的文化以及安全程序的新信息,这些信息在其他地方没有介绍过,是通过对从事这些武器系统工作的美国国防专业人员的采访而获得的。其中包括领导陆军对2003年爱国者自相残杀事件进行事后评估的美国陆军工程心理学家和海军宙斯盾训练和准备中心的指挥官,该中心负责培训所有符合宙斯盾条件的军官和士兵。这些案例研究的结果对建立安全和可控的未来自主武器系统的可能性有直接影响。

6)分析了自主武器的作战价值和风险,这是一个迄今未被充分探索的领域(第六部分)。

7)提出了一个全面的数据集,其中包括40多个历史上试图禁止或以其他方式限制武器技术的尝试,可以追溯到古代印度(附录D)。这是迄今为止汇编的关于禁止武器的历史尝试的最全面的数据集。

8)提出了一个新的框架,说明试图禁止武器的成功的可能性(第七部分)。虽然其他学者以前提出过影响禁令成功可能性的标准,但本论文在现有工作的基础上,提出了一个新的、不同的框架101。此外,这个框架具有预测价值,可以通过观察未来武器禁令或现有禁令在未来条件下的成败来检验。

- 探讨了对自主武器的四种可能的监管方法,并根据历史上禁止武器的尝试,对其成功的可能性进行了可测试的预测(第七部分)。

本论文对该领域的贡献是:将现有理论应用于新的案例研究;提出具有新信息的新案例研究;以新的方式对数据进行汇编和分类(自主武器对稳定的影响,历史上的武器禁令);提出理解各种问题的新框架(自主性的性质,自主武器的操作价值和风险,武器禁令成功的可能性)。这些贡献有助于理解自主武器对稳定的影响。它们还更广泛地促进了对抗环境中的自动化、风险和危险的研究,以及对限制或约束武器的尝试的研究。这篇论文提出了关于复杂的自主系统在对抗环境中发生事故的可能性以及在某些条件下武器禁令可能成功的可测试的假设。

报告大纲和结论预览

本报告将按以下方式进行:

第一部分通过对历史上各种军事和非军事系统如何使用自主性的27个案例,来研究自主性和自主武器的性质。

第二部分探讨了全球各国正在开发的具有越来越高自主性的下一代武器系统和网络系统的25个案例研究。各国在新武器项目细节方面的透明度有很大差异,这影响了哪些案例可供研究。第二部分的结论是,总体趋势是自主性越来越强,虽然没有国家明确表现出开发自主武器的意图,但该技术将变得越来越容易获得。

第三部分研究了自主武器与稳定的交集,并制定了自主武器可能增加或减少稳定的九个机制。第三部分的结论是,自主武器最重要的稳定问题是其对非预期行为造成的危机稳定的影响。这些特征的净效应可能会破坏危机稳定、升级管理和战争终止。

第四部分通过超过25个军事和非军事系统的案例研究,评估了对自主武器的可预测性、可控制性和危险性的关注。这些包括在对抗环境中使用自主性和人工智能的案例研究。第四部分的结论是,由于各种原因,可预测性和可控性是复杂的、高度自动化的系统中的一个重要问题,这些风险在对抗性环境中会加剧。此外,第四部分指出,虽然在一些情况下,组织能够操作复杂、危险的系统而很少发生事故,但这些条件并不适用于完全自主武器的情况。

第五部分根据人工智能和机器学习的最新进展以及对未来类似人类的人工通用智能的假设进展来评估这些风险。第五部分的结论是,目前的机器学习形式加剧了事故风险,而不是减轻了事故风险,因为它们具有反直觉的非人类属性,容易受到欺骗性攻击、偏见和其他安全问题。如果有一天能够实现类似人类的人工通用智能,将减轻一些风险,但可能会引起一系列更严重的安全问题。

第六部分探讨了自主武器的军事行动价值和危险性,包括升级的途径。第六部分的结论是,虽然半自主和受监督的自主武器可能适合于大多数军事环境,但在某些情况下,完全自主的武器将是有价值的。第六部分还得出结论,意外升级的风险是真实存在的,高速意外互动("闪电战")的可能性在网络空间最为严重。

第七部分研究了风险缓解和军备控制的前景,包括之前40多次成功和不成功的管制其他武器的历史经验。第七部分的结论是,由于一些原因,全面禁止自主武器是不可能的,并概述了其他三种成功可能性较大的替代监管制度。