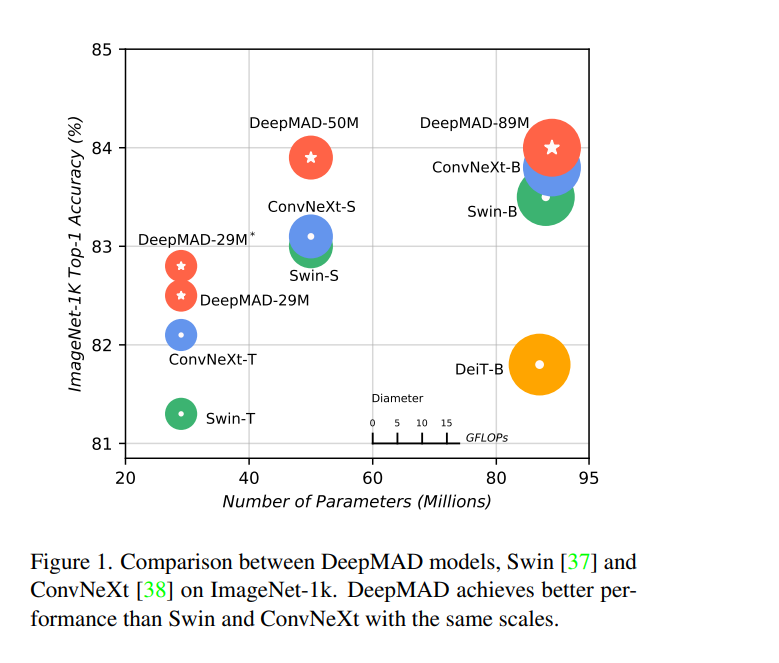

视觉Transformer (ViT)的快速发展刷新了各种视觉任务中的最先进性能,超过了传统的基于CNN的模型。这引发了最近在CNN世界中的一些反复性研究,表明在仔细调优时,纯CNN模型可以实现与ViT模型一样好的性能。虽然令人鼓舞,但设计这样高性能的CNN模型是具有挑战性的,需要网络设计的重要先验知识。为此,提出了一种新的框架DeepMAD,以原则性的方式设计高性能的CNN模型。在DeepMAD中,CNN网络被建模为一个信息处理系统,其表达能力和有效性可以通过其结构参数解析地表示。然后提出一个约束数学规划(MP)问题来优化这些结构参数。MP问题可以通过在内存占用较小的CPU上使用现成的MP求解器来轻松解决。此外,DeepMAD是一个纯数学框架:在网络设计期间不需要GPU或训练数据。在多个大规模计算机视觉基准数据集上验证了DeepMAD的优越性。值得注意的是,在ImageNet-1k上,仅使用传统的卷积层,DeepMAD在微小水平上比ConvNeXt和Swin的top-1精度高出0.7%和1.5%,在小水平上高出0.8%和0.9%。

https://www.zhuanzhi.ai/paper/171aff4ec046122c05ee31db5c8ded8a

成为VIP会员查看完整内容

相关内容

CVPR 2023大会将于 6 月 18 日至 22 日在温哥华会议中心举行。CVPR是IEEE Conference on Computer Vision and Pattern Recognition的缩写,即IEEE国际计算机视觉与模式识别会议。该会议是由IEEE举办的计算机视觉和模式识别领域的顶级会议,会议的主要内容是计算机视觉与模式识别技术。

CVPR 2023 共收到 9155 份提交,比去年增加了 12%,创下新纪录,今年接收了 2360 篇论文,接收率为 25.78%。作为对比,去年有 8100 多篇有效投稿,大会接收了 2067 篇,接收率为 25%。

Arxiv

0+阅读 · 2023年5月2日

Arxiv

0+阅读 · 2023年4月30日