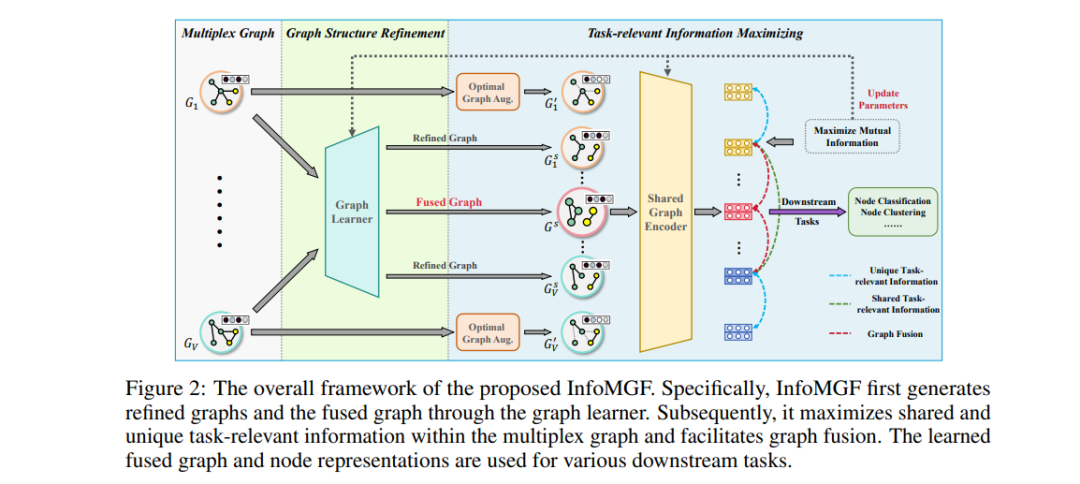

无监督多重图学习 (UMGL) 旨在通过各种边类型学习节点表示,而无需手动标注。然而,现有研究忽略了一个关键因素:图结构的可靠性。现实世界的数据通常表现出复杂的特性,并且包含大量与任务无关的噪声,严重影响了 UMGL 的性能。此外,现有方法主要依赖于对比学习来最大化不同图之间的互信息,这使得它们仅限于处理多重图的冗余场景,未能捕捉到视图特有的任务相关信息。在本文中,我们专注于一个更具现实性和挑战性的任务:无监督地从多个图中学习一个融合图,该图能够保留足够的任务相关信息,同时去除任务无关的噪声。具体而言,我们提出的信息感知无监督多重图融合框架 (InfoMGF) 使用图结构优化来消除无关噪声,同时最大化视图共享和视图特有的任务相关信息,从而应对非冗余多重图的前沿问题。理论分析进一步保证了 InfoMGF 的有效性。在不同下游任务上与多种基线方法的综合实验表明了其优越的性能和鲁棒性。令人惊讶的是,我们的无监督方法甚至超过了复杂的监督方法。源码和数据集可在 https://github.com/zxlearningdeep/InfoMGF 获取。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

223+阅读 · 2023年4月7日