链接:https://github.com/YuanchenBei/Awesome-Cold-Start-Recommendation。

1 引言

在数字信息时代迅速发展的背景下,推荐系统(RecSys)已成为帮助用户在信息过载和选择繁多的情况下发现相关内容和物品的不可或缺的工具【14, 220, 255】。尽管推荐系统被广泛部署,但仍面临持续的挑战,特别是在“冷启动”场景中,即新用户或物品没有历史交互数据可用的情况下。具体来说,在现实场景中,冷启动问题可能表现为新物品的引入、新用户的加入,或者新平台本身就存在稀疏的交互数据。解决冷启动问题不仅对性能指标至关重要,而且对推进推荐系统的有效性和可持续性也具有关键作用。首先,解决这个问题确保新用户和物品得到公平的推荐,减轻依赖历史数据所带来的偏差。这种改进促进了推荐的多样性和公平性,通过防止新物品被忽视,促进了多样化内容的曝光【114, 288】。此外,解决冷启动挑战还带来了平台品牌价值和用户留存。在竞争激烈、快速发展的数字化环境中,为新用户提供即时且相关的推荐能够使平台从竞争对手中脱颖而出。个性化的推荐从一开始就帮助吸引新用户,避免了由于推荐内容不相关或缺失而导致的用户流失,从而留下了强烈的初始印象,培养了忠诚度。对于平台而言,这意味着更高的参与度、更好的留存率以及在动态市场中的成功。最后,能够有效应对冷启动场景也确保了平台的可扩展性和增长。随着平台用户和内容的不断增加,能够有效整合这些新实体的持续涌入,使推荐引擎保持动态和相关性,这种适应性支持了在快速变化环境中的长期可持续性。基于这些动机,冷启动问题推动了利用多种外部知识源的创新方法探索。通过整合超越传统用户-物品交互的数据,如内容特征【183】、社交信息【36】或预训练的大语言模型知识【122】,这些方法丰富了冷启动实体的表示和建模,使推荐系统在数据稀疏的情况下依然能够有效运作。因此,解决冷启动问题不仅仅是一个技术挑战,更是构建公平、吸引人和可持续的推荐平台的战略必要性。

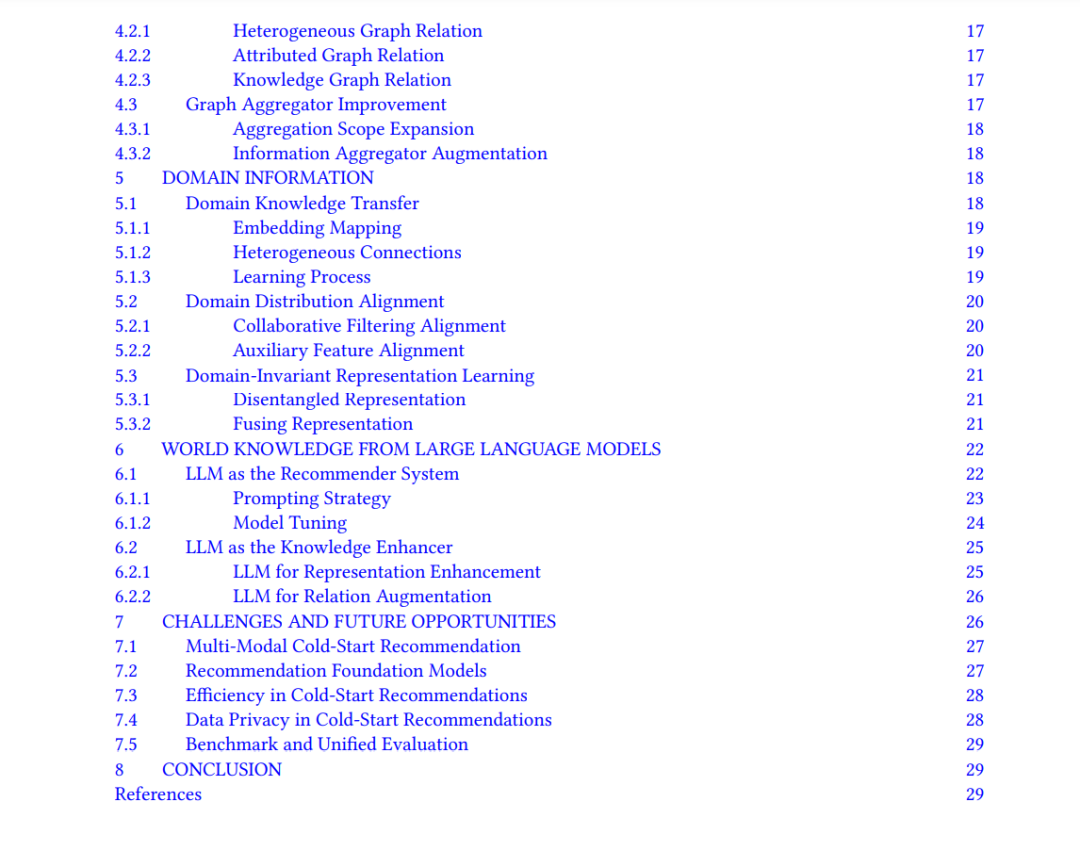

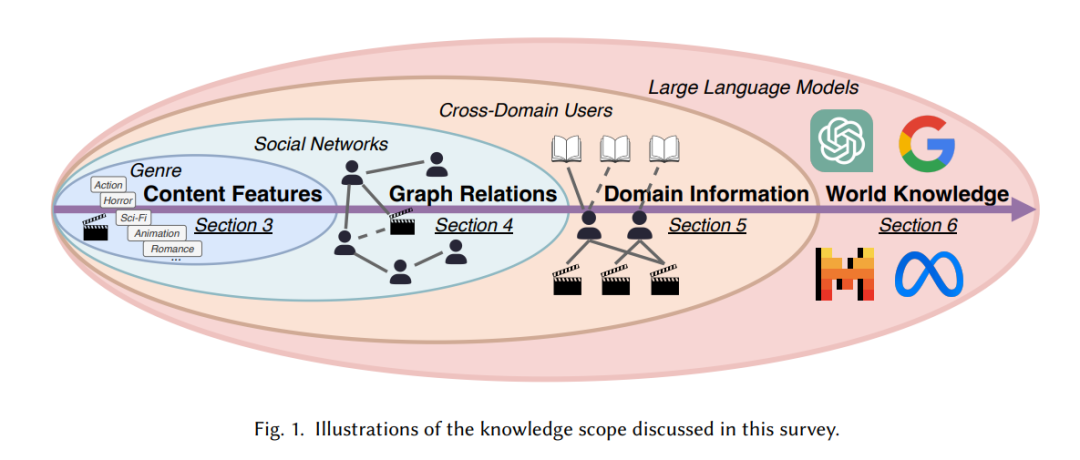

早期的冷启动尝试采用基于内容的方法【133, 181】,重点关注分类文本特征,如物品类别、物品标题和用户资料,这些对冷启动实体的表示起着至关重要的作用。随后,随着图挖掘技术的进步【101, 225, 231】,从图结构中派生出的高阶关系,如用户-物品交互图【24, 64, 257, 258】、知识图谱【21, 203】和社交网络【165, 239】成为增强冷启动推荐的关键组成部分。与此同时,有研究者开始转向不同领域之间的关系,而非挖掘图中节点之间的关系【92, 249】。特别是,目标领域中的冷启动和数据稀疏问题可以通过从其他交互数据更丰富的领域迁移知识来缓解。跨领域推荐技术利用重叠的用户基础、共享的属性或对齐的物品类别,提升冷启动推荐的表现。近年来,大语言模型(LLMs)的兴起,如GPT【3】、LLaMa【39】和T5【157】彻底革新了自然语言处理,展示了在理解和生成类人文本方面的卓越能力,这些能力基于大量的预训练数据【107, 142】。这些进展促使推荐系统研究出现了范式转变,借助大语言模型的全面上下文理解来提升冷启动推荐的表现。通过利用大语言模型的预训练世界知识,研究人员开始探索为冷启动用户和物品建模和表示的新策略,以更加语义丰富和上下文感知的方式。图2a展示了这一发展趋势,突出了冷启动推荐研究从传统的基于内容的方法转向以LLMs为驱动的策略,并逐步扩展知识范围(如图1所示)。

本文旨在提供对冷启动推荐领域最前沿技术和框架的全面综述,特别关注大语言模型时代下知识范围扩展的方向,如图1所示。本文特别关注发表在顶级会议和期刊中的相关工作,如图2b所示。基于这些工作,我们将现有研究按照外部知识源的规模分为四个知识范围:内容特征、图谱关系、领域信息和大语言模型的世界知识。通过系统地分类和分析这些方法,本文综述旨在呈现对冷启动推荐领域的全面理解,并提出未来研究的路线图。我们强调将大语言模型整合到冷启动推荐中的变革潜力,并概述了这一新兴领域未来可能面临的机遇和挑战。

1.1 相关工作

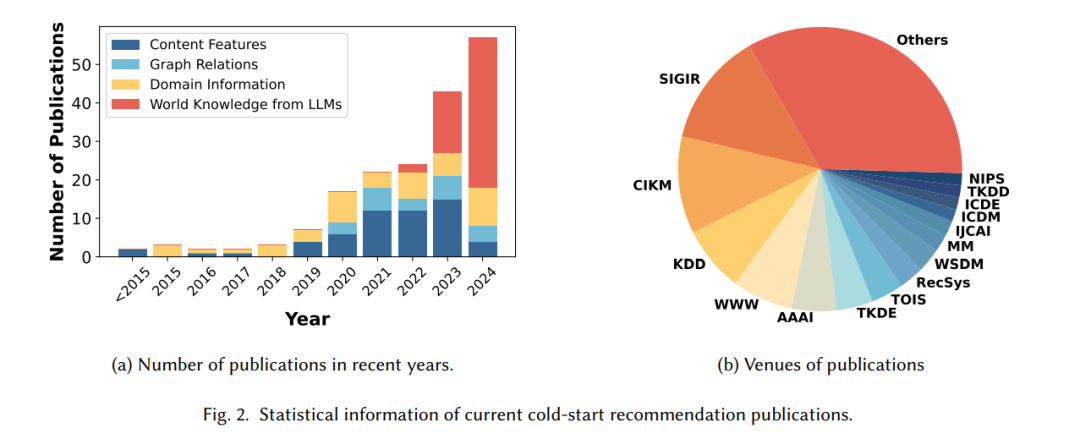

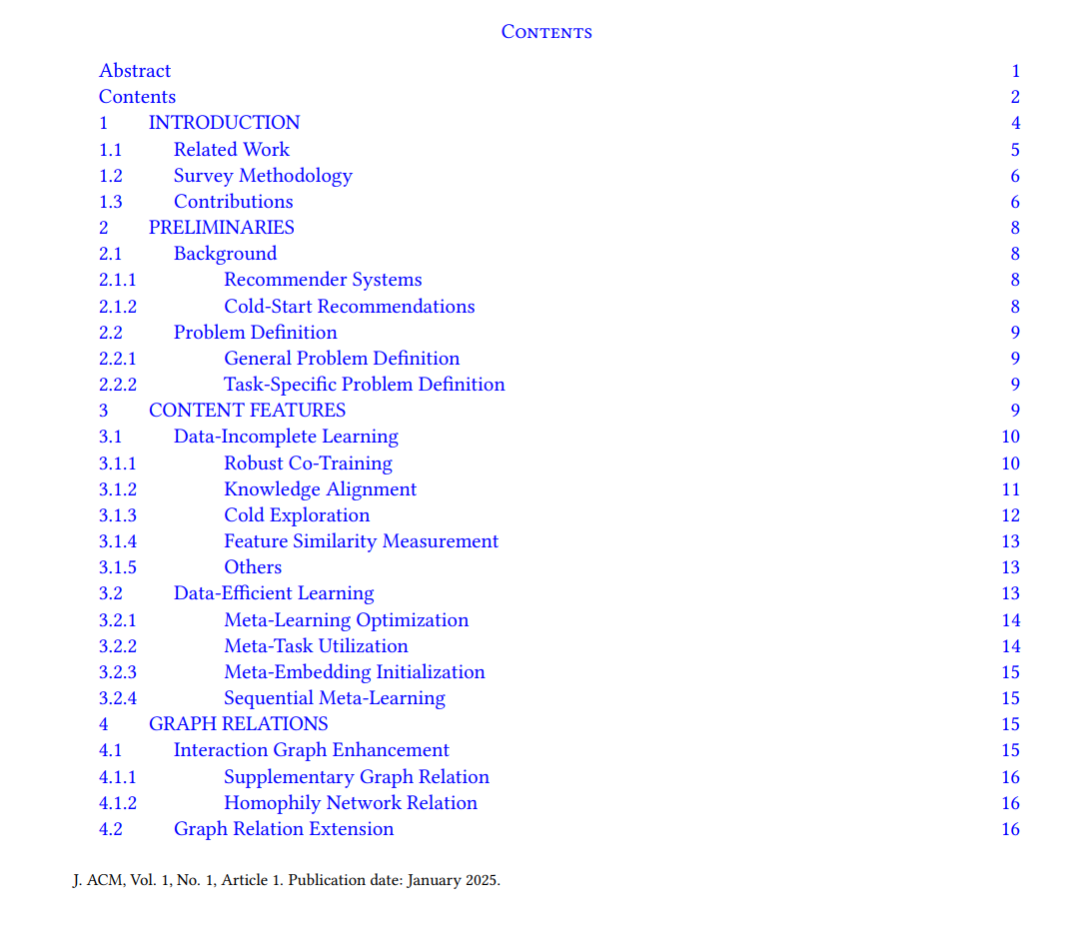

表1展示了我们综述与之前综述之间的比较。现有的所有综述仅关注冷启动推荐问题的部分知识范围或有限方面。最早的综述【51】和【17】部分覆盖了单一知识范围,但没有明确界定具体的冷启动问题。随后,IDCTIT【163】和《Applied Sciences》【1】等的综述开始结合图谱关系和领域信息,并首次明确界定了系统冷启动和用户冷启动问题,涵盖了2021年前相关文献。更近的综述,如《JIIS》【152】和《IEEE Access》【246】扩大了覆盖的范围和文献数量,特别是【246】重点关注用户冷启动问题。总体来说,现有文献中没有任何一篇综述全面覆盖所有四个方面(特征、图谱、领域和LLMs),并同时处理多个冷启动问题。在本文中,我们旨在填补这一空白,提供一篇全面且系统的综述,涵盖220篇文献,明确界定9个不同的冷启动问题,并结合特征、图谱、领域和LLMs的知识范围进行分析。

1.2 综述方法

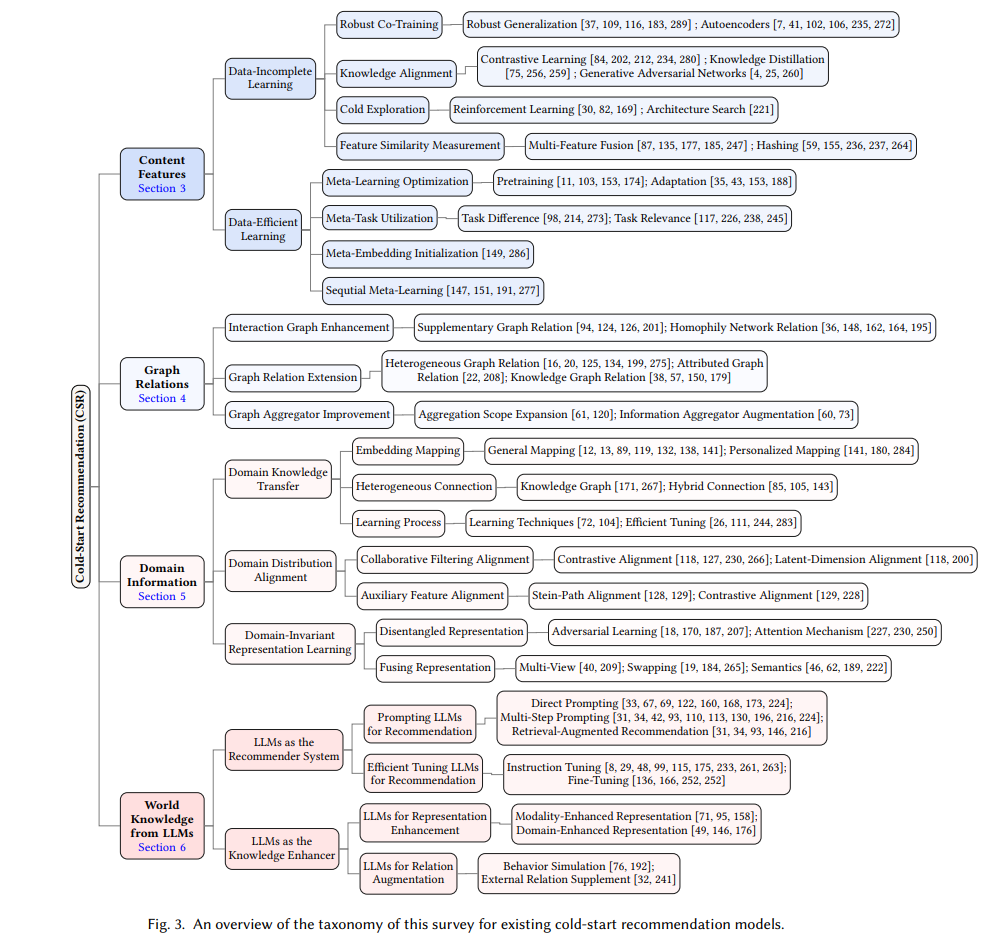

为了全面涵盖冷启动推荐的文献,我们采用了半系统化的综述方法来识别相关论文。首先,我们通过预定义的搜索关键词,如“冷启动推荐”、“冷启动推荐系统”、“严格冷启动”、“零样本推荐”和“少样本推荐”,查询了主要学术数据库,如Google Scholar和Web of Science。此外,我们还筛选了包括KDD、WWW、SIGIR、CIKM、WSDM和RecSys在内的专业会议论文集。通过分析标题、摘要和实验结果来过滤搜索结果,以评估其相关性。然后,对相关文献进行了进一步的详细审阅,并使用引用链方法(snowballing)找出了更多相关论文。最终,我们根据贡献将收集到的文献分为四个核心领域,分别为内容特征、图谱关系、领域信息和大语言模型的世界知识,如图3所示。这些文献大多数描述了技术方法或提出了新的框架,少部分提供了系统演示或对冷启动推荐方法的分析视角。

1.3 贡献

- 开创性的全面综述:我们提出了首个关于冷启动推荐方法的全面综述,系统地识别了来自不同冷启动推荐任务和知识源的研究。我们的综述详细分析了相关文献,考察了它们的动机、数据需求和技术方法,并提供了领先会议(如SIGIR、CIKM、KDD)和期刊(如TKDE、TOIS)中的研究出版物的时间线和统计概述,如图2所示。

- 创新的分类法引入:我们提出了一种新的分类法,提供了一个独特的视角来解决冷启动挑战——利用外部知识源来应对数据稀缺和新实体的交互不足。我们的分类法将知识源区分开来,超越传统方法,向更广泛的冷启动问题解决方案扩展。

- 冷启动问题的明确定义:根据我们的知识,本文是首篇在多个维度上清晰、全面地定义冷启动问题的论文,包括长尾冷启动、用户冷启动、物品冷启动、用户-物品冷启动、零样本和少样本以及严格冷启动问题。这个定义为冷启动领域的多样化研究提供了结构化的理解和统一框架。

- 前瞻性的研究路线图:基于我们的全面综述和创新的分类法,我们提出了一个前瞻性的研究路线图,连接当前在冷启动推荐中的进展和未来研究方向。这个路线图旨在为研究社区提供指导,提供推进这一挑战性领域知识的洞察和结构化路径。

2. 冷启动推荐

在推荐系统的上述背景下,我们可以发现,当前推荐模型的核心是通过不同的技术策略挖掘用户-物品相似性。然而,随着互联网的快速发展,推荐系统面临的一个重大挑战是冷启动推荐(CSR),即如何为每天不断加入互联网的新用户和新物品提供准确的推荐【51, 75, 124】。冷启动推荐的主要难点在于,新用户和新物品往往缺乏或完全没有可用的信息。在这种情况下,系统难以基于极其稀疏的信息对用户与物品的相似性进行建模。因此,冷启动推荐已成为推荐系统研究领域长期存在的难题。

本综述将系统性地回顾现有的冷启动推荐方法,从第2.2节对不同冷启动问题的详细定义开始,到第3节至第6节逐步展开对现有冷启动推荐模型的分类与讨论,涵盖的知识范围包括内容特征、图关系、领域信息及世界知识。

3 内容特征

内容特征主要指的是用户或物品固有的描述性信息,用以表征其属性,如用户个人资料、用户评价、物品名称和描述【2, 63, 78, 292】。由于冷启动用户/物品缺乏历史交互记录,内容特征成为冷启动推荐中代表冷用户/物品的关键数据之一【59, 181】。基于内容特征的利用方式,我们将方法分为两类:数据不完整学习(第3.1节),它解决了没有历史交互的严格冷启动场景;以及数据高效学习(第3.2节),它优化了在有有限交互数据的普通冷启动场景中的性能。

4 图关系

图关系提供了高阶信息,而不仅仅是用户/物品本身的内容特征。利用图关系知识能够将邻域中的信息传播到特定的用户或物品。然而,该领域的关键挑战在于如何为冷启动用户/物品提供图信息,因为缺乏历史交互数据。首先,这里简要介绍一下图神经网络(GNNs),它们在本节被广泛用于图关系推理: 近年来,图神经网络(Graph Neural Networks, GNNs)受到了极大的关注,并在许多图挖掘任务中展示了最前沿的性能,如节点分类【9, 55, 100】、链接预测【223, 248, 254】和图分类【210, 211, 229】等。GNNs通常采用消息传递(message-passing)范式,通过聚合邻域信息来更新每个中心节点的嵌入表示。作为链接预测任务的一部分,推荐系统近年来涌现出大量基于GNN的推荐模型,并取得了显著的推荐效果【64, 204, 232】。基于GNN的推荐模型主要利用GNN强大的消息传递机制,在图结构中建模用户-物品交互,从而更好地理解用户偏好和物品相关性,并利用高阶信息实现更有效的推荐【24, 165, 220】。

5 域信息

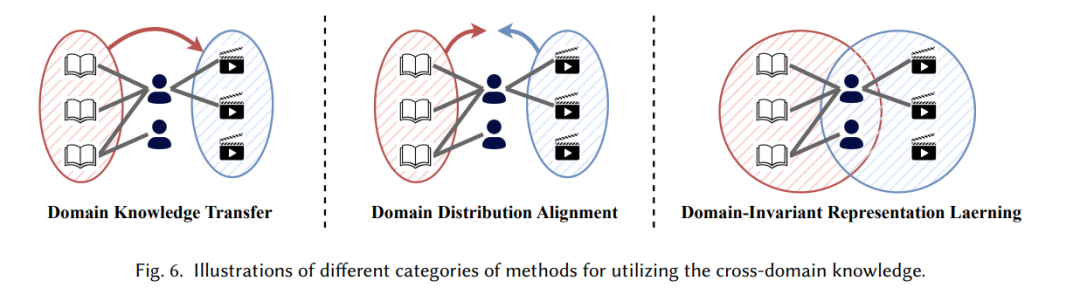

在现实世界的在线应用中,只有少数平台能够实现显著的用户参与,而许多其他平台则面临持续的长尾问题和用户冷启动问题。因此,跨域迁移学习【213, 290】提供了一个有前景的解决方案,通过利用源域中丰富的数据知识来增强目标域中信息有限的推荐性能。与传统的冷启动推荐系统不同,跨域推荐方法本质上更为复杂。它们必须考虑来自至少两个不同系统的知识,而这些系统之间通常存在显著差异。这些方法通常需要跨域环境中有重叠的用户,并且需要有效的策略来利用这些用户共享域知识。根据利用域知识的高层次方法,我们将现有的研究工作分为三类:域知识迁移(第5.1节)、域分布对齐(第5.2节)和域不变表示学习(第5.3节),如图6所示。

6 来自大语言模型的世界知识

大语言模型(LLMs)是通过深度学习技术训练的生成型人工智能系统,旨在通过学习大量文本语料数据来理解一般的世界知识。这些模型能够生成文本、回答问题、进行翻译,甚至参与复杂的对话【271, 287】。由于近年来取得的巨大成功,越来越多的领域开始利用大语言模型的能力来完成各种任务,如多模态学习【217】、图学习【159】和推荐系统【219】,并取得了显著成果。由于大语言模型强大的文本特征处理能力,冷启动,尤其是零样本和少样本场景,已成为大语言模型在推荐领域中的一个重要应用。根据大语言模型所扮演的角色,我们将现有的研究工作分为两个主要方面:大语言模型作为推荐系统(第6.1节)和大语言模型作为知识增强器(第6.2节)。

结论

在本文中,我们对冷启动推荐进行了全面的综述,并提出了一条从内容特征、图关系、领域信息到大语言模型世界知识的研究路线图。具体而言,我们首先正式定义了冷启动推荐领域的不同研究问题,然后系统性地回顾了冷启动推荐的研究进展。在每个部分中,我们不仅总结了相关研究背后的核心洞见,还列举了一些代表性工作,以帮助读者更好地理解。此外,我们重新审视了冷启动推荐的一些关键挑战,并总结了一些有意义的未来研究方向。相关资源已整理至Github:https://github.com/YuanchenBei/Awesome-Cold-Start-Recommendation),供研究社区参考。