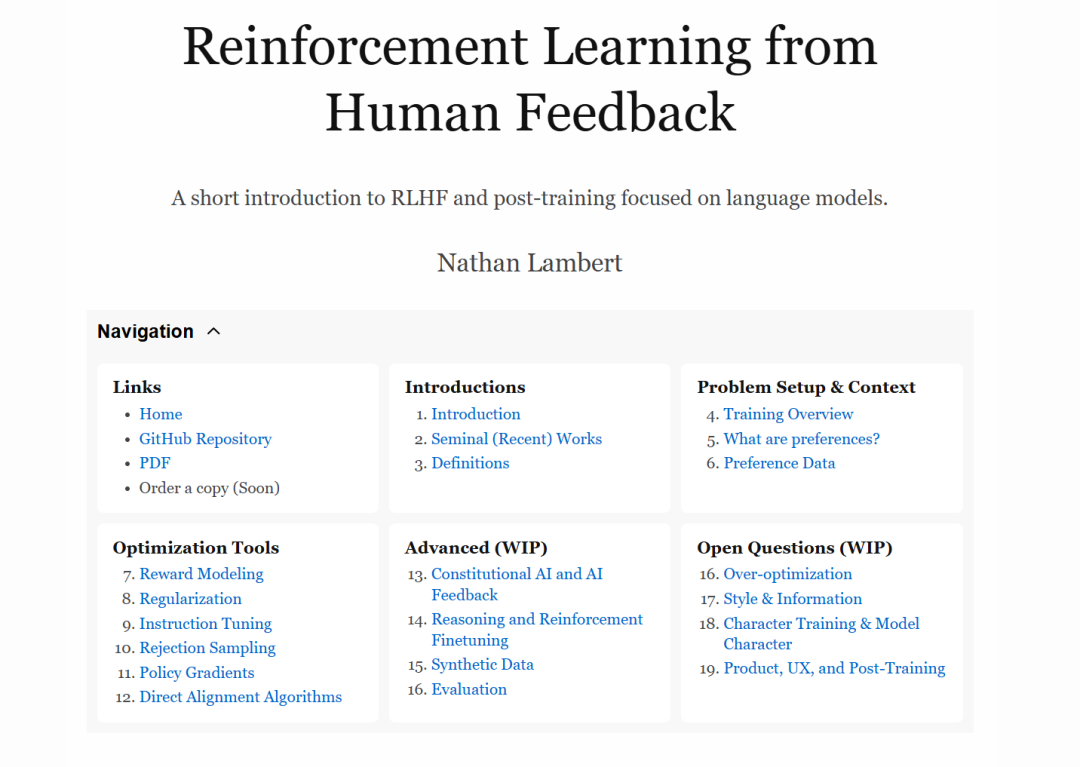

来自人类反馈的强化学习(RLHF) 已成为部署最新机器学习系统的重要技术手段和叙事工具。 在本书中,我们希望为具备一定数量背景的读者提供对核心方法的温和入门。 本书从 RLHF 的起源讲起——既包括近年来的相关文献,也包括经济学、哲学与最优控制等多个学科的交汇与融合。 随后,我们通过定义、问题建模、数据收集以及文献中常见的数学工具,为读者搭建理解基础。 我们将详细介绍当前主流的算法,并探讨 RLHF 的未来前沿方向。 来自人类反馈的强化学习(Reinforcement Learning from Human Feedback, RLHF)是一种将人类信息融入人工智能系统的技术。RLHF 最初作为一种解决难以明确定义问题的方法而出现。它的早期应用多见于控制问题以及强化学习(RL)传统领域中。RLHF 因 ChatGPT 的发布以及随后大型语言模型(LLMs)和其他基础模型的迅猛发展而广为人知。 RLHF 的基本流程包括三个步骤: 首先,需要训练一个能够理解并响应用户提问的语言模型(详见第9章); 其次,需要收集人类偏好数据,以用于训练反映人类偏好的奖励模型(详见第7章); 最后,使用选定的强化学习优化器,通过采样生成内容并根据奖励模型评分,来优化语言模型(详见第3章与第11章)。 本书将详细介绍这一流程中关键的决策点以及基础的实现示例。 随着技术的成熟,RLHF 已被成功应用于多个领域,任务复杂性也随之提升。RLHF 的早期突破性实验涵盖了深度强化学习 [1]、文本摘要 [2]、指令跟随 [3]、网页信息解析与问答 [4] 以及“对齐”任务 [5]。图1展示了早期 RLHF 方法的概览。 在现代语言模型的训练中,RLHF 通常是后训练(post-training)的一部分。后训练是一套更完整的方法与最佳实践,旨在提升语言模型在下游任务中的实用性 [6]。后训练主要包括以下三种优化方法: 1. 指令/监督微调(IFT/SFT):教授模型如何理解格式和基本的指令跟随能力,主要关注语言中的特征学习。 1. 偏好微调(PreFT):使模型更符合人类偏好,同时也略微提升模型的能力,主要涉及语言风格和难以量化的细微人类偏好。 1. 强化微调(RFT):最新的一类后训练方法,提升模型在可验证任务中的表现。

本书聚焦于第二部分——偏好微调。相较于指令微调,其复杂度更高;而相比于强化微调,其发展更为成熟。尽管如此,RLHF 这个术语在日常语境中已逐渐涵盖了整个后训练过程。自 ChatGPT 发布后,RLHF 就被广义地用于描述所有后训练技术。而 RLHF 的基础远不止人类偏好,本书将对所有相关主题做出介绍。