拥有解耦表征的无监督学习是不可能的!硬核ICML 2019最佳论文出炉

机器之心报道

机器之心编辑部

机器学习顶级会议ICML 2019(国际机器学习大会)已于6月9日在美国加州开幕。本届大会共收到3424篇论文投稿,其中774篇被接收(接收率为22.6%)。今日,大会放出了最佳论文。

今年有两支团队收获了最佳论文的奖项,来自剑桥大学、科技公司 PROWLER.io 的《Rates of Convergence for Sparse Variational Gaussian Process Regression》与苏黎世联邦理工学院(ETH)、德国马普所、谷歌大脑共同完成的《Challenging Common Assumptions in the Unsupervised Learning of Disentangled Representations》获得了殊荣。

值得关注的是,ETH Zurich、谷歌大脑等机构的论文《挑战无监督学习中解耦表征的一般假设》提出了一个与此前学界普遍预测相反的看法:对于任意数据,拥有相互独立表征(解耦表征)的无监督学习是不可能的!在大会上,获奖论文的部分作者也现场进行了演讲。

论文作者表示,根据这些理论,对于机器学习从业者来说,我们对于超参数的选择是没有经验法则可言的,而在已有大量已训练模型的情况下,无监督的模型选择仍然是一个很大的挑战。

谷歌还在一篇博客中表示,研究人员已对近期流行的 12,000 个无监督学习模型进行了评估,并发布了论文代码及其中 10,000 个模型的解耦合预训练模型,以便研究人员复现其成果。

项目链接:https://github.com/google-research/disentanglement_lib

最佳论文奖项

最佳论文 1:Challenging Common Assumptions in the Unsupervised Learning of Disentangled Representations

作者:Francesco Locatello、Stefan Bauer、Mario Lucic、Gunnar Rätsch、Sylvain Gelly、Bernhard Schölkopf、Olivier Bachem(苏黎世联邦理工学院、德国马普所、谷歌大脑)

论文地址:https://arxiv.org/abs/1811.12359

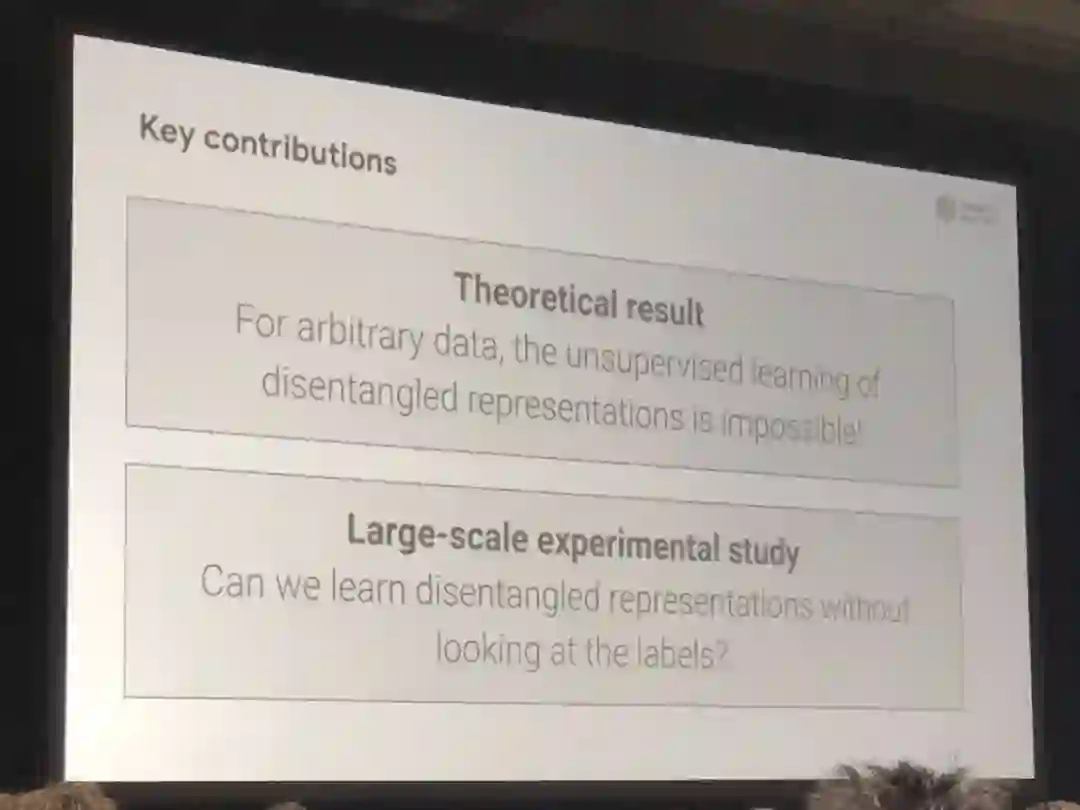

无监督学习解耦表征(disentangled representation)背后的关键思想是,真实数据是由一些变化的可解释因素生成的,这些因素可以通过无监督学习算法恢复。在本文中,我们冷静地审视了该领域的最新进展,并对一些常见的假设提出了质疑。

首先,我们从理论上证明,如果不对模型和数据进行归纳偏置,无监督学习解耦表征基本是不可能的。然后,我们在 7 个不同数据集进行了可复现的大规模实验,我们训练了 12000 多个模型,包括一些主流方法和评估指标。

实验结果表明,虽然不同的方法强制执行了相应损失「鼓励」的属性,但如果没有监督,似乎无法识别完全解耦的模型。此外,增加的解耦似乎不会导致下游任务学习的样本复杂度的下降。

该研究结果表明,未来关于解耦合式学习的工作应该明确归纳偏置和(隐式)监督的作用,研究强制解耦习得表征的具体效益,并考虑涵盖多个数据集的可复现实验设置。

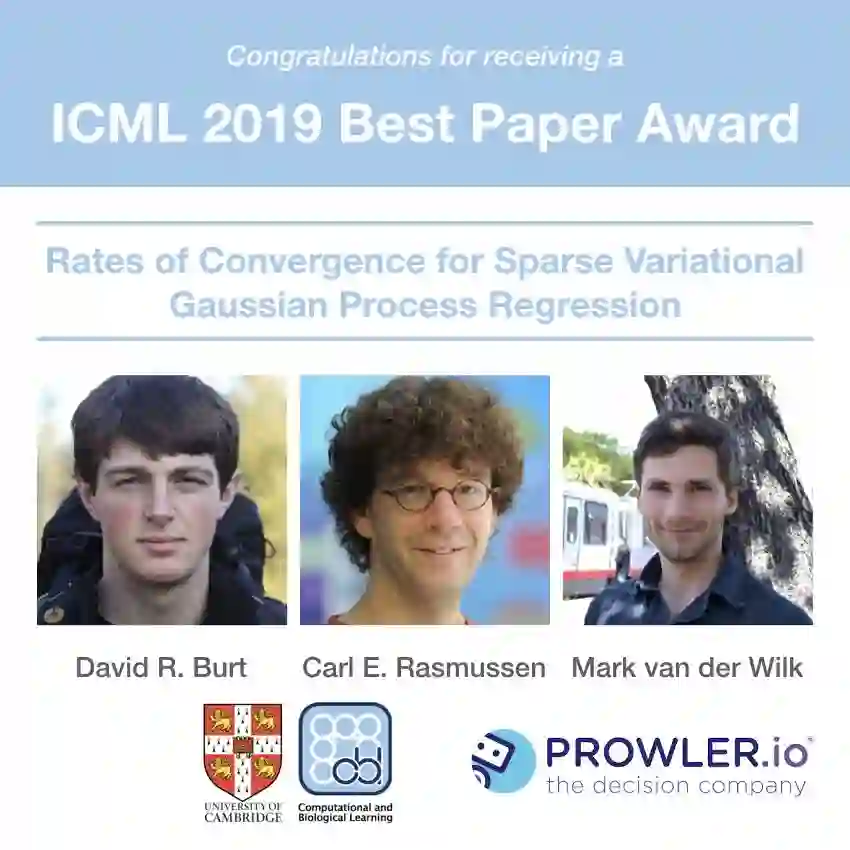

最佳论文 2:Rates of Convergence for Sparse Variational Gaussian Process Regression

作者:David R. Burt、Carl E. Rasmussen、Mark van der Wilk(剑桥大学、PROWLER.io 公司)

论文地址:https://arxiv.org/abs/1903.03571

目前已有用于高斯过程后验的极好变分近似方法,它们避免了数据集大小为 N 的 O(N^3) 缩放。这些变分近似将计算成本降至 O(NM^2),其中 M≪N 是归纳变量的数量,它概括了过程。

虽然计算成本在 N 中似乎是线性的,但该算法的真正复杂性取决于如何增加 M 以确保一定的近似质量。研究者描述了 KL 向后发散上限的行为,进而解决这个问题。研究表明,通过比 N 更慢地增长 M,KL 发散度很可能任意地变小。

一个非常有趣的例子是,对于具有常用平方指数核(Squared Exponential kernel)的 D 维正态分布输入的回归,M=O(log^DN) 就足够了。研究结果表明,随着数据集的增加,高斯过程后验能够以较小的代价真正地近似,并为在持续学习场景下如何增加 M 提供了具体的规则。

Test of time award

大会还公布了 Test of time award,获得此奖项的是《Online Dictionary Learning for Sparse Coding》,这篇论文发表于 2009 年,作者为 Julien Mairal、Francis Bach、Jean Ponce、Guillermo Sapiro。

论文链接:https://apps.dtic.mil/dtic/tr/fulltext/u2/a513243.pdf

稀疏编码,即将数据向量建模为基本元素的稀疏线性组合,被广泛用于机器学习、神经科学、信号处理和统计领域。本文着重于学习基础集,也就是字典,以使其适应特定数据。这种方法最近被证明对音频和图像处理领域的信号重建和分类非常有效。

基于随机近似,本文提出了一种新的在线字典学习优化算法,该算法可以优雅地扩展到具有数百万个训练样本的大型数据集。本文包括收敛性证明,以及在自然图像上的实验,结果表明与小型和大型数据集的经典批处理算法相比,本文提出的算法可以带来更快的性能和更好的字典。

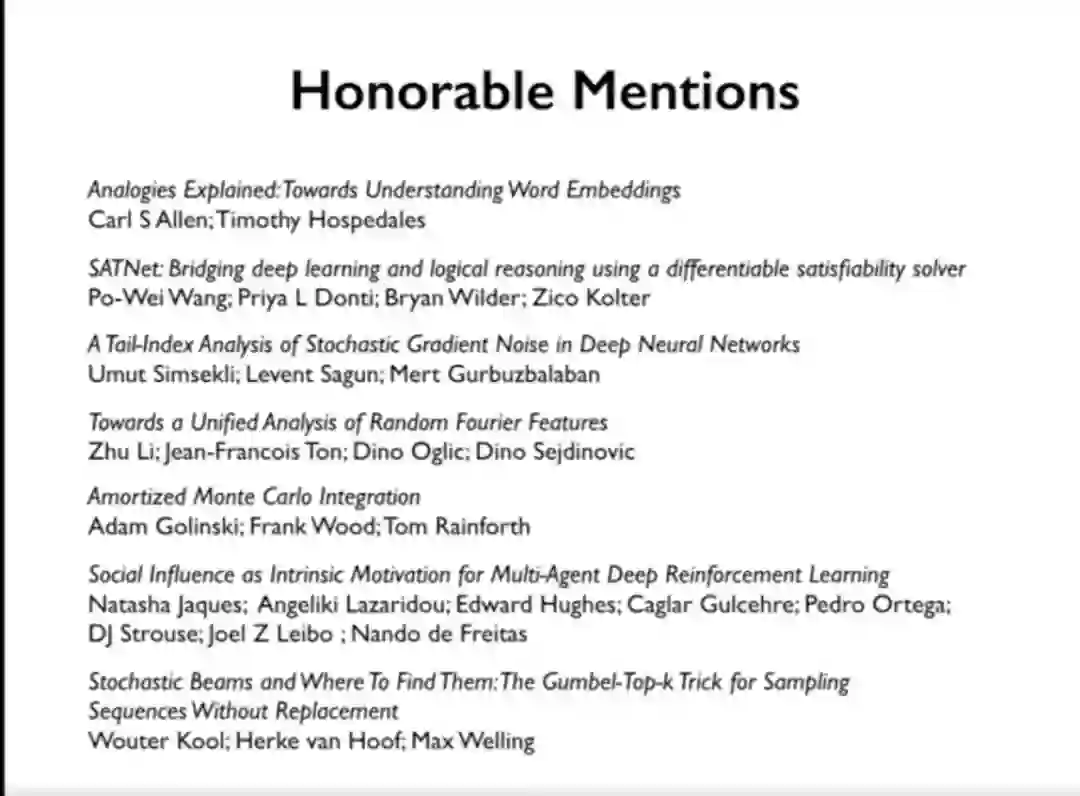

7 篇最佳论文提名奖

除了最佳论文与 Test of time Award 奖项,大会官方还公布了 7 篇最佳论文荣誉提名论文,分别为:

1. Analogies Explained: Towards Understanding Word Embeddings

作者:CarlAllen、Timothy Hospedales(爱丁堡大学)

论文地址:https://arxiv.org/pdf/1901.09813.pdf

2. SATNet: Bridging deep learning and logical reasoning using a differentiable satisfiability solver

作者:Po-WeiWang、Priya L. Donti、Bryan Wilder、Zico Kolter(CMU、美国南加州大学、博世人工智能研究中心)

论文地址:https://arxiv.org/pdf/1905.12149.pdf

3. A Tail-Index Analysis of Stochastic Gradient Noise in Deep Neural Networks

作者:Umut Şimşekli、L, event Sagun、Mert Gürbüzbalaban(法国巴黎-萨克雷大学、瑞士洛桑联邦理工学院、罗格斯商学院)

论文地址:https://arxiv.org/pdf/1901.06053.pdf

4. Towards A Unified Analysis of Random Fourier Features

作者:Zhu Li,Jean-François Ton,Dino Oglic,Dino Sejdinovic(牛津大学、伦敦国王学院)

论文地址:https://arxiv.org/pdf/1806.09178.pdf

5. Amortized Monte Carlo Integration

作者:Adam Golinski、Yee Whye Teh、Frank Wood、Tom Rainforth(牛津大学、英属哥伦比亚大学)

论文地址:http://www.gatsby.ucl.ac.uk/~balaji/udl-camera-ready/UDL-12.pdf

6. Social Influence as Intrinsic Motivation for Multi-Agent Deep Reinforcement Learning

作者:Natasha Jaques、Angeliki Lazaridou、Edward Hughes、Caglar Gulcehre、Pedro A. Ortega、DJ Strouse、Joel Z. Leibo、Nando de Freitas(MIT、DeepMind、普林斯顿高等研究院)

论文地址:https://arxiv.org/pdf/1810.08647.pdf

7. Stochastic Beams and Where to Find Them: The Gumbel-Top-k Trick for Sampling Sequences Without Replacement

作者:Wouter Kool、Herke van Hoof、Max Welling(阿姆斯特丹大学、荷兰 ORTEC、加拿大 CIFAR)

论文地址:https://arxiv.org/pdf/1903.06059.pdf

更多关于论文的录取结果,可以访问以下地址:

https://icml.cc/Conferences/2019/Schedule

ICML 2019 新变化

在公布了以上获奖内容之后,ICML 程序主席之一 Ruslan Salakhutdinov 介绍了此届 ICML 的两个新变化:高风险高奖励论文;提交代码。

我们知道,如果很多论文存在灌水的现象,而一些具有全新创造性的新论文或者新方向的论文可能在评审过程中就会被拒。

所以 ICML 2019 为这样的论文设计了 High Risk High Reward 特殊类别,也就是 5% 的接收论文属于高风险高奖励论文。

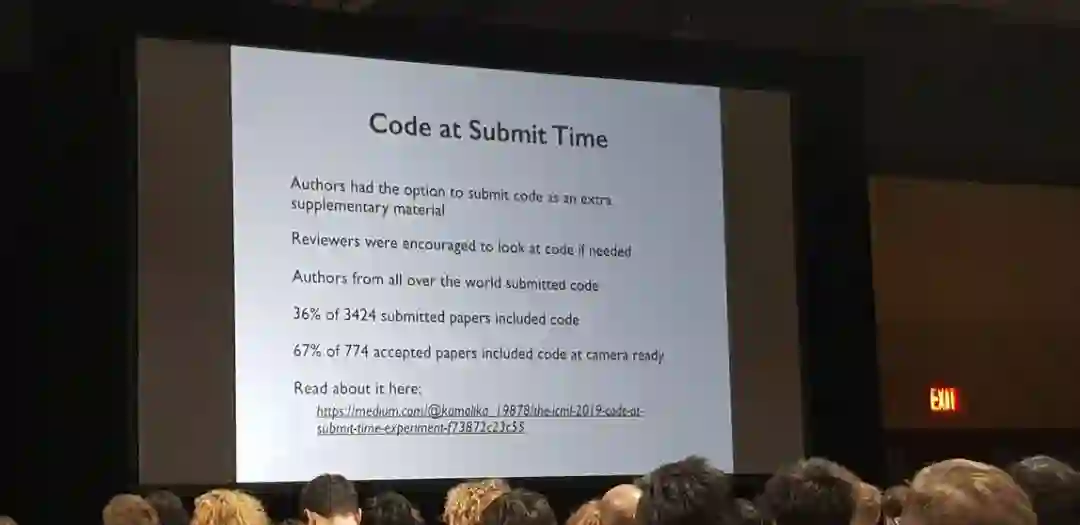

此外,ICML 2019 还公布了代码提交情况。

ICML 大会今年做出的一项重要改变是:为了促进可复现性,委员会鼓励提交的论文附带代码。根据大会公布的数据,首次出现的政策收获了不错的效果,在 3424 篇投稿中有 36% 的论文提交了代码,而在 774 篇接收论文中有 67% 的论文附带代码。

如此高的比例,看来明年的投稿论文作者需要认真考虑附加代码了。

市北·GMIS 2019全球数据智能峰会于7月19日-20日在上海市静安区举行。本次峰会以「数据智能」为主题,聚焦最前沿研究方向,同时更加关注数据智能经济及其产业生态的发展情况,为技术从研究走向落地提供借鉴。

本次峰会设置主旨演讲、主题演讲、AI画展、「AI00」数据智能榜单发布、闭门晚宴等环节,已确认出席嘉宾如下:

大会早鸟票已开售,我们也为广大学生用户准备了最高优惠的学生票,点击阅读原文即刻报名。