机器之心分析师网络 作者:Jiying 编辑:H4O

由于数据隐私限制,多个中心之间的数据共享受到限制,这就影响了联邦学习架构下多中心合作开发高性能深度学习模型的效果。持续学习(Continual Learning)作为点对点联合学习的一种方法,可以通过共享中间模型而不是训练数据来绕过数据隐私的限制,从而促进多中心协作开发深度学习算法。近期不断有研究人员探索联邦持续学习方法(Federated Continual Learning,FCL),即,研究持续学习在联邦学习架构下多中心协作的可行性。

1、背景回顾

1.1 持续学习 (Continual Learning)

首先,我们来回顾一下什么是持续学习。当前,一般认为持续学习 (Continual Learning) 和增量学习(Incremental Learning)、终身学习 (Lifelong Learning) 是等价表述,它们都是在连续的数据流中训练模型,随着时间的推移,更多的数据逐渐可用,同时旧数据可能由于存储限制或隐私保护等原因而逐渐不可用,并且学习任务的类型和数量没有预定义 (例如分类任务中的类别数)。

当一个模型在新的数据集或任务上被重新训练时,深度学习会遇到灾难性遗忘的问题,即深度学习模型会灾难性地遗忘已经学到的旧知识。持续学习技术的目的是让机器学习模型通过新的数据进行更新,同时保留以前学到的知识。持续学习具有两大优点:1) 不需要保存之前任务上学习过的训练数据,从而在节约内存的同时解决了由于物理设备 (例如机器内存 ) 或学习策略 (例如隐私保护 ) 的限制所导致的数据不能被长期存储问题;2) 模型能够保存之前任务所学到的知识,并且能够极大程度地将之前任务学习到的知识运用到未来任务的学习中,从而提高学习效率。

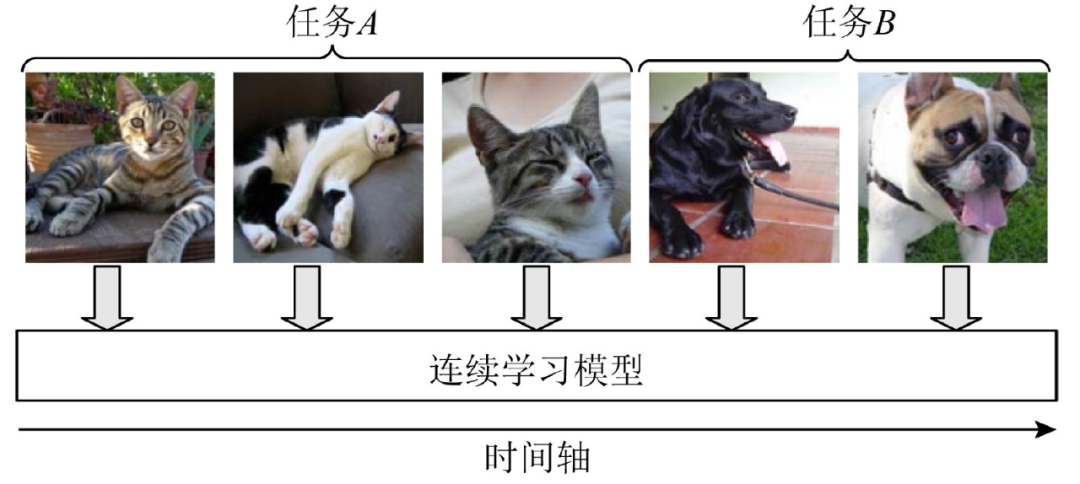

目前,持续学习的方法仍在不断发展中,还没有严格的数学定义。韩等在文章 [1] 中给出了一幅持续学习的示意图,如图 1 所示,“在连续学习过程中,智能体逐个对每个连续的非独立均匀分布流数据示例进行学习,并且该智能体对每个示例只进行一次访问。这种学 习方式与动物学习过程更为接近。如果我们忽略各个任务的先后次序问题,单独训练每个任务,这将导致灾难性遗忘,这也是连续学习一直以来所面临的最大问题。因此,连续学习的本质是通过各种手段高效地转化和利用已经学过的知识来完成新任务的学习,并且能够极大程度地降低遗忘带来的问题。[1]”。

图 1. 连续学习示意图 [1]

到目前为止,已经有许多持续学习算法,主要分为三种类型:回放方法(Memory Reply)、动态结构模型(Dynamic Structural Models)和正则化方法(Regularization Model)。1)回放方法从以前的数据集中选择有代表性的样本,以保留所学的知识。该方法的研究重点是:「要保留旧任务的哪部分数据,以及如何利用旧数据与新数据一起训练模型」,这对于克服数据存储的限制是可行的,但对于多中心合作来说是不可行的,因为由于数据隐私问题,其他中心的样本是不可用的 [6-8]。2)动态结构模型为多任务场景设计动态网络架构或动态参数,网络的各个部分(如某些权重或某些神经元连接)负责对应的各个任务 [9][10]。3)正则化方法使用相同的传统神经网络,但在损失函数中加入了新的正则化项,以保留学习知识的重要参数。该方法的主要思想是「通过给新任务的损失函数施加约束的方法来保护旧知识不被新知识覆盖」[11][12]。

1.2 联邦持续学习 (Federated Continual Learning)

联邦学习的主要思想是去中心化,将模型下放到各个参与联合训练的客户端本地,基于本地客户端的数据进行模型训练,而不需要将用户数据上传到中央服务器,从而保护各个客户端中的隐私。然而,大多数现有方法假设整个联邦学习框架的数据类别随着时间的推移是固定不变的。实际情况中,已经参与联邦学习的客户端经常可能收集到新类别的数据,但考虑到每个客户端本地设备的存储空间非常有限,很难对其收集到的所有类别都保存下足够数量的数据,这种情况下,现实世界中的联邦学习模型很可能对于旧类数据的性能遇到严重的灾难性遗忘。此外,联邦学习框架往往还会有持续不断的新用户的参与,这些新用户往往有着大量的新数据类别,这样会进一步加剧全局模型的灾难性遗忘。

近年来,有研究人员陆续提出将联邦学习和持续学习的思想结合起来构建联邦持续学习框架。然而,直接简单的将联邦学习和持续学习相结合会带来新的问题。首先是,联邦持续学习仍然面临灾难性遗忘,此外还会带来来自其他客户端潜在的干扰。因此我们需要有选择地利用来自其他客户端的知识,以最小化客户端间的干扰,最大化进行客户端间的知识转移。第二个问题是联邦学习之间进行通信交换知识时,可能会造成通信成本过大,“通信代价” 成为了一个不可忽视的问题。

我们通过四篇近期发表的文章概览联邦持续学习的最新研究进展。

第一篇文章提出了一个新的联邦持续学习框架 —— 联邦加权客户端间的传输(FedWeIT)。FedWeIT 将各个客户端的本地模型参数分解为稠密基参数(a dense base parameter)和稀疏的任务自适应参数( sparse task-adaptive parameters),以便进行更高效地通信 [2]。

第二篇文章提出了一种全新的全局 - 本地遗忘补偿 (GLFC) 模型,即同时从全局和本地两个角度出发,尽可能地减弱灾难性遗忘,使得联邦学习最终可训练一个全局增量模型 [3]。

第三篇文章提出了一种联邦互相关和持续学习方法。对于异构性问题,该方法利用未标记的公共数据进行通信,并构造互相关矩阵来学习域偏移(domain shift)下的可概括性的表示。同时,对于灾难性遗忘,在本地更新中利用跨域和本域信息进行知识蒸馏,有效地提供域间和域内知识而不泄露参与者的隐私 [4]。

第四篇文章提出了一个联邦学习架构,称为联邦多语者 TTS 系统 Fed-Speech。该架构使用渐进式修剪掩码来分离参数,以保留说话人的语调。此外,应用选择性掩码来有效地重用任务中的知识。最后,引入 private speaker embedding 以保持用户的隐私 [5]。