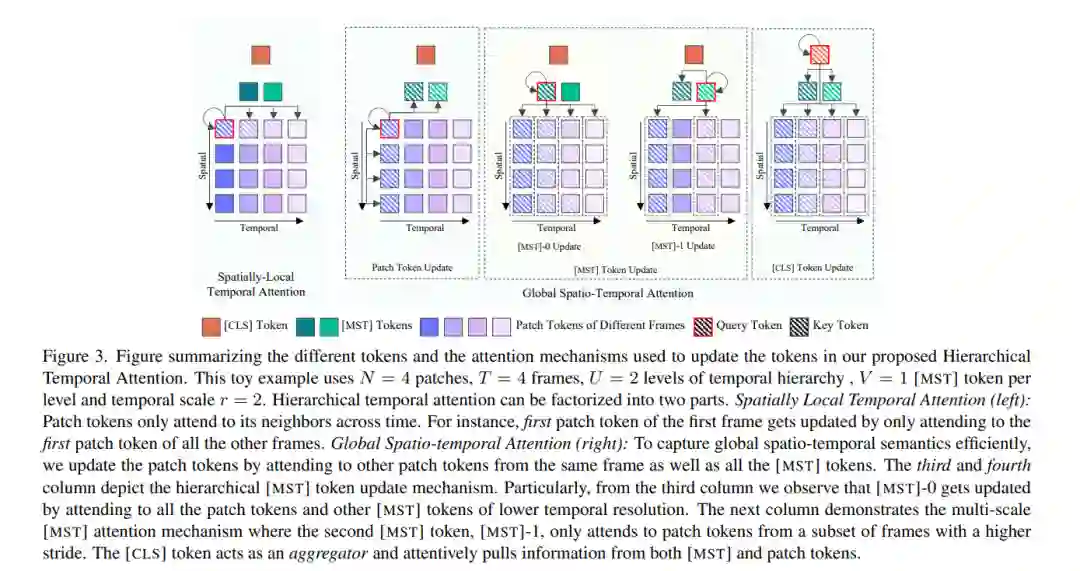

在这篇论文中,我们提出了VidLA,一种大规模视频语言对齐的方法。之前的视频语言对齐方法有两个主要的局限性。首先,它们无法捕捉短距离和长距离的时间依赖性,并且通常采用复杂的层次化深度网络架构,这些架构难以与现有的预训练图像-文本基础模型集成。为了有效地解决这一限制,我们保持了网络架构的简单性,并使用了一组在层次化方式中在不同时间分辨率上操作的数据令牌,以解释视频的时间层次性特点。通过采用简单的双塔架构,我们能够将我们的视频语言模型初始化为预训练的图像-文本基础模型,从而提高最终性能。其次,现有的视频语言对齐工作由于缺乏语义对齐的大规模训练数据而面临困难。为了克服这一点,我们利用最近的大型语言模型(LLMs)来策划迄今为止最大的视频语言数据集,以获得更好的视觉基础。此外,与只包含短片段的现有视频-文本数据集不同,我们的数据集富含不同持续时间的视频片段,以帮助我们的时间层次化数据令牌在不同的时间尺度上提取更好的表示。总的来说,实证结果表明,我们提出的方法在多个检索基准测试上超越了最先进的方法,特别是在较长视频上,并且在分类基准测试上也表现出竞争力。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日