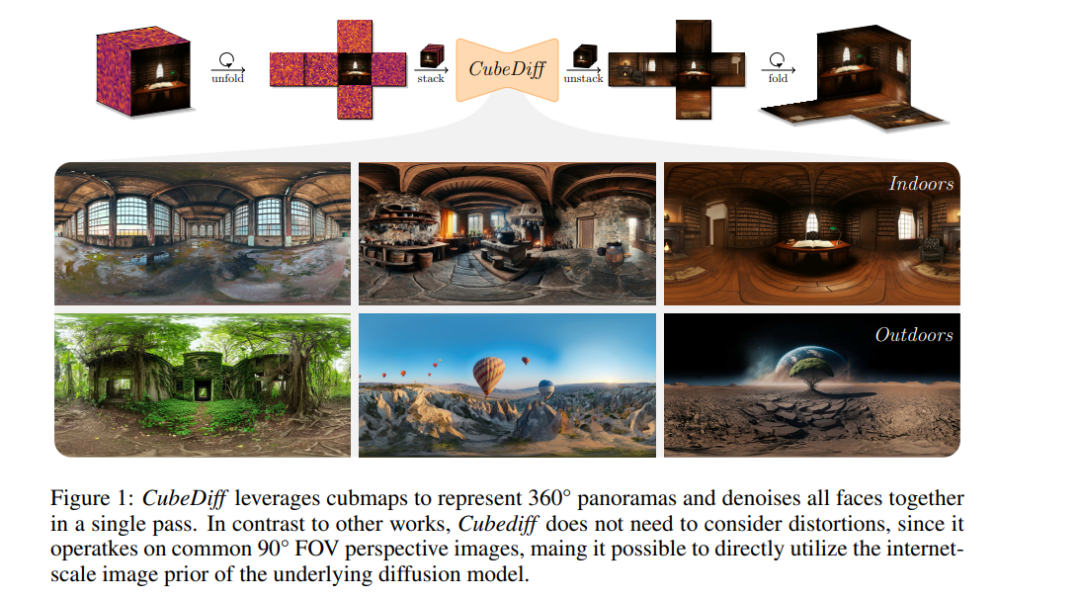

![]() 我们介绍了一种从文本提示或图像生成360°全景图的新方法。我们的方法利用了3D生成领域的最新进展,通过使用多视角扩散模型来联合合成立方体映射的六个面。与依赖处理等矩形投影或自回归生成的先前方法不同,我们的方法将每个面视为标准透视图像,从而简化了生成过程并使现有的多视角扩散模型得以使用。我们展示了这些模型可以在不需要关注层之间的对应关系的情况下适应并生成高质量的立方体映射。我们的模型支持精细的文本控制,能够生成高分辨率的全景图像,并且在训练集之外也能很好地泛化,同时在定性和定量上都达到了最先进的结果。项目页面:https://cubediff.github.io/

我们介绍了一种从文本提示或图像生成360°全景图的新方法。我们的方法利用了3D生成领域的最新进展,通过使用多视角扩散模型来联合合成立方体映射的六个面。与依赖处理等矩形投影或自回归生成的先前方法不同,我们的方法将每个面视为标准透视图像,从而简化了生成过程并使现有的多视角扩散模型得以使用。我们展示了这些模型可以在不需要关注层之间的对应关系的情况下适应并生成高质量的立方体映射。我们的模型支持精细的文本控制,能够生成高分辨率的全景图像,并且在训练集之外也能很好地泛化,同时在定性和定量上都达到了最先进的结果。项目页面:https://cubediff.github.io/

![]()

![]()