集体智能是生命体的核心要素,并广泛存在于自然系统中。尽管其重要性不言而喻,这种涌现特性在很大程度上仍未被人类所认知。虽然自然系统研究已确定多样性是导致其涌现的核心原则之一,但集体人工智能领域的研究却长期忽视了对多样性的深入探索。多智能体学习领域缺乏行为多样性研究的根本原因在于传统方法强制要求智能体采用完全一致的策略。这种方法通过汇集所有个体经验训练共享策略来加速学习进程,但会导致智能体行为趋于同质化。同质化智能体在相同输入条件下被迫采取相同行动,从而丧失策略多样性。这一问题在多智能体强化学习(MARL)背景下尤为突出——为降低模拟过程的高计算成本而采用同质化训练。尽管已有研究致力于提升多智能体强化学习中的行为多样性,但它们仅通过附加损失函数或内在奖励机制来促进多样性,缺乏系统性的测量与控制方法。这种做法实质上改变了原始任务的学习目标,损害了其最优性。

本论文旨在通过研究神经(即行为)多样性对多智能体学习的影响,明确其在集体人工智能中的核心作用。为此,我们提出HetGPPO:一种新型图神经网络(GNN)模型,允许智能体以异质方式进行学习与通信。我们将HetGPPO部署于地面机器人集群,在实际多机器人任务中验证神经多样性提供的固有抗噪声能力。为量化由此产生的异质性,我们提出系统神经多样性(SND)——一种衡量多智能体学习行为异质性的新型指标。SND是首个支持跨不同规模系统进行多样性比较并可量化行为冗余度的度量标准。最后,我们将SND应用于多样性控制(DiCo),这是第一种能够将多智能体系统多样性精确控制到给定指标特定值的方法。DiCo是唯一能不通过增加学习目标而约束多样性的方法,其通过对智能体策略网络施加结构约束来实现。我们通过大规模实证研究,运用SND和DiCo分析多样性在合作与竞争任务中的影响。在每队最多五名玩家的多智能体模拟足球赛中,我们的研究结果表明控制多样性可催生传球与守门等新颖策略,其表现超越同质化智能体,证明行为角色分工的必要性。

为支持神经多样性研究,我们开发了多个用于模拟与训练多智能体系统(MAS)的新型开源库。首先推出向量化多智能体模拟器(VMAS),这是一个批处理模拟器,包含一系列基于PyTorch编写的多机器人任务。凭借图形处理器(GPU)加速与批处理技术,VMAS相比现有先进软件实现显著提速。其次介绍BenchMARL,这是一个以标准化基准测试与确保多智能体强化学习可复现性为目标的训练库。BenchMARL提供高性能且持续维护的先进算法实现,支持跨算法、模型与环境的比较研究。本论文通过多智能体系统研究神经多样性,论证其在集体学习中被忽视的关键作用。我们提出创新方法以模拟、实现、训练、测量与控制多智能体学习中的神经多样性。研究结果表明神经多样性是合作、探索与韧性的基础,为理解与发展集体通用人工智能铺平道路。

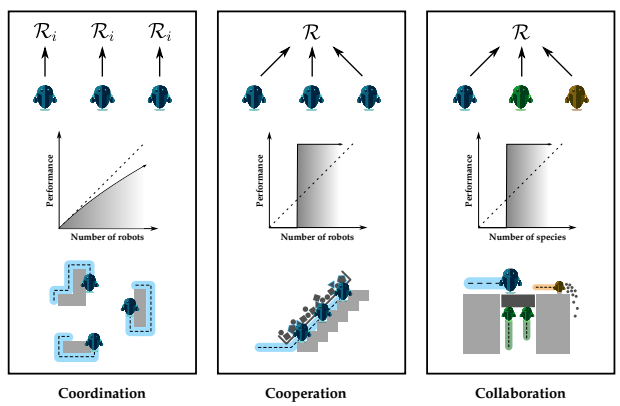

本论文旨在通过提出围绕多智能体学习神经多样性的创新研究与方法,回答以下研究问题:第二章提供理论基础,介绍多智能体系统及其相关挑战与收益,形式化待解决的多智能体决策问题与博弈框架,阐述强化学习(RL)与多智能体强化学习作为解决范式,最后讨论图神经网络作为通信图中智能体间交互建模工具。第三章综述相关文献,首先分析现有多智能体模拟与训练库,接着剖析利用智能体间通信的多智能体强化学习方法,通过领域算法分类学进行系统归纳,最后聚焦多智能体系统多样性,提供异质系统分类框架并评述现有实现、测量与提升神经多样性的方法。

第四章介绍作为本论文核心成果的多智能体开源模拟与学习工具。这些工具旨在提供标准灵活库以支持多智能体强化学习实验,同时兼容任何类型的智能体物理与神经多样性。首先介绍向量化多智能体模拟器(VMAS)[38]。VMAS是为高效多智能体强化学习模拟设计的开源框架,包含基于PyTorch的向量化二维物理引擎与30多个挑战性多机器人场景。我们展示向量化如何在加速硬件上实现可扩展模拟,并在其场景上对各种多智能体强化学习算法进行性能基准测试。其次介绍BenchMARL[39],这是一个用于多智能体强化学习基准测试的库,允许在不同算法、任务与模型之间进行比较,同时系统遵循其两大核心原则:可复现性与标准化。为助力学界建立可共享访问的基准,我们公开一组在VMAS任务上比较所有BenchMARL算法的实验数据。最后展示VMAS与BenchMARL如何协同用于多机器人导航任务学习策略的零样本部署至全向移动机器人团队[40]。

第五章通过明确神经多样性在多智能体强化学习策略中的作用回答第一个研究问题。我们提出异质图神经网络近端策略优化(HetGPPO)[41],这是一种训练异质多智能体强化学习策略的范式,利用图神经网络实现可微分智能体间通信,同时在部分可观测环境中支持完全去中心化训练。为论证该模型必要性,我们刻画同质模型模拟异质行为的技术特征,揭示这种“表观异质性”在真实条件下的脆弱性。最后通过模拟与真实实验证明:(一)当同质方法因强异质需求失败时,HetGPPO成功;(二)当同质方法能学习表观异质行为时,HetGPPO实现更高性能与对训练及部署噪声的韧性。

第六章通过引入系统神经多样性(SND)[42]回答第二个研究问题:一种多智能体系统行为异质度测量方法。我们讨论并证明其理论特性,与机器人领域现有先进行为多样性指标进行比较。通过模拟多种合作多机器人任务,展示该指标如何成为重要工具,提供前所未有的神经多样性与韧性洞察。

第七章聚焦第三个研究问题,提出多样性控制(DiCo)[43],该方法通过将策略表示为参数共享组件与动态缩放智能体组件的和,能将多样性精确控制到给定指标特定值。通过对策略架构直接施加约束,DiCo保持学习目标不变,使其适用于任何行动者-评论家多智能体强化学习算法。我们提供DiCo实现预期多样性的理论证明,并通过教学案例(多智能体导航)进行实证验证。为此提出策略多样性分布的新型可视化方法,分析智能体策略如何学习将DiCo指定的多样性分配于观测空间。为展示DiCo应用潜力,我们在合作与竞争多智能体强化学习任务中开展实验,比较DiCo智能体(约束至不同多样性水平)与同质及无约束异质智能体。实验表明通过约束策略搜索空间,DiCo能实现更高性能、探索性与样本效率。通过对学习DiCo策略的轨迹分析,展示不同多样性约束如何导致多种任务中涌现新颖策略。

第八章运用多样性测量(SND)与控制(DiCo)范式研究神经多样性在多智能体强化学习中的影响[44],回答第四个研究问题。我们应对集体学习三大挑战:(一)团队协作:与队友在长期决策中合作的能力;(二)探索:发现世界与任务目标的能力;(三)韧性:从意外干扰中恢复的能力。通过在足球等合作任务评估团队协作,在集体觅食任务评估探索,在动态干扰下的物理耦合多智能体导航任务评估韧性。实验表明神经多样性促使互补角色涌现与更优团队策略,通过高效探索加速学习过程,并使智能体学习保留潜在技能以克服重复干扰。

最后第九章总结论文,讨论其局限性与未来工作方向。