在深度学习重新崛起(2012 年)之后的 5 年里,深度学习取得了长足进步,但其中很大一部分成功是通过在标注数据上对深度神经网络进行大规模训练取得的。迁移学习被普遍使用,但实际上,人们对如何有效微调预训练模型(如在 ImageNet 上预训练的模型[8])并不十分了解。例如,这些方法很容易受到源数据集数据分布变化(领域变化)的影响,而且在遇到新问题时,往往不清楚从哪里转移。虽然早期开发的方法涉及无监督、半监督、领域适应和少量学习(包括由该团队开发的方法),但它们只解决了现实世界中的小部分问题,在实践中往往无法击败仅靠迁移学习的强大基线[9]。

从那时起,情况发生了翻天覆地的变化,该计划以及整个社区开发的方法使得大规模无标记预训练与半监督学习相结合,显著提高了低标记条件下的性能。研究团队为这项工作做出了巨大的贡献,从对问题的科学表述和理解,到实用算法的开发,这些算法在既有的学术数据集和评估中都表现出色。

通过使用图表示法明确表示数据流形的结构来看待这些低标记问题。通过这一视角,提出了一系列创新方案,以回答传输什么、如何传输以及从哪里传输等问题。特别开发了以下方法:1)通过 "特征匹配"(FeatMatch)[13]利用数据流形结构;2)通过 "流形传输操作符"(Manifold Transport Operators)[14, 15, 16, 17, 18]利用数据流形结构;3)针对 "零镜头学习"(Zero-Shot Learning)的半监督聚类和检索[19];4)通过检索进行低标签字幕制作[20, 21];5)通过 "交叉匹配"(Cross-Match)进行半监督对象检测;6)在主动学习(Active Learning)方面取得进展。

研究提出的方法已在顶级会议上发表,包括 CVPR、ECCV、NeurIPS ICML、AAAI、UAI 和 TMLR。还产生了重大的实际影响,并开源了许多与论文相关的资源库,这些资源库拥有数百颗星,并被广泛使用。最后,方法在 DARPA 独立评估中取得了优异成绩,经常是表现最好的方法之一。

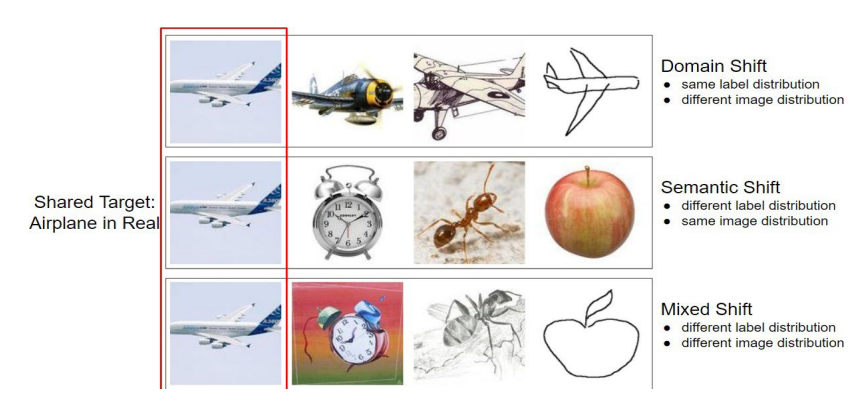

图 1:用于系统研究语义转换(即不同标签空间)和非语义转换(即不同模态)的设置。使用一个共同的目标集,可以单独研究其中一种类型的转换,也可以同时研究两种类型的转换。