本书旨在介绍深度学习数学分析中的关键思想,帮助学生和研究人员快速熟悉这一领域,并为开发大学关于深度学习数学的课程提供基础。我们编写这本书的主要目标是呈现各种严谨但易于理解的结果,以帮助读者建立对深度学习中基本数学概念的理解。为此,我们优先考虑简洁性而非广泛性。作为深度学习的数学导论,本书并不打算对整个(并且快速发展的)领域进行详尽的综述,因此一些重要的研究方向未被涵盖。尤其是,我们更倾向于介绍数学结果而非经验研究,尽管准确理解深度学习的理论需要两者兼顾。本书面向数学及相关领域的学生和研究人员。虽然我们相信,每一个勤奋的研究人员或学生都能通读这本手稿,但需要强调的是,熟悉分析、线性代数、概率论和基本泛函分析的读者将能更好地理解本书内容。为帮助读者,本书在附录中提供了概率论和泛函分析关键概念的回顾。本书的内容围绕深度学习理论的三个主要支柱展开:逼近理论、优化理论和统计学习理论。第一章提供了概述并列出了理解深度学习的关键问题。第二章至第九章探讨了逼近理论的结果,第十章至第十三章讨论了深度学习的优化理论,剩下的第十四章至第十六章则涉及了深度学习的统计方面。本书是作者们一系列讲座的成果。部分内容由P.P.在维也纳大学讲授的“神经网络理论”课程中展示,而J.Z.则在海德堡大学讲授的“深度学习理论”课程中展示了另一部分内容。这些课程的讲义构成本书的基础。我们感谢许多同事和学生通过深刻的讨论和宝贵的建议对本书做出的贡献。我们特别感谢以下个人:本书对上一节提出的问题进行了探讨,提供了数学上严谨且易于理解的答案。我们的重点在于提供可证明的论断,并以简明清晰的方式呈现,而非追求普遍性。有时,我们仅在特定情况下或在强假设下说明关键思想,这既是为了避免过于技术性的阐述,也是因为很多问题的最终答案尚未确定。下面,我们总结了每一章的内容,并重点介绍了与上一节提出的问题相关的部分。

第2章:前馈神经网络。本章介绍了本书研究的主要对象——前馈神经网络。

第3章:通用逼近。本章展示了神经网络在函数逼近中的经典视角,并给出了两个所谓的通用逼近结果。这些结果描述了在网络规模足够大的情况下,神经网络能够以任意精度逼近某个给定类别的所有函数的能力。第一个结果在激活函数的广泛假设下成立,涉及紧致域上连续函数的均匀逼近。第二个结果显示,对于一个非常特定的激活函数,网络规模可以独立于所需精度进行选择,这表明通用逼近需要谨慎解读。

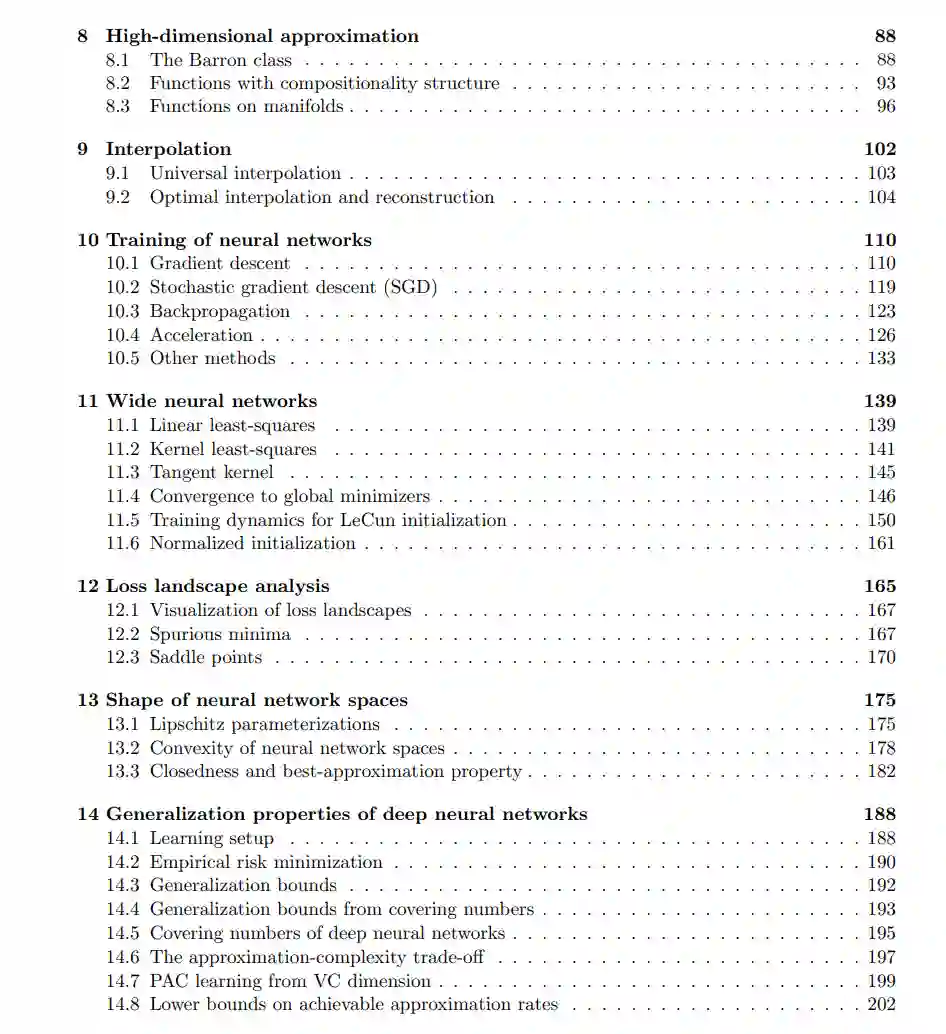

第4章:样条函数。超越通用逼近,本章开始探讨神经网络的逼近速度。具体而言,我们考察了相对于网络参数数量,某些函数的逼近效果。对于所谓的S形激活函数,我们建立了神经网络逼近与样条函数逼近之间的联系。这揭示了更光滑的函数需要较少的网络参数。然而,实现这种效率提升需要使用更深的神经网络。这一观察首次提示了深度在深度学习中的重要性。

第5章:ReLU神经网络。本章聚焦于实践中最流行的激活函数之一——ReLU。我们证明了ReLU网络类等同于连续分段线性函数集,从而为其表达能力提供了理论基础。此外,针对给定的连续分段线性函数,我们研究了表示它所需的ReLU网络的宽度和深度。最后,我们利用分段线性函数的逼近理论推导了逼近Hölder连续函数的收敛速度。

第6章:ReLU神经网络的仿射部分。在对ReLU神经网络有了一些直观认识之后,本章探讨了一些潜在的局限性。我们通过计算ReLU神经网络生成的仿射区域数量来分析这些网络。本章的关键发现是,深层神经网络可以生成指数级更多的区域,而浅层网络则不行。这一观察进一步证明了深度在神经网络架构中的潜在优势。

第7章:深层ReLU神经网络。在确认了深层ReLU神经网络生成大量仿射区域的能力之后,我们探讨了这是否会转化为函数逼近中的实际优势。确实,对于逼近光滑函数,我们证明了相比浅层神经网络,深层神经网络具有显著更好的逼近速度。这再次加深了我们对深度及其与神经网络架构表达能力之间关系的理解。

第8章:高维逼近。前几章中建立的收敛速度在高维情况下显著恶化。本章探讨了神经网络在三种场景下如何可以克服维度灾难。第9章:插值。本章我们将视角从逼近转向训练数据的精确插值。我们分析了在何种条件下精确插值是可能的,并讨论了其对经验风险最小化的影响。此外,我们给出了一个构造性证明,表明ReLU网络可以表达数据的最优插值(在特定意义上)。

第10章:神经网络的训练。我们开始研究深度学习的训练过程。首先,我们研究(随机)梯度下降和凸优化的基本原理。然后,我们讨论了如何使用反向传播算法来实现这些用于训练神经网络的优化算法。最后,我们探讨了加速方法,并强调了像Adam这样流行且更先进的训练算法背后的关键原理。

第11章:宽神经网络。本章引入了神经切线核作为分析神经网络训练行为的工具。我们首先重新审视了基于数据的线性回归和核回归的函数逼近。随后,在一个抽象设置中,我们展示了在某些假设下,神经网络的梯度下降训练动态类似于核回归,收敛于全局最小值。利用标准初始化方案,我们接着展示了,如果网络足够宽(过参数化),这些假设高概率下可以成立。这一分析揭示了为什么在某些条件下,我们可以训练神经网络而不会陷入(糟糕的)局部最小值,尽管目标函数是非凸的。此外,我们还讨论了神经网络与高斯过程之间的著名联系,说明了为什么过参数化的网络在实践中不一定会过拟合。

第12章:损失景观分析。在本章中,我们从分析损失景观的角度提供了对优化问题的另一种看法——即经验风险作为神经网络参数的函数。我们给出了理论论证,表明增加过参数化会增强损失景观中谷底和盆地之间的连通性。因此,过参数化的架构更容易到达所有极小值都是全局最小值的区域。此外,我们观察到,大多数与非全局最小值相关的驻点都是鞍点。这进一步解释了为何在实践中,深层架构通常可以优化而不会陷入非全局最小值。

第13章:神经网络空间的形状。尽管第11章和第12章强调了神经网络训练成功的潜在原因,但在本章中,我们展示了固定架构神经网络集合从优化角度来看具有一些不理想的性质。具体而言,我们证明了这一集合通常是非凸的。此外,通常它不具备最佳逼近性质,这意味着可能不存在一个神经网络可以对给定函数进行最佳逼近。

第14章:深度神经网络的泛化性质。为了理解为什么深度神经网络能够成功地泛化到未见过的数据点(在训练集之外),我们研究了经典的统计学习理论,重点是将神经网络函数作为假设类。随后,我们展示了如何为深度学习建立泛化界限,从理论上理解其在未见数据上的表现。

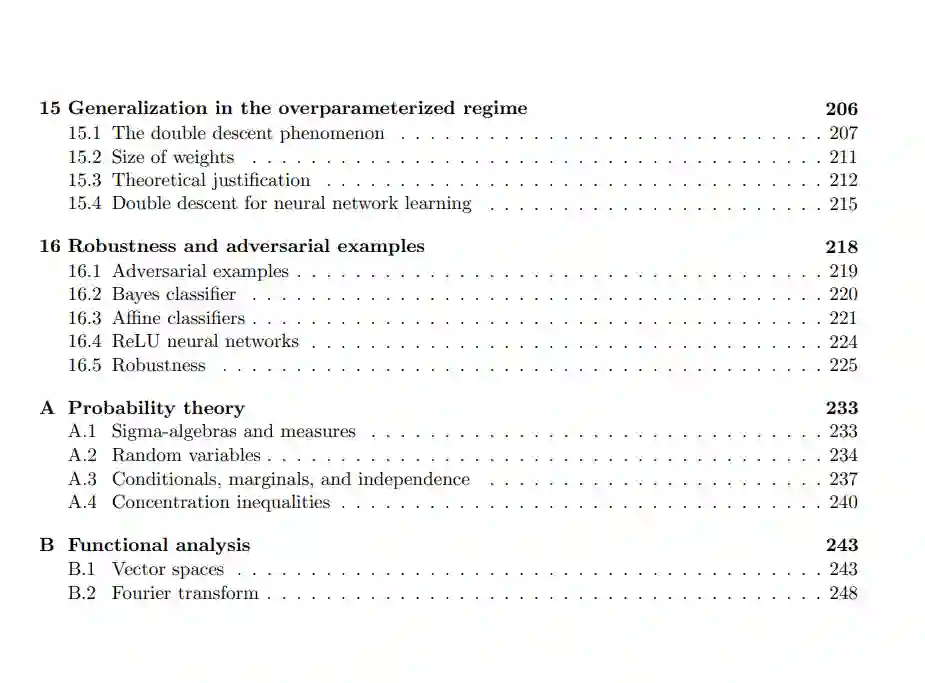

第15章:过参数化状态下的泛化。上一章的泛化界限在神经网络参数数量超过训练样本数量时不再有意义。然而,许多成功的网络架构恰恰在这一过参数化状态下运行。为了更深入地理解这种状态下的泛化,我们描述了双降现象并提出了一个可能的解释。这解释了为什么深度神经网络尽管高度过参数化,仍能表现良好。

第16章:鲁棒性与对抗样本。在最后一章中,我们探讨了对抗样本的存在——这些输入是专门设计用来欺骗神经网络的。我们提供了一些对抗样本为何出现的理论解释,并讨论了可能的防范策略。