摘要

近年来,生成模型的最新进展显著促进了个性化内容创作的发展。在给定一小组包含用户特定概念的图像的情况下,个性化图像生成能够创造出结合指定概念并遵循提供的文本描述的图像。由于其在内容创作中的广泛应用,近年来在这一领域已投入了大量的研究工作。然而,用于个性化的技术随着生成模型的发展而不断演化,且具有各自独特且相互关联的组成部分。在本综述中,我们全面回顾了跨各种生成模型的广义个性化图像生成方法,包括传统的生成对抗网络(GAN)、当代文本到图像的扩散模型和新兴的多模态自回归(AR)模型。我们首先定义了一个统一的框架,标准化不同生成模型中的个性化过程,涵盖了三个关键组件:反演空间、反演方法和个性化方案。这个统一框架为分析和比较不同生成架构中的个性化技术提供了结构化的方法。基于该框架,我们进一步深入分析了每种生成模型中的个性化技术,突出其独特贡献和创新。通过比较分析,本综述阐明了个性化图像生成的现状,识别了现有方法中的共性和特征差异。最后,我们讨论了该领域中的开放挑战,并提出了未来研究的潜在方向。相关工作的持续更新可以访问:https://github.com/csyxwei/Awesome-Personalized-Image-Generation。

关键词

个性化图像生成,生成模型,生成对抗网络,文本到图像的扩散模型,多模态自回归模型 1 引言

近年来,生成模型经历了快速的发展,从生成对抗网络(GANs)[1] 到扩散模型(DMs)[2] 和自回归(AR)模型[3]。这些模型在生成多样化和高质量图像方面表现出了显著的优势。最近,文本到图像(T2I)生成模型[4–7] 展现了通过文本输入控制图像生成的卓越灵活性。得益于大规模的预训练,这些T2I模型表现出卓越的语义理解能力,能够生成准确反映给定文本提示的逼真图像。这些进展促进了多种下游任务的发展,如条件生成[8]、图像编辑[9–11] 和艺术创作[12, 13]。其中,个性化图像生成[14–17] 引起了广泛关注,主要集中在通过图像生成创造用户特定的概念。 当代个性化方法[12, 14–18] 主要利用文本到图像的扩散模型,并增强这些模型以在指定的上下文中生成用户特定的概念。具体而言,用户特定的概念通过一小组包含目标概念的图像(例如,主题、面孔或风格,通常为 3∼5 张图像)来指示,而指定的上下文则由目标文本提供。在本综述中,我们探讨了跨多种生成模型的广义个性化图像生成技术,包括传统的 GANs、当前的文本到图像扩散模型以及新兴的多模态自回归(AR)模型。例如,如图4所示,GAN 反演[19–23] 将真实图像映射到 GAN 的潜在空间,从而允许后续的操作以实现广义个性化。这些 GAN 反演技术显著激发了当前基于扩散的个性化方法中概念反演技术的发展[16, 24, 25]。此外,最近自回归模型[3, 26–28] 在多模态生成中的进展,为个性化生成提供了有前景的新方向。因此,本文将这些技术统称为广义个性化图像生成,并对利用这些生成模型的个性化进行全面的综述。 图1展示了近年来该领域的论文数量和代表性作品。在过去两年中,已提出超过180种基于扩散的个性化方法,而过去十年间,各种生成模型已发展出超过300种方法。 若干综述[29–32] 提供了关于条件图像合成的前沿扩散方法的全面回顾。尽管这些工作提供了宝贵的见解,但它们主要集中在一般的条件生成技术上,而没有深入探讨个性化图像生成领域。其中,有两篇最近的综述[32, 33] 与我们的工作特别相关。Shuai 等人[32] 总结了文本到图像扩散模型在图像编辑中的应用,将个性化图像生成归类为一种无内容编辑形式。Zhang 等人[33] 则对基于扩散模型的个性化图像生成进行了综述,但倾向于忽视其他生成模型所引入的进展。与这些现有综述不同,我们的研究集中在跨多种生成模型的个性化,包括 GANs、文本到图像的扩散模型和多模态自回归模型。我们全面概述了这些模型中的个性化技术,强调它们的共性和差异,以澄清当前个性化图像生成方法的现状。 为了系统地探索个性化图像生成,本文首先定义了一个统一框架,标准化不同生成模型中的个性化过程。具体而言,我们将个性化图像生成分为两个主要阶段:概念反演和个性化生成,其中包含三个关键组件。反演空间:个性化过程首先通过将给定概念反演为生成模型可以操作的表示,探索用于此目的的各种空间。反演方法:选择目标空间后,可以采用多种反演方法来学习表示,例如基于优化的方法、基于学习的方法等。个性化方案:生成模型随后将反演的概念表示与目标文本结合,生成个性化图像。此步骤涉及针对每种生成模型量身定制的各种个性化方法和概念类别。 基于这一统一框架,我们进一步深入分析了每种生成模型中的个性化技术,突出它们在不同场景下的共性与差异。此外,我们还介绍了个性化图像生成中常用的评估指标和数据集,并讨论了该领域的开放挑战以及未来研究的潜在方向。 本文其余部分组织如下:第2节定义了个性化图像生成的问题,并介绍了生成模型的基础知识;第3至5节讨论了针对不同生成模型的个性化技术,包括 GANs、扩散模型和自回归模型;第6节回顾了个性化图像生成中现有的评估数据集和指标;第7节指出了该领域的开放挑战,并概述了潜在的未来研究方向;最后,第8节通过总结关键见解和贡献,结束了本综述。图2展示了我们综述的组织结构,并分类了各节中的文献。

2. 问题定义与生成模型基础

2.2 生成模型基础

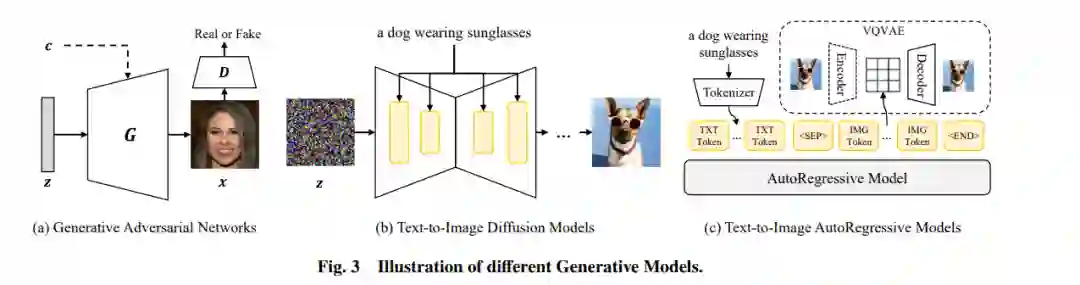

**2.2.1 生成对抗网络(GANs)

生成对抗网络(GANs)由生成器和判别器两个神经网络组成,通过对抗过程进行训练。生成器旨在生成逼真的图像,而判别器则试图区分真实图像和生成图像。近年来,GANs在生成高分辨率图像方面取得了显著进展,特别是基于风格的GAN系列(如StyleGAN),通过分层潜在风格控制生成图像的不同方面。

**2.2.2 文本到图像扩散模型(DMs)

扩散模型通过逐步去噪的过程生成图像,与GANs不同,扩散模型通过前向扩散过程和反向去噪过程生成图像。近年来,扩散模型在文本到图像生成领域得到了广泛应用,特别是Stable Diffusion系列模型,通过在大规模文本-图像数据集上进行预训练,能够生成与文本描述高度一致的图像。

**2.2.3 多模态自回归模型(ARs)

自回归模型通过预测序列中的下一个元素来生成图像,近年来在自然语言处理(NLP)领域展示了卓越的性能。DALL-E等模型通过将文本和图像转换为离散标记,实现了文本到图像的生成。多模态自回归模型通过结合视觉和文本信息,展示了在个性化图像生成中的潜力。

3. GANs中的个性化图像生成

3.1 概述

GANs中的个性化图像生成主要依赖于GAN反演技术,将真实图像映射到GAN的潜在空间中,以便进行后续的编辑和生成。具体来说,给定一个概念图像,个性化图像生成包括两个主要阶段:概念反演和潜在编辑。

3.2 反演空间

在GAN反演中,有多种潜在空间可用于表示概念图像,包括广义风格空间、特征空间和参数空间。广义风格空间(如StyleGAN中的WW空间)提供了更好的语义解缠,能够更准确地表示复杂概念。特征空间通过映射中间残差特征来增强细节一致性,而参数空间则通过微调生成器参数来提高反演保真度。

3.3 GAN反演方法

GAN反演方法可以分为优化方法、学习方法和混合方法。优化方法通过直接优化潜在表示来反演图像,而学习方法则通过训练编码器来预测潜在表示。混合方法结合了学习和优化的优点,通过编码器提供初始潜在表示,并通过优化进行细化。

3.4 潜在编辑

在反演得到概念条件后,用户可以通过潜在编辑生成个性化图像。潜在编辑方法包括潜在导航和文本驱动编辑。潜在导航方法通过支持向量机(SVM)或条件归一化流模型来学习属性编辑方向,而文本驱动编辑则通过CLIP等模型将文本描述映射到潜在空间中,实现更直观的图像生成。

4. 扩散模型中的个性化图像生成

4.1 概述

文本到图像扩散模型通过文本提示生成图像,个性化图像生成进一步增强了其生成用户特定概念的能力。与GANs类似,扩散模型中的个性化图像生成也涉及概念反演和个性化生成两个阶段。

4.2 反演空间

扩散模型中的反演空间包括噪声空间、文本空间、特征空间和参数空间。噪声空间通过DDIM反演等技术将图像反演为噪声表示,文本空间通过CLIP文本编码器将概念表示为文本特征,特征空间通过映射中间特征来增强细节一致性,而参数空间则通过微调模型参数来提高反演保真度。

4.3 概念反演方法

扩散模型中的概念反演方法包括无训练方法、优化方法、学习方法和混合方法。无训练方法利用扩散模型的固有特性进行反演,优化方法通过优化概念条件来学习新概念,学习方法通过训练编码器来预测概念条件,而混合方法则结合了学习和优化的优点。

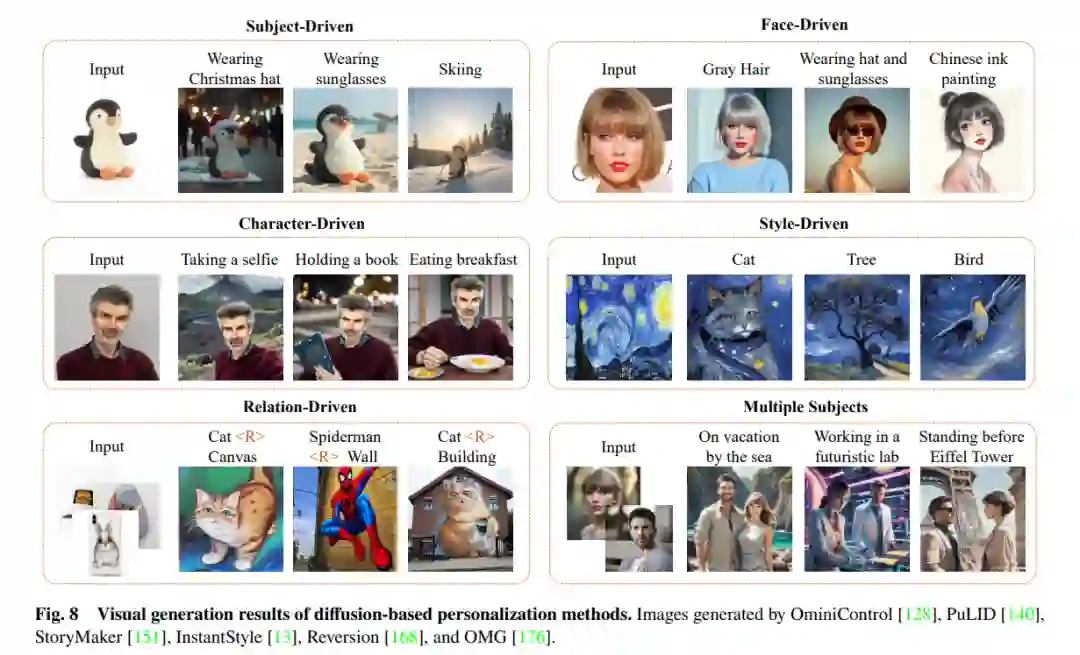

4.4 个性化图像生成

扩散模型中的个性化图像生成可以根据概念类型进行分类,包括主题驱动、面孔驱动、风格驱动和高层语义个性化。主题驱动个性化通过优化或学习方法生成包含目标主题的图像,面孔驱动个性化则专注于生成与参考图像具有相同身份的面孔图像,风格驱动个性化通过反演风格特征生成具有特定风格的图像,而高层语义个性化则通过反演关系或动作生成具有特定语义关系的图像。

4.5 文本驱动图像编辑

与GANs类似,扩散模型中的文本驱动图像编辑通过反演噪声空间并应用文本驱动编辑技术生成个性化图像。Prompt-to-prompt等方法通过操纵注意力机制实现图像编辑,而MasaCtrl等方法则通过自注意力机制保持对象外观的同时进行非刚性编辑。

5. 自回归模型中的个性化图像生成

5.1 概述

自回归模型通过预测序列中的下一个元素来生成图像,近年来在多模态图像生成领域展示了卓越的性能。尽管现有的自回归模型在个性化图像生成方面的研究较少,但其多模态生成框架展示了在个性化图像生成中的潜力。

5.2 多模态自回归模型

多模态自回归模型通过将图像和文本编码到共享的标记空间中,实现了文本和图像的联合生成。Emu2等模型通过CLIP视觉编码器将图像转换为嵌入,并通过自回归方式预测生成的图像嵌入。这些模型通过大规模文本-图像对进行预训练,展示了在个性化图像生成中的潜力。

5.3 个性化图像生成的挑战

尽管自回归模型在多模态生成方面展示了卓越的性能,但在个性化图像生成中仍面临一些挑战。例如,生成图像与参考图像之间的身份一致性仍然有限,未来的研究需要开发更有效的个性化技术,以提高身份一致性和生成质量。

6. 评估

6.1 评估数据集

个性化图像生成模型的评估通常依赖于多个数据集,如DreamBench、Custom101等。这些数据集提供了丰富的图像和文本对,用于评估模型在不同场景下的性能。

6.2 评估指标

个性化图像生成的评估指标主要包括概念保真度和文本可编辑性。概念保真度通过FID、身份得分等指标评估生成图像与目标概念的相似性,而文本可编辑性则通过CLIP-T、ImageReward等指标评估生成图像与文本提示的一致性。

6.3 主观评估

除了定量指标,主观评估通过人类评分者评估生成图像的质量和相关性。用户研究通常包括比较基线模型和提出方法的结果,以评估其有效性。

7. 挑战与未来方向

7.1 主题保真度与文本可控性的权衡

个性化图像生成需要在主题保真度和文本可控性之间取得平衡。现有方法在提高身份保真度的同时,往往面临过拟合问题,导致生成图像忽视文本提示。未来的研究需要开发更精细的设计,以更好地平衡这两个方面。

7.2 通用类别个性化

当前的个性化方法通常专注于特定领域,如主题、面孔或风格。未来的研究需要开发能够生成多个自定义概念的通用类别个性化方法,以提供更灵活和多样化的生成能力。

7.3 多条件可控图像生成

多条件图像生成是一个新兴且有前景的领域,旨在开发能够处理多个条件输入并支持各种任务的统一模型。未来的研究需要开发能够确保可扩展性和高质量生成的鲁棒多条件图像生成方法。

7.4 基于先进生成模型的个性化

生成模型经历了显著的演进,包括最近的DiT-based文本到图像扩散模型和多模态自回归模型。未来的研究需要开发与这些先进模型兼容的有效个性化技术。

7.5 个性化视频和3D生成

近年来,视频和3D内容生成取得了快速进展,未来的研究可以探索在这些领域中应用个性化生成技术,以扩展个性化生成技术的应用范围。

8. 结论

本文综述了基于深度生成模型的个性化图像生成技术,包括生成对抗网络、文本到图像扩散模型和多模态自回归模型。我们首先从整体角度定义了个性化图像生成的范围,统一了不同方法在一个共同的框架下。具体来说,我们将个性化图像生成分为三个关键组件:反演空间、反演方法和个性化方案。基于这一统一框架,我们深入分析了各类生成模型中的技术,强调了现有方法的共性和差异。最后,我们讨论了该领域的开放挑战,并提出了未来研究的潜在方向。本文为个性化图像生成领域提供了一个全面且最新的综述,系统地跟踪了这一快速演进领域中的相关研究。