编译 | 陶雯 审稿 | 杨慧丹

本文介绍由密歇根州立大学和Agios制药公司合作发表于KDD 2021上的研究工作。作者研究了生物医学领域中的图对比学习,提出了一个名为MoCL的新框架,它利用局部和全局层次的领域知识来辅助表征学习。局部层次的领域知识指导增强过程,可以在不改变图语义的情况下引入变化。全局知识对整个数据集中的图之间的相似信息进行编码,有助于学习语义更丰富的表示。作者在各种分子数据集上对MoCL进行了评估,结果表明MoCL达到了最先进的性能。

1 简介

图神经网络(GNN)已被证明在与图相关的任务上具有最先进的性能。最近它还经常被用于生物医学领域,解决与药物相关的问题。然而,与大多数深度学习网络一样,它需要大量有标签数据进行训练,而现实世界中特定任务的标签通常数量有限,因此关于GNN的预训练方案近期得到了积极探索。然而,与图像不同,图对比学习有其独特的挑战。首先,图的结构信息和语义在不同领域(例如社交网络与分子图)之间存在显著差异,因此很难设计出适用于所有场景的通用增强方案。第二,目前大多数图对比学习框架忽略了整个数据的全局结构,比如结构相似的两个图在嵌入空间应该更接近。第三,对比方案不是唯一的,对比可以发生在节点-图,节点-节点,图-图之间。

除了这些独特的图挑战,对比学习本身也存在一些尚未解决的问题。例如,在高维情况下准确估计互信息是困难的。互信息最大化与对比学习之间的关系尚不明确。

因此,本文作者的目标是在生物医学领域解决上述挑战。作者的假设是,通过向增强和对比方案中注入领域知识,可以学习更好的表示。作者建议利用局部和全局两个层次的领域知识来辅助分子图的对比学习。作者提出了一种新的增强方案,称为子结构替换,其中分子中的有效子结构被一个生物电子等排体替换,该生物电子等排体在不太改变分子性质的情况下引入变化。替换规则来源于领域资源,作者将其视为局部层次的领域知识。全局层次领域知识对图之间的全局相似性进行编码。作者建议利用这些信息通过双对比目标学习更丰富的表征。本文是第一个尝试利用领域知识来辅助对比学习的工作,

作者的贡献如下:

- 提出了一种基于局部层次领域知识的分子图增强方案,使得图的语义在增强过程中不发生变化。

- 利用分子图之间的相似性信息,通过添加全局对比损失,将数据的全局结构编码到图表示中。

- 提供了学习目标与度量学习中的三重损失有关的理论依据,说明了整个框架的有效性。

- 在各种分子数据集上对MoCL进行评估,并证明其优于最先进的方法。

2 方法

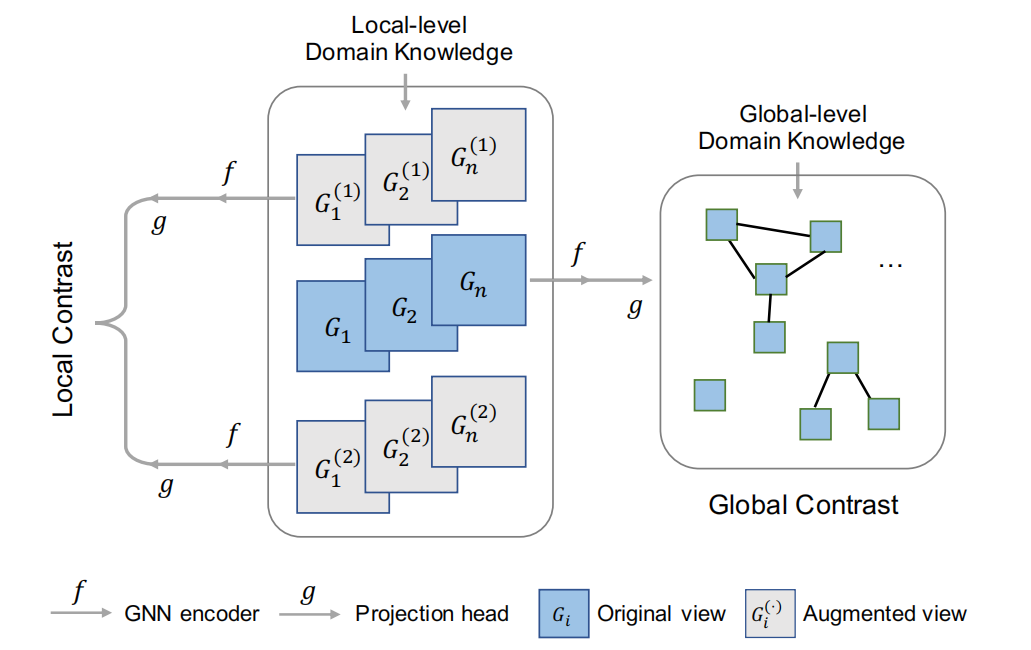

2.1 对比学习框架 图1为MoCL的总体框架。首先,从局部领域知识生成两个增强视图。然后,它们与原始视图(蓝色)一起输入GNN编码器和投影头。局部层次对比最大化了两个增强视图之间的互信息。全局层次的对比最大化了两个相似图之间的互信息,其中相似信息来自全局层次的领域知识。

图1 MoCL的总体框架

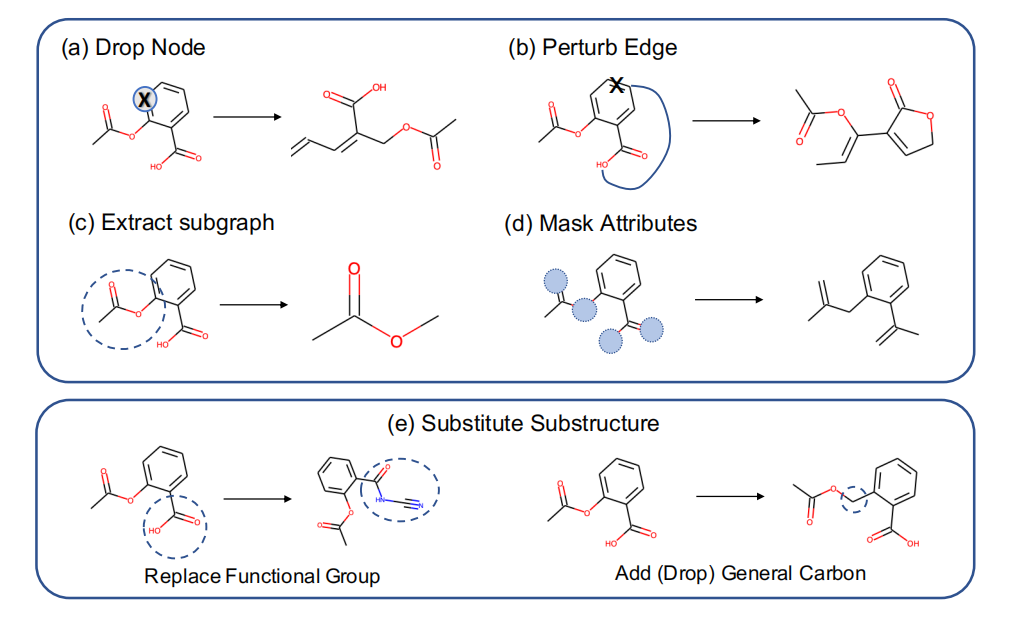

2.2 局部层次领域知识 大多数现有方法在增强过程中可能会改变分子图的语义(图2a,b,c,d)。在一般的增强中,只有属性掩蔽(图2d)不违反生物学假设,因为它不会改变分子,它只掩蔽部分原子和边属性。

因此作者注入领域知识来辅助增强过程。作者提出了子结构替换,其中分子中的有效子结构被一个生物电子等排体取代,该生物电子等排体产生一个具有与原始分子相似的物理或化学性质的新分子(图2e)。作者从领域资源中收集了218条规则,每个规则由一个源子结构和一个目标子结构组成,并增加了12个额外的规则从一个分子中减去和添加碳基团。因此MoCL共包含230条规则,用于生成具有相似性质的分子变体。

图2 增强比较

2.3 全局层次领域知识 最大化对应视图之间的互信息可以学习变换不变表示,然而它可能会忽略数据的全局语义。例如,对于一些具有类似图结构或语义的图,在嵌入空间中应该更接近。对于分子图,这样的信息可以从多个来源获得。对于一般的图结构,扩展连通性指纹(ECFP)对分子子结构进行编码,并被广泛用于计算分子图之间的结构相似性。作者使用ECFP计算分子图之间的相似性,提出两种策略将全局语义纳入学习框架,一种策略是将其用作直接监督,第二种策略是利用一个对比目标,在这个目标中相似的两个图具有更高的互信息。

3 实验

3.1 局部层次领域知识

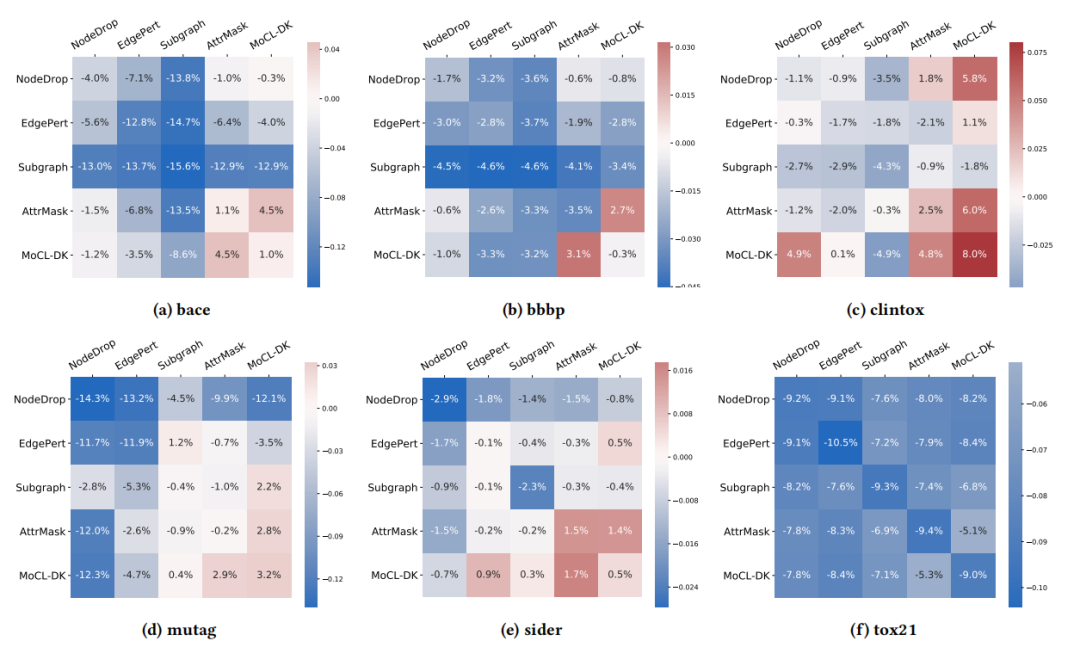

图3显示了在linear protocol下所有数据集的不同增强组合的结果。每个单元格表示从头训练的GNN与用不同的增强组合方法训练的模型在linear protocol下的性能提升。蓝色代表负值,红色代表正值。MoCL-DK得到的表示加上线性分类器产生的预测准确率与GNN效果(bace、bbbp、sider)相当,甚至比它更好(clintox,mutag)。可以看到包含MoCL-DK的行和列的值通常更高,因此MoCL-DK与其它增强方法相结合几乎总是能产生更好的结果。属性掩蔽和MoCL-DK一般在所有场景中都有效,将它们结合起来通常会有更好的性能。这验证了作者之前的假设,即MoCL-DK和属性掩蔽不违反生物学假设,因此比其它增强效果更好。

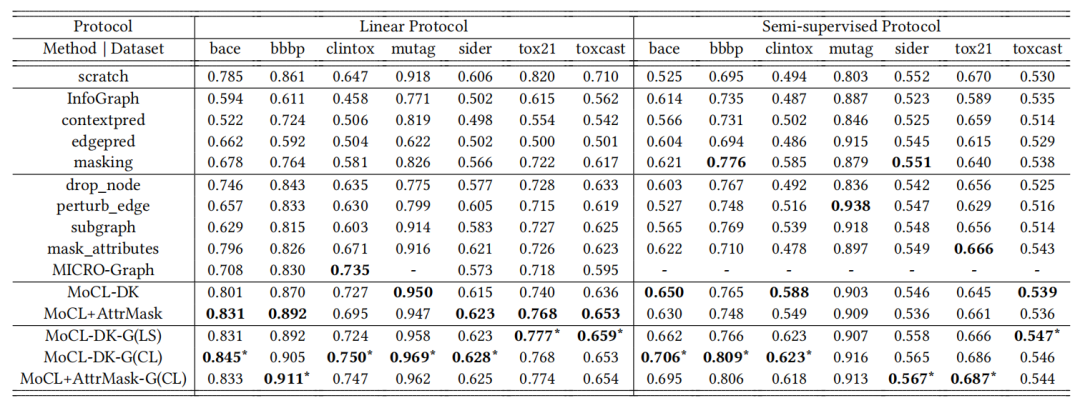

图3 linear evaluation protocol下的增强组合 表1展示了分别在linear protocol和semi-supervised protocol下的实验结果。与其它用到数据增强和对比学习的方法比较,MoCL的性能在大部分数据集上都是最佳的。

表1 各种方法的平均AUC

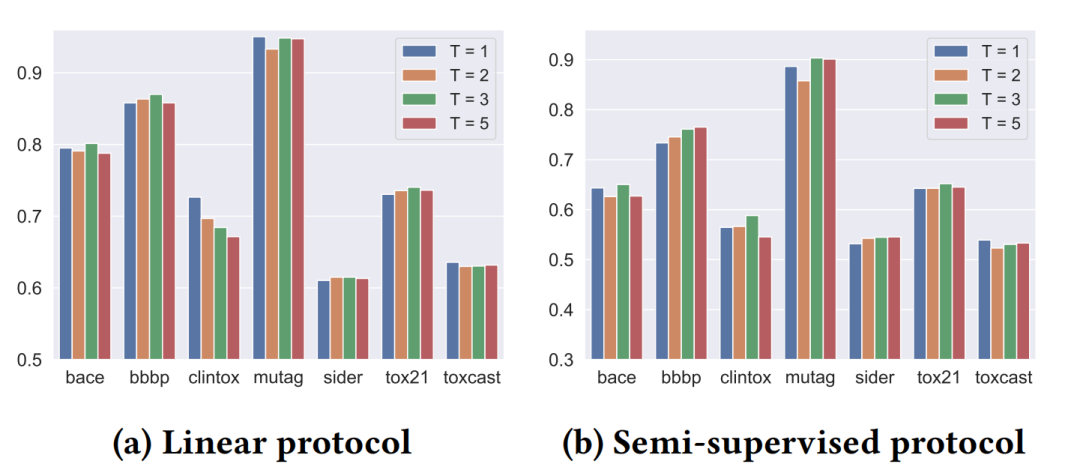

本文提出的增强MoCL-DK可以多次应用,生成更复杂的视图。作者尝试了一系列不同的增强强度,强度指的是增强几次(例如替换后再替换一次,就是增强两次)。图4比较了不同增强强度情况下的效果。对于大多数数据集,随着增强次数的增多,其性能先上升后下降,MoCL-DK3通常能取得更好的结果。

图4 MoCL-Local不同增强强度的平均AUC

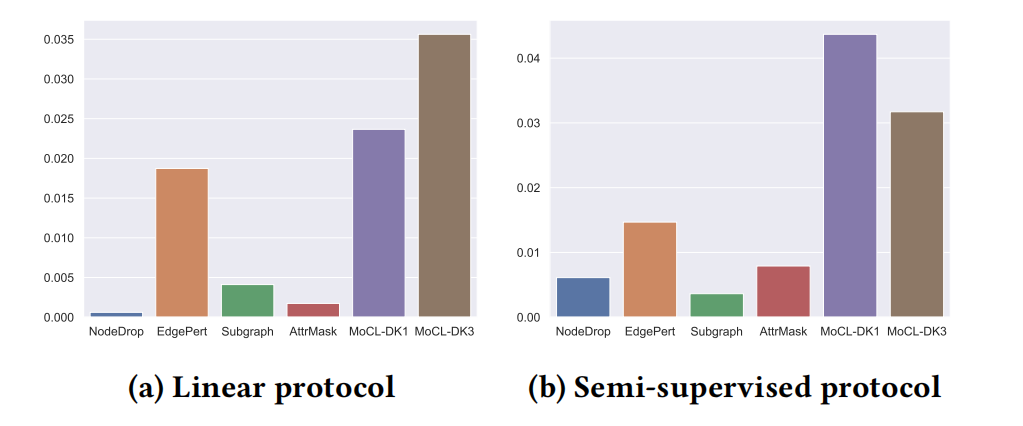

3.2 全局层次领域知识 图5展示了加入全局领域知识后不同增强方法的性能提升。可以看到,全局信息通常会提升所有的增强方法的性能。与其它增强方案相比,所提出的领域增强(MoCL-DK1和MoCL-DK3)的提升要高得多。

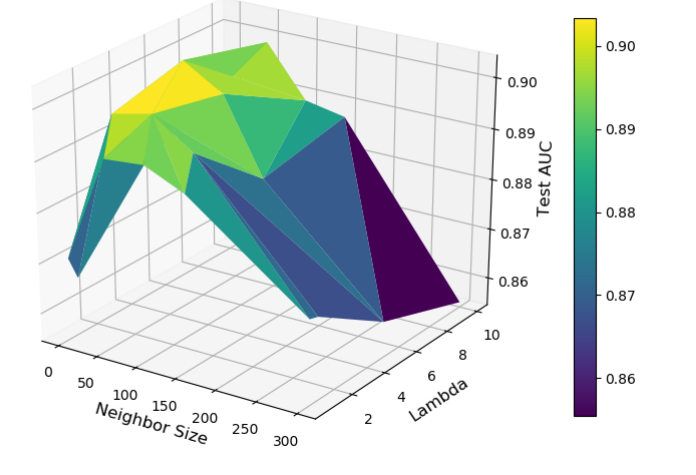

图5 加入全局领域知识后不同增强方法的性能提升 3.3 敏感度分析 图6显示了所提出的方法在不同超参数组合下的性能曲面。可以看到,对于全局损失,使用相对较小的邻域大小(不是太小)和较大的权重(不是太大)可以获得最佳结果。

图6 在不同超参数组合下的平均AUC

4 总结

在这项工作中,作者利用多层次的领域知识来辅助分子图的对比表征学习。局部领域知识支持新的增强方案,全局领域知识将数据的全局结构整合到学习过程中。作者证明了这两种知识都能提高学习表征的质量。 参考资料 论文链接 https://dl.acm.org/doi/10.1145/3447548.3467186