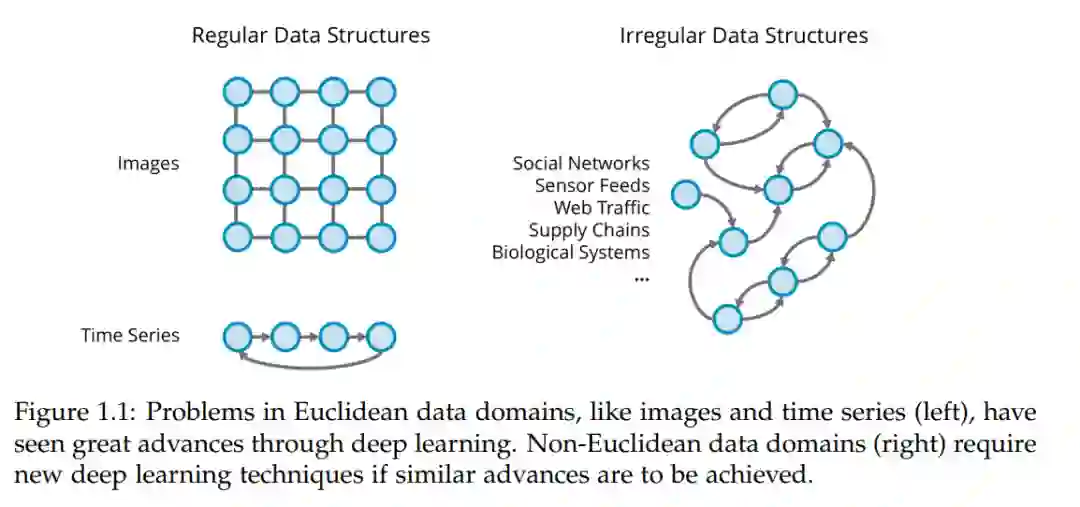

深度学习技术在自然语言处理、计算机视觉和其他欧氏数据领域带来了重大改进,但在许多领域中,数据是不规则的,需要显式建模图或流形。这些应用包括社交网络、传感器反馈、物流、供应链、化学、神经科学和其他生物系统。将深度学习扩展到这些非欧氏数据是一个现在被称为几何深度学习(GDL)的研究领域。

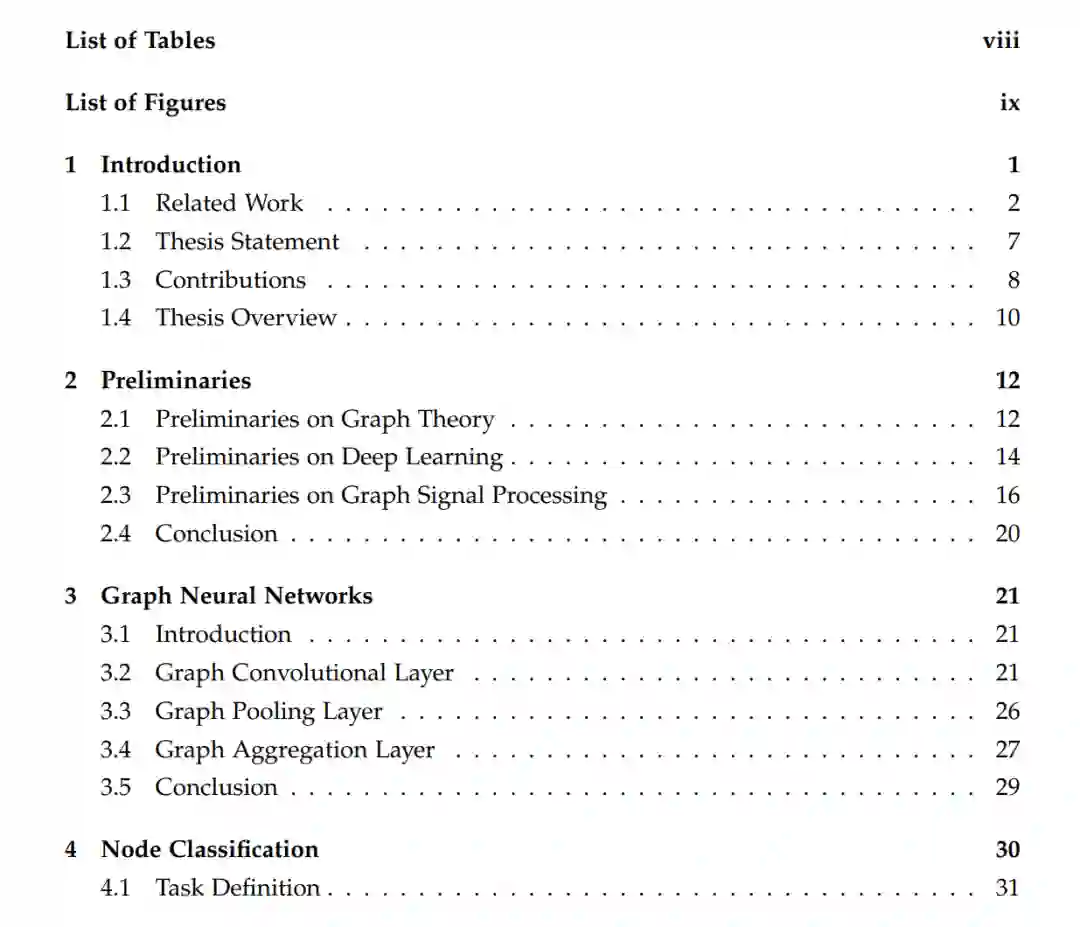

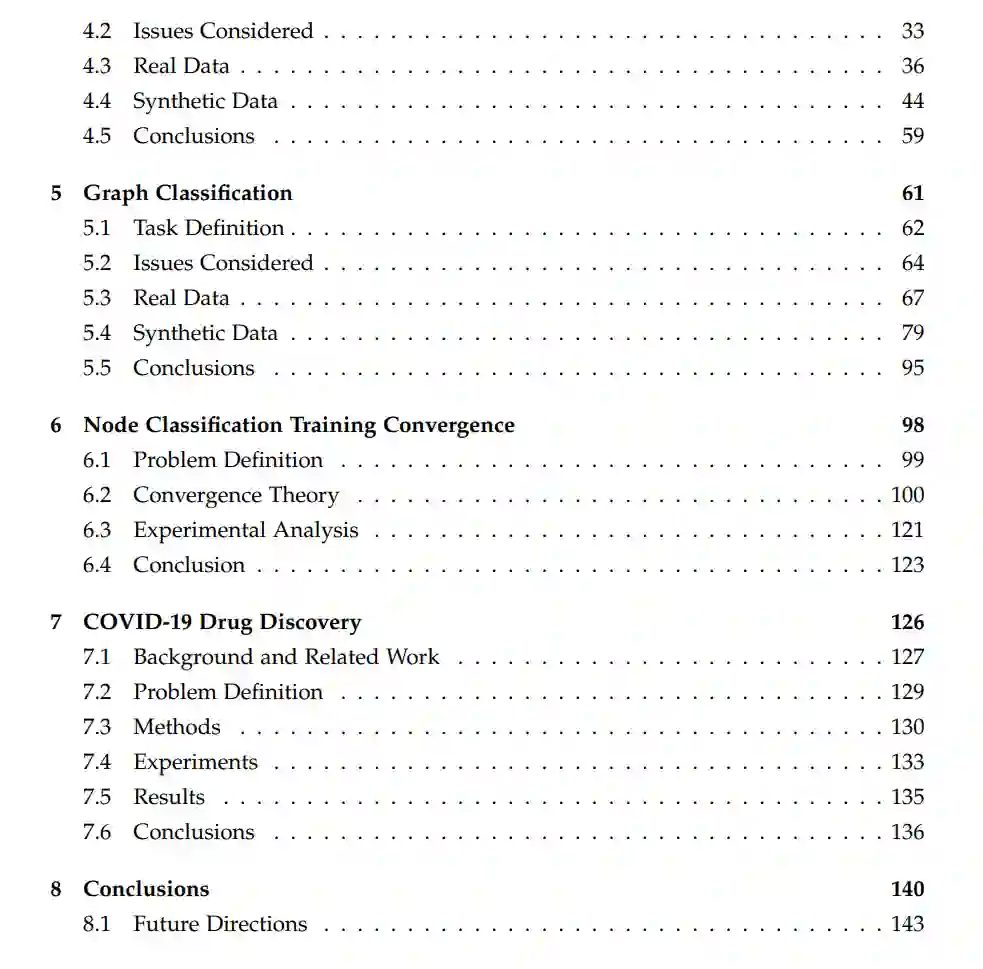

本文专注于GDL的一个子领域,图神经网络(GNN),使用神经网络对图信号进行学习。本文利用真实和合成数据,探讨了数据图结构对图神经网络性能的影响,用于两个图学习任务:节点和图分类。从图神经网络的形式化开始,考虑两种方法:以图卷积网络(GCNs)为代表的谱方法和以拓扑自适应图卷积网络(TAGCNs)为代表的空间方法。通常,TAGCN比GCN需要更少的层数,多项式滤波器的次数适中。对于节点分类,不需要太多层就可以达到最佳性能。与图分类不同,图信号是必要且重要的。对于一些真实的数据集,在图信号上使用简单的估计器进行分类可以优于GNN。对于合成数据集,Erd“os-Rényi”和优先连接模型在GCN和TAGCN的层数和多项式滤波器的度方面具有相似的测试精度曲线。对于小世界模型,TAGCN的滤波器在实现最优精度和加速过平滑效果方面起着重要作用。本文还研究了节点分类的训练收敛性。本文从理论上表明,线性化TAGCN的训练损失收敛到全局最小值。尽管存在非凸目标,但对于1次H层TAGCN,即具有1次多项式滤波器和H层的TAGCN,保证以指数速度收敛到全局最小值,随着层数的增加,收敛速度更快。对于K次TAGCN,多项式滤波器的K次越高,收敛速度越快。实验验证了该理论,并表明训练收敛对线性化和非线性化TAGCN都是正确的。

对于图分类,图结构比图信号起着更重要的作用。如果不同类别的图结构足够不同,GNN通常可以仅使用不同类别的图结构对图进行分类。对于真实的数据集,将简单的网络指标和信号统计与这些模型的性能联系起来。我们表明,对于一些数据集,边的数量或节点的数量上的分类器可以导致与图神经网络更好或类似的性能。对于其他数据集,信号统计可以表现良好。基于这些观察,我们能够对GCN和TAGCN进行简单的修改,以提高它们的性能(sumpool和度感知的TAGCN)。对于合成数据集,Erd“os-Rényi”和优先连接模型在GCN和TAGCN上具有相似的测试精度曲线。对于小世界模型,如果不同类别的边重连概率不同,则需要1层以上的层数才能获得较好的性能。将TAGCN的架构应用于一个COVID-19案例研究。本文提出一种新的分子性质预测方法,通过结合两种现有的GNN方法。所提出模型(D-MPNN+TAGCN)在五个冠状病毒数据集上的表现始终优于最先进的基线方法。