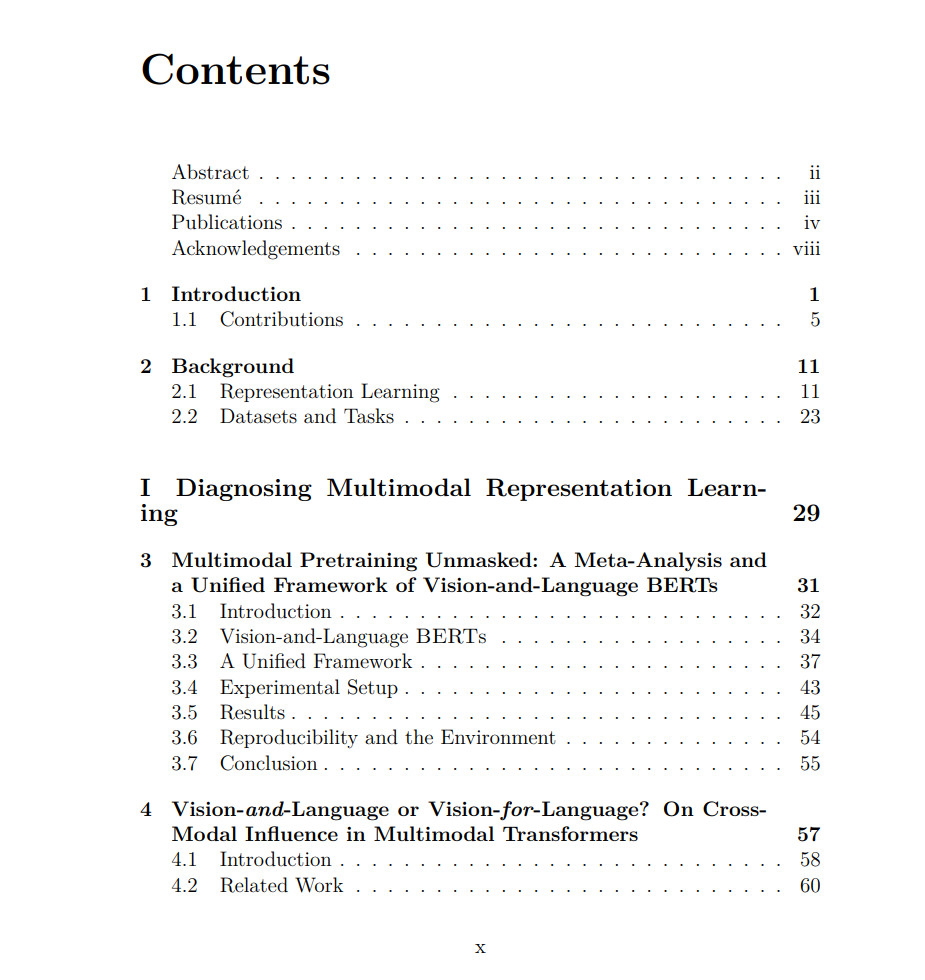

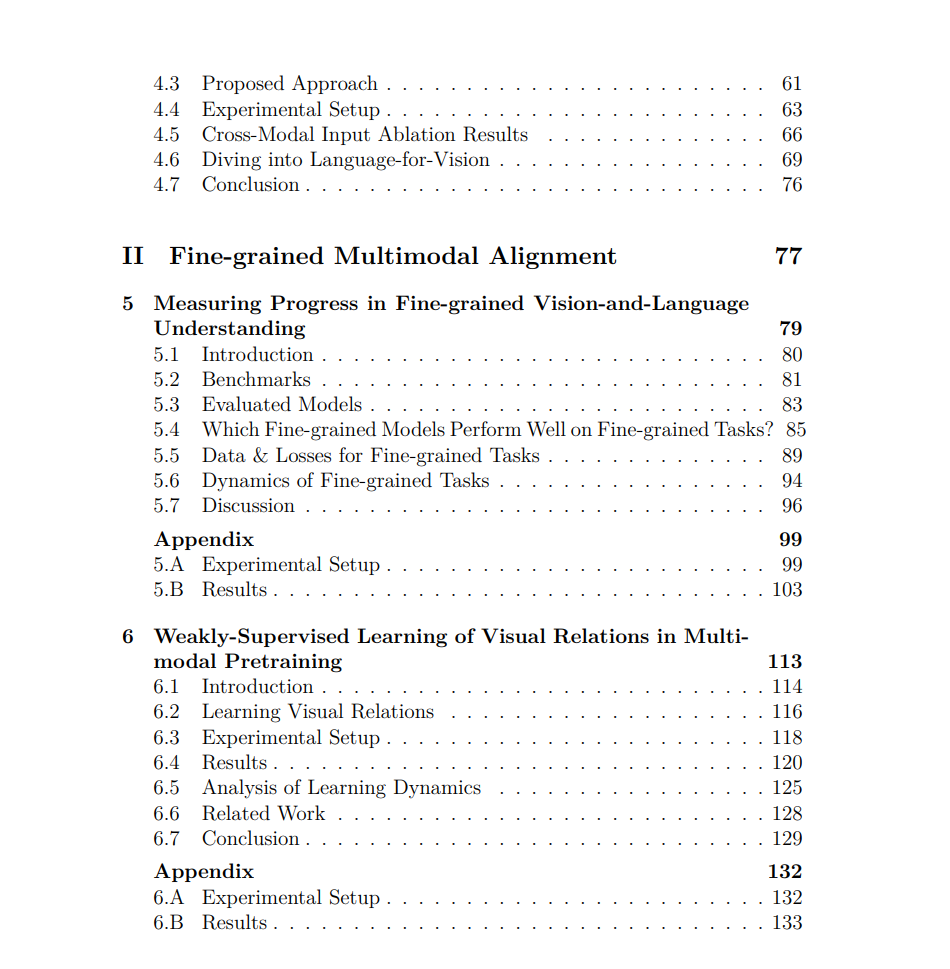

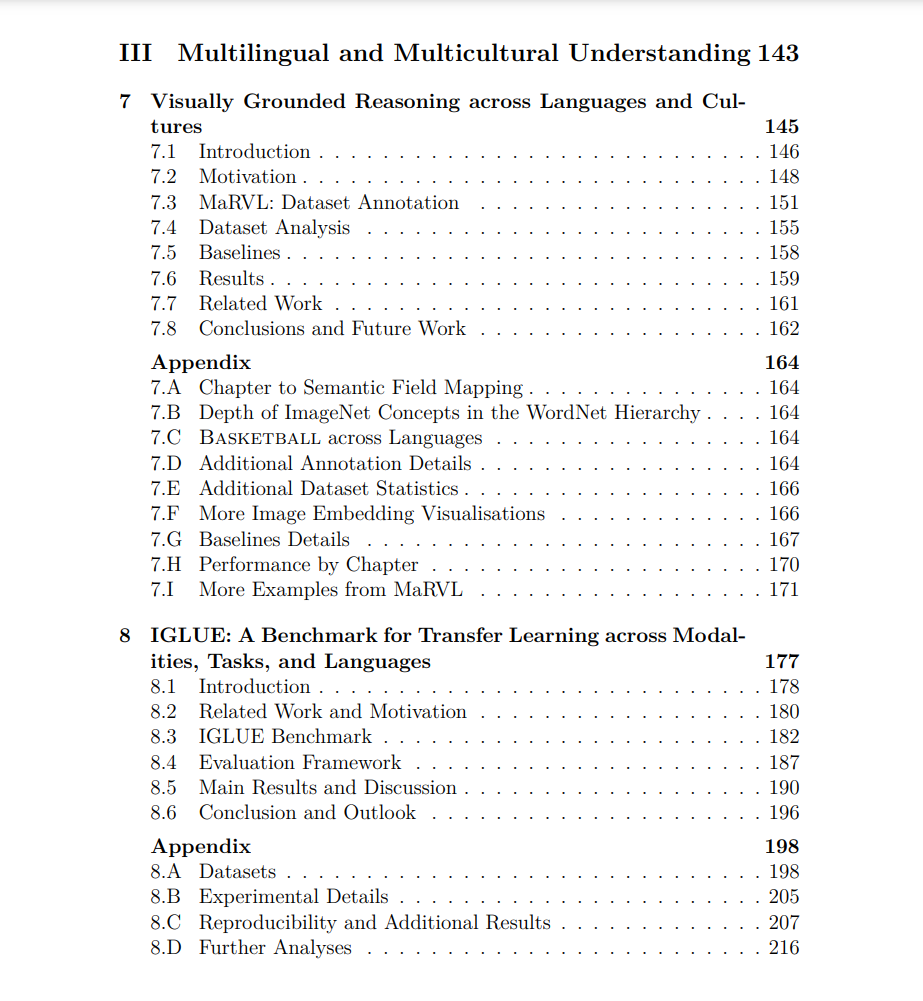

作为人类,我们通过对“世界如何运作”的丰富心智表征来赋予词语和物体以意义。通过处理我们的感官所接收的感知输入并与我们的环境互动,我们获得了对世界中概念的扎实表征,并将其映射到语言中的词语以便彼此交流。最近在人工智能领域的进步得益于构建了一个压缩但复杂的世界观的深度神经网络。这个过程被称为表征学习(representation learning),现在通常与一个称为预训练(pretraining)的学习阶段联系在一起,旨在通过接触大量数据来获得通用的理解。虽然取得了成功,但表征学习的大部分工作都集中在单一模态的数据上(例如,文本、图像、视频、语音)。例如,语言模型是在大量文本上训练的,这与年幼儿童在学习语言之前学习对世界的常识性心智模型的方式不同。作为回应,本篇论文提出了对从多种模态中学习意义表征的新兴框架的关键和深入研究,特别是视觉和语言。多模态表征学习是实现人类形式人工智能的一个有希望的方向,使机器能够解释和推理多模态信号,并获得与我们相一致的世界知识。

在整篇论文中,我们旨在深入理解在从互联网上收集的非常大的数据集上训练的多模态网络。我们首先评估在受控设置中导致强大、通用模型的关键因素,并通过一种新颖的数据中心方法检查网络表征是否确实是跨模态的。然后,我们深入研究多模态表征在进行视觉和文本模态之间的细粒度映射方面的能力。我们的调查显示了多样化、以对象为中心的数据的重要性,并引导我们走向新的关系感知方法,以增强多模态对齐。最后,我们仔细审视社区用于衡量预训练多模态网络性能的典型基准测试实践。我们构建了数据集和评估套件,揭示了最先进的多模态表征无法理解地理上多样的数据和语言的能力,并鼓励研究社区开发在不同人群中表现一致的多模态技术。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

223+阅读 · 2023年4月7日

Arxiv

86+阅读 · 2023年4月4日

Arxiv

152+阅读 · 2023年3月29日