在过去的十年里,深度学习方法已成为计算机视觉、自然语言处理和语音识别等众多领域的主导方法。然而,这些模型也因其高计算成本和大量数据需求而臭名昭著。此外,它们常常给非技术用户带来显著挑战,这些用户通常缺乏将这些模型有效定制到特定应用的专业知识。在这篇论文中,我们通过探索分摊相似学习任务训练模型的成本来应对这些挑战。我们提出了一种方法,不是独立训练多个模型,而是学习一个单一的、可重配置的模型,有效捕获底层问题的全谱。一旦训练完成,这个模型可以在推理时动态地重新配置,调整其属性而不增加额外的训练成本。

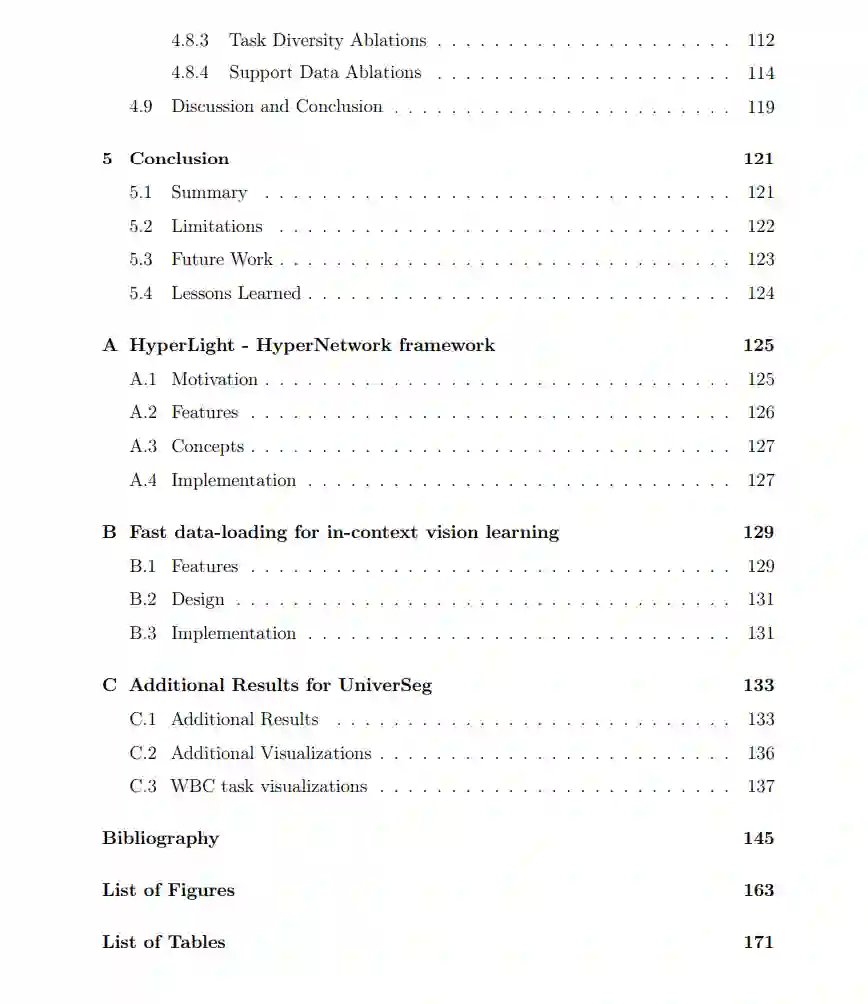

首先,我们引入了尺度空间超网络,这是一种学习具有不同效率特征连续体的CNNs的方法。这使我们能够通过训练单一的超网络来描述模型的整个帕累托准确性-效率曲线,从而大幅降低训练成本。然后,我们描述了在超网络训练中之前未识别的优化问题,并提出了一种修正的超网络公式,导致更快的收敛和更稳定的训练。最后,我们提出了UniverSeg,这是一种用于通用生物医学图像分割的上下文学习方法。给定一个查询图像和一组定义新分割任务的图像-标签对示例,它可以在不需要额外训练的情况下产生准确的分割,超越了几种在未见分割任务上的相关方法。

我们通过聚焦于计算机视觉和生物医学成像的实际应用来实证展示我们方法的有效性,评估了广泛的任务和数据集。在所有这些工作中,我们发现训练可重配置模型不仅是可行的,而且在做到这一点的过程中,我们在训练和推理时间都实现了显著的效率提升。

成为VIP会员查看完整内容

相关内容

Arxiv

225+阅读 · 2023年4月7日