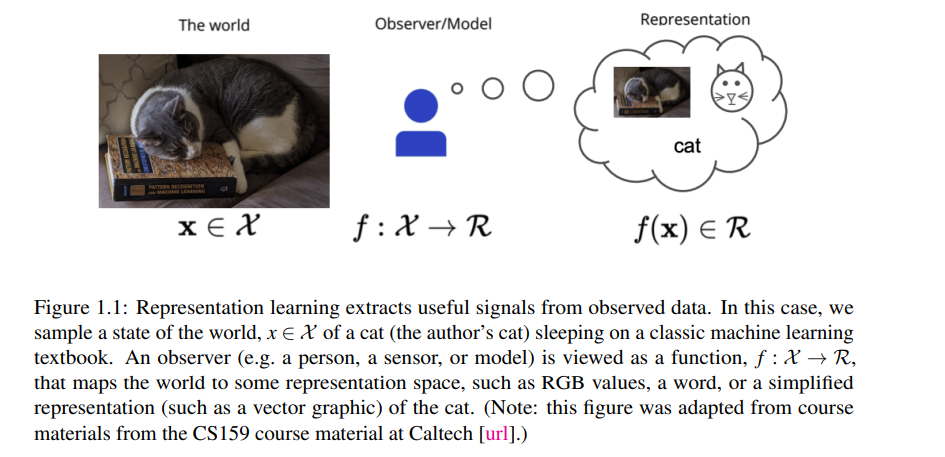

最近在无监督表示学习方面的进展导致了许多广泛使用的人工智能工具,如ChatGPT和稳定扩散。这些工具是将相对简单的训练算法应用于大规模GPU集群上的大规模模型,甚至是大量未标记的训练数据,以及在大量标记的评估任务上调整算法的结果。在这篇论文中,我们提出了一些方法来解决在训练模型进行表示学习时去除这些组件的问题,即有限的计算量、有限的训练数据和有限的评估数据。本文主要分为四章,重点研究数据和标签高效的表示学习。

数据高效表示学习的重点是用较少的数据(有标记或无标记)学习有用的表示,这在本文中讨论过,对于数据可用性有限的应用特别重要。标记高效表示学习专注于在训练数据很少或没有人工标注的情况下学习有用的表示。正如将要讨论的,这对于通常很难或不可能获得准确标记数据的应用程序很重要,例如在隐私敏感领域或具有高度模糊的标签定义的应用程序。

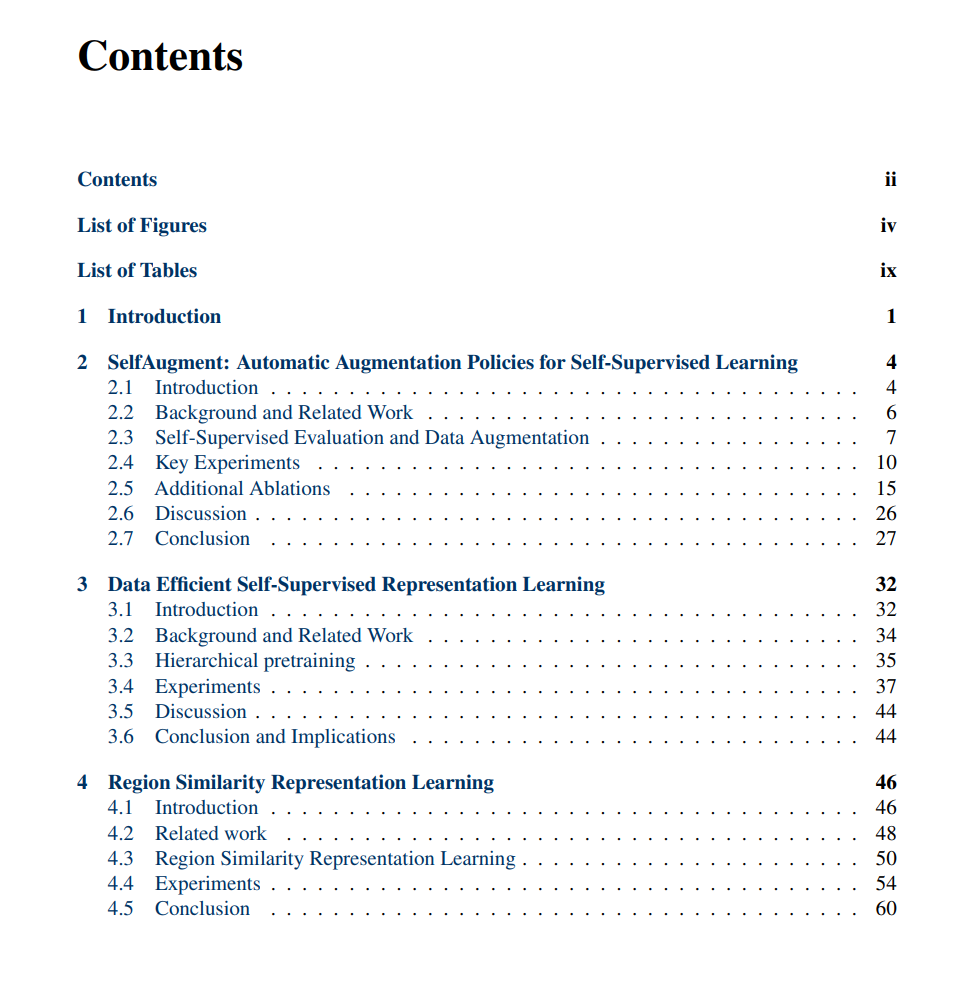

(1)自增强:用于自监督学习的自动增强策略,探索了如何在很少/没有标记训练数据和少量无标记数据的情况下为无监督学习管道开发增强策略。(2)数据高效的自监督表示学习,探索了如何利用一种形式的分层预训练进行数据高效80倍的预训练。(3)区域相似性表示学习,通过在区域(基于块的)水平上进行对比学习,探索了学习区域级表示的首批方法之一,并在标记数据很少的情况下,对目标检测/分割等下游任务进行了实质性的改进。(4) scale - mae:一种面向多尺度地理空间表示学习的尺度感知掩码自编码器,探索了利用已知尺度信息进行地理空间表示学习的方法。

成为VIP会员查看完整内容

相关内容

加州大学伯克利分校(University of California, Berkeley),是美国最负盛名且是最顶尖的一所公立研究型大学,位于旧金山东湾伯克利市的山丘上。创建于1868年,是加州大学十个分校中历史最悠久的一所。加州大学伯克利分校在世界范围内拥有崇高的学术声誉,拥有丰富的教学资源,研究水平非常坚厚,与斯坦福大学、麻省理工学院等一同被誉为美国工程科技界的学术领袖。

Arxiv

0+阅读 · 2023年4月6日

Arxiv

0+阅读 · 2023年4月3日

Arxiv

0+阅读 · 2023年3月31日

Arxiv

27+阅读 · 2021年1月21日