如今,现实世界的应用经常面临着流数据,这要求学习系统在数据演变时吸收新知识。持续学习(CL)旨在实现这一目标,同时在学习新知识时克服对既有知识的灾难性遗忘。典型的CL方法从头开始构建模型,以适应不断涌入的数据。然而,预训练模型(PTM)时代的到来激发了巨大的研究兴趣,特别是在利用PTM的强大表示能力进行CL方面。本文提供了一项关于基于PTM的CL的最新进展的全面综述。我们将现有方法分为三个不同的组别,并提供了它们的相似性、差异性以及各自的优势和劣势的比较分析。此外,我们提供了一个实证研究,对比各种最新的方法,以突出比较中的公平性问题。要重现这些评估的源代码可在以下地址获取:https://github.com/sun-hailong/LAMDA-PILOT。

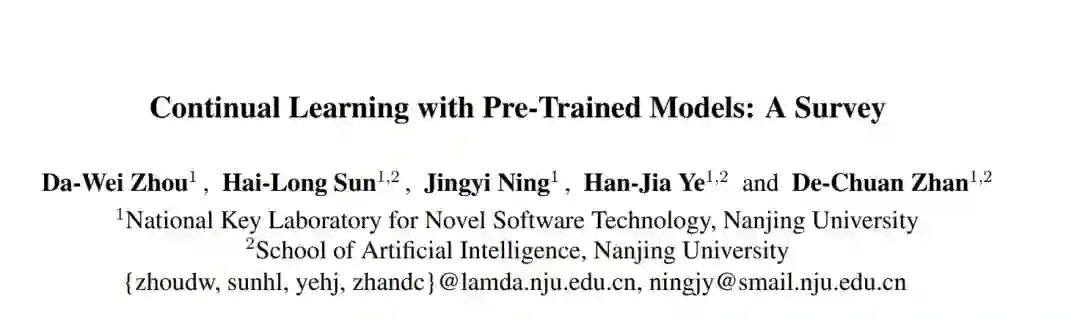

随着深度神经网络的快速发展,深度学习模型在各种应用中展现出了令人期待的结果 [He等人,2016年;Chao等人,2020年;Yang等人,2015年;Ye等人,2021年;Ning等人,2022年]。然而,现实世界的场景往往以流数据的形式呈现。例如隐私问题 [Ning等人,2023年] 和存储限制阻止了流数据的永久保留,这就需要一个能够持续适应和进化的学习系统,这个过程被称为持续学习(CL)[van de Ven等人,2022年;De Lange等人,2021年;Masana等人,2023年]。CL中的一个关键问题是灾难性遗忘的现象,即获得新知识导致在以前学过的任务上的性能显著下降 [McCloskey和Cohen,1989年]。众多研究致力于在CL内部解决这一问题 [Gunasekara等人,2023年;Wang等人,2023d;Wang等人,2023a;Wang等人,2023c;Zhuang等人,2022年;Zhao等人,2021年;Liu等人,2024年;Zhou等人,2023b]。 传统的CL方法从“零开始训练”的模型开始,即从随机初始化的权重开始。然而,预训练技术的蓬勃发展开辟了新的途径。利用预训练模型(PTMs),这些模型是从大量数据集和复杂技术 [Steiner等人,2021年] 开发而来,对CL展示了巨大的潜力。这些PTM本质上具有对各种下游任务的强大泛化能力,使基于PTM的CL成为一个日益流行的话题。 图1展示了基于PTM的持续学习方法与传统持续学习方法之间的区别。两种方法都在数据流中使用CL模型来适应一系列即将到来的任务。目标是让模型在吸收新信息的同时保留之前获得的知识。这需要在学习每个新任务后评估模型在所有遇到的任务上的表现。基于PTM的CL与传统CL之间的主要区别在于CL模型的初始设置。基于PTM的策略从一个大规模的预训练模型开始,而传统方法从零开始训练一个模型。这种差异可以类比为人类学习:传统方法类似于训练一个婴儿成长并获得新知识,而基于PTM的方法类似于利用成人的专业知识来完成相同的学习任务。 在这个快速发展的领域中,现有关于CL的综述主要关注不包括预训练模型的典型算法 [van de Ven等人,2022年;De Lange等人,2021年;Masana等人,2023年]。然而,在当前的PTM时代,基于PTM的CL正成为一个中心关注领域。观察表明,基于PTM的CL的性能正在接近持续学习潜力的上限 [Zhou等人,2023a],表明这是一个有前途的实际应用领域。因此,迫切需要对基于PTM的CL进行一次全面、最新的综述,以推进CL领域的进步。我们综述的具体贡献如下: 1. 我们提出了第一个全面的关于基于预训练模型的持续学习最新进展的综述,包括问题定义、基准数据集和评估协议。我们根据这些方法的定义特征,将它们系统地分类为三个子类别,提供了一个全面和结构化的主题概述。 1. 我们的评估扩展到每个子类别中的代表性方法在七个基准数据集上。此外,我们识别了一个可能影响基于PTM的持续学习中比较公平性的关键因素,为方法论评估提供了见解。 1. 我们突出了基于PTM的持续学习中当前的挑战和潜在的未来方向。我们打算揭示未经充分研究的方面,以激发进一步的调查,探索这个领域内各种可能的路径及其相互关系。

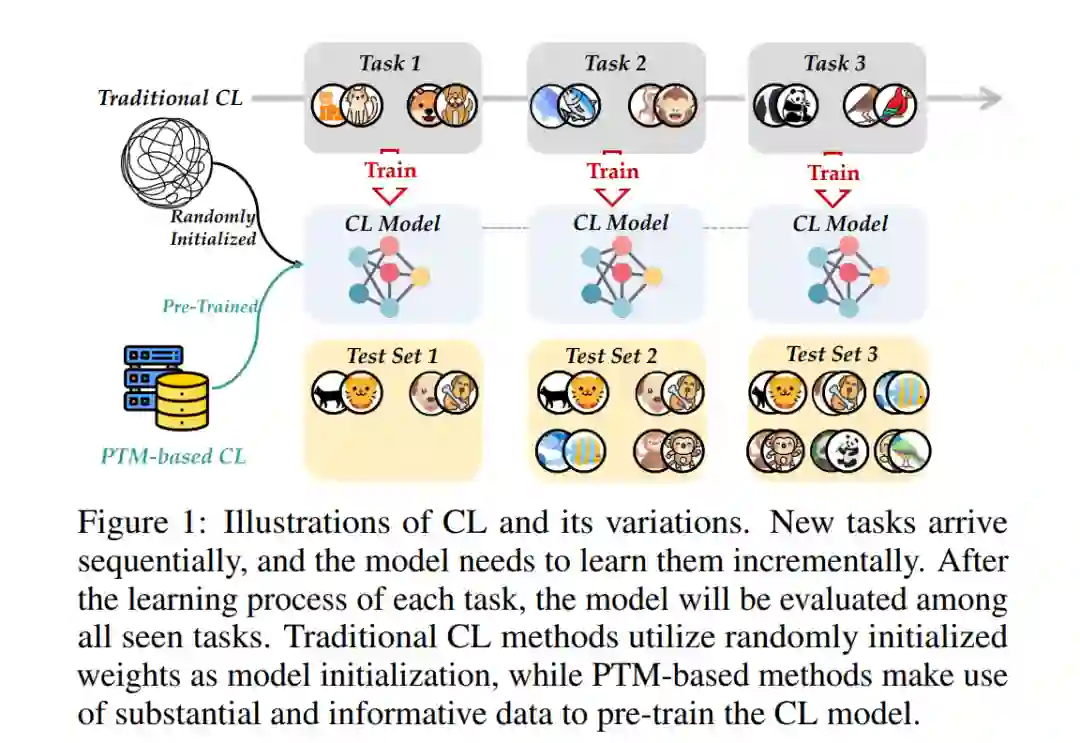

基于PTM的持续学习 我们将当前基于PTM的CL研究分类为三个类别,这些类别基于不同的理念来解决学习问题,即基于提示的方法、基于表示的方法和基于模型混合的方法。这些类别利用预训练模型的不同方面来促进持续学习。例如,考虑到PTM的强大泛化能力,基于提示的方法会采用提示调整 [Jia等人,2022年] 来进行PTM的轻量级更新。由于预训练的权重保持不变,PTM的泛化能力可以被保留,从而缓解了遗忘。类似地,基于表示的方法直接利用PTM的泛化能力来构建分类器。最后,基于模型混合的方法在学习过程中设计了一组模型,并利用模型合并、模型集成和其他混合技术来得出最终预测。 我们展示了基于PTM的CL的分类法,并在图2中列出了代表性的作品。在接下来的部分中,我们将介绍每个类别,并深入讨论它们的优点和缺点。