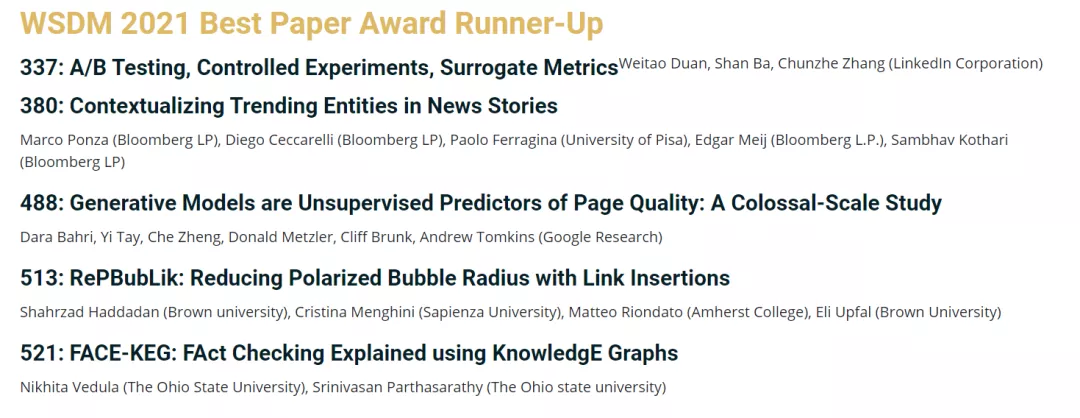

2021年第14届国际网络搜索与数据挖掘会议WSDM将在2021年3月8日到12日于线上举行。今年此次会议共收到了603份有效投稿,最终录取篇数为112篇,录取率为18.6%。近日大会公布了优秀论文奖项(WSDM 2021 Best Paper Award Runner-Up),共有5篇论文。

WSDM,全称为ACM网络搜索与数据挖掘国际会议(ACM International Conference on Web Search And Data Mining) ,是一个有关搜索和数据挖掘的互联网启发式研究的主要会议之一,每年举办一届。WSDM是信息检索与数据挖掘的顶级会议。

Generative Models are Unsupervised Predictors of Page Quality: A Colossal-Scale Study

D Bahri, Y Tay, C Zheng, D Metzler, C Brunk, A Tomkins

[Google Research]

将生成式模型用于无监督评价网页语言/内容质量,通过人工评价证明,训练用来区分人工和机器生成文本的分类器,可作为“页面质量”的无监督预测器,在没有任何额外训练的情况下检测出低质量的网页内容。

https://arxiv.org/abs/2008.13533

ePBubLik:通过插入链接来减小极化气泡半径

RePBubLik: Reducing the Polarized Bubble Radius with Link Insertions 地址:http://arxiv.org/abs/2101.04751

作者:Shahrzad Haddadan, Cristina Menghini, Matteo Riondato, Eli Upfal

摘要:表达不同观点的页面之间的超链接图的拓扑结构可能会影响读者对各种内容的理解。结构性偏见可能会使读者陷入两极分化的泡沫中,而无法获得其他意见。我们将读者的行为建模为随机游走。如果从节点到另一观点的页面的随机游走的预期长度很大,则该节点处于极化泡沫中。图的结构偏差是高度极化的气泡半径的总和。我们研究了通过边插入来减少结构偏差的问题。在对数因子内很难治愈所有具有高极化气泡半径的节点,因此,我们着重于寻找插入的最佳 k 边以最大程度地减少结构偏差。我们介绍了RePBubLik,这是一种利用随机游走接近中心性的变体来选择要插入的边的算法。RePBubLik在温和条件下获得恒定因子近似值。它比现有的边推荐方法(包括一些旨在减少图极化的方法)更快地降低了结构偏差。