作为解决复杂问题的基本能力,推理可以为各种实际应用提供后端支持,如医学诊断、谈判等。本文对语言模型提示推理的前沿研究进行了全面概述。我们介绍了研究成果的对比和总结,并为初学者提供了系统性的资源。我们还讨论了这种推理能力出现的潜在原因,并强调了未来研究的方向。

1. 引言

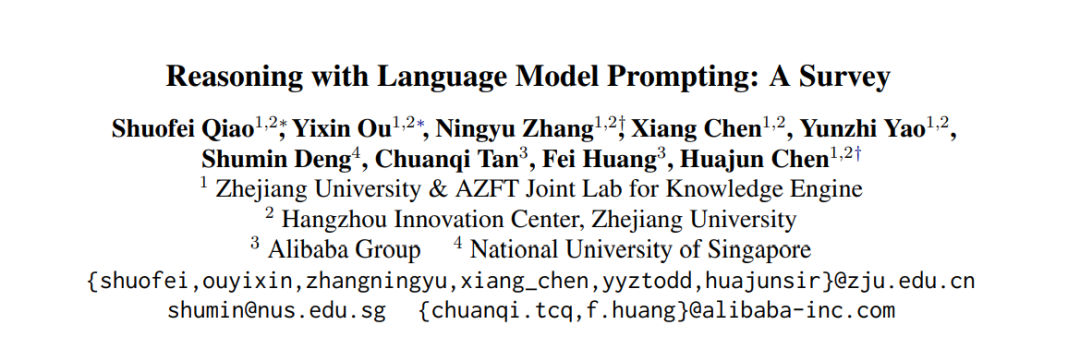

推理能力是人类智能的核心,然而在自然语言处理(NLP)领域,现代神经网络很难从所告知或已知的信息中进行推理(Duan 等,2020;Wang 等,2021;Bhargava 和 Ng,2022)。幸运的是,zhe(Brown 等,2020;Chen 等,2021;Chowdhery 等,2022),扩大语言模型(LMs)的规模已经被证明可以赋予一系列推理能力,如算术推理(Wang 等,2022e;Lewkowycz 等,2022)、常识推理(Jung 等,2022;Liu 等,2022b)和符号推理(Zhou 等,2023;Khot 等,2023)。如图 1 所示,这种能力可以通过提示策略(Liu 等,2022d)(如思维链提示(CoT)(Wei 等,2022b),生成知识提示(Liu 等,2022c))来解锁,从而大大缩小人类与机器智能之间的差距。同样,NLP领域有大量的工作被提出;然而,这些方法分散在各种任务中,并未得到系统的回顾和分析。

本综述组织:在本文中,我们进行了第一次关于语言模型提示推理的最近进展调查。我们首先介绍这个方向的一些初步内容(§2),然后建议按照分类法组织相关工作(§3)。我们进一步提供深入的比较和讨论以获得洞察力(§4)。为了方便对这个领域感兴趣的初学者,我们强调了一些开放资源(§5)以及潜在的未来发展方向(§6)。

为了提高语言模型提示的推理能力,研究主要有两个分支。第一个分支专注于优化提示推理策略,如图 2 所示,包括提示工程(§3.1.1)、过程优化(§3.1.2)和外部引擎(§3.1.3)。

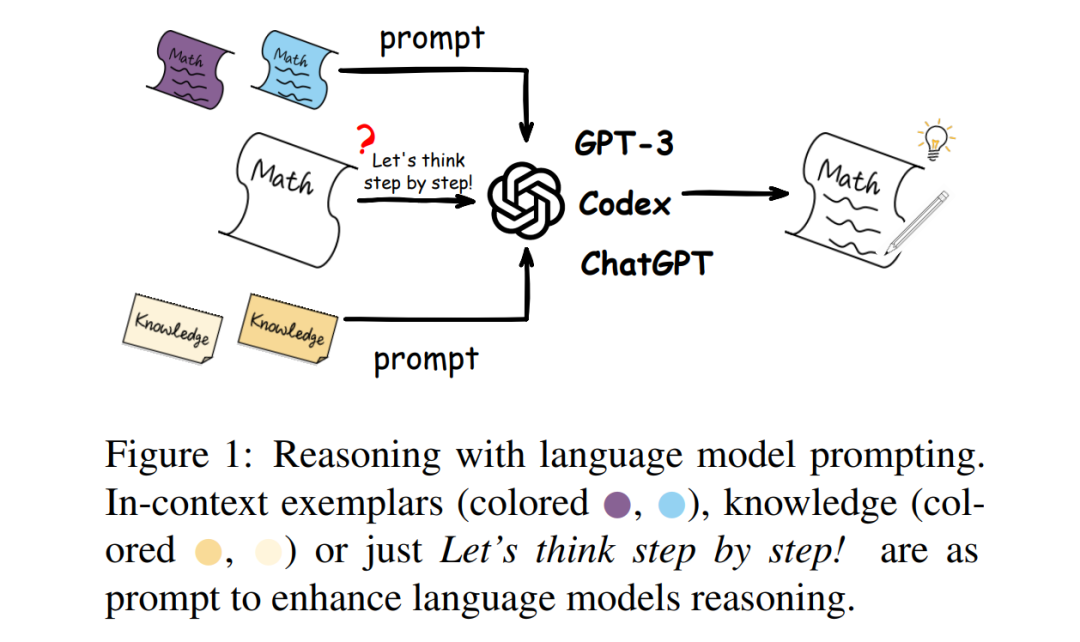

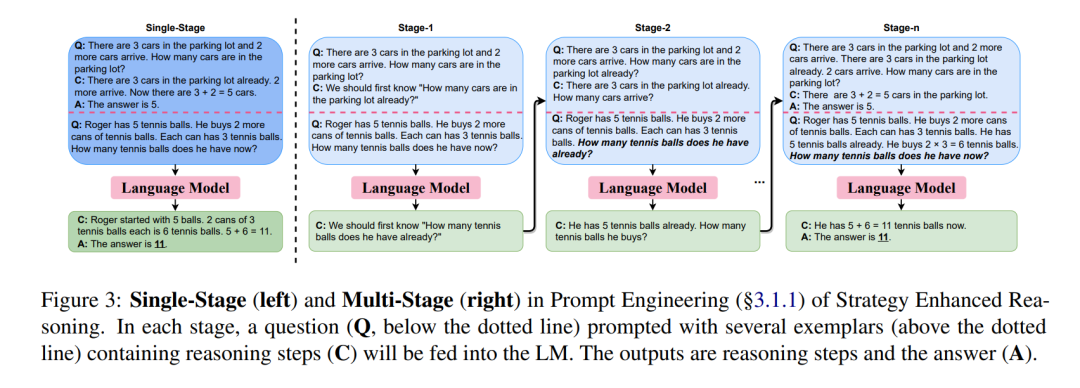

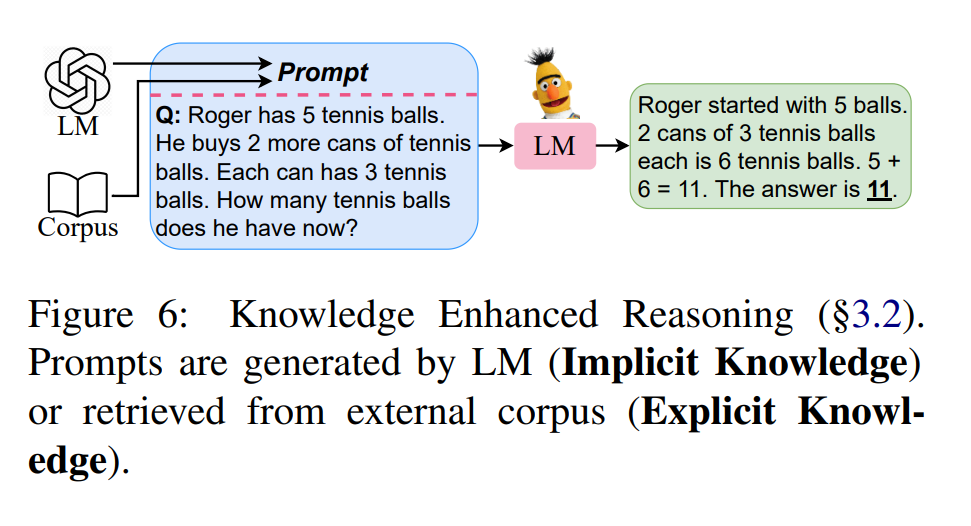

在提示工程(§3.1.1)中,许多方法试图提高提示 T 的质量,我们称这些工作为单阶段方法;而其他方法在每个推理阶段将 ci 添加到(T ,Q)的上下文中,或为每个 ci 设计特定的 Tci ,我们将这些方法视为多阶段方法。需要注意的是,这里的一个阶段是指一个输入输出过程。对于过程优化(§3.1.2),最简单的方法是引入带有参数θ的优化器,用于在生成A时校准C,我们称这些工作为自优化方法。另一些方法尝试获得多个过程来得到最终的答案组合,我们将这些工作视为集成优化方法。此外,整个优化过程可以通过对生成的三元组(Q,C,A)进行微调 pLM 迭代地集成,这被视为迭代优化方法。此外,一些工作利用外部推理引擎(§3.1.3)生成 T ,直接执行 C 或通过在 C 中植入工具 API 调用进行推理。研究的第二个分支重点关注提示的知识增强。需要注意的是,LM 中丰富的隐式“模型知识”(Han等人,2021)可以生成知识或基于知识的提示 T(§3.2.1)。同时,外部资源中的显式知识也可以被利用并检索为知识性提示,以增强推理 (§3.2.2)。

3. 方法体系

在本文中,我们调研了现有的基于语言模型提示的推理方法,并将它们归类为策略增强推理(§3.1)和知识增强推理(§3.2)。如图2所示,我们根据不同方法的独特特征进一步细化它们。

3.1 策略增强推理

这方面工作的主要目的是设计更好的推理策略,具体体现在提示工程(§3.1.1)、流程优化(§3.1.2)和外部引擎(§3.1.3)中。

3.1.1提示工程

一种改进提示推理的直观方法是提示工程。如图3所示,我们根据提示阶段的数量将这种方法分为单阶段提示和多阶段提示。

3.1.2 流程优化

自然语言理据(Ling et al., 2017a),也称为CoT中的推理过程,在CoT提示中起着至关重要的作用(Ye and Durrett, 2022;Lampinen等人,2022;Min et al., 2022)。推理过程的一致性(Wang et al., 2022e)和推理步骤之间的连续性(Li et al., 2022d)都会影响最终答案的准确性。直观地,如图4所示,我们将这一行方法分为三种类型,即自优化、集成优化和迭代优化。

3.1.3 外部引擎

在LM提示下进行推理时,模型应具有语义理解(如问题)和复杂推理(如通过生成推理过程)的能力;然而,我们不能同时拥有鱼和熊掌(Hendrycks等人,2021;Nogueira等人,2021;Lewkowycz等人,2022)。为了打破这个障碍,外部推理引擎可以帮助语言模型(见图5)。

3.2 知识增强推理

正如Manning(2022)所指出的,知识在AI推理系统中起着至关重要的作用。知识增强方法旨在用隐式(§3.2.1)或显式(§3.2.2)知识提示语言模型,以协助推理(见图6)。

**3.2.1 隐式知识 **

研究人员已经证明,语言模型中包含大量的隐式知识(Davison等人,2019;Petroni等人,2019;Jiang等人,2020)。以下工作试图将这种“模型知识”引入作为知识提示进行推理。刘等人(2022c)使用少量提示的 GPT-3(Brown 等人,2020)生成知识并提示下游 LM。刘等人(2022b)借助强化学习(Schulman等人,2017)进一步校准知识。与在知识生成阶段使用少量提示的方法不同,孙等人(2022)提出了一种两阶段生成提示,其中还包括答案生成提示。其他工作(李等人,2022b;王等人,2023;Shridhar等人,2022;Magister等人,2022;何等人,2022)遵循知识蒸馏,通过提示更大的 LM 生成推理样本并教授较小的 LM。

3.2.2显性知识

尽管大型语言模型已显示出强大的生成能力(Wiegreffe等人,2022;Li等人,2022b;Wang et al., 2023),他们仍然有幻觉事实的倾向(Rohrbach等人,2018)和产生不一致的知识(Liu et al., 2022b)。最近的工作表明,在上下文学习中检索提示是取得良好性能的一种很好的方法(Liu等人,2022a;Rubin等人,2022)。由于常用检索方法在度量结构化信息相似性方面的不稳定性,Lu等人(2023b)提出了一种基于策略梯度策略的动态提示检索方法,无需暴力搜索。SU等人(2023)制定了一个选择性的标注框架,以避免对大型标注检索语料库的需求。He et al.(2023)根据CoT的推理步骤检索相关知识,以提供更可靠的解释。Trivedi等人(2022)通过持久检索wiki文档来增强CoT提示,用于需要复杂的多步骤推理的开放域知识密集型任务。

4 比较与讨论

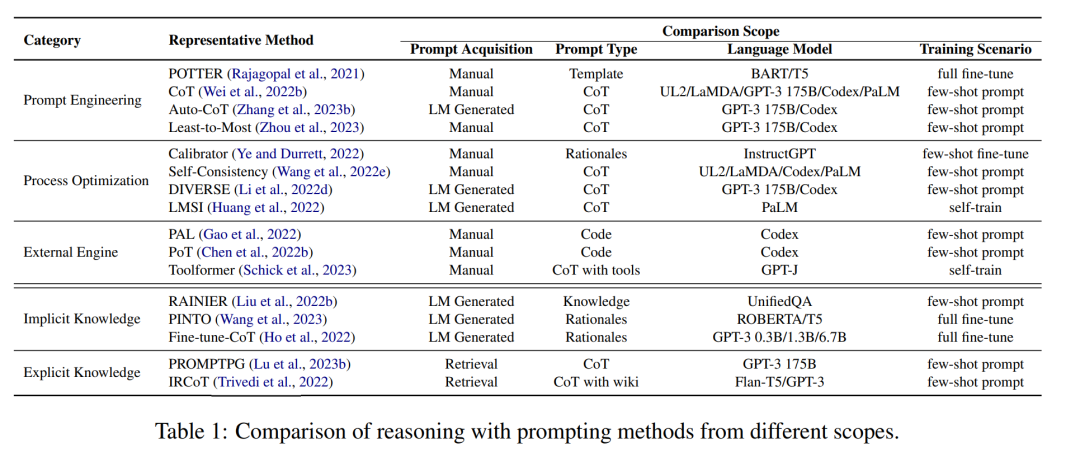

表1显示了不同方法的四种比较范围。图7进一步说明了不同规模的语言模型在算术推理的GSM8K (Cobbe等人,2021)上的性能比较。常识推理基准的类似结果见附录A.3。模型规模较大的语言模型包含更多用于推理的隐性知识(Liang等人,2022b)。对代码分支进行预训练,不仅可以增强代码生成/理解能力,还可以激发CoT的推理能力。.输入上下文中包含的高质量推理依据是LM提示推理的关键。

5. 未来的发展方向

我们列出了一些潜在的方向如下:

推理的理论原理。 高效的推理。 鲁棒的、可靠的和可解释的推理 多模态(交互式)推理。 可泛化(真)推理。

6. 结论

本文对语言模型提示推理进行了综述,包括全面的比较,以及几个研究方向。展望未来,来自NLP和其他领域的方法之间将有更有效的协同作用,并希望复杂和高效的LM提示模型将越来越多地为提高推理性能做出贡献。