2025年的IJCAI(International Joint Conference on Artificial Intelligence) 于8月16日至8月22日在加拿大蒙特利尔召开。IJCAI是中国计算机学会推荐的A类国际学术会议,是人工智能领域最具权威性和影响力的学术会议之一。本次IJCAI 2025一共有5404篇投稿,录用1042篇,录用率19.3%。

来自清华大学的研究团队带来《分布偏移下的图机器学习:适配性、泛化性与图大模型》教程,值得关注!

概述

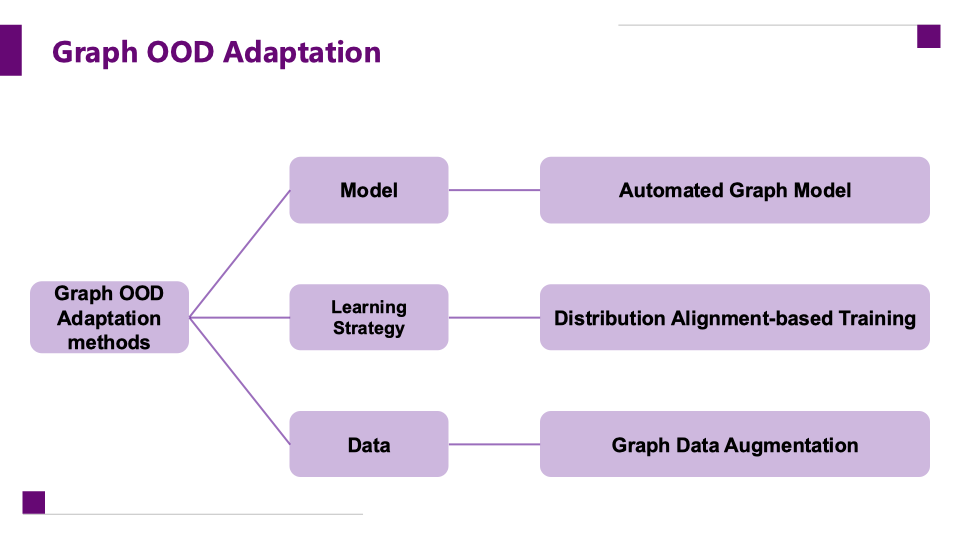

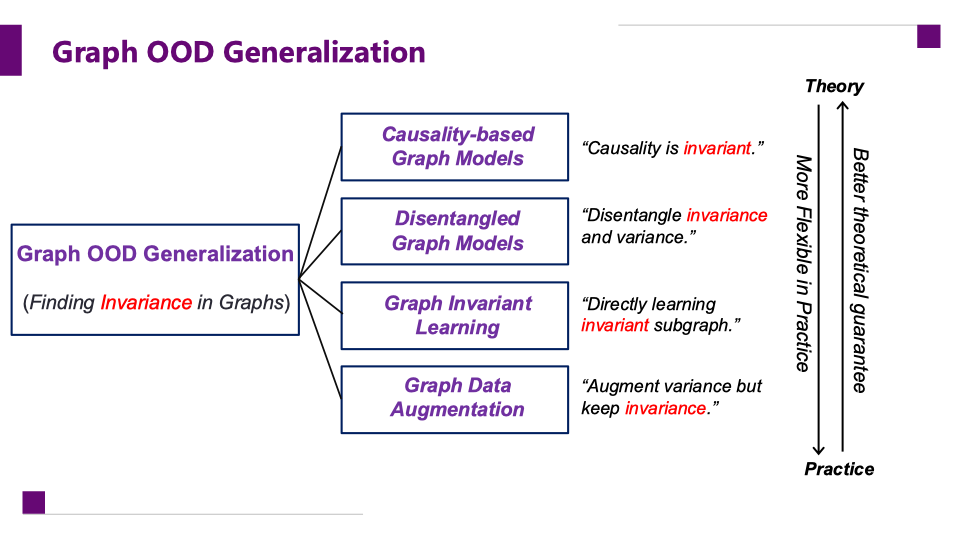

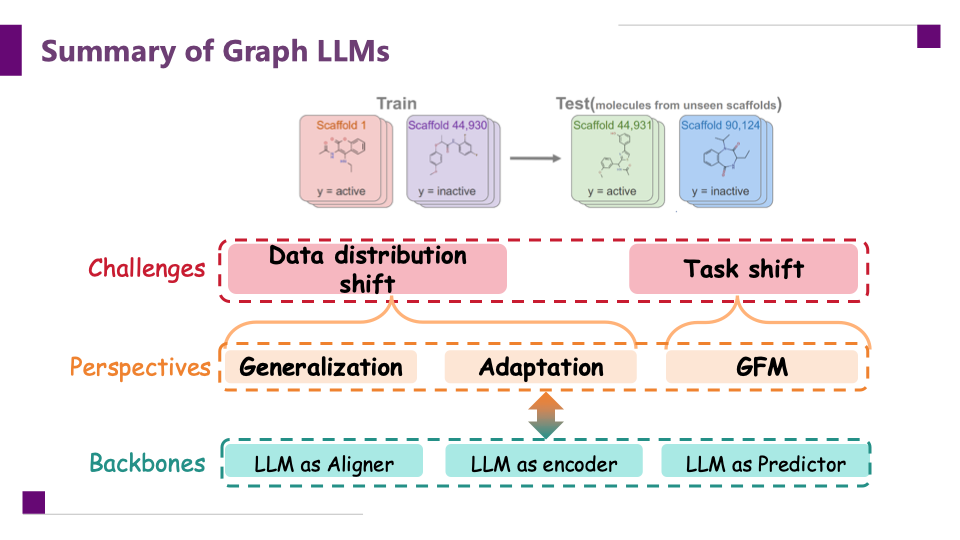

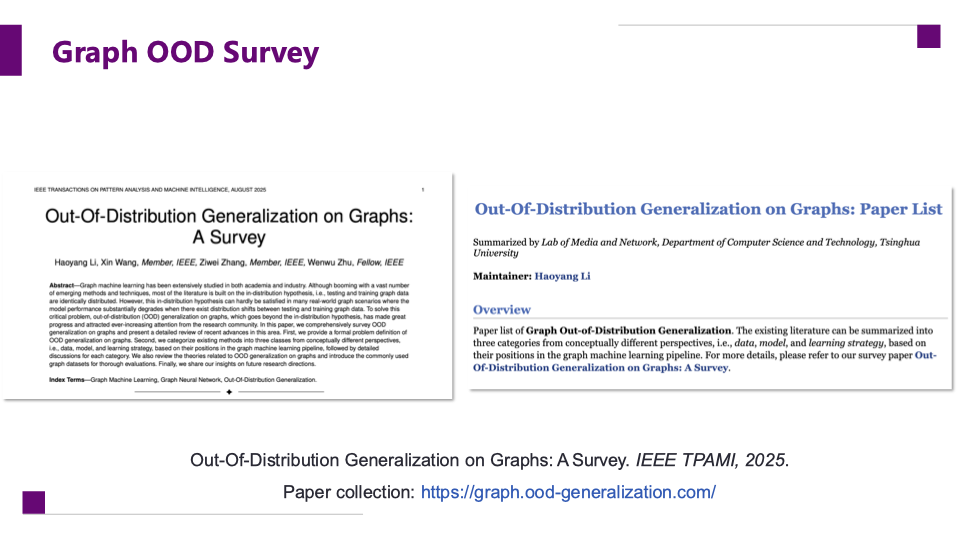

图机器学习近年来在学术界和工业界快速发展,广泛应用于社交网络、推荐系统、生物信息、药物研发等领域,展现出巨大潜力。然而,大部分研究基于同分布假设,即训练与测试数据来自相同分布。但在真实世界中,这一假设往往难以成立,社交网络结构不断演化,用户行为模式持续变化,生物医学数据也存在人群差异。此时,模型性能在分布外场景(Out-of-Distribution, OOD)会显著下降。如何让图模型在OOD场景中依然保持稳定、可靠的表现,已成为学术界和产业界共同关注的前沿问题。本教程系统总结该领域的最新进展,围绕以下三个方向展开: ·图模型适配(Graph OOD Adaptation):从模型、优化和数据三个维度,探索如何快速适配新分布,保持性能稳定。 ·图模型泛化(Graph OOD Generalization):通过因果建模、解耦建模、不变性学习和数据增强,提升跨分布的稳定性与泛化性。 ·图大模型(Graph LLMs & Graph Foundation Models):梳理 LLMs 与图学习的结合方式,包括编码、对齐与预测三大视角,以及 GNN 驱动与 LLM 驱动两类基础模型路线。

教程大纲

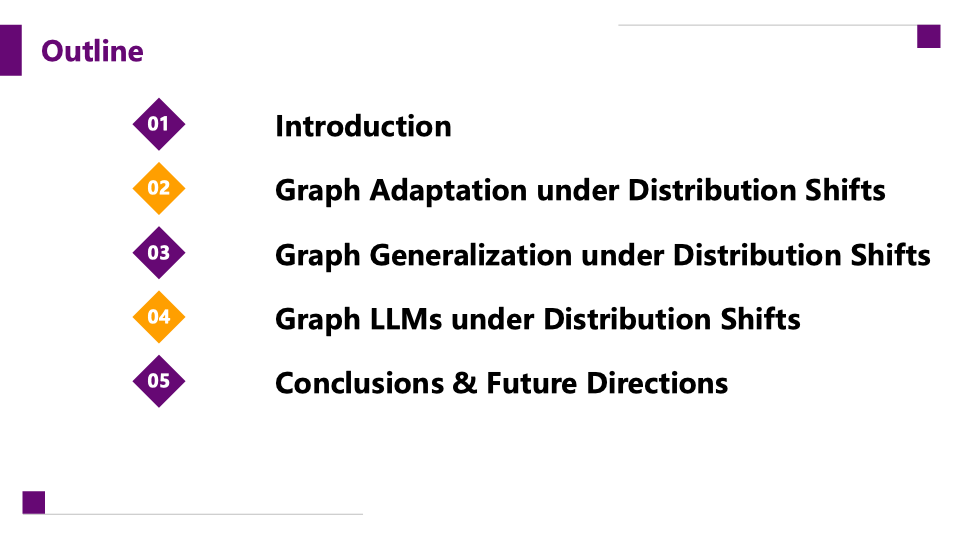

本教程时长1小时45分钟,共分五部分: 1.研究动机与基础概念(15分钟) o分布偏移的定义、挑战与研究价值 2.图模型适配(Graph OOD Adaptation)(25分钟) o模型层面:自动化适配,利用自动化方法设计能适应分布变化的图模型结构。 o优化层面:分布对齐训练,通过优化策略缩小训练与测试分布差异。 o数据层面:图数据增强,在训练阶段引入更多潜在分布,提高模型适应性。 3.图模型泛化(Graph OOD Generalization)(25分钟) o模型层面:因果建模捕捉跨环境的稳定关系,解耦建模分离稳定与变化因素。 o优化层面:不变性学习,通过约束确保表征在多分布下保持一致。 o数据层面:数据增强,提升模型在多样分布下的泛化能力。 4.图与大模型结合(Graph LLMs & Graph Foundation Models)(25分钟) oGraph LLMs:LLM 可作为编码器、对齐器或预测器,分别承担表示学习、语义对齐和任务预测功能。 oGraph Foundation Models:分为 GNN 驱动与 LLM 驱动两条路线。前者遵循“Pretrain-then-Adapt”范式,先在大规模图数据上预训练,再迁移到下游任务;后者遵循“Tokenization-then-Post-training”范式,将图结构转化为序列,再通过大模型输出。 5.未来方向与讨论(15分钟) o更复杂与动态场景下的评估挑战 o图学习与 LLMs 的深度融合趋势 o面向工业应用的可扩展与可信赖方案

目标受众与前提条件

本教程既展示最新进展与前沿研究,也对入门听众友好,适合: ·图机器学习和数据挖掘领域的研究人员与学生; ·在实际应用中面临分布偏移挑战的产业从业者; ·对 LLM 与图学习结合感兴趣的学者与工程师。