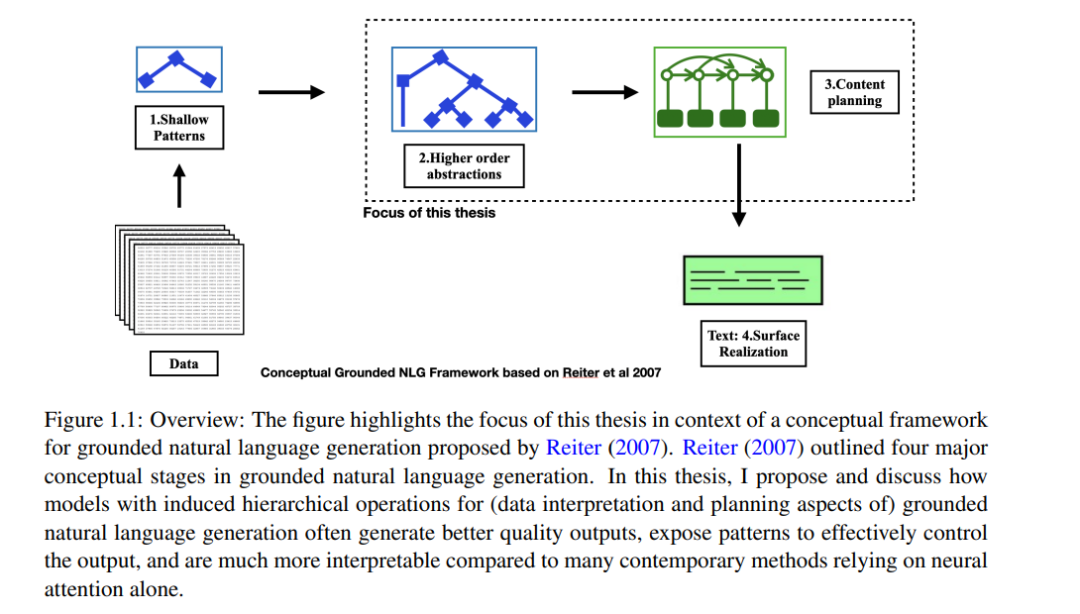

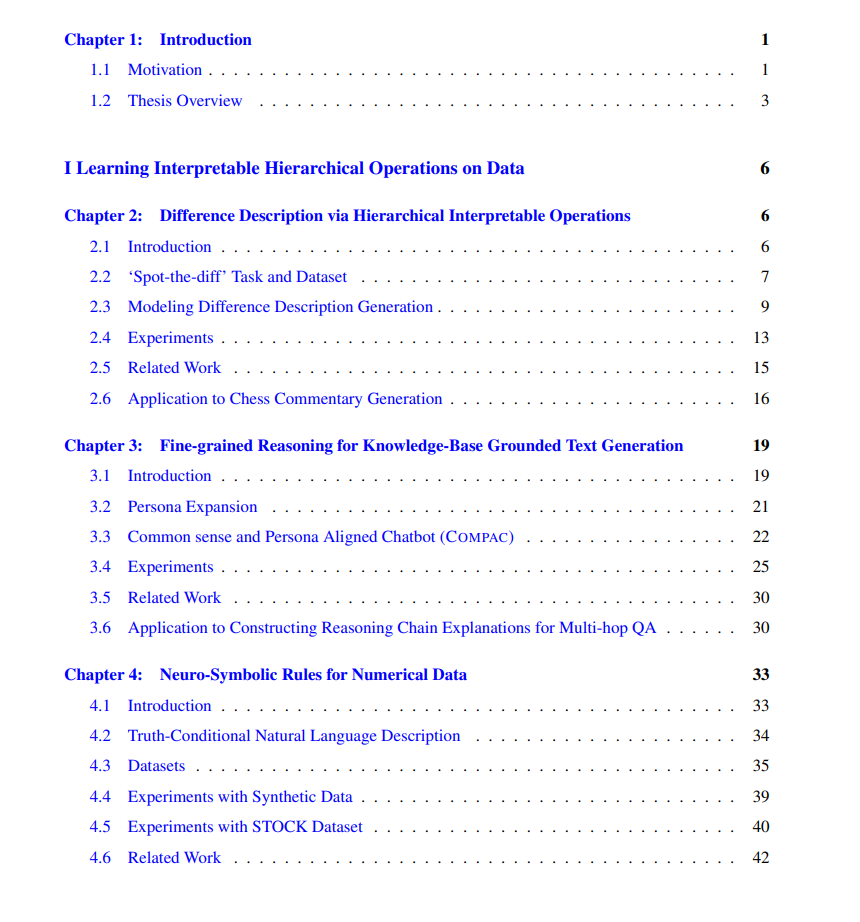

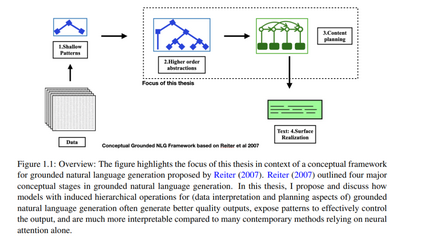

近年来,自然语言生成的许多工作依赖于深度学习,通常使用带有软注意机制的神经网络从数据中选择显著方面,然后构建流畅的自然语言文本。然而,在对数据的自然描述中,人类通常会提到更高级别的模式,这可能需要对数据进行复杂的计算。在许多情况下,仅使用软注意机制的神经模型难以提取这些模式。此外,用户可能会发现这些模型难以解释和控制。在本论文中,我提出了一种通过在数据和文本上引入某些类型的离散层级操作的方法,以实现基础自然语言生成。与仅使用注意力机制相比,这种层级操作可以更好地对数据中的复杂模式建模,揭示可解释的中间计算,并实现可控的生成。

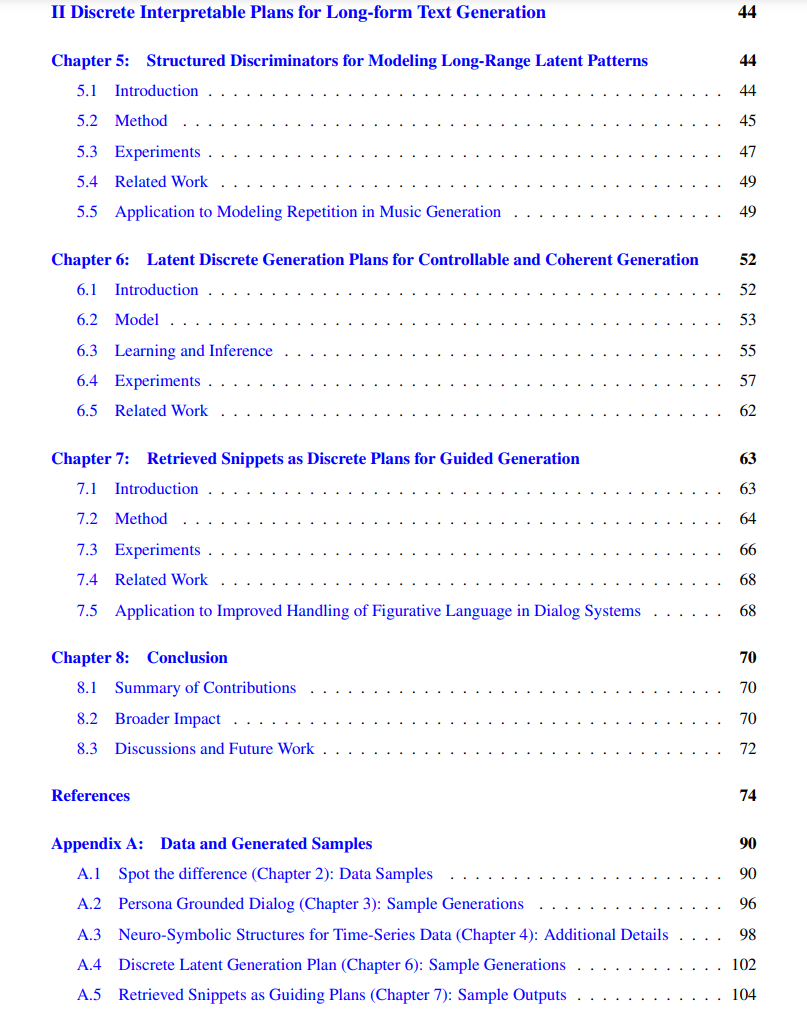

在论文的前半部分,我将讨论在不同的基础自然语言生成任务中向神经模型添加特定的离散层级操作,如图像和表格标题生成、对话响应生成以及构建多跳问题回答的推理链。这些任务涵盖了各种数据模态(包括图像、表格数据、数值数据和知识库)。在论文的后半部分,我将描述用于文本解码器中的内容规划的层级方法,研究诗歌生成中的押韵模式以及用于连贯叙事文本生成的离散计划。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日