尽管深度学习有着广泛的应用,但在实际应用中仍面临稳健性挑战,尤其是在训练和测试分布不一致的情况下。训练和测试分布之间的差异原因包括人类行为的逐渐变化或服务使用环境的人口统计学差异。虽然获取预期分布变化的标注数据可能非常困难,但未标注样本相对便宜且数量充足。

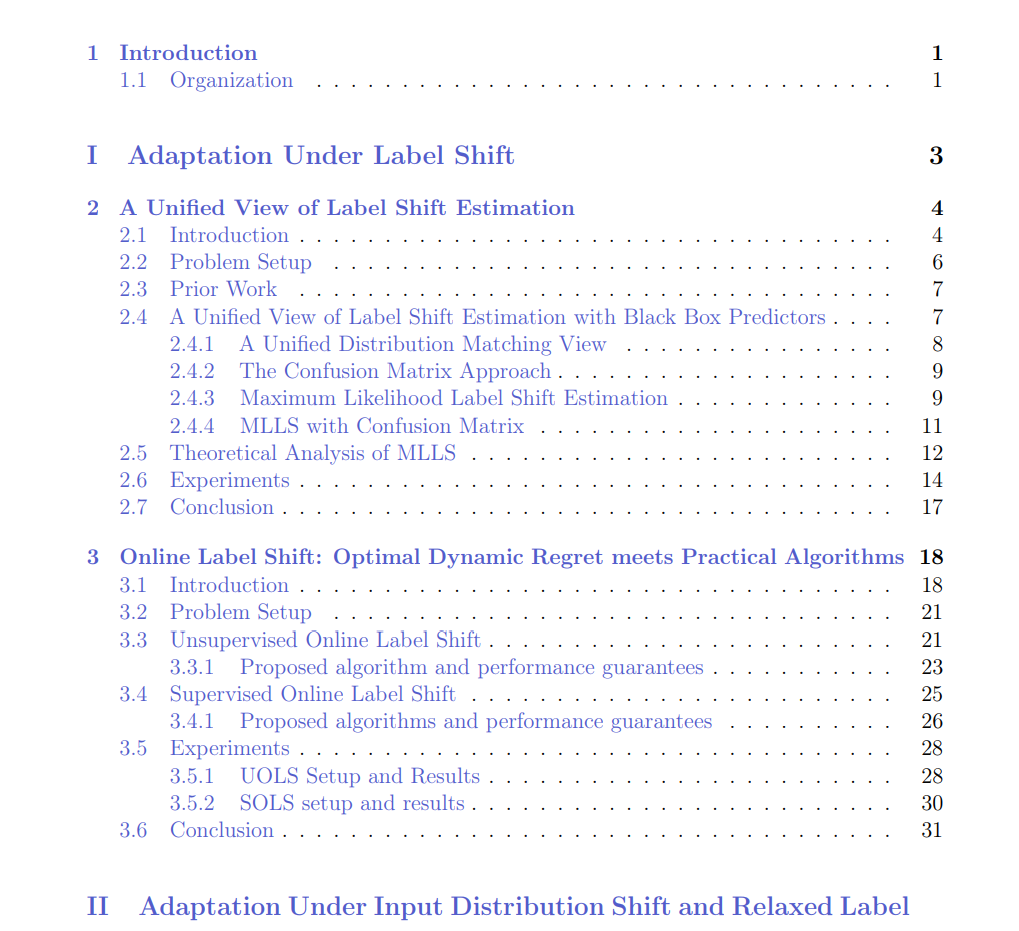

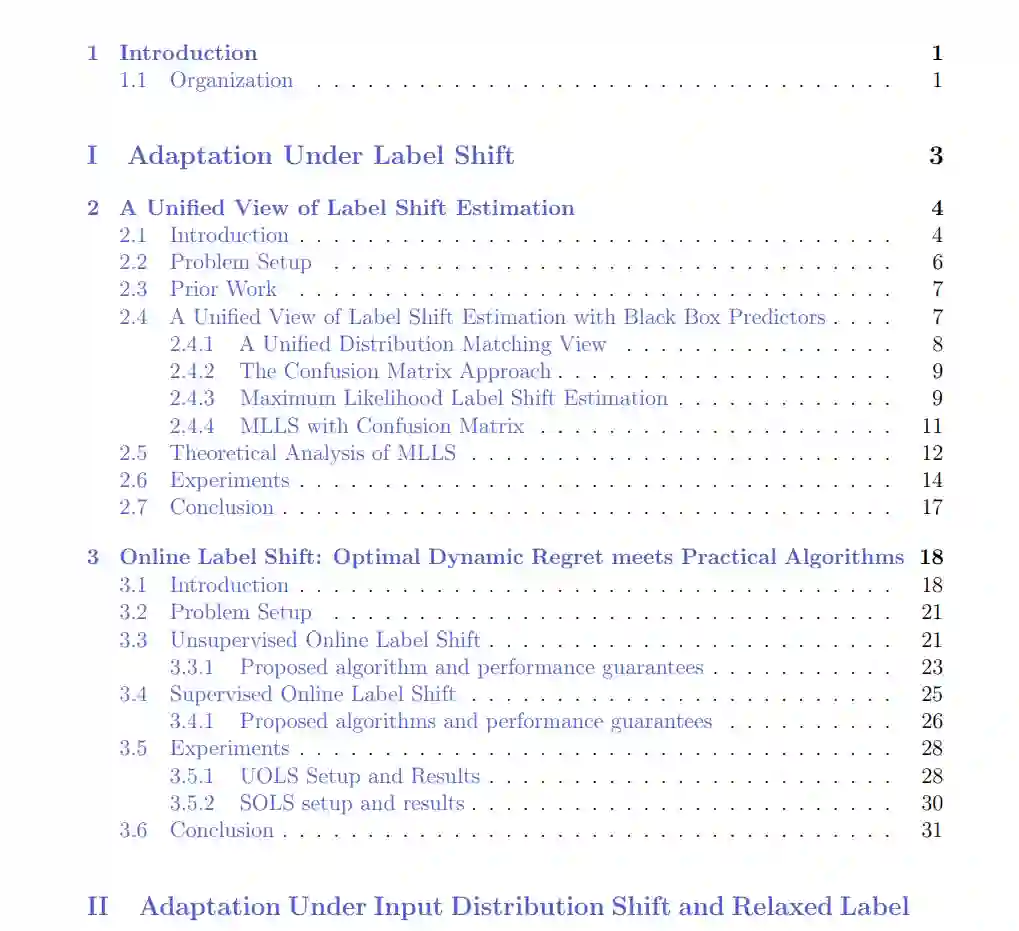

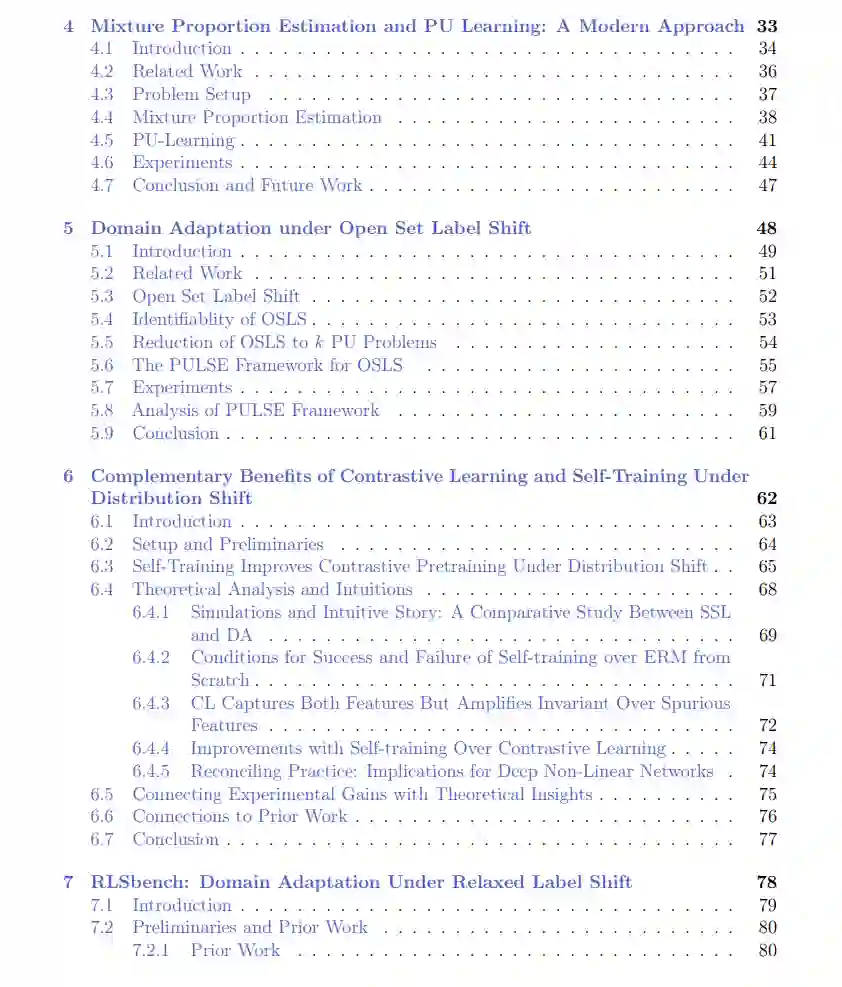

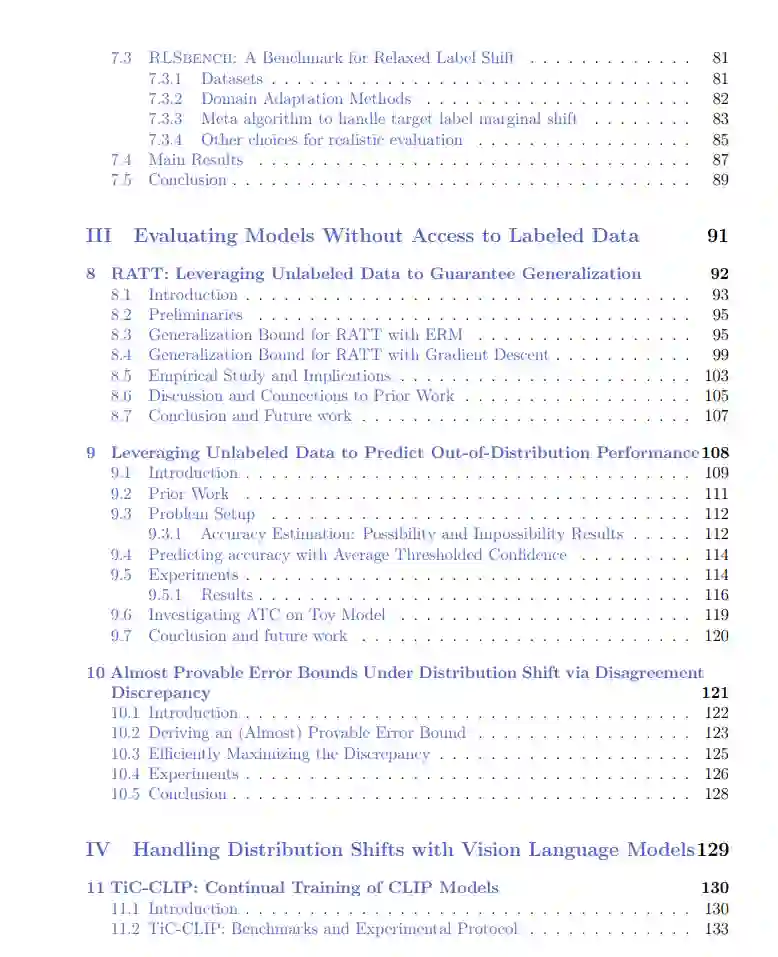

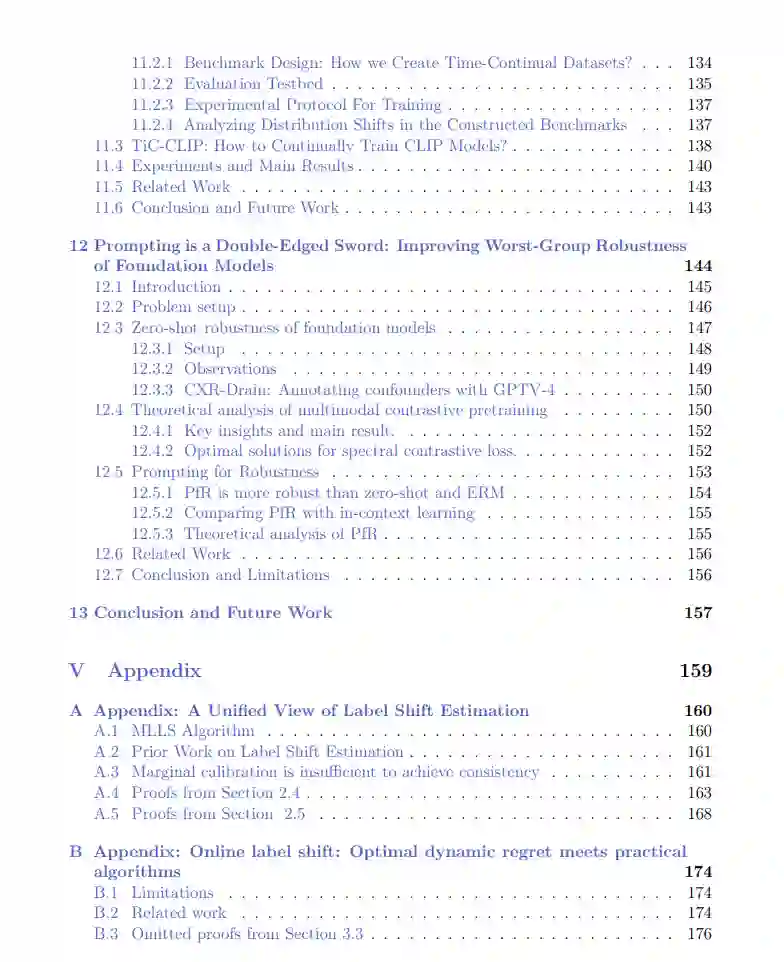

我的研究利用目标领域的未标注数据,识别目标领域和源领域之间的结构关系,然后利用这些关系来适应和评估模型。本论文讨论的工作涉及理论和实证上理解深度模型的行为,并利用这些见解开发稳健的方法。特别是,本论文调查了我在以下三个问题上的工作:

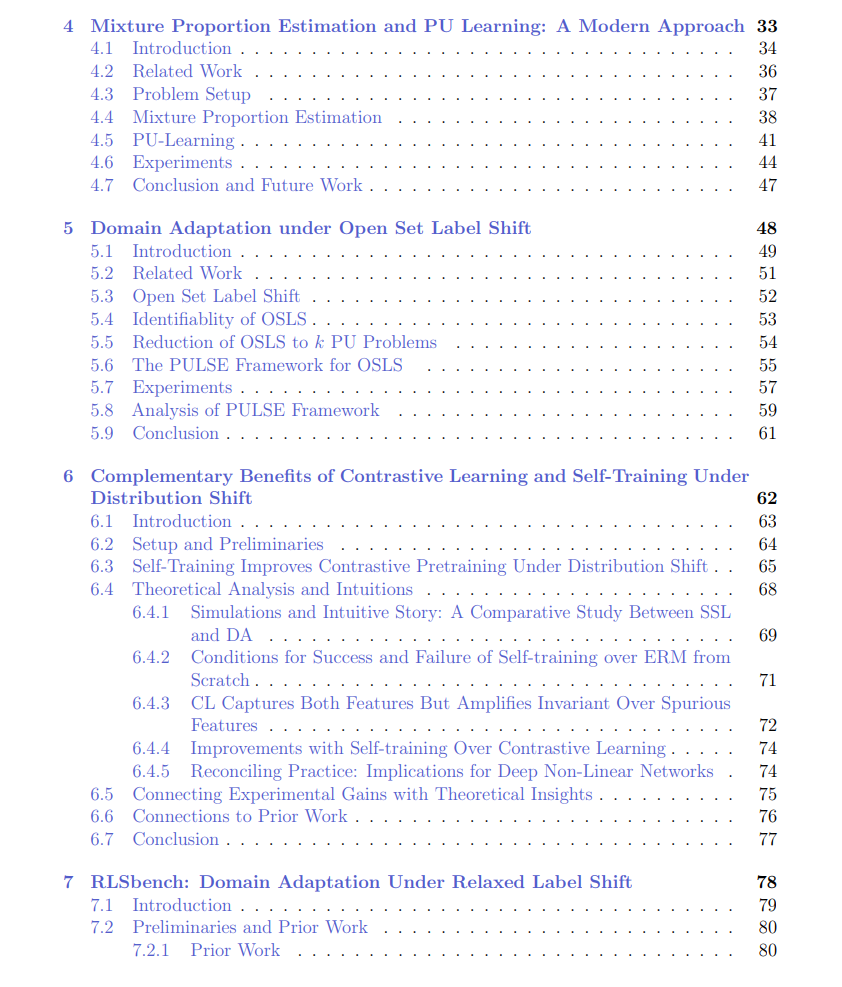

Q1:如何在分布变化的情况下适应模型?如果没有对分布变化性质的假设,这项任务是不可能完成的。我的研究重点是制定在实际环境中出现的分布变化场景的假设,并通过利用未标注数据来改进和适应深度模型。论文的第一部分和第二部分详细探讨了这一研究。

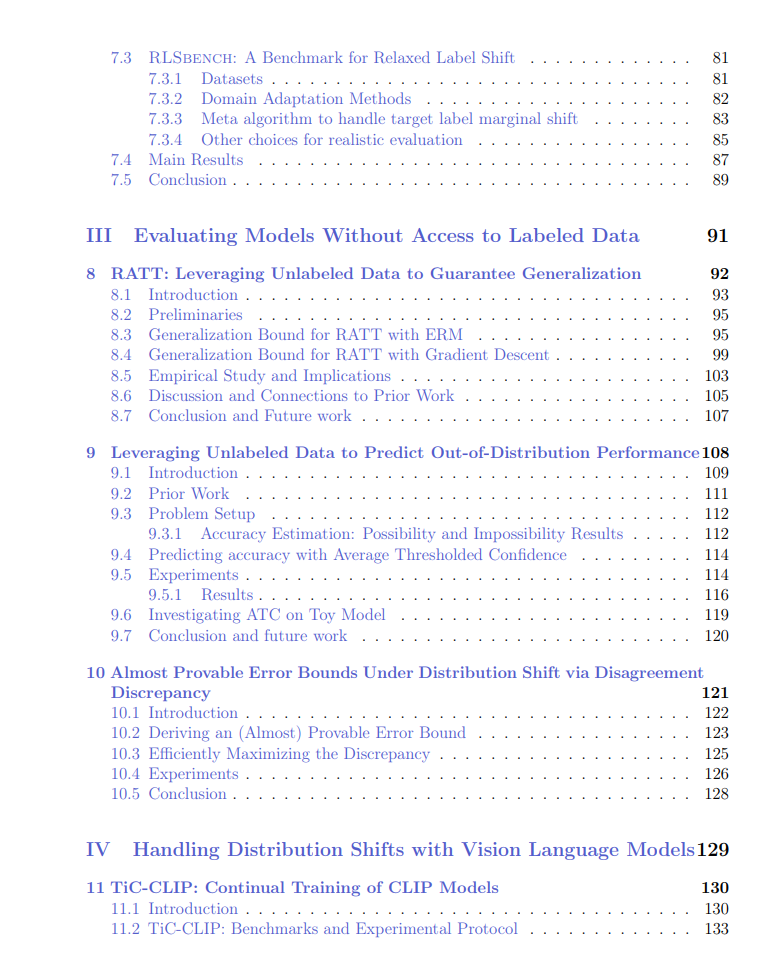

Q2:在没有标注数据的情况下,如何评估模型的性能?深度学习模型会无声地失败,即它们无法标记不确定的决策。为了构建可靠的机器学习系统,获得准确性的证明与增强系统的稳健性同样重要。第三部分讨论了我在这方面的研究,并提出了利用未标注数据预测模型准确性的技术。

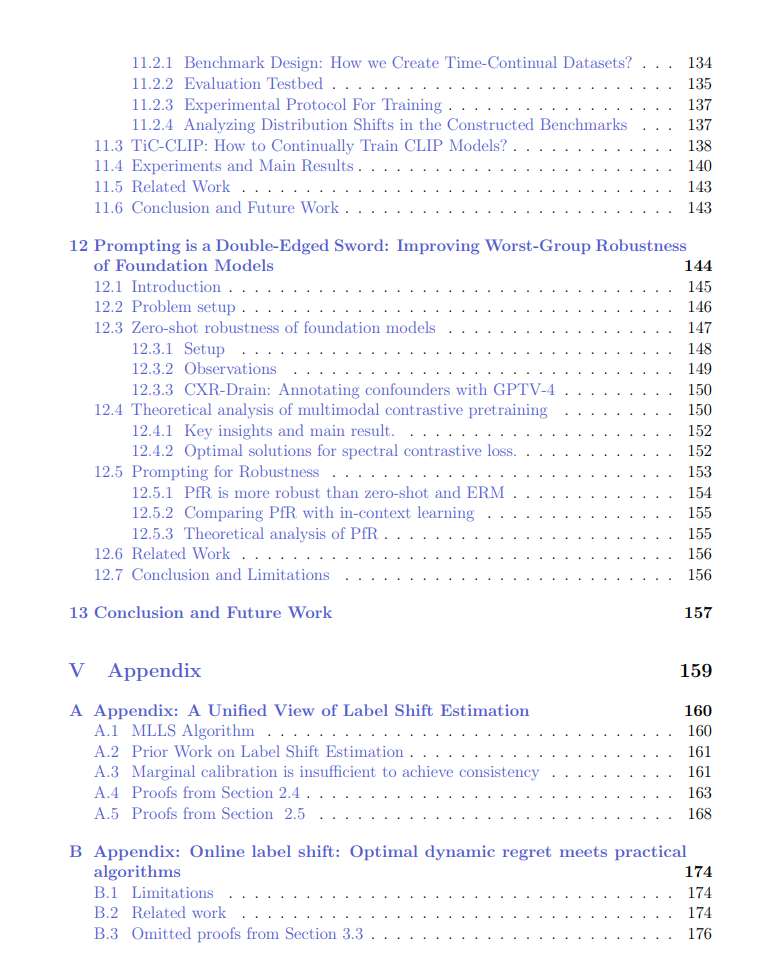

Q3:如何利用基础模型来解决分布变化带来的挑战?基础模型(如视觉语言模型)在广泛的任务中表现出色。然而,这些模型也由于虚假关联、图像与文本对齐差等原因缺乏稳健性。此外,随着互联网数据的演变,这些模型也会变得过时,提出了保持它们更新的新的挑战。第四部分讨论了我对基础模型行为的理解以及在分布变化下提高其稳健性的技术。

总体而言,本论文通过开发利用未标注数据在分布变化下适应和评估模型的技术,拓展了稳健机器学习的前沿。这里展示的工作是朝着在分布变化面前开发稳健机器学习全面工具包迈出的一步。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日