这项工作确定了确保大型语言模型(LLMs)的对齐与安全的18个基础挑战。这些挑战分为三个不同的类别:对LLMs的科学理解、开发与部署方法以及社会技术挑战。基于识别的挑战,我们提出了200多个具体的研究问题。

https://www.zhuanzhi.ai/paper/4b2cab1f8af7235be68b4bf406b8480c

大型语言模型(LLMs)已成为解决开放性问题最有效的方法之一,并在机器学习内部标志着一次范式转变。然而,确保它们的安全性和对齐仍然是一个突出的挑战,这一挑战被包括私人AI实验室(Leike等人,2022年;Anthropic,2023a年;Frontier Model Forum,2023年),国家和国际政府组织(白宫,2023年;办公室,2023年;委员会,2023年),以及研究和学术界(Bengio等人,2023年;FAccT,2023年;CAIS,2023年;CHAI, Far.ai和Ditchley Foundation,2023年)在内的所有利益相关者所认可。的确,确保任何基于深度学习的系统的安全性和对齐都是困难的(Ngo等人,2023年)。然而,由于它们庞大的规模(Sanh等人,2019年,图1)和日益广泛的能力范围(Bubeck等人,2023年;Morris等人,2023年),这一挑战对于LLMs来说更加严峻。此外,LLMs能力的快速进步不仅扩大了LLMs的潜在应用,还增加了它们对社会造成伤害的潜力(Weidinger等人,2021年;Ganguli等人,2022年;Birhane等人,2023年;Chan等人,2023a年)。

**1.1 为什么有这个议程? **

进展的快速率尤其令人担忧,因为缺乏必要的技术工具和在社会技术结构上的不足,这可能有助于确保LLMs的安全开发和部署(Bengio等人,2023年)。在这项工作中,我们绘制了开发适当技术便利设施的挑战地图,这些设施可能有助于确保安全性,并理解和应对我们在确保社会规模安全性方面可能面临的社会技术挑战。本质上,这项工作是对机器学习研究人员以及相关领域研究人员的行动呼吁。我们广泛引用当代文献,专注于识别有前途的具体研究方向,并深入讨论每个挑战,使其成为领域新手的理想教育资源。同时,我们期望在这项工作中识别的诸多挑战将成为当前从事LLM对齐和安全领域实践者的灵感来源,包括那些来自其他多样化学科的工作者(例如社会科学、人文学科、法律、政策、风险分析、哲学等)。

一些先前的研究已经汇编并讨论了AI安全的基本问题(Amodei等人,2016年;Hendrycks等人,2021a年;Critch和Krueger,2020年;Kenton等人,2021年;Ngo等人,2023年)。然而,LLMs标志着一个范式转变,并提出了许多在对齐、安全和保证方面的新颖和独特的挑战,这些挑战并未在这些作品中讨论。在这些中,Kenton等人(2021年)的工作是唯一专注于LLMs的,但其覆盖范围较窄,主要关注目标偶然错位的问题。我们的工作在前述工作的基础上进行了建设,提供了迄今为止最全面、最详尽的关于LLMs对齐和安全挑战的处理。

我们突出了LLMs安全性和对齐的18个不同的基础挑战,并对每一个进行了广泛的讨论。我们识别的挑战在基础上意味着没有克服它们,确保LLMs及其衍生系统的安全性和对齐将是非常困难的。对于这项工作,我们进一步优先讨论了那些明确的(即非推测性的)、适合研究且与当前和即将到来的LLMs所带来的伤害和风险高度相关的基础挑战。此外,我们还提出了200多个具体的研究问题以供进一步调查。其中每一个都与特定的基本挑战相关联。这些研究问题相当开放,大致相当于一个研究生论文的规模,尽管许多提供了多个攻击角度,可以更彻底地进行研究。

1.2 术语解释 “对齐”、“安全”和“保证”的术语根据上下文有不同的含义。我们使用“对齐”指代意图对齐,即当系统在尝试按照某个人类行动者的意图行动时,系统被认为是“对齐”的(Christiano,2018)。重要的是,对齐并不保证系统实际上按预期行动;例如,由于能力有限,它可能无法做到这一点(Ngo等人,2023)。为了进一步简化我们的讨论,我们将意图固定为LLM开发者的意图(Gabriel,2020;Ngo等人,2023)(例如,与用户相对)。我们认为一个系统是安全的,到它不太可能导致未计划的、不希望的伤害(Leveson,2016)。这是一个有些广泛的定义,不仅考虑了系统的技术属性,还考虑了它的(或可能的)部署和使用方式(Weidinger等人,2023a),尽管在它不考虑故意伤害的意义上是狭窄的,并且它没有设定构成伤害的任何标准。对齐可以用来增加安全性,但这种关系并非直接:它也可以被用来使系统更危险(如果开发者有意为之),并且它并不直接关心系统在其部署环境中嵌入时的实际影响,或开发者与其他利益相关者之间(缺乏)对齐的非常重要的问题。最后,通过“保证”,我们指的是提供系统安全或对齐的任何证据的方式(Ashmore等人,2021),包括但不限于:系统的科学理解、行为评估、模型行为或内部处理的解释,以及系统开发者遵循负责任的开发实践(Casper等人,2024a)。

1.3 结构

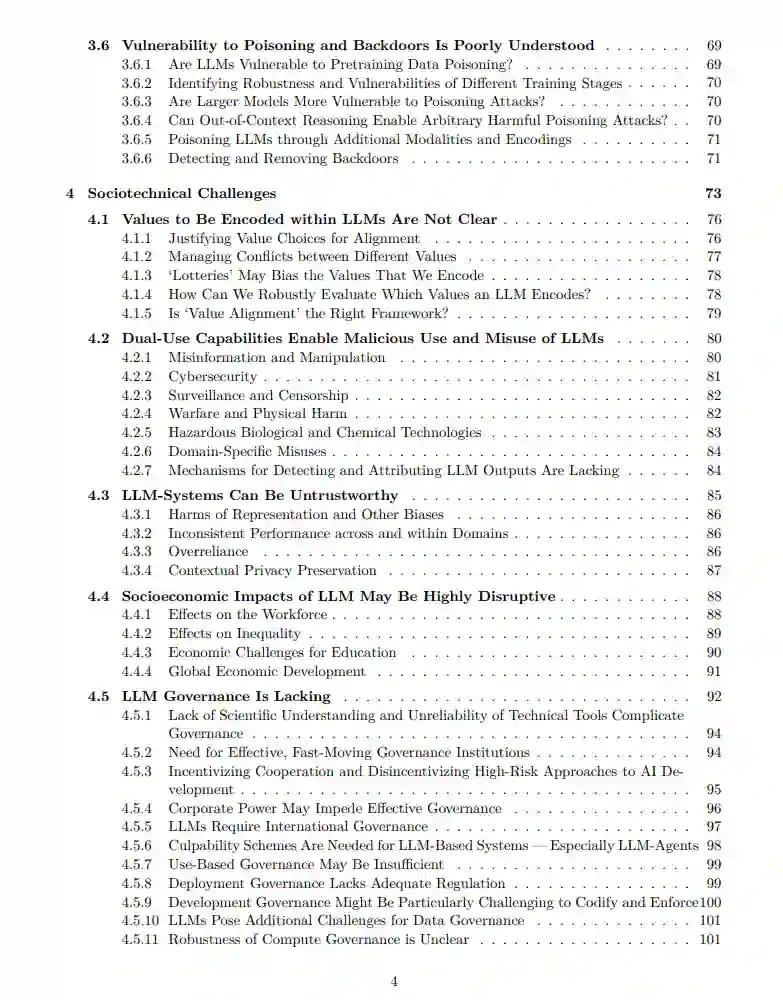

我们将基础挑战组织成三个不同的类别。第一类,LLMs的科学理解(第2节),调查了可以帮助我们建立一个更好的LLMs功能“理论”并指导开发和部署决策的最重要的开放性问题。我们讨论了开发原理化解决方案以概念化、估计、理解和预测LLMs能力的必要性。我们特别指出了LLMs的在场景中学习和推理能力,认为这对于确保所有场景中的对齐和安全至关重要。我们强调,当前LLMs面临的风险可能会随着LLM-agent的引入而成倍增长,我们需要预先理解这些风险并努力在单一agent和多agent场景中减轻这些风险。最后,我们注意到,对于基于LLM的系统,可能不可避免地存在安全性-性能权衡,我们应该更好地理解这一点。 第二类,开发与部署方法(第3节),介绍了现有技术在确保LLMs的安全性和对齐方面的已知限制。我们识别了通过修改预训练过程来生产更对齐的模型,从而帮助改善模型对齐的机会,调查了微调在确保对齐和安全方面的几个限制,讨论了“评估危机”背后的问题,审查了解释和解释模型行为的挑战,并最终提供了像越狱、提示注入和数据投毒等安全挑战的评估。总体而言,这一部分涉及研究实证技术,这些技术可能有助于改善LLMs的对齐、安全和安全性。

最后一类,社会技术挑战(第4节),聚焦于需要更多样化和整体视角来解决的挑战。例如,我们讨论了在LLMs中编码哪些价值观的社会级讨论的重要性,以及我们如何防止价值强加并使价值多样化成为可能。许多LLMs功能是双重用途的;我们需要理解这样的功能可能启用何种恶意滥用,以及我们如何抵御它们。还需要确保独立并持续监控LLM系统的偏见和其他问题,并透明地传达,以建立信任并减少过度依赖。LLMs在社会中的广泛传播可能会产生不希望的社会经济影响(例如工作岗位的减少、不平等的增加),这些影响应该得到更好的调查和对策。最后,我们通过讨论治理和监管领域的挑战和机会来结束这一部分。 作为附录,在第5节中我们回顾了这项工作的一些局限。最值得注意的是,虽然这一议程是全面的,但它并非详尽无遗。我们接着提供了与本工作广泛相关的先前工作的详细概述;包括但不限于先前关于AI安全的议程和与LLMs相关的各种调查。

LLMs科学理解

许多安全和对齐挑战源自我们目前对大型语言模型(LLMs)的科学理解不足。如果我们能更好地理解LLMs,这将帮助我们更准确地估计当前和未来LLMs所带来的风险,并设计合适的干预措施来缓解这些风险。科学理解也是保证的一个重要组成部分——特别是对于复杂系统。一些依靠科学理解来保证安全的复杂系统经典例子包括桥梁设计、飞机设计、核反应堆设计、航天器设计等。如果没有对这些系统背后物理学的科学理解,这些系统的保证可能几乎是不可能的。

LLMs展现了许多复杂系统的典型特征(Holtzman et al., 2023; Steinhardt, 2023; Hendrycks, 2023,第5章)——其中最主要的是涌现行为(Wei et al., 2022a; Park et al., 2023a)。这种类似复杂系统的特性意味着仅依靠“评估”可能不足以确保安全和保证(参见第2.2.3节和第3.3节),并且迫切需要探究LLMs表层行为之外,了解这些行为是如何产生的(Holtzman et al., 2023)。

理解LLMs是一个广泛且宏大的科学挑战。然而,符合本作的总体主题,我们专注于最与安全相关的方面(参见表1以获取概览)。解决这些挑战将有助于通知更安全的LLM开发或部署实践;然而,还需要额外的工作将这里的见解转化为实际的建议。

科学理解可以采取许多不同且多样的形式(Adams et al., 2014,表4)。的确,我们已经确定的挑战承认多样的研究风格。虽然一些挑战在本质上是深度理论性的(例如,变换器的计算极限是什么?或理解扩展定律),其他一些则可能需要更多经验性的方法来解决(例如,单一代理训练对多代理互动的影响尚不清楚)。总体而言,我们提出的大多数挑战都集中在开发对LLMs的定性理解上。定性理解通常允许发展出量化分析可能无法允许的一般化,因此可能对LLMs的快速发展更为稳健。这些定性理解的优点在将近50年前由Herbert Simon和Allen Newell在他们的里程碑式1975年图灵奖讲座中高度赞扬,该讲座也恰好是关于设计和理解人工智能系统的(Newell和Simon, 1976)。

开发与部署方法

迄今为止,对齐和安全研究的主要关注点一直是开发方法来提高LLMs的安全性和对齐性。这确实取得了一些成功,最显著的是在“微调”阶段改进和发展方法,以提高模型行为的对齐。然而,总体而言,目前在LLMs的开发和部署中使用的技术工具还有很大的改进空间。缺乏适当的工具来稳健地对齐、评估、解释、保护和监控LLMs,这是确保LLMs的对齐和安全的障碍。与对LLMs的科学理解类似,并符合议程的更广泛主题,我们关注于与确保LLMs的安全和对齐最相关的开发和部署方法的不足。即便是从这种限定的视角出发,我们也识别出许多改进开发和部署方法的机会。

在LLMs的开发和部署中使用的方法大致可以分为三种类型。第一种类型包括用于LLMs训练的技术(包括数据收集和标注技术),用于预训练和微调。我们将微调阶段使用的所有技术(监督微调、基于人类或AI反馈的强化学习训练、遗忘方法)统称为“安全微调”方法。我们在第3.1节和第3.2节中讨论了预训练和安全微调中的各种挑战,这些挑战对LLMs的安全性、对齐性和保证产生了负面影响。第二种方法包括评估和解释技术——不幸的是,正如我们在整个报告中(第3.3节和第3.4节)所强调的,评估和解释方法还有很大的提升空间,且在当前状态下不能依赖它们提供必要的保证。最后,第三种方法关注这些模型的安全性——这包括对各种类型的敌对攻击的鲁棒性,最突出的是越狱和提示注入(第3.5节)以及投毒攻击(第3.6节)。