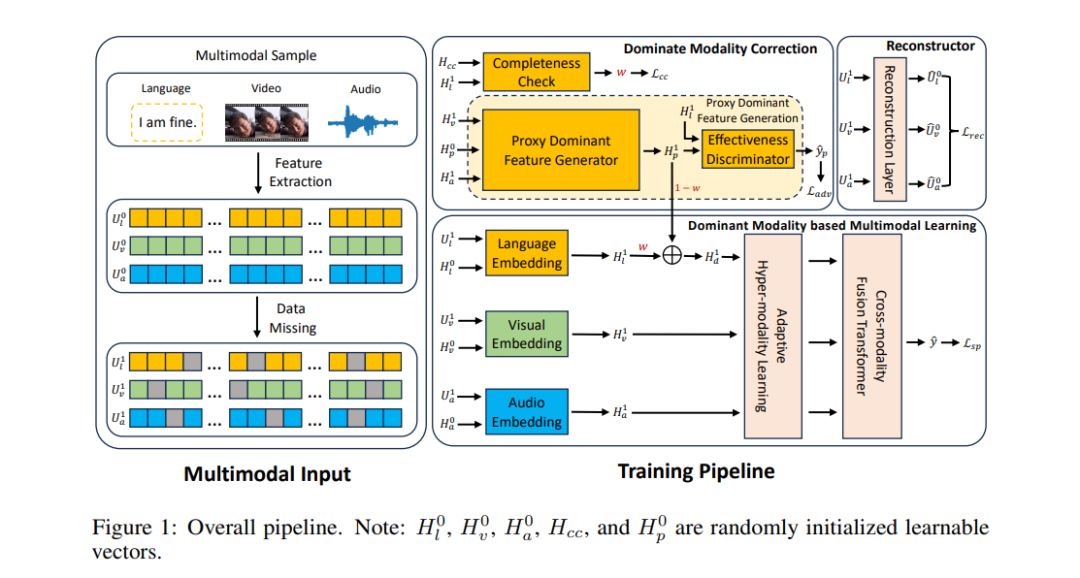

多模态情感分析(MSA)领域最近出现了一个新兴方向,旨在解决数据不完整性问题。鉴于语言模态通常包含丰富的情感信息,我们将其视为主导模态,并提出了一种创新的以语言为主的抗噪学习网络(LNLN),以实现鲁棒的多模态情感分析。所提出的LNLN包含主导模态校正(DMC)模块和基于主导模态的多模态学习(DMML)模块,通过确保主导模态表示的质量,增强模型在各种噪声场景下的鲁棒性。除了方法设计之外,我们还在随机数据缺失场景下进行了全面实验,利用多个流行数据集(如MOSI、MOSEI 和 SIMS)中的多样且有意义的设置,提供了比现有文献中评估更具一致性、透明性和公平性的测试。实验证明,LNLN在这些具有挑战性且广泛的评估指标上始终优于现有基准,展示了其卓越的性能。我们的代码将发布在:https://github.com/Haoyu-ha/LNLN。

成为VIP会员查看完整内容

相关内容

Arxiv

35+阅读 · 2023年4月19日

Arxiv

166+阅读 · 2023年4月7日