图数据上的持续学习最近引起了广泛关注,其目的是在使现有模型适应新出现的图任务的同时,解决现有任务上的灾难性遗忘问题。虽然已经有人努力总结欧氏数据(如图像和文本)上的持续学习研究进展,但仍然缺乏对持续图学习工作的系统综述。图数据在数据结构和应用场景方面要复杂得多,使得持续的图学习任务设置、模型设计和应用极其复杂。为解决这一差距,本文对现有的持续图学习工作进行了全面的回顾,阐明了不同的任务设置,并根据所采用的技术对现有工作进行了分类。本文将持续图学习工作与传统持续学习工作进行比较,分析传统持续学习技术对持续图学习任务的适用性。回顾了对持续图学习研究至关重要的基准工作。最后,讨论了尚存的挑战,并提出了未来的研究方向。

https://github.com/QueuQ/CGL_tut01

1. 引言

传统的图学习通常假设图是静态的。然而,在现实世界的大多数应用中,包括节点层学习任务和图层学习任务,图的规模或数量都会不断增长,期望模型不断适应新出现的模式,而不会忘记之前学习过的知识。例如,在引文网络中,新的研究论文类别(图节点)和伴随的引文类别(图边)会不断出现,在其上工作的文档分类器希望能够不断适应新数据的分布,同时保持对以前观察到的数据分布的学习知识[1],[2]。在药物发现研究中,可能会间歇性地发现新的分子性质和分子类别,而分子性质预测器必须在不失去对以前的分子类别或性质[1]、[3]的预测能力的情况下,为新的模式拟合其参数。在这种持续学习场景中,一种朴素的方法是每当有新任务到来时,只使用新数据训练模型。但不断适应新任务的模型会遭遇灾难性遗忘问题,即学习新任务后对先前任务的性能严重下降。另一种直观的方法是在包含所有先前观察到的数据的整个数据集上重新训练模型。然而,由于较高的再训练成本和潜在的隐私问题,该策略不可行。

鉴于此,持续图学习(CGL)最近受到越来越多的关注,它旨在不断地学习新的任务,而不忘记以前已经学习过的知识。由于图数据的复杂性,现有持续学习工作在目标图类型、学习设置、基础技术和评价指标等方面具有高度异构性。首先,技术工作可能提出通用技术或针对特定应用场景(如知识图谱、推荐系统等)的专用技术。其次,根据测试过程中任务标识的可用性,连续的图学习工作可能采用不同的设置,包括任务增量(taskIL)、域增量(domain-IL)和类增量(class-IL)。除了增量设置外,图学习任务还可能关注不同的粒度,包括节点级任务和图级任务。第三,不同工作采用的技术遵循不同的主流,包括正则化、内存重放和参数隔离。最后,与标准的学习环境不同,连续图学习模型的性能从整体性能、性能下降(遗忘)、任务间干扰等多个角度考虑。因此,根据研究目标的不同,不同的工作可能会采用不同的指标来评价模型。连续图学习工作的这些正交维度令人困惑,并为研究人员进入该领域制造了巨大的障碍。

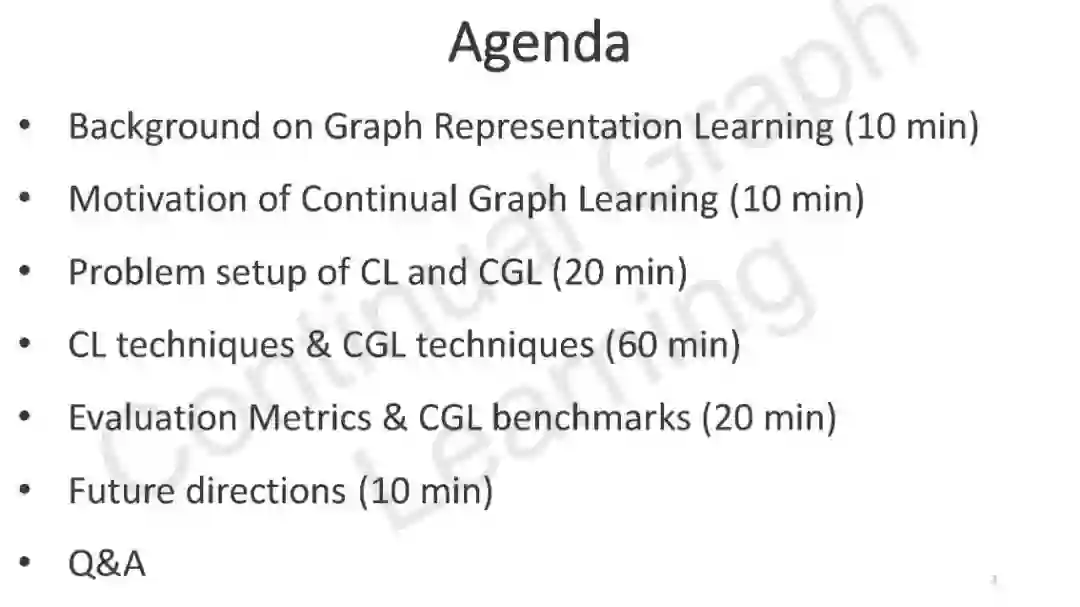

为此,本文从上述角度对现有方法进行了系统综述。论文的其余部分组织如下。在第3节中,从基本概念、骨干模型框架、任务序列构建、任务粒度、增量场景以及评估指标等角度解释了持续图学习的问题设置。在第四部分中,我们首先系统地回顾了持续学习技术的研究进展,包括基于正则化的方法、基于记忆回放的方法和基于参数隔离的方法,然后分析了传统持续学习技术的适用性;在第6节中,介绍了最近提出的基准工作,旨在提供一致的实验环境和公平的性能比较平台。然后,分析了传统持续学习技术对持续图学习任务的适用性;最后,我们还介绍了基准工作,为比较不同技术提供了一个公平的平台。最后,在第7节中,讨论了CGL研究面临的挑战和有希望的未来方向。

2. 问题设置

与欧氏数据上的持续学习不同,持续图学习(continuous Graph learning, CGL)关注更复杂的任务配置。例如,在一些应用中,学习是在一个不断增长的图上进行的,每个新任务都是附加在现有图上的一个子图。而在其他场景中,任务可能是图级别的任务,每个新任务都是一组独立的图。在本节中,我们首先提供持续学习过程的一般性公式,然后根据这些公式推导出不同的特定学习场景。

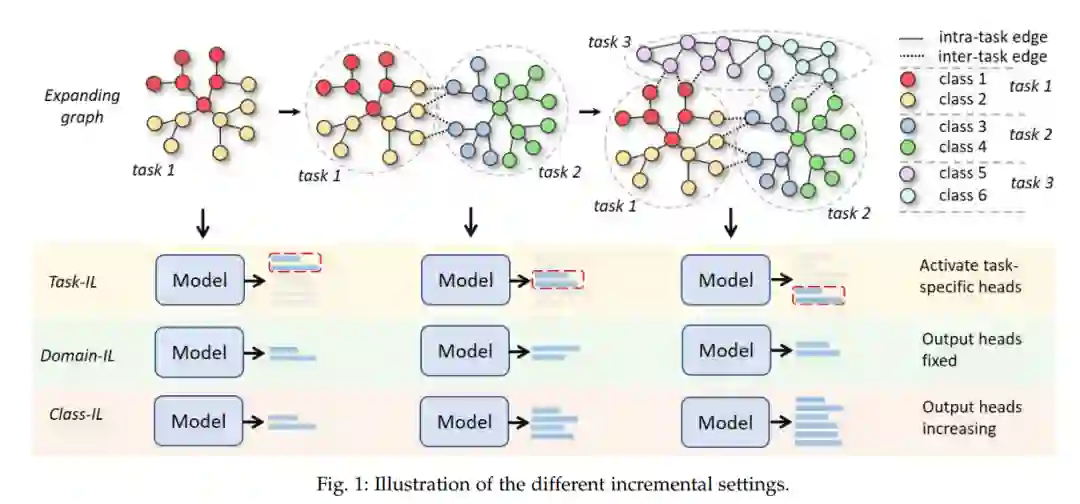

根据测试过程中是否提供任务标识以及是否需要模型来获取任务标识,持续图学习以及经典的持续学习可以分为任务增量学习(task- il)、领域增量学习(domain-IL)和类增量学习(class-IL)。

2.1 Task-IL

在task- il中,任务标识在测试期间显示给模型,因此模型不需要识别给定的任务。对于分类任务,现有模型通常增加其输出维度以适应新任务,并且在测试期间仅激活每个给定任务的相应维度。例如,在分子特性预测任务中,每个新任务都可以预测新特性的存在。

2.2 Domain-IL

Domain-IL比task- il更具挑战性,因为它在测试过程中不提供任务标识。但是它也不需要识别给定的测试任务。在这种情况下,模型输出维度的语义含义通常是固定的,新任务被视为来自新领域的数据。例如,在知识图谱上持续学习的一个可能场景是在具有不同实体和关系的图上连续学习,而预测任务总是三元组的完成。一些工作还考虑了时间增量场景,将时间序列数据划分为不同的时间段作为不同的任务。然而,由于模型输出的语义在不同的任务中是相同的,该场景本质上是domain-IL的实例化,不同的时间段本质上是不同的域。

2.3 Class-IL

Class-IL是三种场景中最具挑战性的。在测试过程中,任务标识是不可访问的,模型必须识别给定的任务。对于分类任务,当新类别到达时,模型通常增加输出维度,并必须在所有学习的类别中选择正确的类别,而不像任务il只需要区分已知任务中的类别。

3. 方法

与传统的持续学习类似,持续图学习也从限制模型参数的变化、隔离和保护对先前学习任务重要的参数、重放先前任务中的代表性数据以提醒模型先前学习的模式等角度来解决问题。然而,持续图学习的一个关键挑战是必须妥善保存数据的拓扑结构,这是图数据中包含的重要信息。

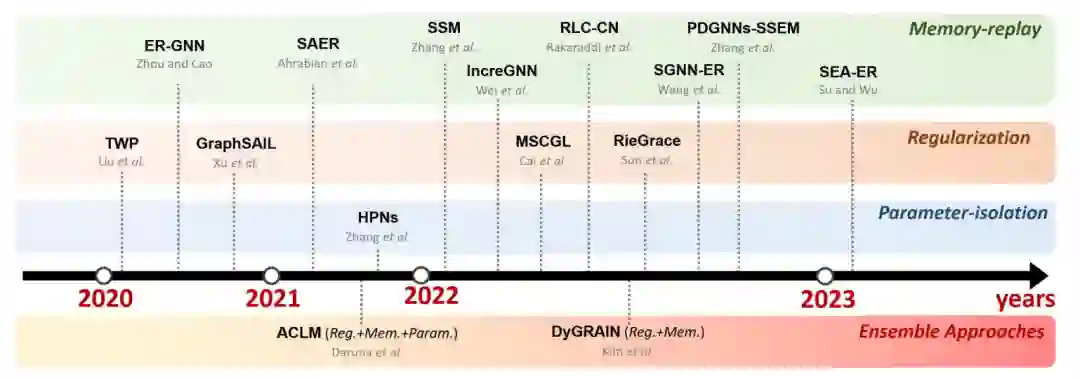

3.1 基于正则化的方法

由于遗忘的原因是为之前的任务训练的模型参数在适应新任务后发生了修改,传统的基于正则化的方法[48]、[49]增加了惩罚项以防止参数发生剧烈变化。然而,这些方法并不能显式地保留图数据的拓扑结构。针对这一不足,拓扑感知的权重保持(TWP)[1]提出通过对模型权重的正则化来显式保留在之前任务中学习到的拓扑.

3.2 基于内存重放的方法

基于记忆回放的方法通过使用前一任务中的代表数据重新训练模型来防止遗忘。传统的持续学习方法处理个体数据时无需交互,只需要简单地采样并存储在缓冲区中即可。然而,对于图的学习,基于内存重放的方法会遇到内存爆炸的挑战[3]。在生成节点(数据)的表示时,图神经网络(GNNs)通常聚合来自多跳邻居的信息。因此,为了重新生成单个节点的表示,必须存储来自指数扩展邻域的信息。在稠密图上,内存消耗很容易成为难以处理的问题。由于这一挑战,经验回放图神经网络(ER-GNN)[38]直接忽略图的拓扑结构,仅存储单个节点的属性来重新生成表示。

3.3 参数隔离方法

最后一类是基于参数隔离的方法,通过对不同任务完全或部分分离模型参数来保护模型在之前任务上的性能。现有的基于参数隔离的连续图学习方法很少,代表性的方法是分层原型网络(Hierarchical Prototype Networks, HPNs),它提出动态增加特征提取器和原型以适应新模式。具体来说,HPNs由一组用于从给定数据中提取基本特征的原子特征提取器(AFEs)和3层用于存储学习到的模式的分层原型组成。对于给定的输入节点,AFEs首先根据节点属性及其邻域关系提取基本特征;因此,AFEs由两部分组成。一组AFEs,称为AFEnode,用于根据节点属性生成原子节点嵌入。另一个集合为AFEstruct,用于捕获给定节点的邻域拓扑结构,并据此生成原子结构嵌入。得到的原子嵌入对应于最基本的特征,然后将根据其余弦相似度与现有的原子级原型(A -原型)进行匹配。

4. CGL模型的评估

与标准学习环境只关注一个任务不同,持续学习模型的评价必须考虑模型在所有学习任务上的表现。因此,评价一个持续学习模型最有效的方法就是在学习完一个新任务后,展示它在以前的每一个任务上的表现。 性能矩阵包含整个学习过程中的原始性能。在此基础上,研究人员采用了多种不同的评价指标。例如,考虑到性能矩阵不适用于不同方法的性能比较,可以使用[3]的平均性能(AP)和平均遗忘(AF)。这两个指标在CGL以及传统的持续学习工作中被广泛采用,但在不同的工作中名称可能不同。例如,在[53]、[60]中分别命名为平均准确率(ACC)和反向迁移(BWT),在[3]、[38]中分别命名为平均性能(AP)和平均遗忘(AF),在[1]中分别命名为性能均值(PM)和遗忘均值(FM)。

**5. 机会、未来方向和讨论 **

作为一个新兴且快速发展的领域,CGL的研究已经取得了显著的进展,并进入更具挑战性和实用性的学习场景。然而,仍有许多挑战需要解决, 包括效率和空间复杂度的权衡,对任务边界的依赖,现有任务中节点的概念漂移问题,基于任务的知识迁移,扩展到其他模态。

《持续图学习》教程

在过去的几年中,图上的深度学习在各个领域取得了显著的进展。然而,大多数图学习任务假设图是静态的,而现实世界的图可能会不断增长或演变。因此,研究如何在不忘记之前学习的知识的情况下,不断地使图学习模型适应新的模式/任务是至关重要的。为此,在本教程中,我们将介绍持续图学习(CGL)的新领域。具体来说,我们将(1)介绍不同的持续图学习设置,(2)提出CGL中的关键挑战,(3)强调现有的CGL技术,以及(4)讨论未来的方向。本教程时长为3小时,包括150分钟的演示和30分钟的问答。