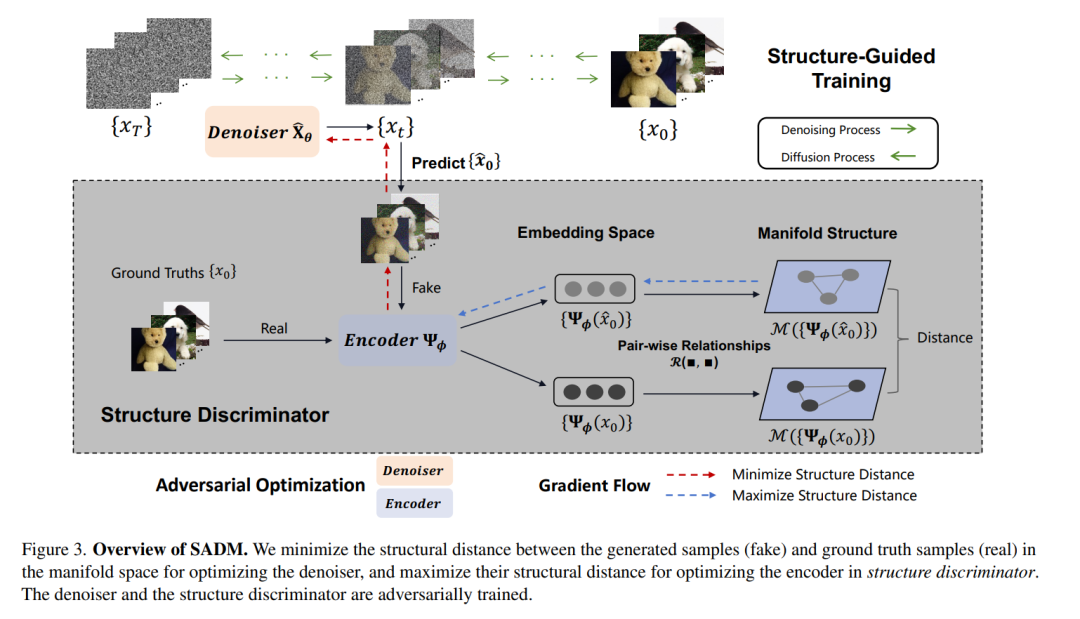

扩散模型在各种生成应用中已展现出卓越的效果。尽管现有模型关注于最小化用于数据分布建模的去噪分数匹配损失的加权和,它们的训练主要强调实例级优化,忽视了每个小批量中包含的有价值的结构信息,这些结构信息表明了样本间的成对关系。为了解决这一限制,我们引入了结构指导的扩散模型对抗训练(SADM)。在这种开创性的方法中,我们强制模型学习每个训练批次中样本间的流形结构。为了确保模型捕获数据分布中真实的流形结构,我们提倡在极小极大游戏中进行扩散生成器对抗一种新颖的结构鉴别器的训练,区分真实的流形结构和生成的流形结构。SADM在现有的扩散变换器上取得了显著改进,并在图像生成和跨域微调任务中跨越12个数据集超越现有方法,建立了新的最先进的FID,分别在256×256和512×512分辨率的类条件图像生成上达到了1.58和2.11。

https://www.zhuanzhi.ai/paper/49614b89be54dc8bf62027a494e32b5b

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

224+阅读 · 2023年4月7日

Arxiv

86+阅读 · 2023年4月4日