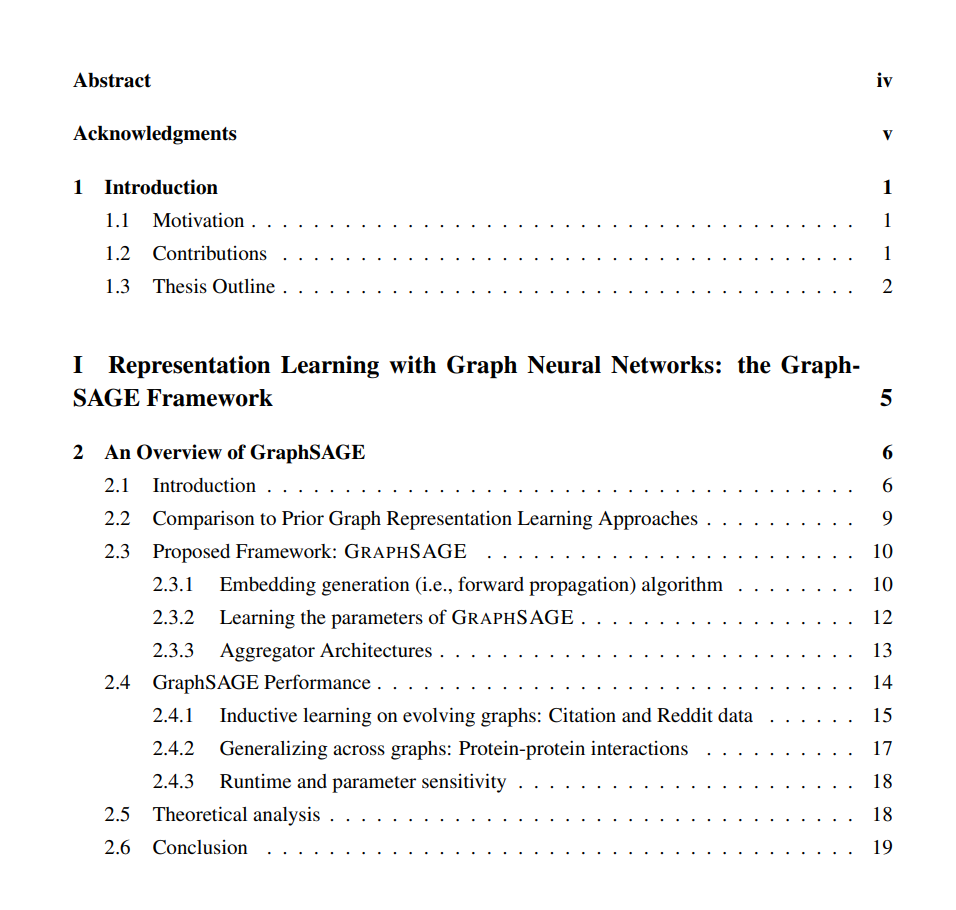

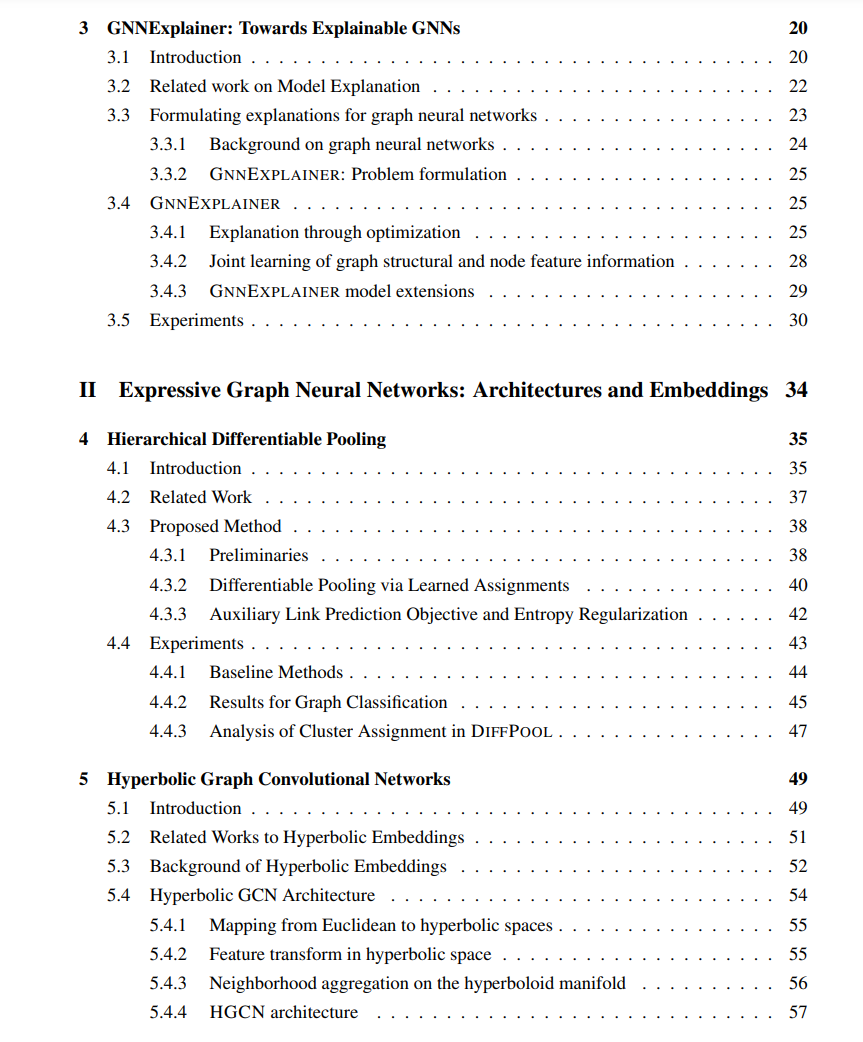

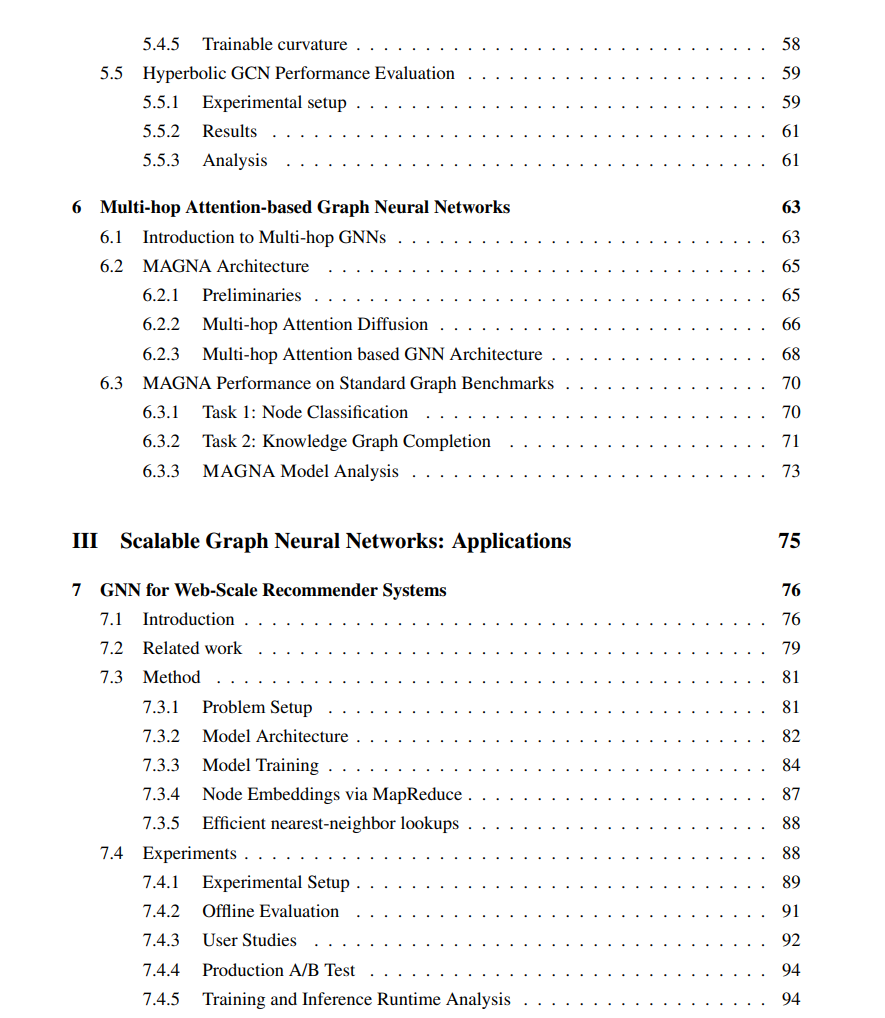

在科学和工业中图结构的普遍性要求我们拥有能够捕获关系数据底层归纳偏见的有效且可扩展的机器学习模型。然而,传统的图结构表示学习算法面临很多限制。首先,包括矩阵分解和分布式嵌入在内的传统方法由于其参数空间的大小而无法扩展到拥有数十亿节点和边的大型实际图。其次,与深度学习架构的最新进展相比,它们缺乏表达能力。最后,它们在归纳场景中失败,因为它们需要对训练期间未见过的节点进行预测。最终,模型从数据中学到的内容对领域专家来说难以理解。 在这篇论文中,我展示了一系列开创性的工作,利用图神经网络(GNNs)来解决图表示学习在解释性、可扩展性和表现力方面的挑战。在第一部分,我展示了我的GraphSAGE框架,作为一个通用但强大的图神经网络框架。为了解决新GraphSAGE框架的模型可解释性挑战,我进一步引入了一个扩展模型,从已训练的图神经网络模型中获得有意义的解释。在GraphSAGE的框架下,第二部分展示了一系列的工作,通过使用分层结构、几何嵌入空间以及多跳注意力来提高GNNs的表达能力。这些基于GNN的架构在各种上下文的任务上实现了前所未有的性能提升,如分子的图分类、分层知识图和大规模引文网络。

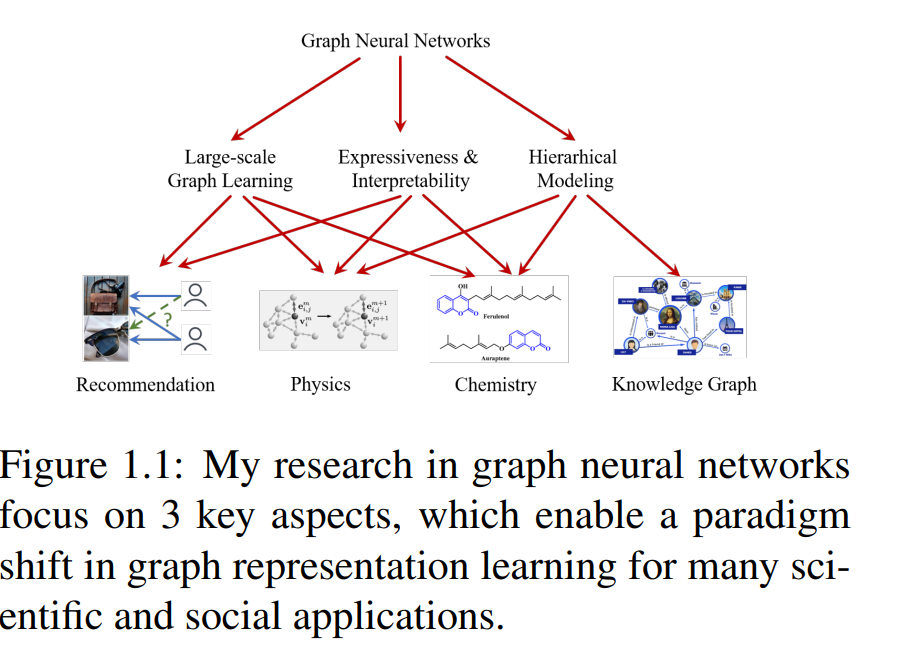

在第三部分,我进一步展示了GNNs的各种应用。基于GraphSAGE,我开发了PinSAGE,这是第一个部署的能够扩展到十亿级图的GNN模型。PinSAGE已在Pinterest部署,为Pinterest的数十亿用户提供推荐。在图形和仿真领域,我们应用了表现力强大的架构来准确预测不同材料的物理性质,并允许对未见过的动态系统进行泛化。最后,我讨论了BiDyn,一个用于滥用检测的动态GNN模型,然后总结了这篇论文。 在科学和工业中图结构的无处不在,需要能够捕获关系数据底层归纳偏见的有效且高效的机器学习模型。 我的研究旨在学习深度表示,捕获图结构的高度复杂的连接信息,并利用这些表示在许多下游任务中进行预测,包括节点、链接、子图和整个图的级别。我的研究为图神经网络贡献了基本部分,这些网络结合了神经网络的高表达能力和图连接信息的归纳偏见,并适用于多种应用(如图1所示)。 建模关系数据带来了许多基本的挑战。 (1) 实际应用涉及极大规模的数据集,例如涉及数亿粒子的物理系统,以及用户和内容之间有数十亿次交互的网页规模的社交应用。它们要求对图形进行高效且具有泛化能力的学习算法。 (2) 在关系结构中经常存在丰富的层次结构信息,例如基因本体论、概念分类以及网络中的模式出现。对关系数据的这种层次结构的学习是深度图表示学习中的一个开放性挑战。 (3) 表达能力和可解释性的建模是分析复杂网络进行深度图表示学习时的两个关键方面。

我的研究重点是开发可扩展、具有表达能力和可解释性的深度学习算法,对图结构数据进行预测。我在图神经网络(GNNs)领域提出了许多基础方法,这使得网络分析领域发生了范式转变,并在多个领域的应用中取得了突破性的性能。我的研究改变了如推荐系统、知识图谱领域的图学习方法,并被扩展以增强在化学和物理应用中的科学发现。 我推进该领域并解决挑战的方法是设计新的方法论(带有可解释性),利用图神经网络(GNNs)来捕获网络的结构信息,并探索学习适合不同图拓扑的有表达能力的嵌入几何形态。以下是主要贡献列表: • 提出了最广泛使用的GNN方法之一(第2章)及相关的训练技术,使得十亿规模的图结构数据的深度表示学习成为可能。 • 创建了一些最先进的GNN架构(第4、5、6章)以及通用的GNN框架,以实现表达能力和可解释性(第3章)。 • 展示了在各种科学领域和工业用例中GNNs的应用(第7、8、9章)。 我的长期研究目标是开发具有人类水平推理能力的机器学习模型。与如分类等传统任务相比,人类水平的推理强调逻辑推理能力,可以解释为通过学习概念和实体之间的关系,在图结构上导航。我从关系和层次结构中的学习使得朝着人类水平推理的目标开启了新的范式。