我们在实践中部署高性能神经网络时面临许多挑战。这些挑战主要是由于神经网络的规模,既适用于训练也适用于推理。因此,压缩神经网络以使其训练和运行更高效至关重要,并自神经网络发展初期以来一直是研究的平行方向。深度学习中的两种主要压缩技术是剪枝和量化,它们是本论文的重点。本论文探讨了如何利用高阶梯度(元梯度)的信息来改进深度学习压缩。我们首先发现剪枝公式中的一个根本性限制:尽管许多方法(如基于显著性的剪枝)在剪枝后进行训练或微调阶段,但参数显著性只关注参数的一个快照,而没有考虑到参数的可训练性。我们展示了如何使用元梯度作为更具信息量的信号,在初始化时找到更好的可训练子网络。接下来,我们研究量化神经网络,并展示了如何在正则化方案中使用元梯度来学习具有对训练后量化固有鲁棒性的模型。最后,我们研究双重压缩问题,即使用神经网络压缩数据源。我们从图像开始,提出了一种简单的无自编码器架构,其中我们存储神经网络的权重而非图像像素的RGB值。然后,我们使用元梯度来元学习一个基础网络,以摊销每个输入训练一个网络的成本。我们学习压缩的一个显著优势是它变得对数据类型不可知,并且我们展示了在2D图像之外的各种数据类型上的结果。重要的是,我们评估了标准DNN压缩技术(如量化)在这种新型神经网络中的实用性。

1. 引言

近年来,深度学习的成功是由于几个几乎同时发生的突破和范式转变而成为可能:训练中采用反向传播,卷积神经网络的进步,大规模数据集的可用性,至关重要的是,由于GPU演变为通用、高度并行、多线程的计算平台,计算能力的大幅提高。随着算法和计算能力的不断进步,训练可以利用大量数据并在广泛应用中做出非常有价值的预测的大型神经网络现在已经是我们力所能及的事情。

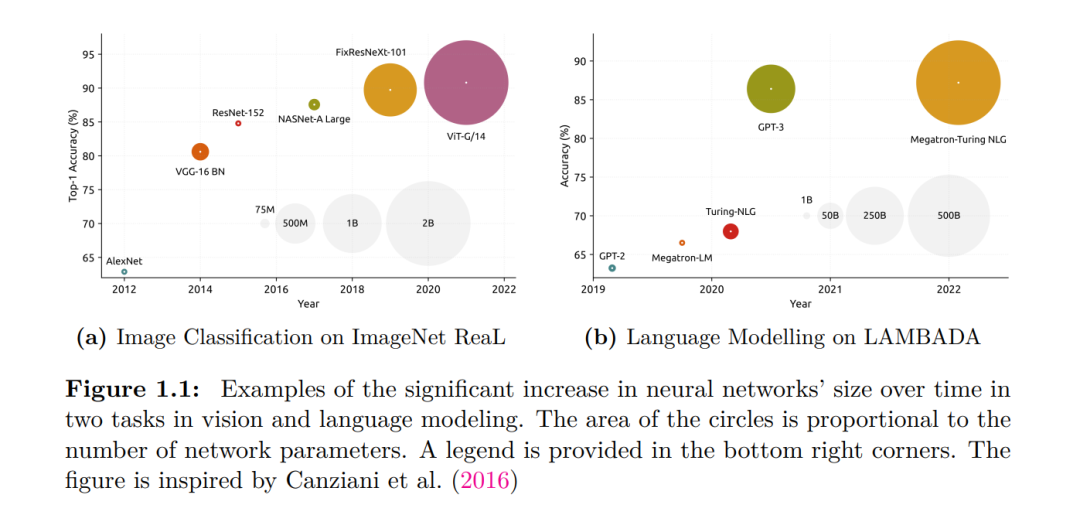

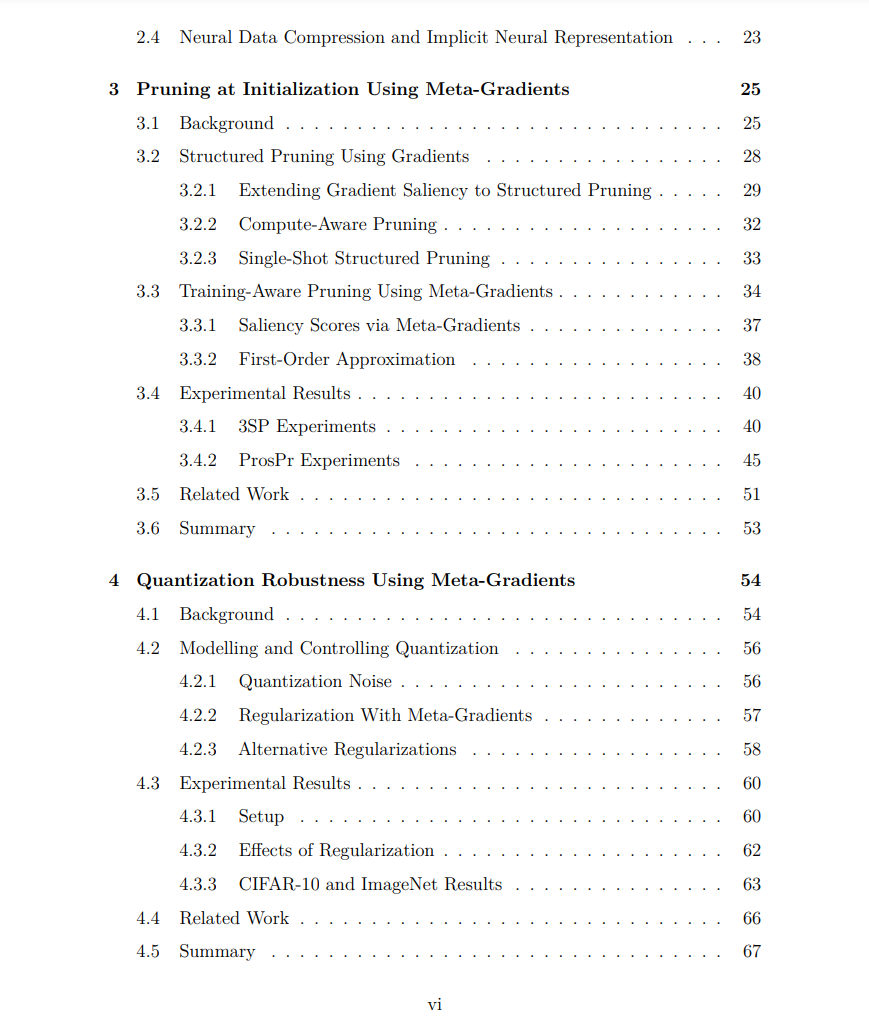

然而,随着我们进入一个希望在生活中越来越多的方面使用高性能神经网络的时代,在实践中部署它们面临许多挑战。这些挑战主要是由于神经网络的规模。现在,神经网络很容易拥有数百万或数十亿个参数,并且没有迹象表明我们的速度正在放缓,特别是在一些应用程序,如自然语言处理,我们还没有看到缩放定律的结束。这可以在图1.1中看到,它显示了在两个特定的视觉和自然语言处理任务中模型大小和性能的趋势。 神经网络的规模带来的挑战适用于训练和推理。在推理方面,人们越来越希望在设备上私下运行模型。一些示例应用程序是语音到文本识别和自动字幕,其中模型必须在设备上实时运行。需要运行此类应用程序的设备通常是手机、嵌入式系统和物联网设备,这些正是在内存、计算、延迟和能耗方面具有最严格要求的平台类型。 除了推理之外,训练也会受到神经网络和数据集规模较大的阻碍。首先,与推理相比,训练需要更多的内存。这是因为在训练过程中,我们需要保留网络生成的中间值,以便完成反向传播。这也使得并行化变得困难,因为我们无法进行新的前向传递,直到梯度找到它们自己的路回到第一层。其次,训练大型神经网络比较小的模型更脆弱和不稳定。Zhang et al.(2022)最近发布了一个1750亿参数的语言模型,除了模型参数,他们还包括训练日志,这表明训练如此大的模型涉及大量的工程。我们将在后续章节中看到,这对需要重新培训或针对特定平台的高效方法具有深远影响。

因此,压缩神经网络以使其更有效地训练和运行是至关重要的,自神经网络发展早期以来一直是一个平行的研究方向(LeCun等人,1990a;Hassibi等人,1993b)。在介绍各种用于提高神经网络效率的方法之前,有必要快速回顾一下在这个过程中我们关心的主要指标(Reagen等人,2017;Sze等人,2020):

准确性或模型性能。这个指标决定了我们在不影响模型性能的情况下提高模型效率的成功程度。准确率对于类平衡分类任务来说是一个合适的度量指标,本文中的大多数实验都是这样的,在其他任务中,准确率可以用其他指标来代替,以提高模型的性能。

能耗和动力。能耗指的是每单位能量可以处理的数据量,在使用电池供电的设备上运行时,能耗变得至关重要。它是决定装置形状因素的一个主要因素。另一方面,功率消耗是单位时间内消耗的能量,它决定了设备的冷却要求。它与移动设备和服务器安装都相关。

存储和内存。需要更多的存储和内存是神经网络规模带来的第一个挑战。它是决定模型所需硅芯片面积的一个主要因素。

吞吐量和延迟;除了存储权重和中间值之外,我们还需要足够快地移动数据。延迟衡量的是这个要求,定义为从输入数据到达模型到输出结果的时间。它决定了模型是否可以实时运行,这在许多应用中至关重要,如机器人,自动驾驶和游戏。

要使神经网络对这些指标有效,需要在每个堆栈级别进行优化。栈的一端是用于训练和运行模型的硬件平台。半导体制造工艺的不断进步导致了更密集的晶体管,从而产生了更强大和更节能的芯片,但深度学习工作负载尤其影响了CPU和GPU的硬件设计,并产生了专门针对神经网络的定制加速器。

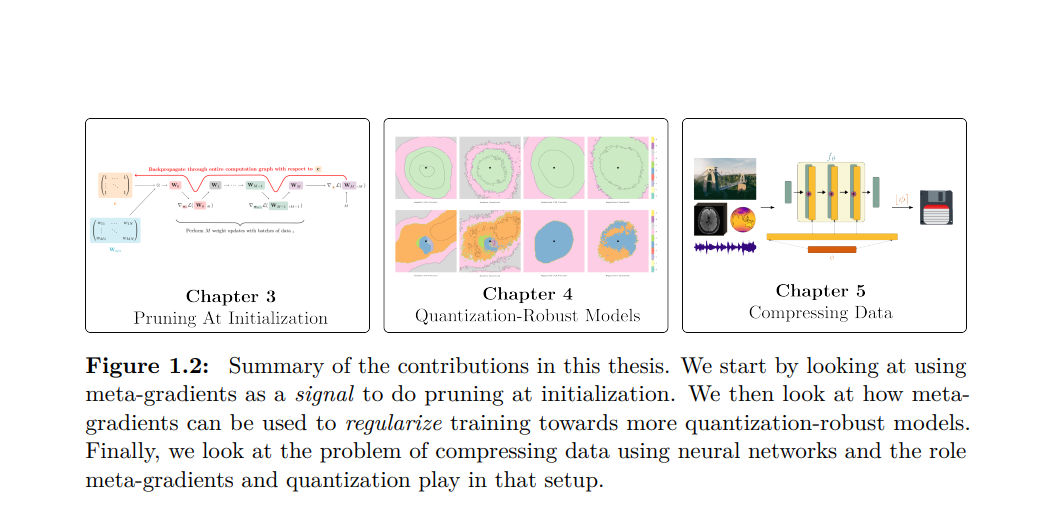

本文的主要贡献是研究了元梯度在各种压缩任务中的应用。本文主要关注视觉应用中的神经网络,并解决以下中心问题: 高阶梯度的信息可以通过量化和修剪来改进深度神经网络的压缩吗? 除了研究神经网络的压缩外,我们还研究了对偶压缩问题,即用神经网络压缩数据,并解决以下问题:神经网络的参数可以用于存储和压缩数据吗?如果是,量化和剪枝技术是否仍然适用于此设置?

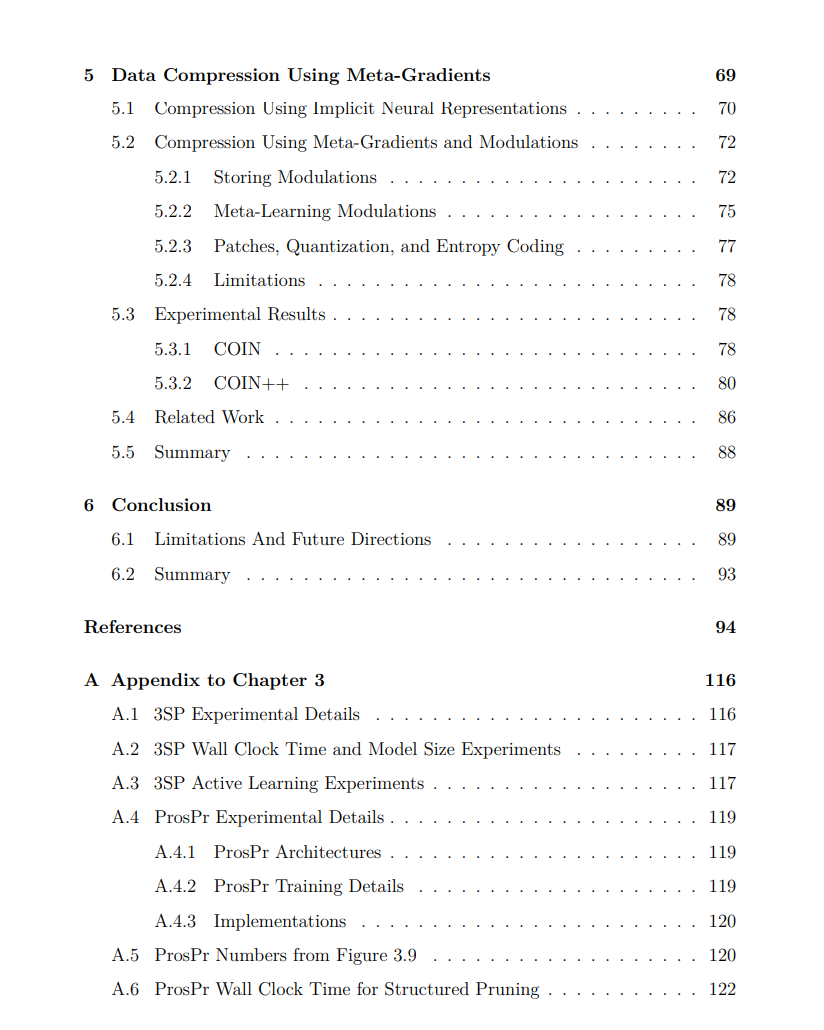

除了提供必要背景材料的第2章和总结工作的第6章外,本文的主要材料分为三章(如图1.2所示),每一章都专注于一个压缩任务。

相关内容

牛津大学是一所英国研究型大学,也是罗素大学集团、英国“G5超级精英大学”,欧洲顶尖大学科英布拉集团、欧洲研究型大学联盟的核心成员。牛津大学培养了众多社会名人,包括了27位英国首相、60位诺贝尔奖得主以及数十位世界各国的皇室成员和政治领袖。2016年9月,泰晤士高等教育发布了2016-2017年度世界大学排名,其中牛津大学排名第一。