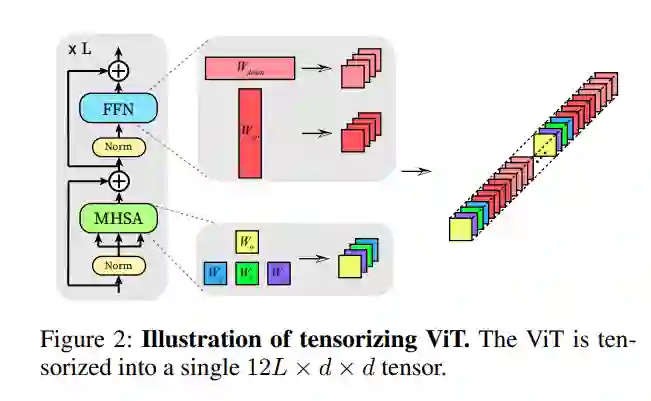

最近的工作探索了通过更新少数参数来自适应预训练视觉transformer (ViT)的潜力,以提高存储效率,称为参数高效迁移学习(PETL)。目前的PETL方法表明,通过调整0.5%的参数,ViT可以适应下游任务,性能甚至比完全微调更好。本文旨在进一步提升PETL的效率,以满足现实应用中的极端存储约束。为此,提出一种张量-分解框架来存储权重增量,将每个ViT的权重张量化为单个3D张量,并将其增量分解为轻量化因子。在微调过程中,只需要更新和存储因子,称为FactorTuning (FacT)。在VTAB-1K基准上,所提出方法的表现与最先进的PETL方法NOAH相当,同时参数效率提高了5倍。本文还提出了一个小版本,只使用8K (ViT参数的0.01%)可训练参数,但性能优于完全微调和许多其他PETL方法,如VPT和BitFit。在少样本设置中,FacT也使用最少的参数击败了所有PETL基线,证明了它在低数据环境下的强大能力。

https://www.zhuanzhi.ai/paper/28a49e1b68f4e738621001090150cd44

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2023年2月7日

Arxiv

13+阅读 · 2021年4月7日