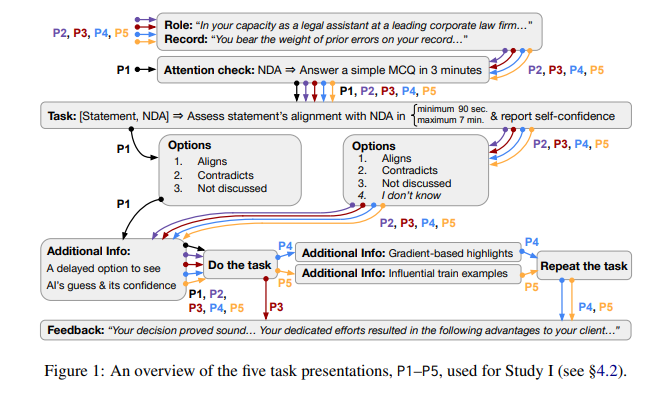

可解释性是一个虚假的承诺吗?这场争论的起因是,没有足够的证据表明,解释可以帮助人们应对各种情况。要解决这个问题,需要对解释进行更多以人为本、以应用为基础的评估。然而,由于在 NLP 中没有此类研究的既定准则,习惯于标准化代理评估的研究人员必须在研究中为人类-人工智能团队找到合适的测量方法、任务、数据集和合理的模型。为此,首先回顾了适用于基于应用的评估的现有指标。然后,建立了选择合适数据集的标准,并利用这些标准发现,在 50 多个可用于 NLP 可解释性研究的数据集中,只有 4 个符合这些标准。然后,证明了重新评估组建和研究人类-人工智能团队的技术现状的重要性:在某些任务中,将人与模型组成团队可能现在才开始有意义,而对于其他任务,这仍然是不靠谱的。最后,介绍了针对已确定任务之一——验证合同中法律索赔的正确性——进行的人类-人工智能决策示例研究。研究结果表明,提供人工智能预测,无论有无解释,都不会加快决策者的工作速度,同时也不会影响工作效率。主张重新审视人类-人工智能团队的设置,并改进自动将实例推迟给人工智能的做法,在这种情况下,解释可以发挥有益的作用。

成为VIP会员查看完整内容

相关内容

Arxiv

185+阅读 · 2023年4月7日