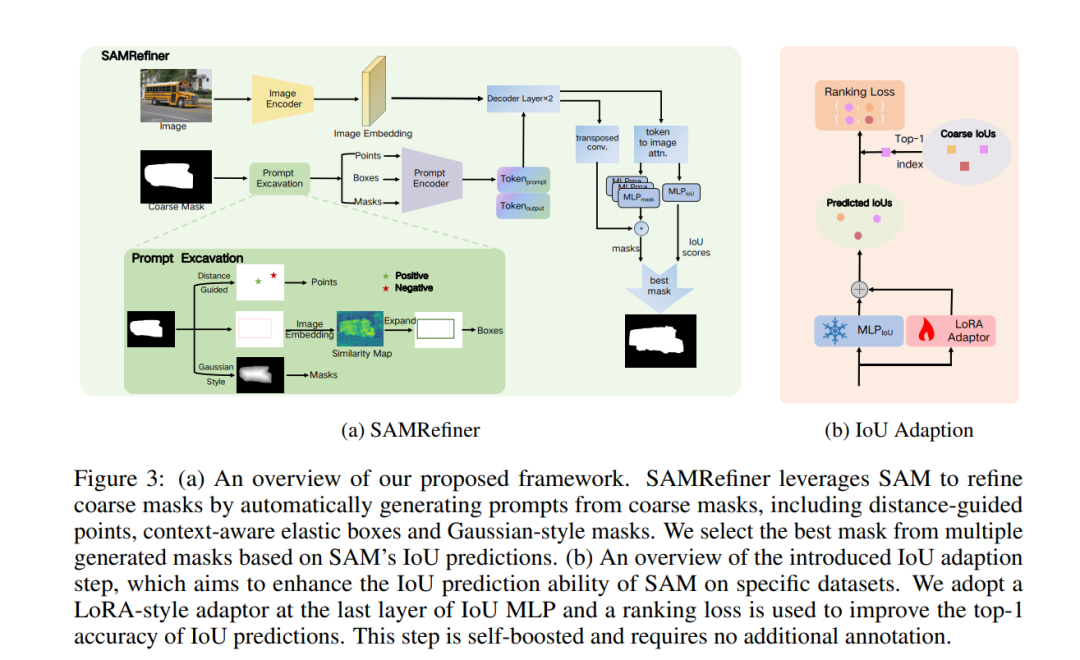

在本文中,我们探讨了一种主要方法,以提升广泛存在的粗略掩码的质量,使其能够作为可靠的训练数据,供分割模型使用,从而减少标注成本。与先前专门针对特定模型或任务的精细化技术不同,我们提出了SAMRefiner,这是一种通用且高效的方法,通过将SAM适配到掩码精细化任务中。我们模型的核心技术是噪声容忍的提示方案。具体而言,我们引入了一种多提示挖掘策略,从初始粗略掩码中挖掘出多样的输入提示,以供SAM使用(即,基于距离的点、上下文感知的弹性边界框和高斯风格的掩码)。这些提示可以相互协作,以减轻粗略掩码缺陷的影响。特别是考虑到SAM在处理语义分割中的多物体情形时的困难,我们引入了一个“拆分后合并”(STM)流程。此外,我们通过引入额外的IoU适配步骤,将我们的方法扩展为SAMRefiner++,进一步提升了通用SAMRefiner在目标数据集上的表现。这个步骤是自增强的,不需要额外的标注。所提出的框架具有高度的通用性,能够灵活地与现有的分割方法协作。我们在各种基准测试下评估了我们的掩码框架,在不同设置下展示了更好的准确性和效率。SAMRefiner具有显著的潜力,能够加速精细化工具的发展。我们的代码可在SAMRefiner上获取。

成为VIP会员查看完整内容

相关内容

Arxiv

36+阅读 · 2023年4月19日

Arxiv

75+阅读 · 2023年4月4日

Arxiv

134+阅读 · 2023年3月29日