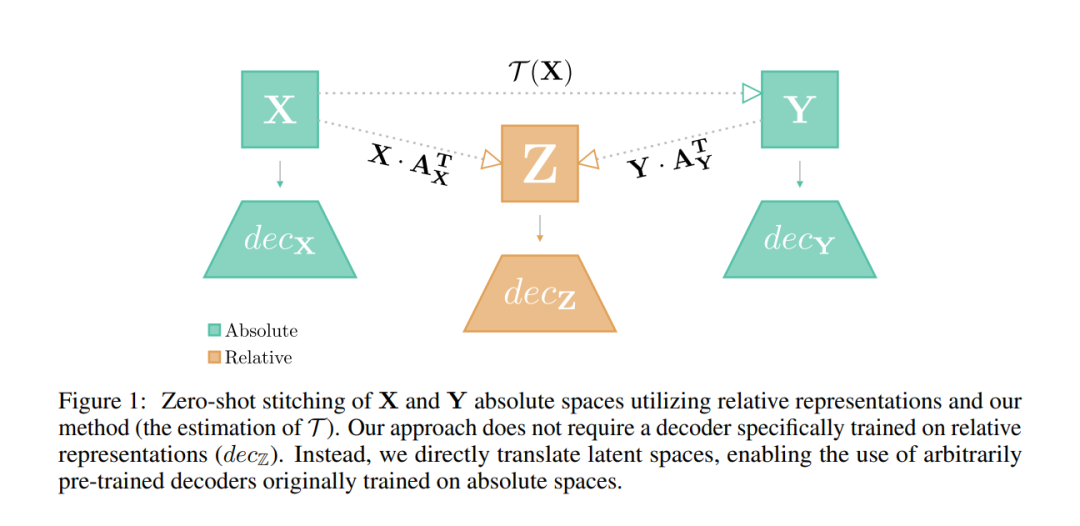

虽然不同的神经模型在面对语义相关的数据时往往表现出相似的潜在空间,但这种内在的相似性并不总是立即可见。为了更好地理解这一现象,本文工作展示了如何通过比之前认为的更简单的转换,将从这些神经模块中学习到的表示在不同的预训练网络之间转换。这种方法的一个优点是能够使用标准的、易于理解的、具有封闭形式解决方案的代数过程来估计这些转换。该方法直接估计两个给定潜空间之间的转换,从而能够在没有额外训练的情况下有效地拼接编码器和解码器。广泛验证了这种翻译过程在不同实验环境下的适应性:在各种训练、领域、架构(如ResNet、CNN、ViT)和多个下游任务(分类、重建)中。本文展示了如何零样本缝合文本编码器和视觉解码器,反之亦然,在这种多模态设置中产生令人惊讶的良好分类性能。

https://www.zhuanzhi.ai/paper/2101f1710ab0f62f8e9ab0b44a940190

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

224+阅读 · 2023年4月7日

Arxiv

86+阅读 · 2023年4月4日

Arxiv

152+阅读 · 2023年3月29日